目前面向平面、视觉、时尚等设计领域的高可用 AIGC 方向有以下 4 种:

- 透明图层生成

- 可控生成

- 图像定制化

- SVG 生成

本篇(上篇)介绍 1、2,而下篇将介绍 3、4。

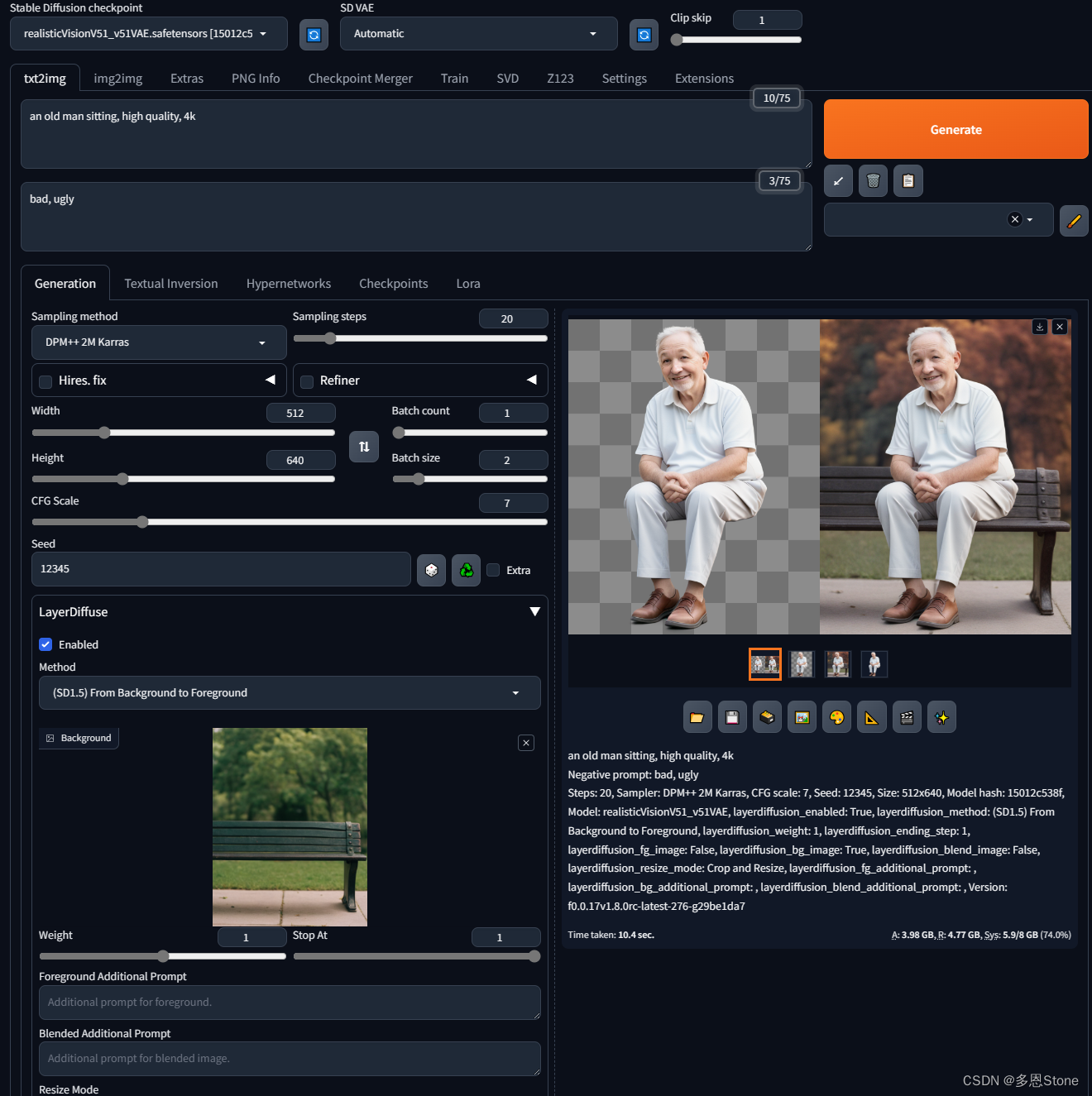

透明图层生成 LayerDiffuse

代表性论文:Transparent Image Layer Diffusion using Latent Transparency

论文链接:https://arxiv.org/abs/2402.17113

代码仓库(暂未完全开源):https://github.com/layerdiffusion/LayerDiffuse?tab=readme-ov-file

核心功能:可以在文生图基础模型(SD1.5,SDXL)之上,实现前后景的分层生成。使得生成图像能够更加适配 ps、 ai 等专业设计软件中的分层格式,让 SD 生成的图像更加适用于实际的设计工作中。

论文摘要:我们提出了LayerDiffuse,这是一种使大规模预训练的潜在扩散模型能够生成透明图像的方法。该方法允许生成单个透明图像或多个透明层。该方法学习一个“潜在透明度”,将阿尔法通道透明度编码到预训练的潜在扩散模型的潜在流形中。它通过将添加的透明度作为潜在偏移进行调节,使预训练模型的原始潜在分布变化最小,从而保持了大扩散模型的生产就绪质量。以这种方式,任何潜在扩散模型都可以通过利用调整后的潜在空间对其进行微调而转换为透明图像生成器。我们使用人在环采集方案采集的1百万个透明图像层对来训练模型。我们表明,潜在透明度可以应用于不同的开源图像生成器,也可以适用于各种条件控制系统,以实现前景/背景条件层生成、联合层生成、层内容的结构控制等应用。一项用户研究发现,在大多数情况下(97%),用户更喜欢我们原生生成的透明内容,而不是以前的特定解决方案,如生成然后抠图。用户还报告说,我们生成的透明图像的质量与Adobe Stock等真正的商业透明资产相当。

可控生成 ControlNet

代表性论文:Adding Conditional Control to Text-to-Image Diffusion Models

论文链接:https://arxiv.org/abs/2302.05543

代码仓库:https://github.com/lllyasviel/ControlNet

核心功能:可以在文生图基础模型(SD1.5,SDXL)之上,实现生成图像的结构控制。同样,也是让 SD 生成的图像更可控,更方便用于实际的设计工作中。

论文摘要:我们提出了ControlNet,这是一种神经网络架构,用于将空间条件控制添加到大型预训练的文本到图像扩散模型中。ControlNet锁定了可用于生产的大型扩散模型,并将其用数十亿张图像预训练的深度和稳健的编码层重新用作学习一组不同条件控制的强大骨干。神经架构与“零卷积”(零初始化卷积层)相连,该卷积层从零开始逐步增长参数,并确保没有有害噪声会影响微调。我们使用稳定扩散测试各种条件控制,例如边缘、深度、分割、人体姿势等,使用单个或多个条件,无论是否提示。我们证明了ControlNets的训练对于小(<50k)和大(>1m)数据集是稳健的。广泛的结果表明,ControlNet可以促进控制图像扩散模型的更广泛应用。