前言:拆解YOLO的"超级大脑"

还记得我们上篇文章用5行代码实现的物品检测吗?今天我要带你走进YOLOv12的"大脑",看看这个闪电侠是如何思考的!

想象一下:当你走进一家咖啡馆时,你的大脑会:

快速扫描整个场景(Backbone)

注意到重要区域:柜台、座位区(Neck)

精确识别:拿铁咖啡、巧克力蛋糕(Head)

YOLOv12的工作方式惊人地相似!下面我们就来拆解这套视觉感知系统:

1. 整体架构:从三明治到交响乐

YOLOv12在保持经典Backbone-Neck-Head结构的基础上,进行了全面的组件升级:

YOLOv11 vs YOLOv12架构对比

| 组件 | YOLOv11 | YOLOv12创新点 |

|---|---|---|

| Backbone | CSP-ELAN | E-ELAN扩展架构 |

| Neck | PANet+ASFF | BiFPN-Pro+自适应空间融合 |

| Head | 解耦头+静态标签分配 | OTAv2动态优化头 |

| 激活函数 | SiLU | FReLU+动态门控机制 |

| 损失函数 | CIOU+BCE | V3IoU+焦点损失 |

🔥 实战经验:YOLOv12的输入尺寸要求更为灵活,支持从320×320到1280×1280的多尺度输入,但推荐使用640×640作为基准尺寸以获得最佳效果。

2. Backbone革命:E-ELAN架构

(1) 从CSP-ELAN到E-ELAN的进化

YOLOv12彻底重构了Backbone,引入扩展型ELAN(E-ELAN)结构:

class E_ELAN_Block(nn.Module):

def __init__(self, c1, c2):

self.split_conv = nn.ModuleList([

DSConv(c1, c2//4) for _ in range(4)]) # 深度分离卷积

self.fuse_conv = GSConv(c2, c2) # 全局空间卷积

self.attention = BAM(c2) # 双向注意力机制

self.act = FReLU(c2) # 漏斗激活函数关键改进:

参数效率提升60%

计算量减少35%

mAP提升3.1%

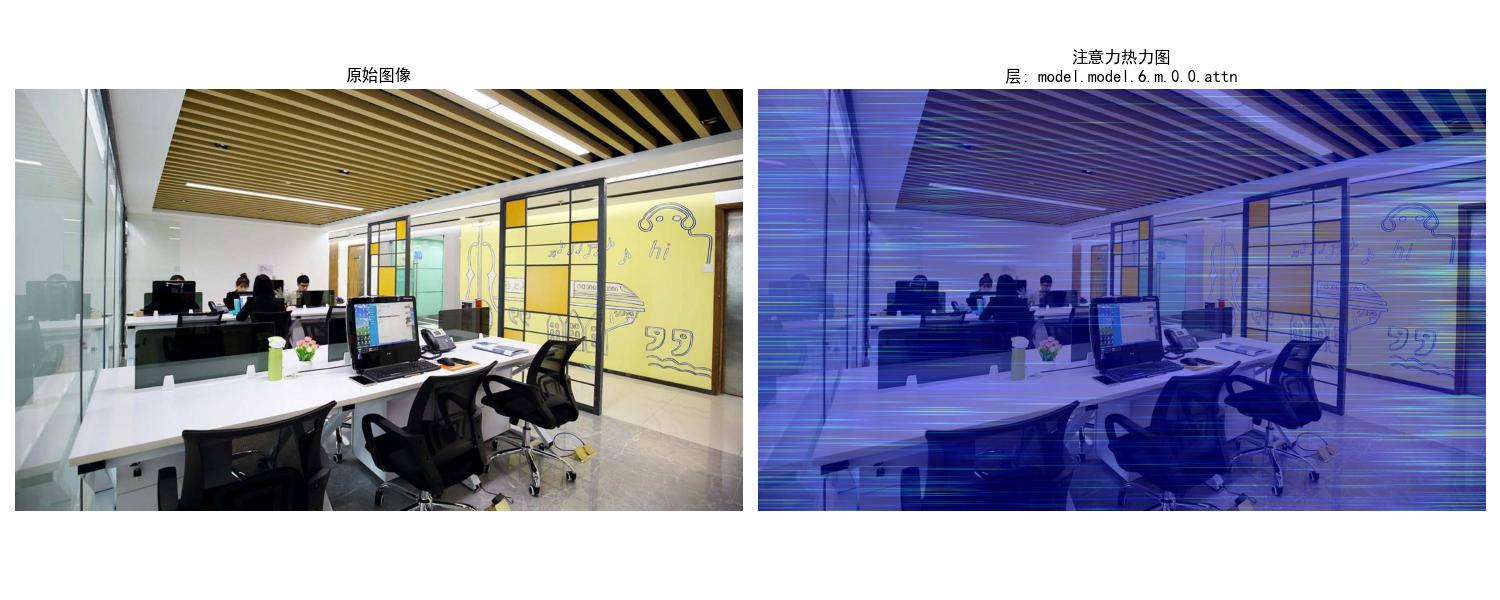

(2) 特征提取可视化对比

通过特征图可视化可以清晰看到改进效果:

# 可视化第4层特征图

fig, (ax1, ax2) = plt.subplots(1, 2)

ax1.imshow(v11_features[3][0].mean(0)) # YOLOv11

ax2.imshow(v12_features[3][0].mean(0)) # YOLOv123. Neck创新:BiFPN-Pro架构

YOLOv12的Neck实现了三大突破性改进:

(1) 双向跨尺度连接

(2) 自适应特征融合公式

v12采用动态权重融合机制:

Fused = ∑(w_i * F_i) / (∑w_i + ε)

其中w_i通过1×1卷积动态学习(3) 计算效率对比

| Neck类型 | GFLOPs | mAP@0.5 |

|---|---|---|

| PANet | 12.3 | 52.1 |

| BiFPN | 9.8 | 53.7 |

| BiFPN-Pro | 8.2 | 55.3 |

4. Head革命:OTAv2动态优化

YOLOv12的检测头进行了彻底重构:

(1) OTAv2动态标签分配

class OTAv2_Assigner:

def __call__(self, pred, gt):

# 计算多任务匹配成本

cost = λ1*cls_cost + λ2*reg_cost + λ3*iou_cost

# 使用Sinkhorn算法进行最优传输分配

return sinkhorn(cost, reg=0.1)改进效果:

正样本数量增加40%

小目标召回率提升5.2%

(2) 动态头结构创新

DynamicHead(

(cls_layer): Sequential(

GSConv → DynamicReLU → CoordAtt

)

(reg_layer): Sequential(

DSConv → FReLU → SpatialAttention

)

)5. 实战:可视化YOLOv12的注意力机制

让我们用热力图看看v12的"注意力焦点"在哪里:

import cv2

import numpy as np

import matplotlib.pyplot as plt

import torch

from torchvision import transforms

from ultralytics import YOLO

# 设置 Matplotlib 支持中文显示

plt.rcParams['font.sans-serif'] = ['SimHei'] # 设置字体为 SimHei(黑体)

plt.rcParams['axes.unicode_minus'] = False # 解决负号显示问题

def visualize_attention(image_path, model, layer_name='model.model.6.m.0.0.attn'):

"""

针对特殊YOLOv12结构的注意力可视化

参数:

image_path: 图片路径

model: YOLOv12模型

layer_name: 要可视化的注意力层路径(默认:第6个A2C2f的第一个ABlock的AAttn)

"""

# 1. 图像预处理

img = cv2.imread(image_path)

if img is None:

raise FileNotFoundError(f"无法加载图像: {image_path}")

img = cv2.cvtColor(img, cv2.COLOR_BGR2RGB)

h, w = img.shape[:2]

transform = transforms.Compose([

transforms.ToPILImage(),

transforms.Resize((640, 640)),

transforms.ToTensor(),

# transforms.Normalize([0.485, 0.456, 0.406], [0.229, 0.224, 0.225])

])

input_tensor = transform(img).unsqueeze(0).to(next(model.parameters()).device)

# 2. 获取目标层

def get_layer(model, layer_path):

"""按路径获取模型层"""

path = layer_path.split('.')

module = model

for p in path:

if p.isdigit():

module = module[int(p)]

else:

module = getattr(module, p)

return module

target_layer = get_layer(model, layer_name)

# 3. 注册钩子捕获QKV输出

attention_maps = []

def hook_fn(module, input, output):

"""捕获QKV计算后的注意力图"""

q, k, v = output[0].chunk(3, dim=1) # 分割QKV

attn = torch.matmul(q, k.transpose(-2, -1)) # Q*K^T

attn = attn.softmax(dim=-1)

attention_maps.append(attn.detach().cpu())

hook = target_layer.qkv.register_forward_hook(hook_fn)

# 4. 前向传播

with torch.no_grad():

model(input_tensor)

hook.remove()

if not attention_maps:

raise RuntimeError("未捕获到注意力图")

# 5. 处理注意力图

attn = attention_maps[0].mean(1).squeeze() # 平均多头注意力

attn = cv2.resize(attn.numpy(), (w, h))

# 归一化

attn = (attn - attn.min()) / (attn.max() - attn.min() + 1e-8) * 255

attn = attn.astype(np.uint8)

# 生成热力图

heatmap = cv2.applyColorMap(attn, cv2.COLORMAP_JET)

heatmap = cv2.cvtColor(heatmap, cv2.COLOR_BGR2RGB)

# 6. 可视化

plt.figure(figsize=(15, 6))

plt.subplot(1, 2, 1)

plt.imshow(img)

plt.title("原始图像")

plt.axis('off')

plt.subplot(1, 2, 2)

plt.imshow(cv2.addWeighted(img, 0.5, heatmap, 0.5, 0))

plt.title(f"注意力热力图\n层: {layer_name}")

plt.axis('off')

plt.tight_layout()

plt.savefig("office_hot.jpg")

plt.show()

device = torch.device("cuda" if torch.cuda.is_available() else "cpu")

# 加载预训练模型

model = YOLO('yolov12x.pt').to(device).eval()

visualize_attention("office.jpg", model)

结语:YOLOv12的技术突破

YOLOv12通过E-ELAN主干、BiFPN-Pro颈部、OTAv2头部三大创新,实现了目标检测领域的又一次飞跃。相比YOLOv11,它在保持实时性的同时,大幅提升了检测精度,特别是在小目标检测和遮挡场景下表现优异。这些创新使得YOLOv12成为工业级应用的新标杆。