目录

1.5 Performance Is Challenging

5.2 Application Performance Techniques

Preface

已知的是已知的;我们知道我们所知道的事情。

我们也知道存在已知的未知;也就是说,我们知道有些事情我们不知道。

但也存在未知的未知——

有些事情我们不知道我们不知道。

—美国国防部长唐纳德·拉姆斯菲尔德(Donald Rumsfeld),2002年2月12日

虽然上述声明引起了出席新闻发布会的人们的笑声,但它总结了一个重要原则,这个原则在复杂的技术系统和地缘政治中同样适用:性能问题可能来自任何地方,包括您不知道且因此未检查的系统领域(未知未知)。本书可能会揭示许多这些领域,同时提供分析它们的方法和工具。

About This Book

欢迎来到《系统性能:企业和云端》!本书关注操作系统和应用程序的性能,从操作系统的角度来讲述,并适用于企业和云计算环境。我的目标是帮助您充分发挥系统的潜力。

当与不断开发的应用软件一起工作时,您可能会认为经过数十年开发和调优的操作系统性能问题已经解决了。但事实并非如此!操作系统是一个复杂的软件体系,管理着各种不断变化的物理设备和新的、不同的应用负载。内核也在不断发展,不断添加功能以提高特定工作负载的性能,并且随着系统的扩展,新遇到的瓶颈也在被消除。分析和改进操作系统的性能是一项持续的任务,应该不断取得性能改进。应用程序的性能也可以在操作系统的上下文中进行分析;我将在这里介绍相关内容。

Operating System Coverage

本书的主要重点是系统性能的研究,以Linux和Solaris操作系统为例介绍了工具、示例和可调参数。除非特别说明,操作系统的具体发行版在示例中并不重要。对于基于Linux的系统,示例来自各种裸金属系统和虚拟化云租户,运行的操作系统可以是Ubuntu、Fedora或CentOS。对于基于Solaris的系统,示例同样可以是裸金属系统或虚拟化系统,可以是Joyent SmartOS或OmniTI OmniOS。SmartOS和OmniOS使用的是开源的illumos内核,这是OpenSolaris内核的活跃分支,而OpenSolaris内核本身则基于最终成为Oracle Solaris 11的开发版本。

对于每个读者群体来说,覆盖两种不同的操作系统提供了额外的视角,深入了解它们的特点,特别是在每个操作系统采取不同的设计路径时。这有助于读者更全面地理解性能,而不局限于单一的操作系统,并以更客观的方式思考操作系统。

从历史上看,针对基于Solaris的系统进行了更多的性能工作,使其成为某些示例的更好选择。Linux的情况已经大大改善。当《系统性能调优》[Musumeci 02]撰写时,十多年前,它也同时涉及到Linux和Solaris,但主要是针对后者。作者指出了这样做的原因:

Solaris机器更注重性能。我怀疑这是因为Sun系统的价格平均比Linux的高。因此,人们对性能要求更高,所以在Solaris上做了更多的工作。如果您的Linux机器性能不够好,您可以购买另一台并分担工作负载 - 这很便宜。但是如果您的几百万美元的Ultra Enterprise 10000性能不佳,您的公司由于此而每分钟损失可观的金额,您会联系Sun Service并开始要求答案。

这可以解释Sun历史上对性能的关注:Solaris的利润与硬件销售密切相关,性能改进常常与真实的资金挂钩。Sun需要并且能够雇佣100多名全职性能工程师(包括我和Musumeci在内)。与Sun的内核工程团队一起,我们在系统性能领域取得了许多进展。

Linux在性能工作和可观察性方面已经取得了长足的进步,特别是现在它被广泛应用于大规模的云计算环境中。本书中包含的许多Linux的性能特性是在过去五年内开发的。

Other Content

书中包含了性能工具的示例屏幕截图,不仅显示数据,还用来说明可用的数据类型。这些工具通常以直观的方式呈现数据,许多工具的风格类似于早期的Unix工具,产生的输出是熟悉且常常不言自明的。这意味着屏幕截图可以是传达这些工具目的的有力方式,有些工具只需要很少的额外解释。(如果一个工具需要费力的解释,那可能是设计上的失败!)

技术的历史可以提供有用的见解,深化您的理解,在书中的一些地方已经提到了。了解一些行业中的关键人物也很有用(这是一个小圈子):在性能和其他环境中,你可能会遇到他们或者他们的工作。附录G中提供了一个"名人堂"列表。

What Isn’t Covered

本书着重于性能。要完成所有示例任务,有时需要进行一些系统管理活动,包括安装或编译软件(这里不涉及)。特别是在Linux上,您需要安装sysstat包,因为本文中使用了许多其工具。内容还概述了操作系统的内部结构,这在专门的文本中有更详细的介绍。高级性能分析主题也进行了总结,以便您了解它们的存在,并在需要时从其他来源进行学习。

How This Book Is Structured

本书包括以下内容:

第1章:介绍。介绍系统性能分析,概述关键概念,并提供性能活动的示例。

第2章:方法论。提供性能分析和优化的背景知识,包括术语、概念、模型、观察和实验的方法、容量规划、分析和统计。

第3章:操作系统。总结了面向性能分析师的内核内部机制。这是解释和理解操作系统正在做什么的必要背景知识。

第4章:可观测性工具。介绍了可用的系统可观测性工具的类型,以及它们构建在哪些接口和框架之上。

第5章:应用程序。讨论应用程序性能相关的主题,并从操作系统的角度观察它们。

第6章:CPU。涵盖处理器、核心、硬件线程、CPU缓存、CPU互联和内核调度。

第7章:内存。介绍虚拟内存、分页、交换、内存架构、总线、地址空间和分配器等内容。

第8章:文件系统。介绍文件系统I/O性能,包括涉及的不同缓存。

第9章:磁盘。涵盖存储设备、磁盘I/O工作负载、存储控制器、RAID和内核I/O子系统。

第10章:网络。介绍网络协议、套接字、接口和物理连接等内容。

第11章:云计算。介绍常用于云计算的基于操作系统和硬件的虚拟化方法以及它们的性能开销、隔离性和可观测性特性。

第12章:基准测试。展示如何进行准确的基准测试,以及如何解释他人的基准测试结果。这是一个令人意外棘手的话题,本章将展示如何避免常见错误,并试图理解其含义。

第13章:案例研究。包含一个系统性能案例研究,展示了如何从头到尾分析一个真实的云客户问题。

第1至第4章提供了必要的背景知识。阅读完它们后,您可以根据需要参考本书的其余部分。

第13章的写作方式不同,采用叙事方式来描绘性能工程师的工作更全面的画像。如果您是新手,可能希望先阅读这一章以获得上下文,然后再在阅读其他章节后返回它。

As a Future Reference

本书旨在通过专注于系统性能分析师的背景和方法论,提供多年的价值。

为了支持这一点,许多章节被分成两个部分。第一部分包括术语、概念和方法论(通常带有这些标题),这些内容应该在未来很多年内仍然相关。第二部分提供了第一部分如何实现的示例:架构、分析工具和可调整参数,虽然它们会过时,但在示例的背景下仍然有用。

Tracing Examples

我们经常需要深入探索操作系统,这可以通过内核追踪工具来实现。在不同的开发阶段有许多这样的工具,例如ftrace、perf、DTrace、SystemTap、LTTng和ktap。其中一个工具在大多数追踪示例中被选中,并在基于Linux和Solaris的系统上进行演示:DTrace。它提供了这些示例所需的功能,并且还有大量关于它的外部资料,包括可以作为高级追踪用例参考的脚本。

您可能需要或希望使用不同的追踪工具,这是可以的。DTrace示例是追踪的示例,展示了您可以向系统提出的问题。通常,这些问题和提出这些问题的方法论是最难掌握的部分。

Intended Audience

本书的目标读者主要是企业和云计算环境的系统管理员和运营人员。它也是开发人员、数据库管理员和Web服务器管理员的参考,他们需要了解操作系统和应用程序的性能。

作为一家云计算服务提供商的首席性能工程师,我经常与支持人员和客户合作,他们承受着巨大的时间压力,需要解决多个性能问题。对于许多人来说,性能不是他们的主要工作,他们只需要了解足够多的知识来解决手头的问题。这促使我尽可能地缩短本书的篇幅,因为我知道你学习的时间可能非常有限。但也不会太短:有很多内容需要涵盖,以确保你准备充分。

另一个预期的读者是学生:本书也适用于支持系统性能课程的教材。在撰写本书时(甚至在开始写作前的许多年),我自己开发和教授过这样的课程,其中包括模拟性能问题供学生解决(但没有提前提供答案!)。这帮助我看到哪些类型的材料最适合引导学生解决性能问题,这指导了我选择本书的内容。

无论你是否是学生,章节练习都给了你回顾和应用材料的机会。这些练习包括一些可选的高级练习题(来自审稿人的建议),你不需要解决它们(它们可能是不可能解决的;但至少应该引起思考)。

关于公司规模,本书应包含足够的详细信息,以满足从小型到大型环境,包括拥有数十名专门的性能工作人员的公司。对于许多较小的公司,本书可能只在需要时作为参考资料,每天只使用其中的一部分。

1 Introduction

性能是一个令人兴奋、多样且具有挑战性的领域。本章介绍了性能领域,特别是系统性能,描述了其中的角色、活动、视角和挑战。它还介绍了延迟,这是一个关键的性能指标,并介绍了计算领域的一些新发展:动态跟踪和云计算。还包括一些性能活动的示例,以提供背景信息。

1.1 Systems Performance

系统性能是对整个系统进行研究,包括所有物理组件和完整的软件栈。任何在数据路径中的软件或硬件都应被纳入考虑,因为它们会影响性能。对于分布式系统,这意味着多个服务器和应用程序。如果您没有显示数据路径的环境图表,请找到一个或自己画一个;它将帮助您理解组件之间的关系,并确保您不会忽略整个区域。

图1.1显示了单个服务器上通用系统软件栈,包括操作系统(OS)内核,以及示例数据库和应用程序层。术语“整个栈”有时用来描述仅包含应用程序环境的情况,包括数据库、应用程序和 Web 服务器。然而,在谈到系统性能时,我们使用“整个栈”来表示包括系统库和内核在内的所有内容。

这个栈在第3章《操作系统》中进行了讨论,并在后面的章节中进行了更详细的研究。以下几节将描述系统性能和性能的一般情况。

1.2 Roles

系统性能作为一项活动,可以由各种角色来完成,包括系统管理员、支持人员、应用程序开发人员、数据库管理员和 Web 管理员。对于其中许多人来说,性能是一项兼职活动,并且可能倾向于仅在自己负责的领域内探索性能问题(网络团队检查网络,数据库团队检查数据库等)。然而,对于一些性能问题,要找到根本原因需要这些团队的合作努力。

一些公司雇佣了性能工程师,他们的主要工作是系统性能。他们可以与多个团队合作,并对环境进行全面研究,这种方法在解决复杂性能问题时可能至关重要。他们还可以识别机会,为跨环境的系统级分析和容量规划开发更好的工具和指标。

在性能领域还有专门的应用程序职业,例如针对Java性能和MySQL性能的职业。这些通常会从对系统性能的有限检查开始,然后转向特定于应用程序的工具。

1.3 Activities

性能领域包括以下活动,按照理想的执行顺序列出:

1. 设定性能目标和性能建模

2. 原型软件或硬件的性能特性分析

3. 开发代码的性能分析,在集成之前

4. 对软件构建进行非回归测试,在发布前或发布后

5. 为软件发布进行基准测试

6. 在目标环境中进行概念验证测试

7. 针对生产部署进行配置优化

8. 监控正在运行的生产软件

9. 对性能问题进行性能分析。

步骤1到5是传统软件产品开发的一部分。然后产品被推出市场,随后进行在客户环境中的概念验证测试或部署和配置。如果在客户环境中遇到问题(步骤6到9),意味着在开发阶段未能检测或修复该问题。

性能工程理想情况下应在选择硬件或编写软件之前开始。这可以是第一步,涉及设定目标和创建性能模型。然而,通常产品在没有经过这一步的情况下进行开发,将性能工程工作推迟到出现问题时再进行。然而,随着开发过程的每个步骤,由于之前做出的架构决策,修复性能问题可能会越来越困难。

容量规划这个术语可以指前面提到的一系列活动。在设计阶段,它包括研究开发软件的资源占用情况,以评估设计是否能满足目标需求。在部署后,它包括监控资源使用情况,以预测问题的发生。

本书介绍了一些方法和工具,用于执行这些活动。

不同公司和产品之间的环境和活动各不相同,在许多情况下,并不会执行所有九个步骤。你的工作可能也只专注于其中一些或只有一个活动。

1.4 Perspectives

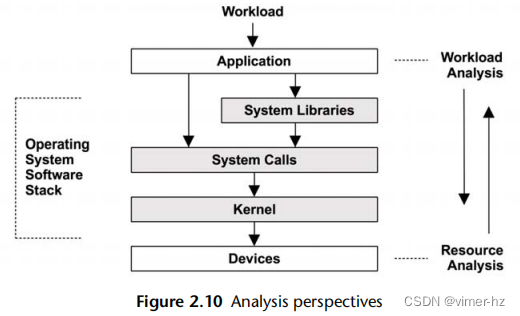

除了专注于不同的活动外,性能角色可以从不同的角度进行考虑。性能分析的两个视角在图1.2中标记为工作负载分析和资源分析,它们从不同的方向来接近软件堆栈。

资源分析的视角通常由系统管理员所采用,他们负责系统资源。而负责工作负载的交付性能的应用程序开发人员通常会专注于工作负载分析的视角。每个视角都有其自身的优势,在第2章“方法论”中进行了详细讨论。对于具有挑战性的问题,尝试从两个视角进行分析可能会有所帮助。

1.5 Performance Is Challenging

系统性能工程是一个具有挑战性的领域,原因包括它具有主观性,复杂性,并且通常涉及多个问题。

1.5.1 Performance Is Subjective //主观

技术学科往往是客观的,以至于行业内的人们以黑白分明而著称。这对软件故障排除来说可能是正确的,因为错误要么存在,要么不存在,要么已经被修复,要么没有被修复。这些错误通常表现为容易被解释和理解的错误消息,表示存在错误。

另一方面,性能问题往往是主观的。在性能问题上,是否存在问题并不清楚,如果存在问题,何时已经被解决也不清楚。对于一个用户而言,可能被认为是“糟糕”的性能,因此是一个问题,但对于另一个用户来说,可能被认为是“良好”的性能。

考虑以下信息:

平均磁盘I/O响应时间为1毫秒。

这是“好”还是“坏”?虽然响应时间或延迟是可用的最佳指标之一,但解释延迟信息是困难的。在一定程度上,一个给定的度量是否“好”或“坏”,可能取决于应用程序开发人员和最终用户的性能期望。

通过定义明确的目标,例如设置目标平均响应时间,或要求某个百分比的请求在特定延迟范围内完成,可以使主观性变为客观性。在第2章“方法论”中介绍了其他处理这种主观性的方法,包括通过延迟分析将问题表达为其操作延迟的比率。

1.5.2 Systems Are Complex

除了主观性外,性能问题可能由于系统的复杂性和缺乏清晰的分析起点而成为一门具有挑战性的学科。有时我们从一个猜测开始,比如责备网络,而性能分析师必须弄清楚这是否是正确的方向。

性能问题也可能源于子系统之间的复杂相互作用,在单独分析时它们表现良好。这可能是由于级联故障,当一个组件发生故障时会导致其他组件的性能问题。要理解所产生的问题,您必须解开组件之间的关系,并理解它们的贡献方式。

瓶颈也可能是复杂的,并以意想不到的方式相关;修复一个瓶颈可能只会将瓶颈转移到系统中的其他地方,整体性能并没有如期望的那样得到改善。

除了系统的复杂性外,性能问题可能是由生产工作负载的复杂特性引起的。在这些情况下,它们可能永远无法在实验室环境中重现,或者只会间歇性地重现。

解决复杂的性能问题通常需要采用整体方法。整个系统——包括其内部和外部交互——可能都需要被调查。这需要一系列技能,通常一个人很难具备,这使得性能工程成为一项多样化且具有智力挑战的工作。

不同的方法可以指导我们应对这些复杂性,就像在第2章中介绍的那样;第6至10章包括了特定的方法论,针对系统资源如CPU、内存、文件系统、磁盘和网络进行了介绍。

1.5.3 There Can Be Multiple Performance Issues

通常情况下,找到一个性能问题并不是问题;在复杂的软件中通常存在很多问题。为了说明这一点,试着找到你操作系统或应用程序的错误数据库,然后搜索关键词"性能"。你可能会感到惊讶!通常情况下,即使在被认为具有高性能的成熟软件中,也会存在一些已知但尚未修复的性能问题。这在分析性能时又带来了另一个困难:真正的任务不是找到一个问题,而是辨别出最重要的问题或问题。

为了做到这一点,性能分析师必须量化问题的严重程度。有些性能问题可能与您的工作负载无关,或者只适用于很小的程度。理想情况下,您不仅要量化问题,还要估计每个问题修复后的加速效果。当管理层寻求为工程或运营资源开支提供合理性时,这些信息是有价值的。

当可用时,一个非常适合性能量化的指标是延迟。

1.6 Latency

延迟是等待所花费的时间的度量。广泛地使用时,它可以表示任何操作完成所需的时间,例如应用程序请求、数据库查询、文件系统操作等。例如,延迟可以表示一个网站从链接点击到完全加载所花费的时间。这对于客户和网站提供者都是重要的指标:高延迟可能导致沮丧,客户可能会选择其他地方进行业务。

作为一个指标,延迟可以用来估计最大的加速效果。例如,图1.3描述了一个数据库查询需要100毫秒(即延迟),其中有80毫秒被阻塞等待磁盘读取。通过消除磁盘读取(例如通过缓存),可以计算出最大的性能提升:最多可以提升五倍(5倍)。这就是估计的加速效果,该计算还量化了性能问题:磁盘读取导致查询运行速度最多慢了5倍。

使用其他指标进行这样的计算是不可能的。例如,每秒I/O操作次数(IOPS)取决于I/O的类型,并且通常不能直接进行比较。如果某个更改将IOPS速率降低80%,很难知道性能影响会是什么样。可能会减少5倍的IOPS,但如果每个I/O的大小(字节)增加了10倍呢?

在网络的上下文中,延迟可以指连接建立的时间,而不是数据传输时间。在本书中,术语在每章的开始处进行了澄清,以便清楚地了解这种上下文差异。

尽管延迟是一个有用的指标,但并不总是能够在需要的时间和地点获得。一些系统领域只提供平均延迟;有些甚至不提供任何延迟指标。随着动态跟踪技术的出现,可以从任意感兴趣的点测量延迟,并提供显示完整延迟分布的数据。

1.7 Dynamic Tracing

动态跟踪允许所有软件在生产中都可以被检测和测量。它是一种技术,可以在内存中获取CPU指令,并动态地构建仪器。这使得可以从任何正在运行的软件中创建自定义性能统计数据,提供远远超出内置统计数据的可观察性。以前由于缺乏可观察性而无法解决的问题现在可以解决。以前可能可以解决但难度极大的问题现在通常更容易解决。

动态跟踪与传统观察方法有很大不同,因此一开始很难理解其作用。考虑操作系统内核:分析内核内部就像进入一个黑暗的房间,系统统计数据就像放在内核工程师认为需要的地方的蜡烛。动态跟踪就像一个手电筒,你可以把它指向任何地方。

该技术首次以可用于生产的工具形式问世,这个工具就是DTrace,它提供了许多其他功能,包括其自己的编程语言D。DTrace是由Sun Microsystems开发的,并于2005年发布用于Solaris 10操作系统。它也是Solaris中首个作为开源提供的组件,后来被移植到了Mac OS X和FreeBSD,并目前正在被移植到Linux。

在DTrace之前,系统跟踪通常使用静态探测器进行,即在内核和其他软件中放置一小组仪器点。它们的可见性有限,使用它们经常很耗时,需要配置、跟踪、转储数据,然后进行分析的一个周期。

DTrace提供用户级和内核级软件的静态和动态跟踪,并可以实时提供数据。以下是一个简单的示例,跟踪ssh登录期间的进程执行情况。跟踪是系统范围的(不与特定进程ID相关):

在这个示例中,DTrace被指示打印时间戳(纳秒),并显示进程名称和参数。在D语言中可以编写更复杂的脚本,允许我们创建和计算自定义的延迟度量。DTrace和动态跟踪将在第4章《可观察性工具》中进行解释。在后面的章节中,有许多基于Linux和Solaris系统的DTrace单行命令和脚本示例。对于更高级的用法,还有一本单独介绍DTrace的书籍[Gregg 11]。

1.8 Cloud Computing

最近对系统性能产生影响的最新发展是云计算和云常用的虚拟化技术。云计算通过使用一种可以在越来越多的小型系统之间平衡应用程序的架构,实现了快速扩展能力。这种方法还减少了对严格容量规划的需求,因为可以随时从云端添加更多容量。在某些情况下,它还增加了对性能分析的需求:使用更少的资源可以意味着使用更少的系统。由于云使用通常按小时计费,所以通过减少系统数量来提高性能可以立即节省成本。将这种情况与企业客户进行比较,企业客户可能被锁定在数年的固定支持合同中,可能无法在合同结束之前实现成本节约。

云计算和虚拟化带来的新问题包括管理其他租户引起的性能影响(有时称为性能隔离)以及每个租户对物理系统的可观察性。例如,除非系统得到正确管理,否则由于与邻居竞争,磁盘I/O性能可能较差。在某些环境中,每个租户可能无法观测到物理磁盘的真实使用情况,这使得难以识别此问题。

这些主题在第11章《云计算》中进行了详细讨论。

1.9 Case Studies

如果您是系统性能方面的新手,可以通过展示何时以及为什么进行各种活动的案例研究来帮助您将它们与当前环境联系起来。这里总结了两个假想的例子:一个是涉及磁盘I/O的性能问题,另一个是针对软件更改的性能测试。

这些案例研究描述了在本书的其他章节中解释的活动。这里描述的方法旨在展示的不是正确的方法或唯一的方法,而是这些性能活动可以进行的一种方法,供您进行关键考虑。

1.9.1 Slow Disks

Scott是一家中型公司的系统管理员。数据库团队提交了一个支持工单,抱怨他们的一个数据库服务器上的“磁盘速度慢”。Scott的第一个任务是了解更多关于这个问题的情况,收集详细信息来形成一个问题陈述。工单声称磁盘速度慢,但没有解释这是否导致了数据库问题。Scott通过提出以下问题做出回应:

- 目前是否存在数据库性能问题?如何进行衡量?

- 这个问题存在多长时间了?

- 最近数据库有什么变化吗?

- 为什么怀疑是磁盘的问题?

数据库团队回复说:“我们有一个查询时间超过1,000毫秒的日志。通常这种情况不会发生,但在过去一周中每小时都有几十个。AcmeMon显示磁盘在忙碌。”这证实了确实存在一个数据库问题,但也表明磁盘假设很可能是一个猜测。Scott想检查磁盘,但他也想快速检查其他资源,以防那个猜测是错误的。

AcmeMon是公司的基本服务器监控系统,提供基于操作系统工具(mpstat(1)、iostat(1)等)的历史性能图形。Scott登录AcmeMon亲自查看。

Scott从一种称为USE方法的方法开始,快速检查资源瓶颈。如数据库团队所报道的,磁盘的利用率很高,约为80%,而对于其他资源(CPU、网络)的利用率则要低得多。历史数据显示,磁盘利用率在过去一周中稳步增加,而CPU利用率则保持稳定。AcmeMon不提供磁盘饱和度或错误统计信息,因此为了完成USE方法,Scott必须登录到服务器并运行一些命令。

他从/proc中检查磁盘错误计数器,结果为零。他运行iostat命令,间隔为一秒,并随时间观察利用率和饱和度指标。AcmeMon报告显示80%的利用率,但使用了一分钟的间隔。以一秒的粒度,Scott可以看到磁盘利用率波动很大,经常达到100%,导致饱和度水平升高和增加的磁盘I/O延迟。

为了进一步确认这是否阻塞了数据库,而不是与数据库查询异步进行,他使用基于动态跟踪的脚本来捕获每当数据库被内核挂起时的时间戳和数据库堆栈跟踪。这显示数据库经常在文件系统读取期间、查询期间以及持续数毫秒的时间内发生阻塞。这对于Scott来说已经是足够的证据。接下来的问题是为什么会发生这种情况。磁盘性能统计数据似乎与高负载一致。Scott进行工作负载特性分析以进一步了解情况,使用iostat(1)来测量IOPS、吞吐量、平均磁盘I/O延迟以及读/写比。通过这些数据,他还计算了平均I/O大小并估计访问模式:随机还是顺序。如果需要更多细节,Scott可以使用磁盘I/O级别跟踪;然而,他满意地认为这已经指向了高磁盘负载的情况,而不是磁盘的问题。

Scott在工单中增加了更多细节,说明了他所检查的内容,并包括了研究磁盘所使用的命令的屏幕截图。到目前为止,他的总结是磁盘处于高负载状态,这增加了I/O延迟并减慢了查询速度。然而,从负载情况来看,磁盘似乎表现正常。他询问是否有一个简单的解释:数据库的负载是否增加了?

数据库团队回复说没有,而且查询速率(这并未由AcmeMon报告)一直很稳定。这似乎与之前的发现一致,即CPU利用率也一直稳定。

Scott考虑到什么原因会导致磁盘I/O负载增加,而CPU没有明显增加,并与同事进行了快速交流。其中一位同事提出文件系统碎片化的可能性,当文件系统接近100%容量时,这是预期的。但实际上只有30%。

Scott知道他可以进行深入分析以了解磁盘I/O的确切原因,但这可能需要很长时间。他首先尝试想出其他易于检查的简单解释,基于他对内核I/O堆栈的了解。他记得这种磁盘I/O主要是由文件系统缓存(页面缓存)未命中引起的。

Scott检查了文件系统缓存命中率,发现当前为91%。听起来很高(很好),但他没有历史数据可以进行比较。他登录到其他提供类似工作负载的数据库服务器,发现它们的缓存命中率超过97%。他还发现其他服务器的文件系统缓存大小要大得多。

将注意力转向文件系统缓存大小和服务器内存使用情况,他发现了一个被忽视的问题:一个开发项目有一个原型应用程序,即使没有生产负载,也在消耗越来越多的内存。这些内存来自可供文件系统缓存使用的内存,降低了命中率,从而增加了磁盘I/O并影响生产数据库服务器。

Scott联系应用程序开发团队,并要求他们关闭应用程序并将其移动到另一台服务器,引用数据库问题。在他们这样做后,Scott观察到AcmeMon中的磁盘利用率逐渐下降,因为文件系统缓存恢复到原始大小。慢查询数量降为零,他将工单标记为已解决。

1.9.2 Software Change

Pamela是一家小公司的性能和可伸缩性工程师,负责所有与性能相关的工作。应用程序开发人员开发了一个新的核心功能,并不确定其引入是否会影响性能。Pamela决定在将新的应用程序版本部署到生产环境之前进行非回归测试。(非回归测试是用于确认软件或硬件更改不会导致性能退化的活动,因此被称为非回归测试。)

Pamela获取了一台空闲服务器用于测试,并寻找一个客户端工作负载模拟器。应用团队以前写过一个,尽管它有各种限制和已知的bug。她决定尝试使用它,但希望确认它是否充分类似于当前的生产工作负载。

她配置服务器以匹配当前的部署配置,并从不同的系统运行客户端工作负载模拟器到目标系统。通过研究访问日志,可以对客户端工作负载进行特征化,公司已经有一个工具可以做到这一点,她使用了这个工具。她还在不同时间的生产服务器日志上运行了这个工具,比较了工作负载。看起来客户端模拟器应用了一个平均的生产工作负载,但没有考虑变化。她注意到了这一点,并继续她的分析。

Pamela在这个阶段知道几种可以采用的方法。她选择了最简单的方法:从客户端模拟器增加负载,直到达到一个限制(工作负载)。客户端模拟器可以配置为每秒执行一定数量的客户端请求,其默认值为1,000,她之前已经使用过。她决定从100开始增加负载,每次增加100,直到达到一个限制,每个级别测试一分钟。她编写了一个shell脚本来执行测试,并将结果收集到一个文件中,以便由其他工具进行绘图。

在负载运行时,她进行主动基准测试以确定限制因素是什么。服务器资源和服务器线程似乎大部分处于空闲状态。客户端模拟器显示完成的请求大约稳定在每秒700个左右。

她切换到新的软件版本并重复测试。结果也达到了700个请求,并趋于稳定。她还分析了服务器以寻找限制因素,但仍然没有发现任何问题。

她绘制了结果,显示完成请求率与负载之间的关系,以直观地确定可伸缩性特征。两者似乎都达到了一个突然的上限。

尽管看起来软件版本具有类似的性能特征,但Pamela对于未能确定导致可伸缩性上限的限制因素感到失望。她知道自己只检查了服务器资源,而限制因素可能是应用程序逻辑问题。它也可能存在于其他地方:网络或客户端模拟器。

Pamela想知道是否需要采取不同的方法,例如运行固定速率的操作,然后对资源使用情况(CPU、磁盘I/O、网络I/O)进行特征化(资源使用),以便可以从单个客户端请求的角度来表示。她以每秒700个请求的速率运行模拟器,测试当前和新的软件,并测量资源消耗情况。对于给定的负载,当前软件将32个CPU的平均利用率提高到20%。对于同样的负载,新软件将相同的CPU利用率提高到30%。看起来确实存在回归问题,即消耗更多的CPU资源。

为了了解700的限制,Pamela增加了负载,并调查数据路径中的所有组件,包括网络、客户端系统和客户端工作负载生成器。她还对服务器和客户端软件进行了深入分析。她记录了自己所检查的内容,包括截屏,以供参考。

为了调查客户端软件,她进行了线程状态分析,并发现它是单线程的。这一个线程花费100%的时间在CPU上执行。这使她确信这就是测试的限制因素。

作为一项实验,她在不同的客户端系统上并行启动客户端软件。通过这种方式,她让服务器在当前软件和新软件下都达到了100%的CPU利用率。当前版本达到了每秒3,500个请求,而新版本达到了每秒2,300个请求,与先前的资源消耗结果一致。

Pamela通知应用程序开发人员,新软件版本存在回归问题,并开始对其CPU使用情况进行分析以了解原因:哪些代码路径在起作用。她指出进行了平均生产工作负载测试,但未进行各种工作负载测试。她还提交了一个bug,指出客户端工作负载生成器是单线程的,可能成为瓶颈。

1.9.3 More Reading

第13章《案例研究》提供了一个更详细的案例研究,记录了我如何解决一个特定的云性能问题。下一章介绍了用于性能分析的方法论,并且接下来的章节涵盖了必要的背景知识和具体内容。

2 Methodology

在没有数据之前进行理论推测是一个严重的错误。不知不觉中,人们开始扭曲事实以适应理论,而不是调整理论以适应事实。

阿瑟·柯南·道尔爵士的《波西米亚丑闻》中的福尔摩斯警句

当面临性能下降和复杂的系统环境时,首要挑战是确定从哪里开始分析、收集哪些数据以及如何进行分析。正如我在第一章中所说,性能问题可能来自任何地方,包括软件、硬件和数据路径上的任何组件。方法论可以帮助性能分析人员处理复杂的系统,指导他们从何处开始,并采取哪些步骤来定位和分析性能问题。对于初学者,方法论指明了起点并提供了详细的步骤。对于普通用户或专家,它们可以作为检查清单,以确保不会错过细节。它们包括量化和确认发现的方法,识别最重要的性能问题。

本章分为三个部分:

- 背景介绍术语、基本模型、关键性能概念和观点。

- 方法论讨论性能分析方法论,包括观察和实验方法;建模;以及容量规划。

- 指标介绍性能统计、监控和可视化。

这里介绍的许多方法论在后面的章节中会进行更详细的探讨,包括第5到第10章的方法论部分。

2.1 Terminology

以下是系统性能的关键术语。后面的章节提供了更多的术语,并在不同的上下文中对其中一些进行了描述。

- IOPS:每秒输入/输出操作是数据传输操作的速率衡量单位。对于磁盘I/O,IOPS指的是每秒的读取和写入次数。

- 吞吐量:工作执行的速率。特别是在通信中,该术语用于表示数据速率(每秒字节数或每秒比特数)。在某些情况下(例如数据库),吞吐量可以指操作速率(每秒操作次数或每秒事务数)。

- 响应时间:操作完成所需的时间。这包括等待时间和服务时间(服务时间包括传输结果的时间)。

- 延迟:延迟是指一个操作等待服务的时间。在某些情况下,它可以指整个操作所花费的时间,相当于响应时间。有关示例,请参见第2.3节中的概念部分。

- 利用率:对于为请求提供服务的资源,利用率是基于在给定时间间隔内资源处于主动执行工作状态的时间的度量。对于提供存储的资源,利用率可能指已使用的容量(例如内存利用率)。

- 饱和度:资源无法处理的排队工作的程度。

- 瓶颈:在系统性能中,瓶颈是限制系统性能的资源。识别和消除系统性瓶颈是系统性能的关键活动。

- 工作负载:输入到系统或施加的负载即为工作负载。对于数据库而言,工作负载由客户端发送的数据库查询和命令组成。

- 缓存:快速存储区域,可以复制或缓冲有限量的数据,以避免直接与较慢的存储层通信,从而提高性能。出于经济原因,缓存的大小小于较慢的存储层。

需要时,附录中包含了基本术语以供参考。

2.2 Models

以下简单模型说明了系统性能的一些基本原理。

2.2.1 System under Test

系统测试下的性能展示如图2.1所示。

//Perturbations:干扰

需要意识到,干扰(干涉)可能会影响结果,其中包括由系统定期活动、系统其他用户以及其他工作负载引起的干扰。这些干扰的来源可能不太清晰,可能需要仔细研究系统性能来确定。在一些云环境中,这可能特别困难,因为在客户SUT内部无法观察到物理主机系统上其他租户的活动(由客户租户进行的其他活动)。现代环境的另一个困难在于,它们可能由几个网络化组件组成,用于处理输入工作负载,包括负载均衡器、Web 服务器、数据库服务器、应用服务器和存储系统。仅是对环境进行映射可能有助于揭示先前被忽视的干扰源。该环境也可以被建模为队列系统的网络,进行分析性研究。

2.2.2 Queueing System

一些组件和资源可以被建模为队列系统。图2.2展示了一个简单的队列系统。

队列论是在第2.6节“建模”中介绍的,它研究队列系统和队列系统网络。

2.3 Concepts

以下是系统性能的重要概念,假设读者在本章和本书的其余部分已经具备相关知识。这些主题以一种通用的方式进行描述,然后在后面章节的架构和分析部分引入具体的实现细节。

2.3.1 Latency

对于某些环境而言,延迟是性能的唯一关注点。对于其他环境,延迟是分析的首要或前两个关键领域之一,与吞吐量一起。

以延迟为例,图2.3展示了一个网络传输的示例,比如一个HTTP GET请求,将时间分为延迟和数据传输组成部分。

延迟是指在执行操作之前花费的等待时间。在这个例子中,该操作是一个网络服务请求,用于传输数据。在进行这个操作之前,系统必须等待建立网络连接,这就是该操作的延迟。响应时间跨越了这个延迟和操作时间。

由于延迟可以从不同的位置进行测量,因此通常会与测量的目标一起表示。例如,网站的加载时间可能由从不同位置测得的三个不同的时间组成:DNS延迟、TCP连接延迟,以及TCP数据传输时间。DNS延迟涉及整个DNS操作。TCP连接延迟仅涉及初始化(TCP握手)。

在更高的层次上,所有这些,包括TCP数据传输时间,都可以被视为其他某种东西的延迟。例如,从用户点击网站链接到结果页面完全加载完成的时间可以称为延迟,其中包括浏览器渲染网页所需的时间。

由于延迟是一种基于时间的度量,可以进行各种计算。通过使用延迟来量化性能问题,然后对其进行排序,因为它们使用相同的单位(时间)进行表示。也可以通过考虑何时可以减少或消除延迟来计算预测的加速比。例如,使用IOPS指标无法准确执行这两种计算。

供参考,时间量级及其缩写列在表2.1中。

在可能的情况下,可以将其他类型的指标转换为延迟或时间,以便进行比较。如果你必须在100个网络I/O和50个磁盘I/O之间进行选择,你如何知道哪一个性能更好?这将是一个复杂的选择,涉及许多因素:网络跳数、网络丢包和重新传输的速率、I/O大小、随机或顺序I/O、磁盘类型等等。但是,如果你比较总共100毫秒的网络I/O和总共50毫秒的磁盘I/O,差异是明显的。

2.3.2 Time Scales

虽然时间可以通过数字进行比较,但对时间有一种本能感觉,并且对来自不同来源的延迟有期望也很有帮助。系统组件在时间尺度上(数量级)的操作差异巨大,以至于很难理解这些差异有多大。在表2.2中,提供了示例延迟,从3.3 GHz处理器的CPU寄存器访问开始。为了展示我们正在使用的时间尺度之间的差异,该表显示了每个操作可能需要的平均时间,按比例缩放到一个想象中的系统中,在该系统中,寄存器访问(在现实生活中为0.3纳秒,约为十亿分之一秒)需要一秒钟的时间。

正如你所看到的,CPU周期的时间尺度非常小。光线传播0.5米的时间,也许就是从你的眼睛到这个页面的距离,大约是1.7纳秒。在同样的时间内,一颗现代CPU可能已经执行了五个CPU周期并处理了几条指令。

关于CPU周期和延迟的更多信息,请参阅第6章《CPU》,有关磁盘I/O延迟,请参阅第9章《磁盘》。包含的互联网延迟来自第10章《网络》,其中还有更多例子。

2.3.3 Trade-offs

你应该意识到一些常见的性能权衡。好/快/便宜的“选择两个”权衡如图2.4所示,同时还有为IT项目调整过的术语。

许多IT项目在时间和成本上都把控得很好,但却将性能修复留到后期。当早期的决策阻碍了提高性能时,这个选择可能会变得有问题,比如选择和填充次优的存储架构,或者使用缺乏全面性能分析工具的编程语言或操作系统。

性能调整中常见的权衡是CPU和内存之间的权衡,因为内存可以用于缓存结果,减少CPU使用量。在现代系统中,由于CPU充足,这种权衡可能会反过来:CPU可以用来压缩数据以减少内存使用量。

可调参数通常伴随着权衡。以下是一些例子:

文件系统记录大小(或块大小):接近应用程序I/O大小的小记录大小对于随机I/O工作负载表现更好,并且在应用程序运行时更有效地利用文件系统缓存。大记录大小将改善流式工作负载,包括文件系统备份。

网络缓冲区大小:小缓冲区大小将减少每个连接的内存开销,帮助系统扩展。大尺寸将提高网络吞吐量。

在对系统进行更改时,请寻找这样的权衡。

2.3.4 Tuning Efforts

//调优工作

性能调优最有效的时候是在工作执行的最近位置进行。对于由应用程序驱动的工作负载,这意味着在应用程序本身内部进行调优。表2.3展示了一个软件栈的示例,其中包含了调优的可能性。

通过在应用程序级别进行调优,可能可以消除或减少数据库查询,并将性能大幅提高(例如,20倍)。将调优降至存储设备级别可能会消除或改善存储I/O,但已经执行了较高级别的操作系统堆栈代码,因此这可能仅会将结果应用程序的性能提高百分之几(例如,20%)。

在应用程序级别找到大幅度的性能提升还有另一个原因。如今,许多环境都以快速部署功能和功能为目标。因此,在生产部署之前,应用程序的开发和测试往往集中在正确性上,几乎没有时间进行性能测量或优化。这些活动通常在性能成为问题时才进行。

虽然应用程序可能是最有效的调优级别,但不一定是最有效的观察级别。慢查询可能最好通过它们在 CPU 上花费的时间或它们执行的文件系统和磁盘 I/O 来理解。这些可以通过操作系统工具进行观察。

在许多环境中(尤其是云计算环境),应用程序级别处于不断开发的状态,每周甚至每天都会推送软件更改到生产环境。在应用程序代码发生变化时,通常会找到大的性能优化,包括修复回归问题。在这些环境中,很容易忽视针对操作系统的调优和从操作系统进行观测。

请记住,操作系统性能分析也可以识别应用程序级别的问题,而不仅仅是操作系统级别的问题,在某些情况下比仅从应用程序中更容易识别。

2.3.5 Level of Appropriateness

不同的组织和环境对性能有不同的要求。你可能加入了一个组织,在这个组织中,深度分析的程度超出了你以前见过的范围,甚至是你所知道的可能范围。或者你可能会发现,你认为基本的分析被视为高级分析,并且以前从未执行过(好消息是:很容易获得成果!)。

这并不意味着某些组织做得对,而某些组织做得错。这取决于性能专业知识的投资回报率(ROI)。拥有大型数据中心或云环境的组织可能需要一个性能工程师团队,他们分析一切,包括内核内部和CPU性能计数器,并经常使用动态跟踪。他们还可能正式建模性能,并为未来的增长制定准确的预测。小型初创公司可能只有时间进行表面检查,信任第三方监控解决方案来检查他们的性能并提供警报。

最极端的环境包括股票交易所和高频交易者,性能和延迟至关重要,并且可以证明需要投入巨大的努力和费用。作为一个例子,目前计划在纽约和伦敦交易所之间建立一条新的跨大西洋电缆,耗资3亿美元,以减少传输延迟6毫秒[1]。

2.3.6 Point-in-Time Recommendations

环境的性能特性随着时间的推移而变化,这是由于增加了更多的用户、更新的硬件和软件或固件所导致的。一个目前受限于1 Gbit / s网络基础设施的环境,在升级到10 Gbit / s后可能会开始感到磁盘或CPU性能不足。

性能建议,特别是可调参数的值,仅在特定时间点有效。一个星期内的性能专家给出的最佳建议,一个星期后可能因软件或硬件升级或添加更多用户而失效。

在互联网上搜索到的可调参数值可以在某些情况下提供快速解决方案。但是,如果它们对于您的系统或工作负载不合适,曾经适用但现在不适用,或者只适用于软件漏洞的临时解决方法,这些参数值也可能会损害性能。这就像搜刮别人的药柜并服用可能不适合您的药物,或者已经过期,或者只应该短期服用一样。

浏览此类建议可以很有用,只是为了了解哪些可调参数存在并且过去需要更改。然后的任务就是看看这些参数是否适合您的系统和工作负载,以及如何调整它们。但是,如果其他人以前没有需要调整该参数,或者已经调整了该参数但没有在任何地方分享他们的经验,您仍然可能会忽略一个重要的参数。

2.3.7 Load versus Architecture

应用程序的性能不佳可能是由于软件配置和运行的硬件(即其架构)存在问题。然而,应用程序也可能由于负载过大而导致排队和延迟过长而表现不佳。负载和架构如图2.5所示。

如果架构分析显示工作正在排队,但没有关于工作执行方式的问题,那么问题可能是负载过多。在云计算环境中,这时可以引入更多节点来处理工作。

例如,架构问题可能是一个繁忙的单线程应用程序,请求在排队,而其他CPU可用且空闲。在这种情况下,性能受限于应用程序的单线程架构。

负载问题可能是一个多线程应用程序,它在所有可用的CPU上都很繁忙,但请求仍在排队。在这种情况下,性能受限于可用的CPU容量,或者换句话说,是负载超过了CPU可以处理的负荷。

2.3.8 Scalability

在负载增加的情况下,系统的性能表现为可扩展性。图2.6展示了系统负载增加时的典型吞吐量曲线。

在某个阶段,观察到线性可扩展性。然后达到一个点,用虚线标记,资源争用开始影响性能。这一点可以被描述为拐点,因为它是两个曲线之间的边界。超过这一点,随着资源争用的增加,吞吐量曲线偏离线性可扩展性。最终,由于更多资源争用和一致性导致完成的工作减少,吞吐量减少。

当一个组件达到100%利用率时,即饱和点时,这一点可能会出现。它也可能在一个组件接近100%利用率时发生,排队开始变得频繁和显著。

一个可能表现出这种曲线的系统是一个执行重计算的应用程序,随着线程的增加,负载越来越大。当CPU接近100%利用率时,性能开始下降,因为CPU调度器延迟增加。在达到最高性能后,即100%利用率时,随着添加更多线程,吞吐量开始降低,导致更多的上下文切换,消耗CPU资源并导致完成的实际工作减少。

如果将x轴上的“负载”替换为CPU核心等资源,则可以看到相同的曲线。有关此主题的更多信息,请参见第2.6节,“建模”。

非线性可扩展性的性能退化,以平均响应时间或延迟为基础,可以在图2.7 [Cockcroft 95]中绘制出来。

较高的响应时间当然是不好的。当系统开始进行分页(或交换)以补充主内存时,可能会出现"快速"退化的内存负载情况。而对于CPU负载,则可能会出现"缓慢"退化的情况。

另一个"快速"退化的示例是磁盘I/O。随着负载(及其导致的磁盘利用率)的增加,I/O更有可能排队等待其他I/O完成。一个空闲的旋转磁盘可能在大约1毫秒的响应时间内提供I/O服务,但当负载增加时,这个时间可能接近10毫秒。这在第2.6.5节的M/D/1和60%利用率中有所建模。

如果应用程序在资源不可用时开始返回错误而不是将工作排队,那么响应时间的线性可扩展性可能会发生。例如,Web服务器可能会返回503“服务不可用”而不是将请求添加到队列中,以便那些已经得到服务的请求可以以一致的响应时间执行。

2.3.9 Known-Unknowns

在前言中介绍的已知已知、已知未知和未知未知的概念对于性能领域非常重要。以下是分类说明,以系统性能分析为例:

已知已知:这些是你已经知道的事情。你知道你应该检查性能指标,也知道它的当前值。例如,你知道应该检查CPU利用率,并且知道平均值为10%。

已知未知:这些是你知道自己不知道的事情。你知道可以检查指标或子系统的存在,但尚未观察到。例如,你知道可以通过使用剖面来检查使CPU繁忙的原因,但尚未这样做。

未知未知:这些是你不知道自己不知道的事情。例如,你可能不知道设备中断会成为严重的CPU消耗者,因此没有对其进行检查。

性能是一个“你知道得越多,你不知道得就越多”的领域。这是相同的原则:你学到的关于系统的越多,你就会意识到更多的未知未知,然后可以将其作为已知未知进行检查。

2.3.10 Metrics

性能指标是由系统、应用程序或附加工具生成的统计数据,用于测量感兴趣的活动。它们被用于性能分析和监控,可以通过命令行数字或使用可视化图形进行研究。

常见的系统性能指标类型包括:

IOPS:每秒I/O操作次数

吞吐量:每秒操作或每秒传输的容量

利用率

延迟

吞吐量的使用取决于其上下文。数据库吞吐量通常是每秒查询或请求(操作)的衡量标准。网络吞吐量是每秒比特或字节(容量)的衡量标准。

IOPS是一种吞吐量测量,但仅适用于I/O操作(读取和写入)。同样,上下文很重要,定义可能因情况而异。

Overhead

//开销

性能指标并非免费;在某些时候,必须花费CPU周期来收集和存储它们。这会导致开销,可能会对测量目标的性能产生负面影响。这被称为观察效应。(它经常与海森堡的不确定性原理混淆,后者描述了物理属性对,如位置和动量,可以被知道的精度限制。)

Issues

//问题

人们往往会认为软件供应商提供的指标选择得当、没有错误,并提供完整的可见性。实际上,指标可能令人困惑、复杂、不可靠、不准确,甚至完全错误(由于错误)。有时,某个指标在一个软件版本上是正确的,但没有更新以反映新代码和代码路径的添加。

有关指标问题的更多信息,请参见第4章Observability Tools的第4.6节“观察可观性”。

2.3.11 Utilization

术语“利用率”通常用于操作系统中描述设备的使用情况,比如CPU和磁盘设备。利用率可以基于时间或容量来衡量。

Time-Based

基于时间的利用率在排队论中有正式定义。例如 [Gunther 97]:

服务器或资源繁忙的平均时间量

以及比率

U = B/T

其中,U表示利用率,B表示系统在观察期间T内繁忙的总时间。

这也是操作系统性能工具中最常见的“利用率”。磁盘监控工具iostat(1)将此指标称为“%b”,表示百分比繁忙,这个术语更能传达出底层的指标:B/T。

该利用率指标告诉我们组件有多忙:当组件接近100%利用率时,资源争用时性能可能严重下降。可以检查其他指标来确认并查看该组件是否成为系统瓶颈。

某些组件可以并行地处理多个操作。对于它们来说,在100%利用率时性能可能不会严重下降,因为它们可以接受更多的工作负载。

为了理解这一点,考虑一个大楼的电梯。当电梯在楼层之间移动时,它被认为是被利用的;当它处于空闲等待状态时,它被认为是未被利用的。然而,即使电梯在100%的时间里都在忙碌地响应呼叫,它可能仍然能够接受更多的乘客,也就是说,它处于100%的利用率。

一个100%繁忙的磁盘也可能能够接受和处理更多的工作负载,例如通过将写操作缓冲到磁盘缓存中以便稍后完成。存储阵列通常以100%的利用率运行,因为某些磁盘在100%的时间内都很忙,但阵列中有很多空闲磁盘,可以接受更多的工作负载。

Capacity-Based

另一个关于利用率的定义是由 IT 专业人员在容量规划的背景下使用的 [Wong 97]:

一个系统或组件(例如磁盘驱动器)能够提供一定数量的吞吐量。在任何性能水平下,系统或组件都在其容量的某个比例上工作。这个比例被称为利用率。

这种定义是基于容量而不是时间来定义利用率。它意味着100%利用率的磁盘无法接受更多的工作负载。根据基于时间的定义,100%利用率仅表示它在100%的时间内处于繁忙状态。

100%繁忙并不意味着100%容量。

以电梯为例,100%容量可能意味着电梯已达到最大载重量,无法接受更多乘客。

在理想的情况下,我们能够同时测量设备的这两种利用率。例如,你可以知道磁盘是否100%繁忙并且由于争用而性能开始下降,以及它是否已达到100%容量无法接受更多工作。然而,很遗憾,通常情况下这是不可能的。对于磁盘来说,需要了解磁盘上的控制器正在做什么,并对容量进行预测。目前,磁盘并不提供这些信息。

在本书中,利用率通常指的是基于时间的版本。容量版本用于一些基于容量的指标,例如内存使用情况。

Non-Idle Time

在我们公司开发云监控项目期间,定义利用率的问题浮现出来。首席工程师 Dave Pacheco 叫我定义利用率。我照上面的定义给了他。然而,他对可能引起混淆的可能性不满意,因此提出了一个不同的术语,以使其不言自明:非空闲时间。

虽然这更准确,但它目前还没有广泛使用(通常将此指标称为百分比繁忙,就像之前所描述的)。

2.3.12 Saturation

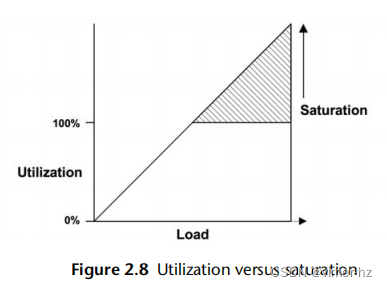

当对资源请求的工作量超过其处理能力时,饱和度就会发生。在100%利用率(基于容量)时开始出现饱和,因为无法处理额外的工作负载并且开始排队。这在图2.8中有所描述。

该图显示了饱和度随着负载的增加而线性增加,超过了基于100%容量的利用率标记。任何程度的饱和度都是一个性能问题,因为时间被浪费在等待上(延迟)。对于基于时间的利用率(百分比繁忙),排队和因此饱和可能不会在100%利用率标记处开始,这取决于资源可以并行处理工作的程度。

2.3.13 Profiling

性能剖析构建了一个可以被研究和理解的目标的画像。在计算机性能领域,性能剖析通常通过定时采样系统状态,然后研究采样集来完成。与之前涉及的指标(包括IOPS和吞吐量)不同,采样提供了目标活动的粗略视图,具体取决于采样频率。

例如,通过在频繁间隔采样CPU程序计数器或堆栈回溯,收集消耗CPU资源的代码路径的统计信息,可以相对详细地了解CPU使用情况。这个话题在第6章“CPU”中有所涉及。

2.3.14 Caching

缓存经常被用来提高性能。缓存将较慢存储层的结果存储在更快的存储层中以供参考。一个例子是将磁盘块缓存到主内存(RAM)中。

可以使用多个级别的缓存。CPU通常使用多个硬件缓存来处理主内存(第1、2和3级),从一个非常快速但较小的缓存(第1级)开始,随着存储容量和访问延迟的增加而增加。这是密度和延迟之间的经济权衡;级别和大小是为可用芯片空间的最佳性能而选择的。

系统中还有许多其他缓存,其中许多是使用主内存作为存储器实现的。请参见第3章“操作系统”的3.2.11节“缓存”中的缓存层列表。

了解缓存性能的一种指标是每个缓存的命中率-所需数据在缓存中被找到的次数(命中)与未找到的次数(未命中)之比:

命中率= 命中次数/总访问次数(命中次数+未命中次数)

命中率越高越好,因为更高的比率反映了从更快的媒体中成功访问的数据更多。图2.9显示了随着缓存命中率的增加,性能改善的预期情况。

98%和99%之间的性能差异要大于10%和11%之间的差异。这是一个非线性的情况,因为缓存命中和未命中之间的速度差异-两个不同的存储层。差异越大,斜率就越陡。

另一个了解缓存性能的指标是每秒的缓存未命中率。这与每个未命中的性能惩罚成正比(线性关系),并且更容易解释。

例如,工作负载A和B使用不同的算法执行相同的任务,并使用主内存缓存来避免从磁盘读取。工作负载A的缓存命中率为90%,工作负载B的缓存命中率为80%。仅凭这些信息,可以推断工作负载A的性能更好。如果工作负载A的未命中率为200/s,而工作负载B为20/s呢?以这种方式计算,工作负载B的磁盘读取次数要比A少10倍,这可能比A更早完成任务。为确保准确,可以计算每个工作负载的总运行时间:

运行时间=(命中率×命中延迟)+(未命中率×未命中延迟)

该计算使用了平均命中延迟和未命中延迟,并假设工作负载是串行执行的。

Algorithms

缓存管理算法和策略决定了在有限的缓存空间中存储什么内容。

最近最常使用(MRU)是指缓存保留策略,它决定在缓存中保留哪些对象:最近被使用的对象。最不常使用(LRU)可以指等效的缓存驱逐策略,决定在需要更多空间时从缓存中删除哪些对象。还有最常使用(MFU)和最不常使用(LFU)的策略。

您可能会遇到不经常使用(NFU),它可能是LRU的一种廉价但不太彻底的版本。

Hot, Cold, and Warm Caches

以下是描述缓存状态常用的词汇:

冷缓存:一个冷缓存是空的,或者被不需要的数据占据。对于一个冷缓存来说,命中率为零(或者在开始变暖时接近零)。

热缓存:一个热缓存被常请求的数据所占据,并且有很高的命中率,例如超过99%。

温缓存:一个温缓存被有用的数据所占据,但它的命中率不够高以被认为是热缓存。

温度:缓存温度描述了一个缓存是热还是冷的程度。提高缓存命中率的活动被称为提高缓存温度的活动。当缓存首次被初始化时,它们开始冷,然后随着时间的推移变暖。

当缓存很大或下一级存储速度很慢(或两者都是),缓存可能需要很长时间才能被填充和变暖。

例如,我曾经在一个存储设备上工作,该设备有128 G字节的DRAM作为文件系统缓存,600 G字节的闪存作为二级缓存,并使用旋转磁盘进行存储。在随机读取的工作负载下,磁盘的读取速度大约为每秒2,000个。以8 K字节的IO大小计算,这意味着缓存只能以16 M字节/秒(2,000 x 8 K字节)的速度变暖。当两个缓存都开始变冷时,DRAM缓存需要超过2小时才能变暖,闪存缓存需要超过10小时。

2.4 Perspectives

性能分析有两种常见的视角,每种视角都有不同的受众、指标和方法。它们分别是工作负载分析和资源分析。可以将它们看作对操作系统软件栈进行自上而下或自下而上的分析,如图2.10所示。

第2.5节"方法论"提供了针对每种视角应用的具体策略。这里更详细地介绍了这些视角。

2.4.1 Resource Analysis

资源分析始于对系统资源的分析:包括CPU、内存、磁盘、网络接口、总线和互连。这通常由系统管理员执行,他们负责物理环境资源。活动包括:

1. 性能问题调查:查看特定类型的资源是否负责性能问题。

2. 容量规划:用于确定新系统的大小,并查看现有系统资源何时可能耗尽。

这个视角侧重于利用率,以确定资源是否达到或接近其限制。某些资源类型,如CPU,具有易于获取的利用率指标。其他资源的利用率可以根据可用指标进行估算,例如,通过比较发送和接收的兆位每秒(吞吐量)与已知的最大带宽来估算网络接口的利用率。

最适合资源分析的指标包括:

1. IOPS(每秒输入输出操作数)

2. 吞吐量

3. 利用率

4. 饱和度

这些指标衡量了资源被要求执行的任务,以及在给定负载下它的利用率或饱和度。其他类型的指标,包括延迟,也可以用于查看资源在给定工作负载下的响应情况。

资源分析是性能分析的常见方法,部分原因是因为该主题有广泛可用的文档。这样的文档集中在操作系统的“stat”工具上:vmstat(1)、iostat(1)、mpstat(1)。阅读这样的文档时,重要的是要理解这只是一种视角,而不是唯一的视角。

2.4.2 Workload Analysis

工作负载分析(见图2.11)研究应用程序的性能:应用的工作负载以及应用程序的响应情况。它最常由应用程序开发人员和支持人员使用,他们负责应用程序软件和配置。

工作负载分析的目标包括:

请求:所应用的工作负载

延迟:应用程序的响应时间

完成:查找错误

研究工作负载请求通常涉及检查和总结其属性,即工作负载表征的过程(在第2.5节的方法论中更详细地描述)。对于数据库而言,这些属性可能包括客户端主机、数据库名称、表格和查询字符串。这些数据可以帮助识别不必要的工作或工作不平衡的情况。虽然工作可能表现良好(延迟低),但通过检查这些属性可能会找到减少或消除所应用工作的方法。(最快的查询是根本不进行查询。)

延迟(响应时间)是表达应用程序性能最重要的指标。对于MySQL数据库来说,它是查询延迟;对于Apache来说,它是HTTP请求延迟;等等。在这些情境中,延迟一词被用来表示与响应时间相同的含义(有关上下文的更多信息,请参阅第2.3.1节“延迟”)。工作负载分析的任务包括识别和确认问题,例如通过查找超出可接受阈值的延迟,然后找到延迟的来源(深入分析),并确认在应用修复后延迟是否得到改善。请注意,起点是应用程序。调查延迟通常涉及更深入地分析应用程序、库和操作系统(内核)。

通过研究与事件完成相关的特征,包括其错误状态,可以确定系统问题。虽然一个请求可能很快完成,但如果以错误状态完成,会导致请求被重试,从而累积延迟。

最适合工作负载分析的指标包括:

吞吐量(每秒事务数)

延迟

这些指标衡量请求的速率和结果性能。

2.5 Methodology

本节介绍了系统性能分析和调优的许多方法论和程序,并引入了一些新的方法,特别是USE方法。还包括了一些反方法论。

为了帮助总结它们的作用,这些方法论被归类为不同类型,例如观察分析和实验分析,如表2.4所示。

性能监控、排队理论和容量规划将在本章后面进行介绍。后面的章节还将在不同的上下文中重新解释其中一些方法,并提供一些特定于性能分析领域的附加方法。

下面的几节以常用但较弱的方法作为比较的起点,包括反方法论。在进行性能问题分析时,你应该首先尝试使用问题陈述方法,然后再尝试其他方法。

2.5.1 Streetlight Anti-Method

这种方法实际上是缺乏明确方法论的一种做法。用户通过选择熟悉的、在互联网上找到的或随意选择的可观测工具来分析性能,以查看是否有明显的问题。这种方法是凭运气的,可能会忽视许多类型的问题。

类似地,调优性能也可以尝试使用试错的方式,将已知和熟悉的可调参数设置为不同的值,以查看是否有所帮助。

即使这种方法揭示了一个问题,由于工具或调整与问题无关,因为它们是熟悉的,所以可能会很慢。因此,这种方法学被命名为街灯效应,它是以一个寓言来说明的:

一天晚上,一名警察看到一个醉汉在路灯下搜索地面,他问他在找什么。醉汉说他丢了钥匙。警察也找不到,问道:“你确定是在这儿丢的,就在路灯下?”醉汉回答:“不,但这里的光最亮。”

在性能方面,这相当于查看top(1),不是因为它有道理,而是因为用户不知道如何阅读其他工具。

这种方法找到的问题可能是一个问题,但不是真正的问题。其他方法可以对发现进行量化,以便更快地排除错误的结果。

2.5.2 Random Change Anti-Method

这是一种实验性的反方法论。用户随机猜测问题可能出在哪里,然后不断更改事物直到问题消失。为了确定每次更改是否改善了性能,会研究一项指标,例如应用程序运行时间、操作时间、延迟、操作速率(每秒操作数)或吞吐量(每秒字节数)。具体步骤如下:

1. 随机选择一个要更改的项目(例如一个可调参数)。

2. 在一个方向上进行更改。

3. 测量性能。

4. 在另一个方向上进行更改。

5. 测量性能。

6. 步骤3或步骤5的结果是否比基准线好?如果是,保留该更改并返回到步骤1。

尽管这个过程最终可能会发现适用于经过测试工作负载的调整方法,但它非常耗时,而且长期来看可能会留下没有意义的调整。例如,一个应用程序的更改可能会改善性能,因为它规避了数据库或操作系统的错误,而这个错误之后会被修复。但是应用程序仍将保留那个不再有意义的调整,而且一开始没有人正确理解。

另一个风险是,一个没有被正确理解的更改在生产高峰负载期间导致更严重的问题,并在此期间需要撤销该更改。

//即还是要理解业务之前的写法原理

2.5.3 Blame-Someone-Else Anti-Method

这种反方法论按照以下步骤进行:

1. 找到一个你不负责的系统或环境组件。

2. 假设问题出在那个组件上。

3. 将问题转给负责那个组件的团队。

4. 当证明错误时,返回到步骤1。

也许问题出在网络上。你能否向网络团队确认是否有丢包或其他问题?

使用这种方法论时,用户并不会调查性能问题,而是将问题推给其他人,当问题最终证明并非他们的问题时,可能会浪费其他团队的资源。这种反方法论的特征是缺乏数据支持的假设。

为了避免成为责怪他人的受害者,可以要求控告者提供截图,显示运行了哪些工具以及如何解释输出。你可以将这些截图和解释带给其他人进行第二意见。

//在阅读这些方法论时感觉像是自己的职业经历...

2.5.4 Ad Hoc Checklist Method

当被要求检查和调优系统时,通过按照一个预设的检查清单逐步进行是支持专业人员常用的方法论,通常在较短的时间内完成。一个典型的场景涉及将新的服务器或应用程序部署到生产环境中,支持专业人员花费半天时间检查系统在真实负载下的常见问题。这些检查清单是临时性的,根据最近的经验和该类型系统的问题建立起来。

以下是一个检查清单条目的示例:

运行iostat -x 1,并检查等待时间(await)列。如果负载期间该值持续超过10毫秒,则表示磁盘要么速度慢,要么超负荷。

一个检查清单可能包含十几个这样的检查。

尽管这些检查清单可以在最短时间内提供最大价值,但它们只是针对特定时刻的建议(参见第2.3节,概念),需要经常更新以保持最新。它们也倾向于关注已知可以轻松记录的问题的解决方法,如可调参数的设置,而不是源代码或环境的定制修复方法。

如果你管理一个支持专业人员团队,一个临时性的检查清单可以是确保每个人都知道如何检查最严重问题的有效方式,并且已经检查了所有明显的问题。检查清单可以编写得清晰明确,展示如何识别每个问题以及解决方法是什么。但当然,这个清单必须不断更新。

2.5.5 Problem Statement

当支持人员首次响应问题时,定义问题陈述是一项例行任务。这是通过问客户以下问题来完成的:

1. 什么让你觉得有性能问题?

2. 这个系统以前表现良好吗?

3. 最近有什么变化?软件?硬件?负载?

4. 问题可以用延迟或运行时间来表达吗?

5. 问题是否影响其他人或应用程序(还是只有你)?

6. 环境如何?使用了哪些软件和硬件?版本?配置?

只需问这些问题并回答它们通常就能指向一个即时的原因和解决方案。因此,问题陈述被包含在这里作为自己的方法论,并且应该是你解决新问题时使用的第一种方法。

2.5.6 Scientific Method

科学方法通过提出假设并进行测试来研究未知领域。它可以总结为以下步骤:

1. 问题

2. 假设

3. 预测

4. 测试

5. 分析

问题是性能问题陈述。基于这个问题陈述,你可以假设导致性能不佳的原因是什么。然后,你构建一个测试,这个测试可以是观察性的或实验性的,它测试了基于假设的预测。最后,对收集到的测试数据进行分析。

例如,你可能会发现在迁移到内存较少的系统后,应用程序性能下降了,并且你假设性能不佳的原因是较小的文件系统缓存。你可以使用观察性测试来测量两个系统上的缓存未命中率,预测较小系统上的缓存未命中率会更高。实验性测试可以是增加缓存大小(添加RAM),预测性能会提升。另一个可能更简单的实验性测试是人为减少缓存大小(使用可调参数),预测性能会变差。

/*有什么指标可以查看系统的内存命中率?

1. 缺页率(Page Fault Rate):缺页率是指在内存中无法找到所需数据或指令,需要从磁盘中加载的比例。较高的缺页率表示内存命中率较低。

2. 页面命中率(Page Hit Rate):页面命中率是指在虚拟内存系统中,将页面从磁盘加载到内存中时成功找到并加载到内存的页面的比例。较高的页面命中率表示内存命中率较高。

*/

/*

Minor Page Fault和Major Page Fault的区别:

Minor Page Fault和Major Page Fault是两种不同类型的页面错误(Page Fault),它们在内存管理中具有不同的含义和影响。

1. Minor Page Fault(次要页面错误):

- 当进程访问的页面在物理内存中存在,但没有映射到进程的虚拟地址空间时,会发生次要页面错误。

//进程的虚拟地址空间,不会映射所有的物理内存

- 次要页面错误通常是由分页机制中的页面置换策略引起的,用于将最近不活跃的页交换出去,以便为新的页腾出空间。

- 当发生次要页面错误时,操作系统只需更新页表,将正确的物理页面映射到进程的虚拟地址空间中,而无需从磁盘加载数据,因此通常速度较快。

2. Major Page Fault(主要页面错误):

- 主要页面错误通常是由于所需的页面不在物理内存中,需要从磁盘加载到内存中才能满足进程的访问需求。

- 当发生主要页面错误时,操作系统必须从磁盘读取相应的页面数据,然后更新页表,将该页面映射到进程的虚拟地址空间中。这个过程涉及磁盘访问,因此速度相对较慢。

*/

以下是一些更多的示例:

Example (Observational)

1. 问题:是什么导致数据库查询变慢?

2. 假设:嘈杂的邻居(其他云计算租户)正在执行磁盘I/O,与数据库的磁盘I/O竞争(通过文件系统)。

3. 预测:如果在查询期间测量文件系统的I/O延迟,将会发现文件系统是导致查询变慢的原因。

4. 测试:跟踪数据库文件系统延迟作为查询延迟的比例,显示只有不到5%的时间花在等待文件系统上。

5. 分析:文件系统和磁盘并不是导致查询变慢的原因。虽然问题仍未解决,但已经排除了一些重要的环境组件。进行此调查的人可以返回第2步,提出新的假设。

Example (Experimental)

1. 问题:为什么从主机A到主机C的HTTP请求比从主机B到主机C花费的时间更长?

2. 假设:主机A和主机B位于不同的数据中心。

3. 预测:将主机A移动到与主机B相同的数据中心将解决问题。

4. 测试:移动主机A并测量性能。

5. 分析:性能已经得到改善,与假设一致。如果问题没有得到解决,在开始新的假设之前,应撤销实验性的改变(在这种情况下将主机A移回原来的位置)。

Example (Experimental)

1. 问题:为什么随着文件系统缓存的增大,文件系统性能会下降?

2. 假设:较大的缓存存储更多的记录,相比较较小的缓存,管理较大的缓存需要更多的计算资源。

3. 预测:使记录大小逐渐变小,因此需要使用更多的记录来存储相同数量的数据,将导致性能逐渐变差。

4. 测试:使用逐渐减小的记录大小进行相同的工作负载测试。

5. 分析:结果被绘制成图表,并与预测一致。现在对缓存管理例程进行详细分析。

这是一个反向测试的示例——故意损害性能以了解目标系统更多信息的方法。

2.5.7 Diagnosis Cycle

类似于科学方法的是诊断循环:

假设 → 仪器检测 → 数据收集 → 假设

像科学方法一样,这种方法也通过收集数据有意地测试假设。该循环强调数据能够迅速引出新的假设,并对其进行测试和改进。这类似于医生通过一系列小型测试来诊断患者,并根据每个测试结果来完善假设。

这两种方法都在理论和数据之间取得了良好的平衡。试图快速从假设转向数据,以便能够及早识别并丢弃错误的理论,并发展出更好的理论。

2.5.8 Tools Method

一个以工具为导向的方法如下:

1. 列出可用的性能工具(可选择安装或购买更多)。

2. 对于每个工具,列出其提供的有用指标。

3. 对于每个指标,列出可能的解读规则。

这样得到的结果是一份规定性的清单,显示了应该运行哪个工具,阅读哪些指标以及如何解读它们。虽然这种方法可能相当有效,但它完全依赖于可用(或已知的)工具,这可能会提供对系统的不完整视图,类似于路灯反方法。更糟糕的是,用户并不知道自己的视图是不完整的,也可能一直不知道。需要自定义工具(例如动态追踪)解决的问题可能永远不会被识别和解决。

在实践中,工具方法确实可以识别出一些资源瓶颈、错误和其他类型的问题,尽管通常不够高效。

当有大量的工具和指标可用时,遍历它们可能需要很长时间。当多个工具具有相同功能时,情况会变得更糟,您需要额外的时间来了解每个工具的优缺点。在某些情况下,例如文件系统微基准测试工具,可能会有十多个可供选择的工具,而您可能只需要其中一个。

2.5.9 The USE Method

利用率、饱和度和错误(USE)方法应该在性能调查的早期使用,以识别系统瓶颈[Gregg 13]。它可以总结如下:

对于每个资源,检查其利用率、饱和度和错误。

这些术语的定义如下:

- 资源:所有物理服务器的功能组件(CPU、总线等)。一些软件资源也可以被检查,前提是指标具有意义。

- 利用率:在一个固定时间间隔内,资源忙于处理工作的时间百分比。在繁忙状态下,资源可能仍然能够接受更多的工作;不能接受更多工作的程度由饱和度确定。

- 饱和度:资源具有无法处理的额外工作量,通常在等待队列中等待。

- 错误:错误事件的数量。

对于一些资源类型,包括主存储器,利用率是已使用资源的容量。这与基于时间的定义不同,并且在第2.3.11节“利用率”中已经解释过。一旦一个容量资源达到100%的利用率,就无法接受更多的工作,资源要么排队等待工作(饱和),要么返回错误,这也是利用USE方法确定的。应该调查错误,因为它们可能会降低性能,并且在故障模式可恢复时可能不会立即被注意到。这包括操作失败并重试以及在冗余设备池中失败的设备。

与工具方法相比,USE方法涉及迭代系统资源而不是工具。这有助于您创建一个完整的问题清单,并且只有在这之后才去寻找工具来回答这些问题。即使找不到工具来回答问题,知道这些问题没有得到解答的信息对性能分析师来说也是非常有用的:现在它们成为了“已知的未知”。

USE方法还将分析引向少数关键指标,以便尽快检查所有系统资源。在此之后,如果没有发现问题,可以使用其他方法论。

Procedure

//流程

USE方法的流程图如图2.12所示。在检查利用率和饱和度之前,首先检查错误。错误通常很快且易于解释,在调查其他指标之前排除错误可能是节省时间的做法。

该方法识别出可能是系统瓶颈的问题。不幸的是,系统可能受到多个性能问题的困扰,因此你找到的第一个问题可能只是一个问题,而不是真正的问题。每个发现都可以使用进一步的方法进行调查,然后根据需要返回到USE方法以迭代更多资源。

Expressing Metrics

//指标表达

USE方法的指标通常表示如下:

- 利用率: 在时间间隔内的百分比(例如,“一个CPU运行在90%的利用率”)

- 饱和度: 作为等待队列长度(例如,“CPU平均运行队列长度为4”)

- 错误: 报告的错误数量(例如,“这个网络接口有50个迟到冲突”)

虽然这似乎不符合直觉,但短时间内的高利用率可能会导致饱和和性能问题,即使长时间内的总体利用率很低。一些监控工具报告5分钟平均值的利用率。例如,CPU利用率可能每秒钟变化很大,因此5分钟的平均值可能掩盖了短时间的100%利用率和饱和。

/*

CPU的饱和度详细解释下:

CPU的饱和度指的是CPU处理器的负载情况。当CPU的负载达到极限时,它就会变得饱和,无法再承载更多的工作负载。这通常会导致系统响应变慢甚至崩溃。

CPU饱和度可以通过检查等待队列的长度来确定。当CPU无法及时处理任务时,任务就会在等待队列中排队等待被处理,这就会导致等待队列的长度增加。长时间的高CPU饱和度可能会导致系统性能下降和延迟增加,因此需要进行监控和管理以确保系统正常运行。

"CPU饱和度可以通过检查等待队列的长度来确定"具体怎么做?

在Linux系统中,可以使用命令行工具top或htop来查看CPU的饱和度和等待队列的长度。

打开终端窗口,输入top或htop命令,按下回车键。这会显示一个实时监控系统的进程列表和性能指标。

在top或htop中,饱和度通常用si、so、%si、%so等指标表示。这些指标显示了内存交换的情况,如果这些值非常高,则表示CPU可能正在经历饱和状态。

等待队列的长度显示在进程列表中,它表示当前在CPU等待处理的进程数。在top或htop中,等待队列通常用D”(Interruptible sleep)状态来表示。如果大量的进程处于等待状态,则表明CPU正在经历饱和状态。

总之,在Linux系统中,可以通过top或htop等工具来检查CPU的饱和度和等待队列的长度,以及其他有关系统性能的指标,以便及时发现并解决问题。

“R”(Running)“表示进程处于运行状态。

*/

考虑高速公路上的一个收费站。利用率可以定义为有多少个收费亭正在为一辆车提供服务。100%的利用率意味着你找不到空的亭子,必须排队等候(饱和)。如果我告诉你,在整个一天中,收费亭的利用率为40%,你能告诉我在那一天的任何时间是否有任何车辆排队等候吗?在交通高峰期,利用率为100%,所以他们可能在那段时间内排队等候,但这在每日平均值中是看不出来的。

//这个举例很好

Resource List

USE方法的第一步是创建资源列表。尽量完整地列出所有资源。下面是一个通用的服务器硬件资源列表,以及具体的例子:

- CPUs(中央处理器):插槽(sockets)、内核(cores)、硬件线程(虚拟CPU)

- 主存储器:DRAM(动态随机存取存储器)

- 网络接口:以太网端口

- 存储设备:磁盘

- 控制器:存储、网络

- 互连设备:CPU、存储器、I/O(输入/输出)

每个组件通常作为单个资源类型。例如,主存储器是容量资源,网络接口是I/O资源(可以是IOPS或吞吐量)。一些组件可以作为多个资源类型的行为:例如,存储设备既是I/O资源,也是容量资源。考虑所有可能导致性能瓶颈的类型。另外要注意,I/O资源可以进一步研究为队列系统,用于排队和处理这些请求。

某些物理组件(例如硬件缓存,如CPU缓存)可以从检查清单中剔除。 USE方法最适合那些在高利用率或饱和下性能降级,导致瓶颈的资源,而缓存在高利用率下提高性能。可以使用其他方法来检查这些资源。如果您不确定是否包含某个资源,请将其包含在内,然后看在实践中指标如何运作。

Functional Block Diagram

//功能块图

另一种迭代资源的方法是找到或绘制系统的功能块图,例如图2.13所示。这样的图表还显示了关系,当寻找数据流中的瓶颈时,这些关系非常有用。

//Disk和CPU之间不是DRAM呀?

CPU、内存和I/O互连和总线通常被忽视。幸运的是,它们通常不是常见的系统瓶颈,因为它们通常被设计为提供足够的吞吐量。不幸的是,如果它们成为瓶颈,问题可能很难解决。也许您可以升级主板或减轻负载;例如,“零拷贝”项目可以减少内存总线负荷。

要调查互连设备,请参阅第6章“CPU”的6.4.1节中的“CPU性能计数器”部分。

Metrics

一旦您列出资源清单,考虑指标类型:利用率、饱和度和错误。表2.5显示了一些示例资源和指标类型,以及可能的指标(通用操作系统)。

CPU saturation dispatcher-queue length (aka run-queue length)

CPU饱和度:调度器队列长度(也称为运行队列长度)

Memory saturation anonymous paging or thread swapping (page scanning is another indicator), or out-of-memory events

内存饱和度:匿名分页或线程交换(页面扫描是另一个指标),或内存不足事件

/*

内存饱和度详细解释下:

匿名分页是一种内存管理技术,用于在物理内存不足时将部分内存页面从内存中转移到磁盘上,以释放空间给其他进程使用。当系统中出现频繁的匿名分页活动时,这可能是内存饱和的一个指示。

线程交换是另一种内存管理技术,在物理内存不足时,将部分线程的数据和状态从内存中交换到磁盘上,以便为其他线程腾出空间。当系统中发生频繁的线程交换时,也可能是内存饱和的一个迹象。

此外,当系统中的内存资源不足时,可能会触发内存不足事件,导致系统性能下降或应用程序崩溃。

*/

这些指标可以是每个间隔的平均值或计数。

针对所有组合重复此过程,并包含获取每个指标的说明。

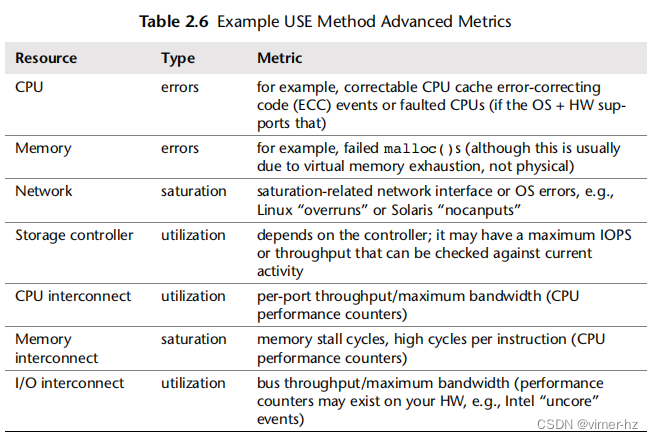

注意当前不可用的指标;这些是已知的未知因素。您最终将得到大约30个指标的列表,其中一些很难测量,有些根本无法测量。幸运的是,通常使用较简单的指标(例如CPU饱和度、内存容量饱和度、网络接口利用率、磁盘利用率)可以发现最常见的问题,因此可以首先检查这些指标。

表2.6提供了一些更困难的组合示例。

CPU interconnect utilization per-port throughput/maximum bandwidth (CPU performance counters)

CPU互连利用率:每端口吞吐量/最大带宽(CPU性能计数器)

Memory interconnect saturation memory stall cycles, high cycles per instruction (CPU performance counters)

内存互连饱和度:内存停滞周期,每条指令的高周期数(CPU性能计数器)

I/O interconnect utilization bus throughput/maximum bandwidth (performance counters may exist on your HW, e.g., Intel “uncore” events)

I/O互连利用率:总线吞吐量/最大带宽(您的硬件上可能存在性能计数器,例如Intel的“uncore”事件)

其中一些可能无法从标准操作系统工具中获取,并可能需要使用动态跟踪或CPU性能计数器功能。

附录A是Linux系统的USE方法清单示例,迭代使用Linux可观察性工具集对硬件资源进行检查。

附录B提供了基于Solaris系统的相同内容。这两个附录还包括一些软件资源。

Software Resources

软件资源

一些软件资源可以进行类似的检查。通常适用于软件的较小组件,而不是整个应用程序,例如:

- 互斥锁:利用率可以定义为持有锁的时间,饱和度则由排队等待锁的线程决定。

- 线程池:利用率可以定义为线程忙于处理工作的时间,饱和度由等待线程池服务的请求数量决定。

- 进程/线程容量:系统可能有限制的进程或线程数量,当前使用情况可以定义为利用率;等待分配则表示饱和度;错误发生在分配失败时(例如,“无法fork”)。

- 文件描述符容量:与进程/线程容量类似,但是针对文件描述符。

如果这些指标在您的情况下有效,请使用它们;否则,可以应用其他方法,如延迟分析。

Suggested Interpretations

//建议的解释

下面是一些关于指标类型的一般建议:

利用率:通常,100%的利用率是瓶颈的一个迹象(检查饱和度及其影响以确认)。超过60%的利用率可能会出现问题,原因有两个:根据间隔的不同,它可能会隐藏短暂的100%利用率。此外,一些资源(如硬盘,但不包括CPU)通常在操作期间无法中断,即使对于优先级较高的工作也是如此。随着利用率的增加,排队延迟会变得更加频繁和明显。有关60%利用率的更多信息,请参阅第2.6.5节《排队论》。

饱和度:任何程度的饱和度都可能是一个问题(非零)。可以将其测量为等待队列的长度,或者作为在队列上等待的时间。

错误:非零的错误计数器值值得调查,特别是如果它们在性能差的情况下不断增加。

解释负面情况很容易:低利用率,无饱和度,无错误。这比听起来更有用——缩小调查的范围可以帮助您迅速专注于问题区域,并确定它可能不是资源问题。这是排除法的过程。

Cloud Computing

//云计算

在云计算环境中,可能会实施软件资源控制,以限制或限制共享一个系统的租户。在Joyent,我们主要使用操作系统虚拟化(SmartOS Zones),它施加了内存限制、CPU限制和存储I/O限制。每个这些资源限制都可以使用类似于检查物理资源的USE方法进行检查。

例如,“内存容量利用率”可以是租户的内存使用量与其内存上限的比较。“内存容量饱和度”可以通过匿名分页活动来观察,即使传统的页面扫描程序可能处于空闲状态。

2.5.10 Workload Characterization

工作负载特征化是一种简单而有效的方法,用于识别一类问题:由于负载过重而引起的问题。它关注系统的输入,而不是结果性能。你的系统可能没有架构或配置问题,但承受的负载超出了其合理处理的范围。

通过回答以下问题可以对工作负载进行特征化:

- 谁造成了负载?进程ID、用户ID、远程IP地址?

- 为什么会发生负载调用?代码路径、堆栈跟踪?

- 负载的特征是什么?IOPS(每秒输入/输出操作数)、吞吐量、方向(读/写)、类型?在适当的情况下包括方差(标准偏差)。

- 负载如何随时间变化?是否存在每日模式?

即使你对这些问题的答案有很强的预期,检查所有这些问题也可能很有用,因为你可能会感到惊讶。

考虑以下情景:你的数据库存在性能问题,其客户端是一组Web服务器。你应该检查谁在使用数据库的IP地址吗?根据配置,你已经预期它们应该是Web服务器。尽管如此,你还是进行了检查,并发现整个互联网似乎都在向数据库投放负载,破坏了它们的性能。事实上,你正在遭受拒绝服务(DoS)攻击!

最佳的性能优化通常是通过消除不必要的工作来实现的。有时,不必要的工作是由应用程序故障引起的,例如,线程陷入循环会创建不必要的CPU负担。它也可能是由于错误的配置,例如在白天运行的系统备份,或者正如之前所述的DoS攻击。特征化工作负载可以识别这些问题,并通过维护或重新配置来消除它们。

如果无法消除已经识别的工作负载,另一种方法可能是使用系统资源控制来限制它。例如,系统备份任务可能通过使用CPU资源压缩备份,然后使用网络资源传输备份来干扰生产数据库。可以使用资源控制(如果系统支持)来限制CPU和网络使用,以便备份仍然进行(速度更慢),而不会损害数据库。

除了识别问题外,工作负载特征化还可以为模拟基准测试的设计提供输入。如果工作负载测量是平均值,理想情况下,你还需要收集分布和变化的详细信息。这对于模拟预期的多样化工作负载非常重要,而不仅仅是测试平均工作负载。有关平均值和变化(标准偏差)的更多信息,请参见第2.8节“统计”和第12章“基准测试”。

工作负载分析还有助于通过识别前者来区分负载问题和架构问题。负载与架构的对比在第2.3节“概念”中介绍过。

执行工作负载特征化的具体工具和指标取决于目标。某些应用程序记录客户端活动的详细日志,这可以是统计分析的源。它们也可能已经提供了关于客户端使用情况的每日或每月报告,可以挖掘其中的细节。

2.5.11 Drill-Down Analysis

钻取分析始于对问题进行高层次的检查,然后根据先前的发现缩小焦点,舍弃那些看似无趣的领域,并深入挖掘那些有趣的领域。这个过程可以涉及深入到软件堆栈的更深层次,如果需要的话,甚至可以涉及硬件,以找到问题的根本原因。

Solaris Performance and Tools [McDougall 06b] 提供了一种用于系统性能的钻取分析方法,包括三个阶段:

1. 监测:用于持续记录随时间变化的高级统计数据,并在可能存在问题时进行识别或警报。

2. 识别:在怀疑存在问题的情况下,将调查范围缩小到特定的资源或感兴趣的领域,识别可能存在的瓶颈。

3. 分析:进一步检查特定的系统领域,试图找出问题的根本原因并量化它。

监控可以在整个公司范围内进行,将所有服务器或云实例的结果进行汇总。传统的方法是使用简单网络管理协议(SNMP),它可用于监控支持该协议的任何网络连接设备。所得到的数据可能会显示出长期模式,而在短时间内使用命令行工具时可能会被忽略。许多监控解决方案在怀疑存在问题时提供警报,促使分析转入下一阶段。

在服务器上,识别是通过交互方式进行的,使用标准的可观测性工具来检查系统组件:CPU、磁盘、内存等。通常是通过使用诸如vmstat(1)、iostat(1)和mpstat(1)等工具的命令行会话来完成的。一些较新的工具允许通过图形用户界面进行实时交互式性能分析(例如,Oracle ZFS存储设备分析)。

分析工具包括基于跟踪或分析的工具,用于对可疑区域进行更深入的检查。这种更深入的分析可能涉及创建自定义工具,并检查源代码(如果有的话)。这就是大部分钻取的地方,根据需要剥离软件堆栈的各层,以找到根本原因。执行此操作的工具包括strace(1)、truss(1)、perf和DTrace。

Five Whys

在分析阶段,您还可以使用五个为什么的技术:问自己“为什么?”然后回答这个问题,总共重复五次(或更多)。以下是一个示例过程:

1. 数据库对许多查询开始表现不佳。为什么?

2. 这是由于内存分页导致的磁盘I/O延迟。为什么?

3. 数据库内存使用量增长过大。为什么?

4. 分配器消耗的内存超过了应有的数量。为什么?

5. 分配器存在内存碎片问题。

这是一个真实世界的例子,非常出乎意料地导致了系统内存分配库的修复。正是通过持续的质疑和深入挖掘到核心问题,才导致了修复的发现。

2.5.12 Latency Analysis

延迟分析检查完成操作所需的时间,然后将其分解为更小的组件,继续细分具有最高延迟的组件,以便确定和量化根本原因。类似于深入分析,延迟分析可能会通过软件堆栈的各层进行深入挖掘,以找到延迟问题的根源。

分析可以从应用的工作负载开始,检查该工作负载在应用程序中的处理方式,然后深入到操作系统库、系统调用、内核和设备驱动程序中。

例如,对MySQL查询延迟的分析可能涉及回答以下问题(这里给出了示例答案):

1. 是否存在查询延迟问题?(是)

2. 查询时间主要是花费在CPU上还是等待CPU之外?(等待CPU之外)

3. 等待CPU之外的时间是用来等待什么的?(文件系统I/O)

4. 文件系统I/O时间是由于磁盘I/O还是锁争用?(磁盘I/O)

5. 磁盘I/O时间很可能是由于随机寻道还是数据传输时间?(传输时间)

对于这个例子,每个步骤都提出了一个问题,将延迟分成两部分,然后继续分析较大的部分:如果你愿意,可以将其视为延迟的二进制搜索。该过程如图2.14所示。

当A或B中较慢的部分被确定后,它会进一步分成A或B,并进行分析等操作。

方法R的目标是对数据库查询进行延迟分析。

2.5.13 Method R

Method R是针对Oracle数据库开发的一种性能分析方法,重点是基于Oracle跟踪事件找到延迟的来源[Millsap 03]。它被描述为“一种基于响应时间的性能改进方法,为您的业务带来最大的经济价值”,并且专注于识别和量化查询过程中的时间消耗。尽管该方法用于数据库的研究,但其方法也可以应用于任何系统,并且值得在这里提及作为一个可能的研究途径。

2.5.14 Event Tracing

系统通过处理离散事件来运行。这些事件包括CPU指令、磁盘I/O和其他磁盘命令、网络数据包、系统调用、库调用、应用程序事务、数据库查询等等。性能分析通常研究这些事件的摘要,例如每秒操作次数、每秒字节数或平均延迟。有时,在摘要中会丢失重要的细节,最好在逐个事件进行检查时对其进行理解。

网络故障排除通常需要逐个数据包的检查,使用诸如tcpdump(1)之类的工具。这个例子将数据包总结为单行文本:

根据需要,tcpdump(1)可以打印不同数量的信息(请参阅第10章“网络”)。

可以使用iosnoop(1M)(基于DTrace)来跟踪块设备层的存储设备I/O(请参阅第9章“磁盘”):

这里打印了多个时间戳,包括开始时间(STIME)、结束时间(TIME)、请求和完成之间的时间差(DELTA)以及估算的服务此I/O所需的时间(DTIME)。

系统调用层也是常见的跟踪位置,工具包括Linux上的strace(1)和基于Solaris的系统上的truss(1)(请参阅第5章“应用程序”)。这些工具也有选项来打印时间戳。

在执行事件跟踪时,寻找以下信息:

输入:事件请求的所有属性:类型、方向、大小等。

时间:开始时间、结束时间、延迟(差异)。

结果:错误状态、事件结果(大小)。

有时,通过检查事件的请求或结果的属性,可以理解性能问题。使用事件跟踪工具,可以通过事件时间戳特别有助于分析延迟,并且通常可以包含在内。

前面的tcpdump(1)输出包括Delta时间戳,测量数据包之间的时间,使用-ttt。

对先前事件的研究提供了更多信息。特别糟糕的延迟事件,称为延迟异常值,可能是由以前的事件而不是事件本身引起的。例如,队列尾部的事件可能具有高延迟,但是是由前面的队列事件引起的,而不是其自身属性引起的。可以从跟踪事件中识别此类情况。

2.5.15 Baseline Statistics

将当前的性能指标与过去的数值进行比较通常是很有启发性的。

可以识别负载或资源使用的变化,并追溯问题的首次出现。一些可观测性工具(基于内核计数器的工具)可以显示自引导以来的摘要,以便与当前活动进行比较。这虽然粗糙,但总比没有好。另一种方法是收集基准统计数据。

这可能涉及执行各种系统可观测性工具,并记录输出以供将来参考。与自引导以来的摘要不同,它可以包括每秒的统计数据,以便看到变化。

在系统或应用程序更改之前和之后可能会收集基线统计数据,以便分析性能变化。它也可以不定期地收集,并包含在站点文档中,以便管理员可以了解“正常”情况。每天定期执行此任务是性能监控的一项活动(参见第2.9节“监控”)。

2.5.16 Static Performance Tuning

静态性能调整关注的是配置体系结构方面的问题。其他方法则关注应用负载的性能:动态性能[Elling 00]。当系统处于静止状态且没有负载时,可以进行静态性能分析。

对于静态性能分析和调整,请逐个检查系统的所有组件并检查以下内容:

- 组件是否合理?

- 配置是否符合预期的工作负载?

- 是否自动配置了最适合预期工作负载的组件?

- 组件是否遇到错误并处于降级状态?

以下是使用静态性能调整可能找到的一些问题示例:

- 网络接口协商:选择100 Mbits/s而不是1 Gbit/s

- RAID池中的损坏磁盘

- 使用旧版本操作系统、应用程序或固件

- 文件系统记录大小与工作负载I/O大小不匹配

- 服务器意外配置为路由器

- 配置服务器以从远程数据中心而不是本地使用资源(如身份验证)

幸运的是,这些类型的问题很容易检查。难点在于记得去做!

2.5.17 Cache Tuning

应用程序和操作系统可能会使用多个缓存来提高I/O性能,从应用程序到磁盘。有关完整列表,请参见第3章“操作系统”中的第3.2.11节“缓存”。以下是针对每个缓存级别的一般性调整策略:

1. 旨在尽可能高地在堆栈中缓存,靠近执行工作的位置,减少缓存命中的操作开销。

2. 检查缓存是否已启用并正常工作。

3. 检查缓存命中/未命中比率和未命中率。

4. 如果缓存大小是动态的,请检查其当前大小。

5. 针对工作负载调整缓存。此任务取决于可用的缓存可调参数。

6. 针对缓存调整工作负载。这包括减少不必要的缓存消费者,为目标工作负载释放更多空间。

注意双重缓存,例如消耗主内存并将相同数据缓存两次的两个不同缓存。

还应考虑每个缓存调整级别的整体性能增益。调整CPU一级缓存可能会节省纳秒时间,因为缓存未命中可以由二级缓存服务。但是改进CPU三级缓存可能避免更慢的DRAM访问,并导致更大的整体性能增益。(这些CPU缓存在第6章“CPU”中描述。)

2.5.18 Micro-Benchmarking

微基准测试评估简单和人为工作负载的性能。它可以用于支持科学方法,验证假设和预测,也可以是容量规划的一部分。

这与通常旨在测试真实世界和自然工作负载的行业基准测试不同。此类基准测试通过运行工作负载模拟来进行,可能变得复杂以进行和理解。

微基准测试较为简单,因为涉及的因素较少。可以通过应用工作负载并测量性能的微基准工具来执行,或者可以使用仅应用工作负载而将性能测量留给标准系统工具的负载生成器工具。两种方法都可以,但最安全的方法可能是使用微基准工具,并使用标准系统工具再次检查性能。

微基准测试的一些示例目标,包括测试的第二个维度,是:

- 系统调用时间:对于fork()、exec()、open()、read()、close()

- 文件系统读取:从缓存文件中读取,将读取大小从1字节变化到1兆字节

- 网络吞吐量:在TCP端点之间传输数据,对于不同的套接字缓冲区大小

微基准测试通常尽可能快地执行目标操作,并测量完成大量操作所需的时间。然后可以计算平均时间(平均时间 = 运行时间/操作计数)。后面的章节中将介绍具体的微基准测试方法,列出要测试的目标和属性。有关基准测试的主题将在第12章“基准测试”中详细讨论。

2.6 Modeling

对系统进行分析建模可以用于多种目的,特别是可扩展性分析:研究随着负载或资源的扩展而性能如何扩展。资源可以是硬件,例如CPU核心,也可以是软件,例如进程或线程。

分析建模可以被视为第三种性能评估活动,与生产系统的可观察性("测量")和实验性测试("模拟")一同存在[Jain 91]。只有在至少进行两个这些活动时,性能才能得到最好的理解:分析建模和模拟,或者模拟和测量。

如果分析是针对现有系统的,可以从测量开始:描述负载和相应的性能。如果系统尚未具备生产负载,或者要测试超出生产中所见负载的工作负载,可以使用试验性分析,通过测试工作负载模拟来进行。分析建模可用于预测性能,并且可以基于测量或模拟的结果。

可扩展性分析可能会揭示性能在某个点(称为拐点)停止线性扩展,这是由于资源限制所致。找出是否存在这些点,以及它们位于何处,可以引导对抑制可扩展性的性能问题进行调查,以便在生产中遇到之前修复它们。

有关这些步骤的更多信息,请参阅第2.5.10节"工作负载描述"和第2.5.18节"微基准测试"。

2.6.1 Enterprise versus Cloud

虽然建模使我们能够模拟大规模企业系统,而无需拥有实际系统,但大规模环境的性能往往复杂且难以准确建模。

通过云计算,可以租用任何规模的环境进行短期使用——例如基准测试的时长。与创建数学模型以预测性能不同,工作负载可以被描述、模拟,然后在不同规模的云端进行测试。一些发现,如拐点,可能是相同的,但现在是基于实测数据而不是理论模型,并通过测试真实环境,您可能会发现未包含在您的模型中的限制因素。

2.6.2 Visual Identification

当实验收集到足够的结果时,将它们作为交付性能与缩放参数的关系绘制出来,可能会揭示出一种模式。

图2.15显示了应用程序的吞吐量随线程数量的缩放而变化。在大约八个线程处出现了一个拐点,斜率发生了变化。现在可以对此进行进一步研究,例如查看应用程序和系统配置是否存在接近八的设置值。

在这种情况下,系统是一个具有八个核心的系统,每个核心具有两个硬件线程。为了进一步确认这与CPU核心数有关,可以调查并比较少于八个和多于八个线程时的CPU影响(例如,CPI;参见第6章,CPU)。或者,可以通过在具有不同核心数的系统上重复进行缩放测试,并确认拐点按预期移动来进行实验性的研究。

有许多可视化识别的可扩展性配置文件,而无需使用正式模型。这些显示在图2.16中。

Contention/Coherence/Knee Point/Ceiling

竞争/一致性/拐点/上限

对于每个情况,x轴是可扩展性维度,y轴是结果性能(吞吐量、每秒事务数等)。以下是这些模式:

线性可扩展性:随着资源的扩展,性能成比例增加。这种趋势可能不会一直持续下去,而是可能是另一种可扩展性模式的早期阶段。

竞争:体系结构的某些组件是共享的,并且只能串行使用,对于这些共享资源的竞争开始降低扩展性的效果。

一致性:为了保持数据的一致性,包括传播变化的开销开始超过扩展的好处。

拐点:在某个可扩展性点遇到一个因素,改变了可扩展性配置文件。

可扩展性上限:达到了一个硬性限制。这可能是设备瓶颈,例如总线或互连达到最大吞吐量,或者是软件施加的限制(系统资源控制)。

虽然通过可视化识别可以简单有效,但使用数学模型可以更详细地了解系统的可扩展性。模型可能以意想不到的方式偏离数据,这对于调查很有用:要么模型存在问题,因此您对系统的理解存在问题,要么问题在于系统的实际可扩展性。接下来的章节介绍了Amdahl's Law of Scalability(阿姆达尔定律)、Universal Scalability Law(通用可扩展性定律)和排队理论。

2.6.3 Amdahl’s Law of Scalability

//阿姆达尔可扩展性定律

这条定律以计算机架构师Gene Amdahl [Amdahl 67]的名字命名,它模拟系统的可扩展性,考虑到不以并行方式扩展的串行工作负载组件。它可以用于研究CPU、线程、工作负载等的扩展性。Amdahl's Law of Scalability在之前的可扩展性配置文件中被描述为竞争,描述了对串行资源或工作负载组件的竞争。它可以定义为[Gunther 97]:

C(N) = N/1 + α(N - 1)

其中,相对容量为C(N),N是扩展维度,例如CPU数量或用户负载。参数α(其中0 <= α <= 1)表示串行度的程度,即与线性可扩展性的偏差程度。

可以通过以下步骤应用Amdahl's Law of Scalability:

1. 收集一系列N的数据,可以通过观察现有系统或使用微基准测试或负载生成器进行实验来收集数据。

2. 进行回归分析以确定Amdahl参数(D);可以使用统计软件如gnuplot或R来完成此步骤。

3. 提供结果以进行分析。可以将收集的数据点与模型函数绘制在一起,以预测扩展性并揭示数据与模型之间的差异。这也可以使用gnuplot或R来完成。以下是Amdahl's Law of Scalability回归分析的示例gnuplot代码,以提供执行此步骤的思路:

在R中处理这个类似的代码需要相同的量级,涉及到使用nls()函数进行非线性最小二乘拟合以计算系数,然后在绘图过程中使用这些系数。在本章末尾的参考资料中,可以找到完整的gnuplot和R代码的性能可扩展性模型工具包[2]。下一节将展示一个Amdahl's Law of Scalability函数的示例。

2.6.4 Universal Scalability Law

//通用可扩展性定律

通用可扩展性定律(USL),之前称为超级串行模型[Gunther 97],是由Neil Gunther博士开发的,包括一种相干延迟参数。这在先前被描绘为相干可扩展性配置文件,包括竞争效应。

USL可以定义为

C(N) = N/1 + α(N - 1) + EN(N - 1)

其中,C(N), N和α与Amdahl's Law of Scalability相同。E是相干参数。当E == 0时,这变成了Amdahl's Law of Scalability。

图2.17展示了USL和Amdahl's Law of Scalability分析的示例。输入数据集具有高度的方差,使得难以直观地确定可扩展性配置文件。前十个数据点以圆圈的形式呈现,并提供给模型。还绘制了另外十个数据点,以叉的形式呈现,用于检查模型预测与实际情况之间的差异。

有关USL分析的更多信息,请参见[Gunther 97]和[Gunther 07]。

2.6.5 Queueing Theory

排队论是对具有队列的系统进行数学研究的学科,提供了分析队列长度、等待时间(延迟)和利用率(基于时间)的方法。计算机中的许多组件,包括软件和硬件,都可以建模为排队系统。对多个排队系统进行建模称为排队网络。

本节总结了排队论的作用,并提供了一个示例,以帮助您理解其作用。排队论是一个广泛的研究领域,在其他文献中有详细介绍([Jain 91],[Gunther 97]),如果有需要的话,可以深入学习。

排队论建立在数学和统计学的各个领域基础上,包括概率分布、随机过程、Erlang的C公式(Agner Krarup Erlang发明了排队论)和Little's Law。Little's Law可以表示为

L = λW

其中,L确定系统中的平均请求数,λ是平均到达率,W是平均服务时间,它们相乘得到。

排队系统可以用来回答各种问题,包括以下几个:

- 如果负载加倍,平均响应时间将是多少?

- 添加一个额外的处理器后,平均响应时间会有什么影响?

- 在负载加倍的情况下,系统能否提供小于100毫秒的90th百分位响应时间?

除了响应时间,还可以研究其他因素,包括利用率、队列长度和常驻作业数量。

图2.18显示了一个简单的排队系统模型。

这个系统有一个单一的服务中心,负责处理队列中的作业。排队系统也可以拥有多个并行处理工作的服务中心。在排队论中,这些服务中心通常被称为服务器。

排队系统可以根据三个因素进行分类:

- 到达过程:描述请求到达队列系统的间隔时间,可能是随机的、固定的或者遵循泊松过程(使用指数分布表示到达时间)等。

- 服务时间分布:描述服务中心的服务时间。它们可能是固定的(确定性的)、指数分布的,或者其他类型的分布。

- 服务中心的数量:一个或多个。

这些因素可以用Kendall符号表示。

Kendall’s Notation

这个符号为每个属性分配了代码。它的形式是 A/S/m。这些属性分别表示到达过程 (A)、服务时间分布 (S) 和服务中心的数量 (m)。还有一种扩展形式的Kendall符号,包括更多的因素:系统中的缓冲区数量、总人数和服务纪律。

常见的研究排队系统的例子有:

- M/M/1:马尔可夫到达(指数分布的到达时间)、马尔可夫服务时间(指数分布)、一个服务中心。

- M/M/c:与M/M/1相同,但是有多个服务器。

- M/G/1:马尔可夫到达,服务时间的分布是一般的(可以是任意分布),一个服务中心。

- M/D/1:马尔可夫到达,服务时间是确定性的(固定时间),一个服务中心。

M/G/1常用于研究旋转硬盘的性能。

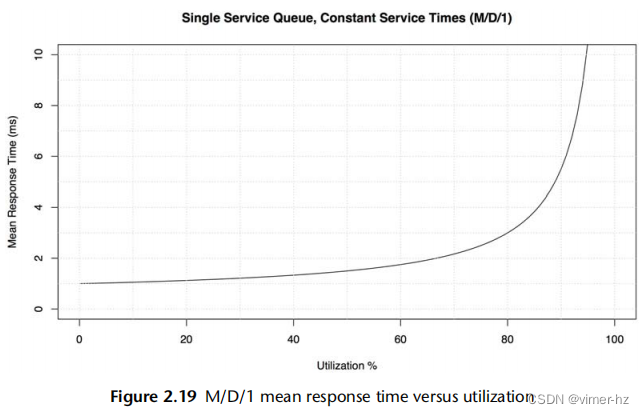

M/D/1 and 60% Utilization

作为排队论的一个简单例子,考虑一个以确定性方式响应工作负载的硬盘(这是一个简化)。该模型是M/D/1。

提出的问题是:随着利用率的增加,硬盘的响应时间如何变化?

排队论可以计算M/D/1的响应时间:

r = s(2 - U)/2(1 - U)

其中,响应时间 r 是以服务时间 s 和利用率 U 来定义的。

对于服务时间为1毫秒和利用率从0到100%的情况,这个关系已经在图2.19中绘制出来。

超过60%的利用率后,平均响应时间翻倍。当达到80%时,它会增加三倍。由于磁盘I/O延迟通常是应用程序的限制资源,将平均延迟增加一倍或更多可能会对应用程序性能产生显著的负面影响。这就是为什么磁盘利用率在达到100%之前就可能成为一个问题的原因,因为它是一个排队系统,请求(通常)无法中断,必须等待它们的顺序。这与例如CPU不同,CPU可以进行高优先级的抢占。

这个图形可以直观地回答之前的一个问题:当负载加倍时,平均响应时间将是多少?—这是相对于负载的利用率。

这个模型是简单的,从某种程度上展示了最好的情况。服务时间的变化可能会使平均响应时间增加(例如使用M/G/1或M/M/1)。还有一个响应时间的分布,图2.19中没有显示出来,当利用率超过60%时,第90百分位数和第99百分位数的退化速度要快得多。

与之前关于Amdahl的可扩展性定律的gnuplot示例一样,展示一些实际代码可能有助于了解可能涉及的内容。这次使用了R统计软件[3]:

之前的M/D/1方程已经传递给plot()函数。该代码的大部分部分用于指定图形的限制、线条属性和坐标轴标签。

2.7 Capacity Planning

容量规划(Capacity Planning)考察系统在处理负载时的能力以及随着负载增加而扩展的能力。可以通过多种方式进行容量规划,包括研究资源限制和因素分析(在此介绍),以及建模(如前所述)。本节还包括了扩展的解决方案,包括负载均衡器和分片。有关更多信息,请参阅《容量规划的艺术》[Allspaw 08]。

对于特定应用程序的容量规划,有一个明确的性能目标会有所帮助。在第5章的早期部分讨论了如何确定这个目标。

2.7.1 Resource Limits

这种方法是寻找在负载下将成为瓶颈的资源。其中的步骤如下:

1.测量服务器请求速率,并随时间监控此速率。

2.测量硬件和软件资源使用情况,并随时间监控此速率。

3.以所使用的资源为基础来表达服务器请求。

4.将服务器请求外推到每个资源的已知(或经过实验确定的)限制。

首先要确定服务器的角色和它所服务的请求类型。例如,Web服务器提供HTTP请求服务,网络文件系统(NFS)服务器提供NFS协议请求(操作)服务,数据库服务器提供查询请求服务(或者是命令请求,而查询是其中的一个子集)。

下一步是确定每个请求对系统资源的消耗量。对于现有系统,可以测量当前请求速率以及资源利用情况。然后可以使用外推法来确定哪个资源将首先达到100%利用率以及请求速率是多少。

对于未来的系统,可以使用微基准测试或负载生成工具在测试环境中模拟预期的请求,同时测量资源利用情况。在足够的客户端负载下,您可以通过实验找到极限。

需要监控的资源包括:

硬件:CPU利用率、内存使用情况、磁盘IOPS、磁盘吞吐量、磁盘容量(已使用的卷)、网络吞吐量

软件:虚拟内存使用情况、进程/任务/线程、文件描述符

假设您正在查看一个目前每秒执行1,000个请求的现有系统。最繁忙的资源是16个CPU,平均利用率为40%;您预测一旦它们达到100%利用率,它们将成为这个工作负载的瓶颈。问题是:此时请求每秒的速率是多少?

每个请求的CPU% = 总CPU%/请求数 = 16 x 40%/1,000 = 0.64% CPU per request

最大请求速率 = 100% x 16 CPUs/CPU% per request = 1,600 / 0.64 = 2,500 requests/s

预测结果是每秒2,500个请求,此时CPU将达到100%利用率。这是容量的一个粗略的最佳估计,因为在请求达到该速率之前可能会遇到其他限制因素。

此次演习仅使用了一个数据点:1,000个应用程序吞吐量(每秒请求数)与40%的设备利用率。如果启用随时间的监控,可以包括不同吞吐量和利用率的多个数据点,以提高估计的准确性。图2.20展示了一种用于处理这些数据并推断最大应用程序吞吐量的可视化方法。

2,500个请求/秒足够吗?回答这个问题需要了解峰值工作负载,它显示在每日访问模式中。对于您经过一段时间监控的现有系统,您可能已经知道峰值会是什么样子。

考虑一个处理每天10万个网站点击的Web服务器。这听起来很多,但平均每秒只有约1个请求,不算多。然而,可能大多数的10万个网站点击发生在发布新内容后的几秒钟内,所以峰值是显著的。

2.7.2 Factor Analysis

在购买和部署新系统时,通常有许多因素可以改变以实现所需的性能。这些因素可能包括磁盘和CPU的数量、内存的大小、闪存设备的使用、RAID配置、文件系统设置等等。任务通常是以最低成本实现所需的性能。

测试所有组合将确定哪种组合具有最佳的性价比;然而,这很容易失控:八个二进制因素将需要进行256次测试。

一种解决方法是测试一组有限的组合。以下是一种基于已知最大系统配置的方法:

1. 将所有因素配置为最大值进行性能测试。

2. 逐个更改因素,测试性能(每次测试应该会降低)。

3. 根据测量结果,将性能下降的百分比归因于每个因素,以及与成本节省相关的情况。

4. 从最大性能(和成本)开始,选择要节省成本的因素,同时基于它们的综合性能下降来保持所需的每秒请求数。

5. 对计算得到的配置进行重新测试,以确认所提供的性能。

对于一个八因素系统,这种方法可能只需要进行十次测试。

以一个新存储系统的容量规划为例,要求读取吞吐量为1 Gbyte/s,工作集大小为200 Gbyte。最大配置可实现2 Gbytes/s,并包括四个处理器、256 Gbytes的DRAM、2个双端口10 GbE网络卡、巨型帧,并禁用压缩和加密(启用这些功能会增加成本)。切换到两个处理器将使性能下降30%,一个网络卡下降25%,非巨型帧下降35%,加密下降10%,压缩下降40%,DRAM减少90%,因为工作负载不再被预期完全缓存。根据这些性能下降和已知的节省情况,现在可以计算出满足要求的最佳性价比系统;可能是一个具有两个处理器和一个网络卡的系统,达到所需的吞吐量:2 × (1 - 0.30) × (1 - 0.25) = 1.04 Gbytes/s 的估计值。然后明智的做法是测试这个配置,以防这些组件在一起使用时的实际性能与预期性能不同。

2.7.3 Scaling Solutions

满足更高的性能需求通常意味着使用更大的系统,这种策略被称为纵向扩展。将负载分布在多个系统上,通常通过称为负载均衡器的系统来实现,使它们看起来像一个系统,这被称为横向扩展。

云计算进一步发展了横向扩展,通过基于较小的虚拟化系统而不是整个系统来构建。这在购买用于处理所需负载的计算资源时提供了更细粒度的控制,并允许以小而高效的增量进行扩展。由于不需要像企业主机那样进行初始的大规模采购(包括支持合同承诺),因此在项目的早期阶段不需要进行严格的容量规划。

云上数据库的常见扩展策略是分片,即将数据分割为逻辑组件,每个组件由自己的数据库(或冗余数据库组)管理。例如,可以按照客户名称的字母范围将客户数据库分割为多个部分。

可扩展性设计非常依赖于您需要处理的工作负载和希望使用的应用程序。有关更多信息,请参阅《可扩展的互联网架构》[Schlossnagle 06]。

2.8 Statistics

了解如何使用统计数据以及它们的局限性非常重要。本节将讨论使用统计数据(指标)和统计类型来量化性能问题,包括平均值、标准差和百分位数。

2.8.1 Quantifying Performance

量化问题及其潜在的性能改进,可以对它们进行比较和优先排序。这项任务可以使用观察或实验来完成。

基于观察的方法

使用观察来量化性能问题的步骤如下:

1. 选择一个可靠的指标。

2. 估计解决该问题后的性能提升。

例如:

观察到:应用程序请求需要10毫秒。

观察到:其中9毫秒用于磁盘I/O操作。

建议:配置应用程序将I/O缓存在内存中,预计DRAM延迟约为10微秒。

预计的改进:10毫秒÷1.01毫秒(10毫秒-9毫秒+10微秒)≈ 9倍的改进。

正如在第2.3节“概念”中介绍的那样,延迟(时间)非常适合这个场景,因为可以直接在组件之间进行比较,从而使得这种计算成为可能。

在使用延迟时,请确保将其作为应用程序请求的同步组件进行测量。某些事件是异步发生的,例如后台磁盘I/O(写入刷新到磁盘),并不直接影响应用程序性能。

基于实验的方法

使用实验来量化性能问题的步骤如下:

1. 应用修复措施。

2. 使用可靠的指标量化修复前后的性能差异。

例如:

观察到:应用程序事务延迟平均为10毫秒。

实验:增加应用程序线程数以允许更多并发而不是排队。

观察到:应用程序事务延迟平均为2毫秒。

改进:10毫秒÷2毫秒 = 5倍的提升。

如果修复在生产环境中尝试成本过高,则此方法可能不适用!

2.8.2 Averages

平均值代表一个数据集的单个值:中心趋势指标。最常用的平均值类型是算术平均值(或简称平均值),它是值的总和除以值的数量。其他类型包括几何平均数和调和平均数。

几何平均数

几何平均数是乘积值的第n个根(其中n是值的数量)。这在[Jain 91]中有描述,其中包括一个使用它进行网络性能分析的示例:如果分别测量内核网络堆栈的每个层的性能改进,那么平均性能改进是多少?由于这些层在同一个数据包上一起工作,性能改进具有“乘法”效应,最好通过几何平均数来总结。

调和平均数

调和平均数是值的数量除以它们的倒数之和。它在计算速率的平均值时可能更合适,例如,在计算800 M字节数据的平均传输速率时,前100 M字节将以50 M字节/秒的速率发送,而剩下的700 M字节将以限速速率10 M字节/秒发送。使用调和平均数,答案是800/(100/50 + 700/10) = 11.1 M字节/秒。

随时间变化的平均值

在性能方面,我们研究的许多指标都是随时间变化的平均值。CPU从来不会处于“50%的利用率”状态;它在某个时间间隔内被利用了50%,这个时间间隔可以是一秒、一分钟或一小时。在考虑平均值时,检查时间间隔非常重要。

例如,我曾遇到一个问题,客户在CPU饱和(调度延迟)引起的性能问题,尽管他们的监控工具显示CPU利用率从未超过80%。监控工具报告的是5分钟的平均值,这掩盖了CPU利用率在某些时刻达到100%的情况。

衰减平均值

在系统性能中,有时会使用衰减平均值。例如,uptime(1)报告的系统“负载平均值”和基于Solaris的系统上的每个进程的CPU利用率。

衰减平均值仍然是在一个时间区间内测量的,但是最近的时间比过去的时间更加重要。这减少(抑制)了平均值中的短期波动。

详细了解这方面内容,请参阅第6章“CPU”中第6.6节“负载平均值”。

2.8.3 Standard Deviations, Percentiles, Median

标准差和百分位数(例如,第99百分位数)是提供有关数据分布的统计技术。标准差是方差的一种度量,较大的值表示与平均值(均值)的差异较大。第99百分位数显示了包括99%的值的分布点。图2.21展示了正态分布中的这些值,以及最小值和最大值。

百分位数,例如第99、90、95和99.9百分位数,用于性能监测请求延迟,以量化人群中最慢的部分。这些百分位数也可以在服务级别协议(SLA)中指定,作为衡量大多数用户接受性能的一种方式。

第50百分位数,称为中位数,可以用来显示数据的大部分所在位置。

2.8.4 Coefficient of Variation

由于标准差与均值相关,只有在考虑到标准差和均值时,方差才能被理解。单独一个标准差为50的信息并不多。但是,如果再加上均值为200,那就能得到很多信息。

有一种方法可以将变异性表示为一个单一的度量:标准差与均值的比率,称为变异系数(CV)。对于这个例子,变异系数为25%。较低的变异系数意味着较小的方差。

2.8.5 Multimodal Distributions

对于平均值、标准差和百分位数存在一个问题,这可能从前面的图表中就能明显看出:它们适用于正态分布或单峰分布。系统性能通常是双峰分布的,对于快速代码路径返回低延迟,对于慢速代码路径返回高延迟,或者对于缓存命中返回低延迟,对于缓存未命中返回高延迟。也可能存在多个模式。

图2.22展示了读写混合工作负载下磁盘I/O延迟的分布情况,其中包括随机和顺序I/O。

这是一个以直方图形式呈现的数据,显示了两个模式。左边的模式显示了小于1毫秒的延迟,表示磁盘缓存命中。右边的模式,峰值约在7毫秒左右,表示磁盘缓存未命中:随机读取。平均(均值)I/O延迟为3.3毫秒,用一条垂直线表示。这个平均值不是中心趋势指标(如前面所述);实际上,它几乎是相反的。作为一个度量指标,对于这个分布来说,平均值严重误导。

然后有一个人淹死在一个平均水深为六英寸的小溪里。

W. I. E. Gates

每当你看到平均值作为性能指标,尤其是平均延迟时,请问一下:这个分布是怎样的?第2.10节,可视化,提供了另一个例子,展示了不同的可视化和度量指标如何有效地显示这个分布情况。

2.8.6 Outliers

另一个统计问题是离群值的存在:极少量的极高或极低的值,不符合预期的分布(单峰或多峰)。

磁盘I/O延迟离群值就是一个例子——偶尔出现的磁盘I/O可能需要超过1,000毫秒,而大多数磁盘I/O在0到10毫秒之间。像这样的延迟离群值会导致严重的性能问题,但它们的存在很难从大多数度量类型中识别出来,除了最大值之外。

对于正态分布,离群值的存在可能会使均值略微移动,但不会影响中位数(这可能有用)。标准差和99百分位数更有可能识别出离群值,但仍取决于它们的频率。

为了更好地理解多峰分布、离群值和其他复杂的常见行为,可以检查完整的分布,比如使用直方图。有关如何进行此操作的更多方法,请参见第2.10节,可视化。

2.9 Monitoring

系统性能监控会记录随时间变化的性能统计信息(时间序列),以便将过去与现在进行比较,并识别基于时间的使用模式。这对于容量规划、量化增长以及显示峰值使用情况很有用。历史值也可以提供上下文来理解性能指标的当前值,通过显示过去的“正常”范围和平均值。

2.9.1 Time-Based Patterns

图2.23、2.24和2.25展示了基于时间的模式示例,这些图表显示了云计算服务器在不同时间间隔内的文件系统读取情况。这些图形显示了每天的模式,从早上8点左右开始增加,下午稍微下降,然后在夜间逐渐减少。较长时间尺度的图表显示,在周末活动较少。在30天的图表中也可以看到几个短暂的尖峰。

在历史数据中,可以常见地看到各种行为周期,包括图表中显示的周期,例如:

按小时:应用环境可能每小时执行一次活动,如监控和报告任务。这些活动通常以5分钟或10分钟的周期执行。

按天:可能存在与工作时间(上午9点至下午5点)相一致的每日使用模式,如果服务器面向多个时区,则该模式可能会延伸。对于互联网服务器,模式可能会根据全球用户的活动时间而变化。其他每日活动可能包括夜间日志轮换和备份。

按周:除了每日模式外,还可能存在基于工作日和周末的每周模式。

按季度:财务报告按季度进行。其他活动可能会导致负载不规则增加,例如发布网站上的新内容。

2.9.2 Monitoring Products

有许多用于系统性能监控的第三方产品。典型的功能包括将数据存档并以基于浏览器的交互式图形方式呈现,并提供可配置的警报。

其中一些产品通过在系统上运行代理来收集统计信息。这些代理要么执行操作系统的可观察性工具(如sar(1)),然后处理输出(这被认为效率低下,甚至可能导致性能问题!),要么直接链接到操作系统库和接口以直接读取统计信息。

还有一些使用SNMP的监控解决方案。如果系统支持SNMP,则通常无需在系统上运行自定义代理。

随着系统变得更加分布式,并且使用云计算的增长,您可能需要监控大量的系统,甚至可能是数百个或数千个。这就是集中式监控产品尤其有用的地方,它可以允许从一个界面监控整个环境。

一些公司更倾向于开发自己的监控解决方案,以更好地适应其定制环境和需求。

2.9.3 Summary-since-Boot

如果没有进行监控,请检查操作系统是否至少提供了自启动以来的摘要值,这些值可用于与当前值进行比较。

2.10 Visualizations

可视化允许我们查看更多的数据,而不仅仅是在文本显示中能够看到的内容。它们还可以实现模式识别和模式匹配。这是一种有效的方法,可以帮助我们发现不同指标来源之间的相关性,这可能在编程上很难实现,但在视觉上很容易做到。

2.10.1 Line Chart

折线图(也称为线图)是一种众所周知的基本可视化工具。它通常用于随时间变化检查性能指标,将时间显示在x轴上。

图2.26是一个示例,显示了一个20秒周期内的平均磁盘I/O延迟。这是在运行MySQL数据库的生产云服务器上测量的,怀疑磁盘I/O延迟导致查询速度缓慢。

这个折线图显示了大约4毫秒左右的相对一致的平均读取延迟,这高于这些磁盘的预期值。

可以绘制多条线,将相关数据显示在同一组坐标轴上。对于这个示例,可以为每个磁盘绘制单独的线条,以显示它们是否具有类似的性能。

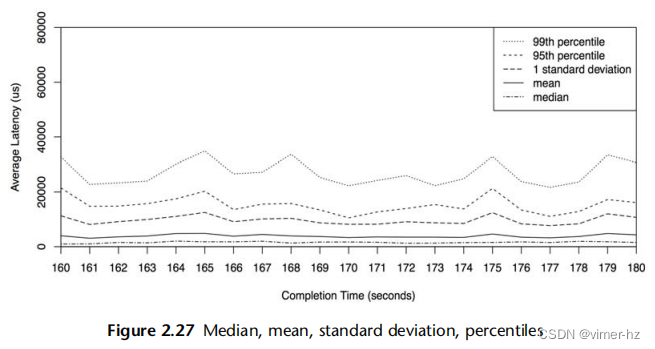

还可以绘制统计值,提供有关数据分布的更多信息。图2.27显示了相同范围的磁盘I/O事件,添加了每秒钟的中位数、标准差和百分位数的线条。请注意,与之前的折线图相比,y轴现在具有更大的范围(扩大了8倍)。

这显示了为什么平均值高于预期:分布中包含了高延迟的I/O操作。具体而言,1%的I/O操作超过20毫秒,由第99百分位数显示。中位数也显示了预期的I/O延迟位置,大约为1毫秒。

2.10.2 Scatter Plots

图2.28以散点图的形式显示了与之前相同时间段内的磁盘I/O事件,这样可以看到所有的数据。每个磁盘I/O操作被绘制为一个点,其完成时间显示在x轴上,延迟显示在y轴上。

现在可以完全理解高于预期的平均延迟的原因了:存在许多延迟为10毫秒、20毫秒甚至超过50毫秒的磁盘I/O操作。散点图显示了所有的数据,揭示了这些异常值的存在。

许多I/O操作的延迟是亚毫秒级别的,接近x轴。这是散点图分辨率开始成为问题的地方,因为点会重叠在一起,难以区分。随着数据量的增加,问题会变得更加严重:想象一下在一个散点图上绘制来自整个云环境的事件,涉及数百万个数据点。另一个问题是必须收集和处理的数据量:每个I/O操作都需要x和y坐标。

2.10.3 Heat Maps

热力图可以通过将x和y范围量化为称为桶的组来解决散点图的可扩展性问题。这些桶以大像素的形式显示,并根据该x和y范围内的事件数量进行着色。这种量化也解决了散点图的视觉密度限制,使得热力图可以以相同的方式显示来自单个系统或数千个系统的数据。它们可以用于分析延迟、利用率和其他指标【Gregg 10a】。

与之前绘制的相同数据集在图2.29中显示为热力图。

高延迟的异常值可以通过热力图中颜色较浅的大块来识别,因为它们跨越很少的I/O操作(通常是单个I/O操作)。数据的主体部分开始出现模式,这些模式在散点图中可能无法看到。

图2.30的热力图显示了此磁盘I/O跟踪的完整秒数范围(之前未显示)。

尽管跨越了九倍的范围,但可视化仍然非常易读。在很大的范围内可以看到双峰分布,其中一些I/O操作的延迟接近于零(可能是磁盘缓存命中),而其他一些I/O操作的延迟略低于1毫秒(可能是磁盘缓存未命中)。

热力图的一个问题是它们还不像折线图那样广为人知,因此用户必须获得一些理解才能有效地使用它们。

本书后面还有各种其他热力图的示例。

2.10.4 Surface Plot

这是一个表示三个维度的三维表面。当第三维的值在相邻点之间不频繁地发生剧烈变化时,它的效果最好,形成了类似起伏山丘的表面。

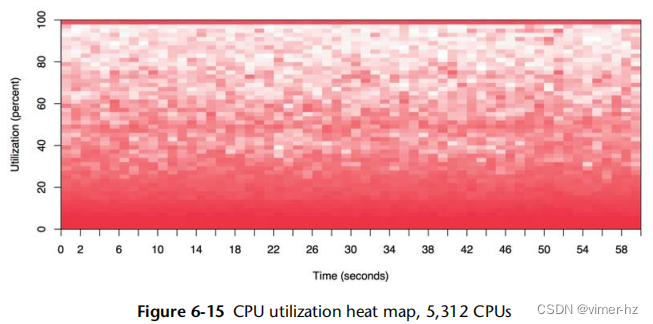

表面绘图通常以线框模型的形式呈现。图2.31显示了每个CPU利用率的线框表面图。它包含来自许多服务器的60秒每秒值(这是从覆盖了超过300个物理服务器和5,312个CPU的数据中心的图像裁剪出来的)[4]。

每个服务器通过在表面上将其16个CPU作为行进行绘制,将60个每秒的利用率测量作为列,并将表面的高度设置为利用率值。颜色也根据利用率值设置。如果需要,色调和饱和度都可以用来添加第四和第五个维度的数据可视化。(如果分辨率足够高,还可以使用图案来表示第六个维度。)

然后,将这些16 x 60个服务器矩形映射到表面上,形成一个棋盘格。即使没有标记,图像中仍然可以清楚地看到一些服务器矩形。在右侧出现的一个被提升的高原表明其CPU几乎始终处于100%的利用率。

使用网格线突出显示高度的微妙变化。一些淡淡的线条可见,表明一个单独的CPU始终以较低的利用率运行(几个百分比)。

2.10.5 Visualization Tools

由于图形支持有限,Unix性能分析在历史上通常侧重于使用基于文本的工具。这样的工具可以在登录会话中快速执行,并实时报告数据。可视化方面的工具更需要花费时间来获取,并且通常需要进行追踪和报告的循环。在处理紧急性能问题时,您可以访问指标的速度至关重要。

现代的可视化工具提供了系统性能的实时视图,可以从浏览器和移动设备上访问。有许多产品可以实现这一点,包括可以监控整个云端的产品,例如Joyent的Cloud Analytics,这是一个基于DTrace的云端分析工具,可以生成包括延迟热图在内的实时可视化。

3 Operating Systems

了解操作系统及其内核对系统性能分析至关重要。您经常需要制定并测试有关系统行为的假设,例如系统调用的执行方式、CPU如何调度线程、有限的内存如何影响性能以及文件系统如何处理I/O。这些行为将需要您应用您对操作系统和内核的知识。

本章概述了操作系统和内核,并假定读者已具备相关知识,是本书的基础。如果您错过了操作系统课程,可以将本章视为快速课程。请留意您所了解的知识中是否存在任何漏洞,因为本章末尾将有一个小测验(开玩笑,只是一个小测试)。有关内核内部的更多信息,请参见本章末尾的参考文献和参考书目。

本章分为两个部分:

背景介绍了术语和操作系统基础知识。

内核概述了基于Linux和Solaris的内核。

有关性能的相关领域,包括CPU调度、内存、磁盘、文件系统、网络和许多特定的性能工具,将在接下来的章节中进行更详细的介绍。

3.1 Terminology

供参考,以下是本书中使用的核心操作系统术语:

操作系统:这指的是安装在系统上的软件和文件,使其能够启动和执行程序。它包括内核、管理工具和系统库。

内核:内核是管理系统的程序,包括设备(硬件)、内存和CPU调度。它运行在允许直接访问硬件的特权CPU模式中,称为内核模式。

进程:用于执行程序的OS抽象和环境。程序通常在用户模式下运行,并通过系统调用或陷阱访问内核模式(例如,执行设备I/O)。

线程:可安排在CPU上运行的可执行上下文。内核有多个线程,一个进程包含一个或多个线程。

任务:Linux可运行实体,可以引用单个线程的进程、来自多线程进程的线程或内核线程。

内核空间:内核的内存地址空间。

用户空间:进程的内存地址空间。

用户层:用户级程序和库(/usr/bin、/usr/lib等)。

上下文切换:内核例程,它将CPU切换到不同的进程地址空间(上下文)中进行操作。

系统调用(syscall):用户程序请求内核执行特权操作的一种明确定义的协议,包括设备I/O。

处理器:不要与进程混淆,处理器是一个包含一个或多个CPU的物理芯片。

陷阱:发送到内核的信号,请求系统例程(特权操作)。陷阱类型包括系统调用、处理器异常和中断。

中断:由物理设备发送到内核的信号,通常是请求I/O服务的信号。中断是陷阱的一种类型。

术语表中包括更多本章需要参考的术语,包括地址空间、缓冲区、CPU、文件描述符、POSIX和寄存器。

3.2 Background

以下各节描述操作系统的概念和通用内核内部。这些部分之后将涵盖特定的内核差异。

3.2.1 Kernel

内核管理CPU调度、内存、文件系统、网络协议和系统设备(磁盘、网络接口等)。它通过系统调用提供对设备和基于它们构建的内核服务的访问。图3.1显示了它的示意图。

//Applications如何直接访问System Calls?

还显示了系统库,通常用于提供比仅使用系统调用更丰富和更易于编程的接口。应用程序包括所有正在运行的用户级软件,包括数据库、Web服务器、管理工具和操作系统Shell。

在这里,系统库被描绘为一个断开的环,以显示应用程序可以直接调用系统调用(如果操作系统允许)。传统上,这个图示是用完整的环来绘制的,反映了从中心核心开始的不同特权级别的递减(这个模型起源于Multics[Graham 68],Unix的前身)。

Kernel Execution

内核是一个庞大的程序,通常包含数十万行代码。它主要根据需求执行,当用户级程序发出系统调用或设备发送中断时执行。一些内核线程异步运行以进行日常维护工作,这可能包括内核时钟例程和内存管理任务,但它们试图轻量化并且消耗非常少的CPU资源。频繁进行I/O操作的工作负载(如Web服务器)通常在内核上下文中执行。计算密集型的工作负载尽可能地被内核保持独立,以便在CPU上无间断地运行。也许会认为内核不能影响这些工作负载的性能,但实际上存在许多情况会受到影响。最明显的是CPU争用,当其他线程竞争CPU资源时,内核调度器需要决定哪个线程将运行,哪个线程将等待。内核还会选择在哪个CPU上运行线程,并且可以选择具有较暖的硬件缓存或更好的进程内存局部性的CPU,从而显著提高性能。

//感觉multi-core cpu越来越重要了!

Clock

Unix内核的一个核心组件是clock()例程,它是从定时器中断执行的。它在过去通常以每秒60次、100次或1,000次的频率执行,每次执行被称为一个tick。它的功能包括更新系统时间、处理定时器和线程调度的时间片、维护CPU统计信息以及执行调用(预定的内核例程)。

在早期的内核中,clock存在性能问题,在后续的内核中得到改进,包括:

- Tick延迟:对于100 Hz的时钟,一个定时器可能会等待下一个tick的处理而产生高达10毫秒的额外延迟。通过使用高分辨率实时中断来修复这个问题,使得执行立即进行而无需等待。

- Tick开销:现代处理器具有动态电源特性,可以在空闲期间关闭部分电源。而clock例程会打断这个过程,对于空闲系统来说可能会不必要地消耗电力。Linux实现了动态ticks,因此当系统处于空闲状态时,定时器例程(clock)不会触发。

现代内核将许多功能从clock例程移出到按需中断中,以创建一个无tick的内核。其中包括Linux,其中的clock例程(即系统定时器中断)除了更新系统时钟和jiffies计数器(jiffies是Linux中的一种时间单位,类似于ticks)之外几乎不执行其他工作。

Kernel Mode

内核是在一种称为内核模式的特殊CPU模式下运行的唯一程序,允许对设备进行完全访问并执行特权指令。内核调解设备访问以支持多任务处理,防止进程和用户在没有明确许可的情况下访问彼此的数据。

用户程序(进程)在用户模式下运行,它们通过系统调用向内核请求特权操作,例如进行I/O操作。要执行系统调用,执行将从用户模式切换到内核模式,然后以较高的权限级别执行。这在图3.2中显示。

每个模式都有自己的软件执行状态,包括堆栈和寄存器。在用户模式下执行特权指令会引发异常,然后由内核进行适当处理。

这些模式(用户模式和内核模式)之间的切换需要时间(CPU周期),这为每个I/O操作增加了一小部分开销。一些服务,例如NFS,已被实现为内核模式软件(而不是用户模式守护程序),这样它们可以在不需要切换到用户模式的情况下执行与设备之间的I/O操作。

如果系统调用在执行过程中阻塞,进程可能会从CPU上切换下来,并被另一个进程取代:这称为上下文切换。

3.2.2 Stacks

栈以函数和寄存器的形式包含了线程的执行祖先。CPU使用栈来高效地处理本地软件中的函数执行。

当调用一个函数时,当前CPU寄存器的集合(存储CPU状态)会保存到栈中,并在栈顶为当前线程的当前执行添加一个新的栈帧。函数通过调用“返回”CPU指令来结束执行,该指令会移除当前的栈并将执行返回到先前的栈中,恢复其状态。

栈检查是调试和性能分析的宝贵工具。栈显示了当前执行的调用路径,这通常可以解答为什么会执行某个操作的问题。

How to Read a Stack

下面是一个示例内核栈(来自Linux),显示了TCP传输的路径,由一个调试工具打印出来:

栈的顶部通常显示为第一行。在这个示例中,它包括了正在执行的函数的名称tcp_sendmsg。函数名称的左右两边是调试器通常包含的细节:内核模块位置(`kernel)和指令偏移量(0x1,它指的是函数内的指令地址)。

调用tcp_sendmsg()的函数(其父函数)可以在其下面看到:inet_sendmsg()。而其父函数则在其下面:sock_aio_write()。通过阅读栈,可以看到完整的祖先链:函数、父函数、祖父函数等等。或者,通过自底向上阅读,可以追踪到当前函数的执行路径:我们是如何到达这里的。

由于栈展示了源代码中的内部路径,这些函数通常没有其他文档,除了代码本身。对于这个示例栈来说,这就是Linux内核源代码。一个例外是那些作为API的一部分并且有公共文档的函数。

User and Kernel Stacks

在执行系统调用时,一个进程线程有两个栈:用户级栈和内核级栈。它们的范围如图3.3所示。

在系统调用期间,被阻塞的线程的用户级栈不会改变,因为线程在内核上下文中执行时使用的是一个单独的内核级栈。(一个例外是信号处理程序,根据其配置可能会借用一个用户级栈。)

3.2.3 Interrupts and Interrupt Threads

除了响应系统调用外,内核还会响应来自设备的服务请求。这些被称为中断,因为它们会中断当前的执行。这在图3.4中有所描述。

设备中断会注册一个中断服务例程来处理。这些例程被设计成尽可能快地运行,以减少对活动线程的中断影响。如果一个中断需要执行更多的工作,特别是如果它可能在锁上阻塞,那么可以由内核调度一个中断线程来处理。

这个实现取决于内核版本。在Linux上,设备驱动程序可以被建模为两个部分,顶半部分快速处理中断,并将工作调度给底半部分以便稍后处理[Corbet 05]。快速处理中断很重要,因为顶半部分在禁止中断模式下运行,以推迟新中断的传递,如果运行时间过长,可能会对其他线程造成延迟问题。底半部分可以是任务(let)或工作队列(work queue);后者是由内核调度并在需要时可以睡眠的线程。基于Solaris的系统会将中断提升为中断线程,如果需要执行更多的工作[McDougall 06a]。

从中断到达到服务的时间被称为中断延迟,这取决于具体的实现方式。这是实时或低延迟系统研究的课题。

3.2.4 Interrupt Priority Level

中断优先级(IPL)表示当前活动的中断服务例程的优先级。在传递中断信号期间,它是从处理器中读取的,只有当其优先级高于当前正在执行的中断(如果有的话),中断才会成功;否则,中断将排队等待稍后处理。这样可以防止较低优先级的工作中断较高优先级的工作。

图3.5显示了一个例子中断优先级范围,对于此内核服务而言,IPL1到IPL10是中断线程。

串行I/O具有较高的中断优先级,因为其硬件缓冲区通常较小,需要快速服务以避免溢出。

3.2.5 Processes

进程是执行用户级程序的环境。它由内存地址空间、文件描述符、线程栈和寄存器组成。在某些方面,进程类似于虚拟的早期计算机,只有一个程序正在执行,具有自己的寄存器和堆栈。

内核通过多任务处理进程,通常在单个系统上支持数千个进程的执行。它们分别由它们的进程ID(PID)唯一标识。

进程包含一个或多个线程,它们在进程地址空间中操作并共享相同的文件描述符(表示打开文件的状态)。线程是一个可执行的上下文,由堆栈、寄存器和程序计数器组成。多个线程允许单个进程在多个CPU上并行执行。

Process Creation

通常使用fork()系统调用创建进程。这将创建一个进程的副本,具有自己的进程ID。然后可以调用exec()系统调用来开始执行不同的程序。

图3.6显示了一个示例进程创建过程,shell(sh)执行ls命令。

fork()系统调用可能使用写时复制(COW)策略来提高性能。这会向先前的地址空间添加引用,而不是复制所有内容。一旦任何一个进程修改了多次引用的内存,就会为修改创建一个单独的副本。该策略延迟或消除了复制内存的需要,减少内存和CPU的使用。

Process Life Cycle

进程的生命周期如图3.7所示。这是一个简化的图表;对于现代多线程操作系统,调度和运行的是线程,并且有关如何将这些映射到进程状态的一些额外实现细节(供参考,请参阅内核源代码中的proc.h文件)。

在处理器(CPU)上运行时,进程处于运行状态。准备运行状态是指进程可运行,但正在等待在 CPU 运行队列中轮到它运行。I/O 操作会阻塞进程,将其置于睡眠状态,直到 I/O 完成并唤醒进程。僵尸状态发生在进程终止期间,进程将等待其进程状态被父进程读取,或者直到被内核移除。

Process Environment

进程环境如图3.8所示,它由进程的地址空间中的数据和内核中的元数据(上下文)组成。

//这个图很清晰!!!

内核上下文包括各种进程属性和统计信息:进程ID(PID),所有者的用户ID(UID)以及各种时间。通常可以通过ps(1)命令进行检查。它还具有一组文件描述符,用于引用打开的文件,这些文件描述符(通常)在线程之间共享。

此示例显示了两个线程,每个线程都包含一些元数据,包括内核上下文中的优先级和用户地址空间中的堆栈。该图表没有按比例绘制;与进程地址空间相比,内核上下文非常小。

用户地址空间包含进程的内存段:可执行文件、库和堆。有关更多详细信息,请参阅第7章"内存"。

3.2.6 System Calls

系统调用是请求内核执行特权系统例程的操作。可用的系统调用数量在数百个,但会尽量保持这个数量尽可能小,以保持内核的简洁性(Unix哲学;[Thompson 78])。更复杂的接口可以在用户空间构建在它们之上作为系统库,在那里更容易开发和维护。

需要记住的关键系统调用列在表3.1中。

系统调用都有详细的文档,通常与操作系统一起提供。它们的接口通常简单而一致,其中包括设置一个特殊变量 errno,以指示是否遇到错误及其类型。

许多系统调用有明显的目的。以下是一些常见用途不太明显的系统调用:

ioctl():通常用于向内核请求各种操作,特别是对于系统管理工具,在其他(更明显)的系统调用不适用的情况下使用。可以参考下面的示例。

mmap():通常用于将可执行文件和库文件映射到进程的地址空间中,以及进行内存映射文件。有时它也被用来分配进程的工作内存,而不是基于 brk() 的 malloc(),以减少系统调用的频率并提高性能(这并不总是有效的,因为这涉及到权衡:内存映射管理)。

brk():用于扩展堆指针,定义进程的工作内存大小。通常由系统内存分配库执行,当堆中的现有空间无法满足 malloc()(内存分配)调用时使用。详见第7章"内存"。

如果对某个系统调用不熟悉,可以在其 man page 中了解更多信息(这些位于第2节:syscalls)。

ioctl() 系统调用可能是最难学习的,因为其含义不明确。以 Linux 中的 perf(1) 工具(在第6章"处理器"中介绍)的使用为例,它执行特权操作以协调性能工具。而不是为每个动作添加系统调用,只添加了一个系统调用:perf_event_open(),它返回一个文件描述符,可与 ioctl() 一起使用。然后可以使用不同的参数来调用这个 ioctl() 以执行不同的操作。例如,ioctl(fd, PERF_EVENT_IOC_ENABLE) 可以启用性能工具。在这个示例中,参数 PERF_EVENT_IOC_ENABLE 更容易由开发人员添加和更改。

/*mmap内存映射的内存和malloc()分配的堆内存的区别:

1 malloc() 分配的堆内存来自进程的堆空间,而 mmap() 内存映射的内存通常与文件或设备相关联。

2 对于 malloc() 分配的堆内存,一般只有当前进程可以直接访问。而 mmap() 内存映射的内存可以通过多个进程共享,实现进程间的通信和共享数据。

*/

/*

进程内存分布图:

https://blog.csdn.net/m0_65346989/article/details/130395560

问题:mmap内存映射的内存对应图中哪个位置?

*/

3.2.7 Virtual Memory

虚拟内存是主存的一种抽象,为进程和内核提供了自己的、几乎无限的私有主存视图。它支持多任务处理,允许进程和内核在自己的私有地址空间中运行而无需担心冲突问题。它还支持超额订阅主存,允许操作系统根据需要在主存和二级存储(磁盘)之间透明地映射虚拟内存。虚拟内存的作用如图 3.9 所示。主存是主内存(RAM),次存是存储设备(磁盘)。

虚拟内存的实现依赖于处理器和操作系统的支持。它并非真实的内存,大多数操作系统只在需要时,即内存首次被使用(写入)时,将虚拟内存映射到真实内存中。有关虚拟内存的更多信息,请参阅第7章"内存"。

3.2.8 Memory Management

虚拟内存允许使用辅助存储器扩展主存,但内核努力将最活跃的数据保持在主存中。为此,内核有两种例行程序:

1. 交换(Swapping)将整个进程在主存和辅助存储器之间移动。

2. 分页(Paging)将称为页面(例如,4 KB)的小内存单位移动。

交换是原始 Unix 方法,可能会导致严重的性能损失。分页更为高效,在引入页面式虚拟内存的 BSD 中被添加。在这两种情况下,最近最少使用(或最近未使用)的内存被移动到辅助存储器中,并且只有在需要时才会被移回到主存中。

在 Linux 中,术语 swapping 用于指代分页。Linux 内核不支持(较旧的)Unix 风格的整个线程和进程交换。

关于分页和交换的更多内容,请参阅第7章"内存"。

3.2.9 Schedulers

Unix 及其衍生系统是时间分享系统,通过将执行时间分配给多个进程,使它们能够同时运行。进程在处理器和各个 CPU 上的调度由调度程序完成,调度程序是操作系统内核的关键组件。调度程序的作用如图 3.10 所示,它对线程(在 Linux 中称为任务)进行操作,并将它们映射到 CPU 上。

基本意图是将 CPU 时间分配给活动进程和线程,并保持一定的优先级概念,以便更重要的工作能够更早地执行。调度程序跟踪所有处于就绪状态的线程,传统上是在每个优先级队列上进行,称为运行队列[Bach 86]。现代内核可能会针对每个 CPU 实现这些队列,并且除了队列之外,还可以使用其他数据结构来跟踪线程。当有更多的线程要运行而可用的 CPU 不足时,较低优先级的线程会等待它们的轮到来。大多数内核线程的优先级高于用户级进程。

调度程序可以动态修改进程优先级,以改善特定工作负载的性能。工作负载可以分为以下两类:

1. CPU 密集型:执行大量计算的应用程序,例如科学和数学分析,预计具有长运行时间(几秒、几分钟、几小时)。这些工作负载受 CPU 资源限制。

2. I/O 密集型:执行 I/O 操作很多但计算量很少的应用程序,例如 Web 服务器、文件服务器和交互式 shell,需要低延迟响应。当它们的负载增加时,它们受 I/O 存储或网络资源的限制。

调度程序可以识别出 CPU 密集型工作负载,并降低它们的优先级,从而让 I/O 密集型工作负载(其中低延迟响应更可取)更早地运行。这可以通过计算最近计算时间(在 CPU 上执行的时间)与实际时间(经过的时间)的比率,并降低具有较高(计算)比率的进程的优先级来实现[Thompson 78]。这种机制优先处理运行时间较短的进程,通常是执行 I/O 操作的进程,包括人机交互进程。

现代内核支持多个调度类别,它们应用不同的算法来管理优先级和可运行线程。其中可能包括实时调度类别,该类别使用比所有非关键工作(包括内核线程)更高的优先级。实时调度类别以及抢占支持(稍后将介绍)为实时系统提供了低延迟调度。有关内核调度程序和其他调度类别的更多信息,请参阅第6章“CPU”。

3.2.10 File Systems

文件系统是将数据组织为文件和目录的一种方式。它们具有基于文件的接口,通常基于 POSIX 标准。内核可以支持多种文件系统类型和实例。提供文件系统是操作系统最重要的角色之一,曾被描述为最重要的角色之一[Ritchie 74]。

操作系统提供了一个全局文件命名空间,以自顶向下的树状拓扑结构组织,从根级别(“/”)开始。文件系统通过挂载将其加入到树中,将自己的树连接到一个目录(挂载点)。这使得最终用户可以透明地浏览文件命名空间,而不受底层文件系统类型的限制。

一个典型的操作系统可能按照图3.11所示的方式进行组织。

顶级目录包括etc(用于系统配置文件),usr(用于系统提供的用户级程序和库),dev(用于设备文件),var(用于包含系统日志等可变文件),tmp(用于临时文件)和home(用于用户主目录)。在图示的示例中,var和home可能位于它们自己的文件系统实例和单独的存储设备上;但是,它们可以像树的任何其他组件一样进行访问。

大多数文件系统类型使用存储设备(磁盘)来存储其内容。一些文件系统类型由内核动态创建,例如/proc或/dev。

VFS

虚拟文件系统(VFS)是一个用于抽象文件系统类型的内核接口,最初由Sun Microsystems开发,以便Unix文件系统(UFS)和NFS能够更容易地共存。其角色如图3.12所示。

VFS接口使得向内核添加新的文件系统类型更加容易。它还支持提供之前所述的全局文件命名空间,以便用户程序和应用程序可以透明地访问各种文件系统类型。

I/O Stack

对于基于存储设备的文件系统,从用户级软件到存储设备的路径被称为I/O堆栈。这是之前展示的整个软件堆栈的一个子集。图3.13显示了一个通用的I/O堆栈。

文件系统及其性能在第8章《文件系统》中有详细介绍,而构建在其上的存储设备在第9章《磁盘》中进行了讨论。

3.2.11 Caching

由于磁盘I/O的延迟通常较高,软件堆栈的许多层次尝试通过缓存读取和缓冲写入来避免它。缓存可能包括表3.2中所示的缓存(按照检查的顺序)。

例如,缓冲区缓存是主内存中存储最近使用的磁盘块的区域。如果请求的块存在于缓存中,磁盘读取可以立即从缓存中提供,避免了磁盘I/O的高延迟。(11)

存在的缓存类型会根据系统和环境而异。

3.2.12 Networking

现代内核提供了一系列内置网络协议,使得系统能够在网络上进行通信并参与分布式系统环境。该堆栈被称为TCP/IP堆栈,以常用的TCP和IP协议命名。用户级应用程序通过可编程的端点(套接字)访问网络。

连接到网络的物理设备是网络接口,通常提供在网络接口卡(NIC)上。系统管理员的常见职责之一是将IP地址与网络接口关联起来,以便它可以与网络通信。

网络协议不经常更改,但增强和选项有所变化,例如更新的TCP选项和TCP拥塞控制算法,需要内核支持。另一个变化是支持不同的网络接口卡,这需要内核的新设备驱动程序。

有关网络和网络性能的更多信息,请参见第10章《网络》。

3.2.13 Device Drivers

内核必须与各种物理设备进行通信。使用设备驱动程序实现这种通信:内核软件用于设备管理和I/O。设备驱动程序通常由开发硬件设备的厂商提供。一些内核支持可插拔的设备驱动程序,可以在不需要系统重启的情况下加载和卸载。

设备驱动程序可以为其设备提供字符和/或块接口。字符设备,也称为原始设备,根据设备的不同,提供任何I/O大小的非缓冲顺序访问甚至单个字符的访问。这样的设备包括键盘和串行端口(在原始Unix中,还有纸带和线打印机设备)。

块设备以块为单位执行I/O操作,每个块通常为512字节。可以基于它们的块偏移随机访问这些块,从块设备的开始处开始,偏移量为0。在原始Unix中,块设备接口还提供了块设备缓冲区的缓存,以提高性能,在主内存的缓冲区缓存区域中完成。

/*sensor驱动程序是字符设备还是块设备?

传感器驱动程序通常被视为字符设备。这是因为传感器通常以流式数据的形式输出读数,而不是以固定大小的块进行访问。因此,传感器驱动程序提供的接口是一个字符接口,允许逐个字符或按流读取传感器数据。

*/

3.2.14 Multiprocessor

多处理器支持允许操作系统使用多个CPU实例并行执行工作。通常以对称多处理(SMP)的形式实现,其中所有CPU被平等对待。这在技术上是很难实现的,会导致在并行运行的线程之间访问和共享内存和CPU时出现问题。有关详细信息,请参见第6章“CPU”中的调度和线程同步,以及第7章“内存”中的内存访问和架构。

CPU跨调用

对于多处理器系统,CPU有时需要协调,例如用于内存转换项的缓存一致性(通知其他CPU,如果缓存了一个条目,则现在已经过时)。CPU可以请求其他CPU或所有CPU立即执行此类工作,使用CPU跨调用。跨调用是设计成快速执行的处理器中断,以最小化对其他线程的中断。

跨调用也可以用于抢占。

3.2.15 Preemption

内核抢占支持允许高优先级的用户级线程中断内核并执行。这使得实时系统(具有严格的响应时间要求的系统)成为可能。支持抢占的内核被称为完全可抢占的,尽管实际上它仍然会有一些无法被中断的小型关键代码路径。

Linux支持的一种方法是自愿内核抢占,在内核代码的逻辑停止点可以检查并执行抢占。这避免了支持完全可抢占内核的一些复杂性,并为常见工作负载提供了低延迟的抢占。

3.2.16 Resource Management

操作系统可以提供各种可配置的控制,以微调对系统资源(如CPU、内存、磁盘和网络)的访问。这些是资源控制,可以用于运行不同应用程序或租户(云计算)的系统来管理性能。这些控制可以对每个进程(或进程组)的资源使用设置固定限制,或者采用更灵活的方法,允许它们之间共享闲置使用。

早期的Unix和BSD版本具有基本的针对每个进程的资源控制,包括使用nice(1)进行CPU优先级设置,以及使用ulimit(1)进行一些资源限制。基于Solaris的系统自Solaris 9(2002年)起提供了高级资源控制,并在resources_controls(5)手册页中有相关文档。

对于Linux,已经开发并集成了控制组(cgroups)功能,从2.6.24版本(2008年)开始,并添加了各种附加控制功能。这些功能在内核源码的Documentation/cgroups目录下有详细说明。

适当的章节中会提到特定的资源控制。第11章“云计算”中描述了一个示例用例,用于管理基于操作系统的租户的性能。

3.2.17 Observability

操作系统由内核、库和程序组成。这些程序包括用于观察系统活动和分析性能的工具,通常安装在/usr/bin和/usr/sbin目录下。还可以在系统上安装第三方工具来提供额外的可观察性。

下一章介绍了可观察性工具以及构建它们所依赖的操作系统组件。

3.3 Kernels

本节介绍了基于Solaris和Linux内核(按时间顺序),它们的历史和特点,并重点讨论了它们在性能方面的差异。Unix的起源也作为背景进行了讨论。

现代内核之间的一些明显差异包括它们支持的文件系统(参见第8章“文件系统”)和它们提供的可观察性框架(参见第4章“可观察性工具”)。还存在着它们的系统调用(syscall)接口、网络堆栈架构、实时支持以及CPU、磁盘和网络I/O调度方面的差异。

表3.3显示了最近的内核版本,其中系统调用计数是基于操作系统手册第2节中的条目数。这是一个粗略的比较,但足以看出一些差异。

这些只是有文档记录的系统调用,内核通常还提供了更多供操作系统软件私下使用的系统调用。除了内核之间的差异,随着时间的推移,存在一种模式:Linux一直在增加系统调用,而Solaris则一直在删除系统调用。

UNIX最初只有20个系统调用,而今天直接来自UNIX的Linux已经有超过一千个……我只是担心随之增长的复杂性和规模。

肯·汤普森(Ken Thompson),ACM图灵百年庆典,2012年

这两个内核实际上都在不同的方式中变得越来越复杂,并通过添加新的系统调用或通过其他内核接口将此暴露给用户空间。

3.3.1 Unix

Unix是由肯·汤普森(Ken Thompson)、丹尼斯·里奇(Dennis Ritchie)和贝尔实验室(AT&T Bell Labs)的其他人在1969年及其后几年开发的。它的确切起源在《UNIX分时系统》[Ritchie 74]中有所描述:

第一个版本是由我们其中之一(汤普森)在对现有计算机设备不满意的情况下,发现了一个很少使用的PDP-7,然后着手创建一个更友好的环境。

UNIX的开发者之前曾在多路信息和计算机服务(Multics)操作系统上工作过。UNIX最初被开发为一种轻量级多任务操作系统和内核,最初被命名为UNiplexed Information and Computing Service(UNICS),以对Multics进行双关语的方式命名。从《UNIX实施》[Thompson 78]中可以看出:

内核是唯一不能由用户自己替换的UNIX代码。因此,内核应该尽可能少地做出真正的决策。这并不意味着允许用户通过无数选项来完成相同的事情。相反,它意味着只允许一种方式来完成一件事,但这种方式是所有可能提供的选项的最小公倍数。

尽管内核很小,但它确实提供了一些高性能的功能。进程具有调度器优先级,以降低高优先级工作的运行队列延迟。为了效率,磁盘I/O是按照大块(512字节)进行的,并且在内存中的每个设备缓冲区缓存中进行了缓存。空闲进程可以被交换到存储器中,使得更繁忙的进程可以在主存中运行。当然,该系统是多任务的,允许多个进程同时运行,提高作业吞吐量。

为了支持网络、多个文件系统、分页和其他我们现在认为是标准的功能,内核不得不增长。而且随着包括BSD、SunOS(Solaris)和后来的Linux在内的多个衍生版本的出现,内核性能变得具有竞争力,这推动了更多功能和代码的添加。

3.3.2 Solaris-Based

Solaris内核不仅是Unix衍生的,甚至还保留了一些原始Unix内核的代码。Solaris始于1982年由Sun Microsystems创建的SunOS。基于BSD,SunOS被保持得小巧紧凑,以便在Sun工作站上表现出色。到了1980年代末,Sun已经开发了新的操作系统功能,并与BSD和Xenix的功能一起贡献给了AT&T的Unix System V Release 4(SVR4)。随着SVR4成为新的Unix标准,Sun基于它创建了一个新的内核和操作系统:SunOS 5。Sun市场营销将其称为Solaris 2.0,并将先前的SunOS命名为Solaris 1.0。然而,工程师们在内核中保留了SunOS的名称。

Sun内核的发展,特别是与性能相关的,包括以下内容:

NFS:NFS协议允许文件在网络上共享,并作为全局文件系统树的一部分透明地使用(挂载)。NFS目前广泛使用的是3和4版本,每个版本都引入了许多性能改进。

VFS:虚拟文件系统(VFS)是一个抽象和接口,允许多个文件系统轻松共存。Sun最初创建它是为了使NFS和UFS可以共存。有关VFS的详细信息,请参见第8章,文件系统。

页面缓存:这个缓存虚拟内存页面,并且自从引入以来一直是大多数操作系统的主要文件系统缓存(ZFS ARC是一个例外)。它在SunOS 4中引入,同时也支持共享页面。有关页面缓存的更多信息,请参见第8章,文件系统。

内存映射文件:可用于减少文件I/O的开销,并在SVR4的SunOS虚拟内存重写中引入。

RPC:远程过程调用接口。

NIS:网络信息服务是一个简单的扁平拓扑结构,用于在网络上共享信息,包括passwd和hosts文件。它多年来被广泛使用,但现在正在被LDAP取代。

CacheFS:缓存文件系统在Solaris 2.4(1994年)引入,用于提高访问慢速NFS服务器的性能。此后,NFS服务器的性能已经提高到CacheFS不再常用或被考虑的程度。

完全可抢占内核:Sun最早的一个特点是其完全可抢占内核,确保高优先级工作(包括实时工作)的低延迟。

调度器类:提供多个调度器类来调整不同类工作负载的性能。这些包括时间共享(TS)、交互式(IA)、实时(RT)、系统(SYS)、固定(FX)和公平分享调度器(FSS)。有关详细信息,请参见第6章,CPU。

/*

上面的内存映射文件是指mmap么?

是的,上面提到的内存映射文件就是指mmap。mmap是一种将文件或其他对象映射到内存中的方法,使得应用程序可以像访问内存一样访问这些对象,从而避免了频繁的文件I/O操作带来的开销。在SVR4的SunOS虚拟内存重写中,引入了内存映射文件的概念。

*/

多处理器支持:在上世纪90年代初,Sun大力投资于多处理器操作系统支持,开发了对称和非对称多处理器(ASMP和SMP)的内核支持[Mauro 01]。

Slab分配器:取代了SVR4的伙伴分配器,内核slab分配器通过预先分配缓冲区的每个CPU缓存,提供更好的性能,这些缓冲区可以快速重用。这种分配器类型及其衍生物已成为操作系统的标准。

崩溃分析:Sun开发了一个成熟的内核崩溃转储分析框架,适用于所有系统并默认启用,包括用于崩溃转储、内核和应用程序分析的模块化调试器(mdb(1))。

M:N线程调度:这实现了一个在线程和进程之间增加一个额外的对象,目的是进行高效的线程调度。这个对象被称为轻量级进程(LWP),它可以有自己的用户级调度行为,与内核调度器不同。Sun的实现后来被发现存在问题,并且不值得复杂性[Cantrill 96]。它在Solaris 9中被删除,但术语(LWP)和一些数据结构在Solaris的某些部分中仍然存在。

STREAMS网络堆栈:Sun在AT&T STREAMS接口上构建了其TCP/IP网络堆栈,该接口提供了用户空间和内核空间之间的通信。它最终无法适应更快的网络,到Solaris 10时,许多STREAMS管道已被删除。

64位支持:Solaris 7内核(1998年)提供了对64位处理器的支持。

锁统计:在Solaris 7中引入了锁性能统计。

MPSS:多页大小支持允许操作系统使用由处理器提供的不同大小的内存页面,包括大(或巨大)页面,提高了内存操作的效率。

MPO:在Solaris 9中添加了内存放置优化,以改善与处理器体系结构(局部性)相关的内存分配方式,这可以显着提高内存访问性能。

资源控制:一种限制进程或进程组使用各种资源的设施,称为项目(稍后由区域使用)。

FireEngine:用于Solaris 10的一组高性能TCP/IP堆栈增强功能,包括垂直边界,以改善数据包处理的CPU和内存局部性,以及IP扇出以在CPU之间分散负载。

DTrace:一个静态和动态跟踪框架和工具,实时在生产环境中提供对整个软件堆栈的几乎无限的可观察性。它于2005年发布于Solaris 10,并成为首个广泛成功的动态跟踪实现。它已被移植到其他操作系统,包括Mac OS X和FreeBSD,并目前正在移植到Linux。DTrace在第4章“可观察性工具”中有详细介绍。

Zones:一种基于操作系统的虚拟化技术,允许创建共享同一主机内核的操作系统实例。它于Solaris 10发布,但这个概念最早由FreeBSD的jails在1998年实现。与其他虚拟化技术相比,它们具有轻量级和高性能的特点。详见第11章“云计算”。

Crossbow:一种提供高性能虚拟化网络接口和网络带宽资源控制的架构。这个特性对于构建高性能和可靠的云至关重要。

ZFS:ZFS文件系统提供了企业级功能,并随Solaris 10更新1一起发布,同时也作为开源软件提供。现在它已经适用于其他操作系统,并成为许多文件服务器设备的基础。详见第8章“文件系统”。

其中许多功能已经被移植或重新实现为Linux,并且有些功能仍在开发中。

在面对Linux的压力下,Sun在2005年将Solaris开源为OpenSolaris项目。它一直保持开源状态,直到Oracle于2010年收购Sun并停止发布源代码更新。最后发布的OpenSolaris版本,它镜像了Solaris 11的开发版本,成为开源的illumos内核的基础。今天有几种基于illumos内核的操作系统,包括Joyent的SmartOS,它被用于本书中许多基于Solaris的示例中。

3.3.3 Linux-Based

Linux是由Linus Torvalds于1991年创建的免费操作系统,用于Intel个人计算机。他在Usenet上发布了这个项目的消息:

我正在开发一个(免费的)操作系统(只是一种爱好,不会像GNU那样大而专业),用于386(486)AT克隆机。这个项目从四月份开始酝酿,并且正在逐渐准备就绪。我希望得到关于人们在MINIX中喜欢/不喜欢的事物的任何反馈,因为我的操作系统在某种程度上类似于它(包括文件系统的物理布局相同(出于实际原因)等等)。

这里提到的是MINIX操作系统,它当时正在开发,作为面向小型计算机的免费和精简版Unix。BSD也致力于提供一个免费的Unix版本,尽管当时遇到了法律问题。

Linux内核的开发借鉴了许多前辈的一般性思想,包括:

Unix(和Multics):操作系统层,系统调用,多任务处理,进程,进程优先级,虚拟内存,全局文件系统,文件系统权限,设备文件,缓存

BSD:分页虚拟内存,按需分页,快速文件系统(FFS),TCP/IP网络堆栈,套接字

Solaris:VFS、NFS、页面缓存、统一页面缓存、slab分配器,以及(正在进行中的)ZFS和DTrace

Plan 9:资源叉(rfork),用于创建进程和线程(任务)之间不同级别的共享。

/*

内存管理buddy和slab分配器的关系是?

Buddy分配器和Slab分配器是Linux内核中用于内存管理的两种不同机制。

Buddy分配器是一种用于管理大块连续内存的算法。它将物理内存按照2的幂次方进行划分,并通过合并相邻的空闲块来满足不同大小的内存分配请求。Buddy分配器主要用于处理大于一个页面的内存分配,例如进程堆栈或内核数据结构。

Slab分配器是一种用于管理小块连续内存(称为slabs)的机制。它通过将内存划分为固定大小的slabs来提高内存分配和释放的效率。每个slab被预先分配并用作特定类型的对象的缓存,以减少频繁的内存分配和释放操作。Slab分配器主要用于管理内核数据结构和缓存,例如文件描述符、进程控制块等。

因此,Buddy分配器和Slab分配器是Linux内核中两个不同的内存管理机制,用于处理不同大小和类型的内存分配需求。

*/

Linux内核的特性,特别是与性能相关的特性包括以下内容。其中许多特性包括了它们首次引入的Linux内核版本。

CPU调度类:开发了各种高级CPU调度算法,包括调度域(2.6.7)以更好地决策非均匀存储器访问(NUMA)。参见第6章,CPUs。

I/O调度类:开发了不同的块I/O调度算法,包括deadline(2.5.39)、anticipatory(2.5.75)和完全公平队列(CFQ)(2.6.6)。参见第9章,磁盘。

TCP拥塞控制:Linux内核支持新的TCP拥塞控制算法,允许根据需要选择。还有许多TCP增强功能。参见第10章,网络。

超额提交:与内存不足杀手(OOM)一起,这是一种利用更少主内存进行更多操作的策略。参见第7章,内存。

Futex(2.5.7):快速用户空间互斥量,用于提供高性能的用户级同步原语。

巨大页面(2.5.36):这提供了对由内核和内存管理单元(MMU)预分配的大内存页面的支持。参见第7章,内存。

OProfile(2.5.43):一个系统性能分析器,用于研究CPU使用率和其他事件,适用于内核和应用程序。

RCU(2.5.43):内核提供了一种读-复制-更新同步机制,允许多个读与更新并发进行,从而提高数据的性能和可扩展性。

epoll (2.5.46):一个系统调用,用于有效地等待许多打开文件描述符的I/O操作,提高服务器应用程序的性能。

模块化I/O调度(2.6.10):Linux提供了可插拔的调度算法来调度块设备I/O。参见第9章,磁盘。

DebugFS(2.6.11):内核向用户级别公开数据的简单非结构化接口,被一些性能工具使用。

Cpusets(2.6.12):进程的独占CPU分组。

自愿内核抢占(2.6.13):此过程提供低延迟调度而不需要完全抢占的复杂性。

inotify(2.6.13):用于监视文件系统事件的框架。

blktrace(2.6.17):用于跟踪块I/O事件的框架和工具(后来迁移到tracepoints)。

splice(2.6.17):一种系统调用,用于在文件描述符和管道之间快速移动数据,无需通过用户空间。

延迟账户(2.6.18):跟踪每个任务的延迟状态。参见第4章,可观测性工具。

IO账户(2.6.20):测量各种存储I/O统计信息的进程。

DynTicks(2.6.21):动态滴答允许内核定时器中断(时钟)仅在必要时触发(无滴答),节省CPU资源和电源。

SLUB(2.6.22):一个新的、简化的slab内存分配器版本。

CFS(2.6.23):完全公平调度程序。参见第6章,CPUs。

cgroups(2.6.24):控制组允许对进程组的资源使用进行测量和限制。

latencytop(2.6.25):用于观察操作系统延迟来源的仪器和工具。

Tracepoints(2.6.28):静态内核跟踪点(也称为静态探针),用于仪器化内核中的逻辑执行点,供跟踪工具使用(以前是内核标记)。跟踪工具在第4章可观测性工具中介绍。

perf(2.6.31):Linux性能事件(perf)是一组用于性能可观测性的工具,包括CPU性能计数器分析和静态和动态跟踪。参见第6章,CPUs,进行介绍。

透明大页面(2.6.38):这是一个框架,允许轻松使用巨大(大)内存页面。参见第7章,内存。

Uprobes(3.5):用于动态跟踪用户级软件的基础设施,被其他工具(perf、SystemTap等)使用。

KVM:基于内核的虚拟机(KVM)技术是由Qumranet开发的,后来在2008年被Red Hat收购。KVM允许创建虚拟操作系统实例并运行它们自己的内核。请参见第11章,云计算。

其中一些功能,包括epoll和KVM,已经被移植或重新实现为基于Solaris的系统。

Linux还通过其对设备驱动程序的广泛支持和开源要求,间接地为许多其他操作系统做出了贡献。

3.3.4 Differences

虽然Linux和基于Solaris的内核都是Unix的后代,共享相同的操作系统概念,但它们在许多方面都有不同,无论是大还是小。没有简洁明了的方法来总结这种复杂性。

Linux系统的主要优势主要不来自内核或操作系统本身,而来自应用程序包支持、设备驱动程序支持、庞大的社区以及其开源性。大多数基于Solaris的内核也是开源的(Oracle Solaris目前不是),但它们没有相同广泛的驱动程序支持(这对于笔记本电脑使用可能是一个问题)。

基于Solaris的系统提供了面向企业级的ZFS文件系统和几乎无限的可观测性DTrace。尽管它们正在被移植到Linux上,但它们已经在基于Solaris的系统上可用并成熟,自2003年以来已在生产环境中使用。Linux确实具有许多较新的会计和跟踪框架,提供了扩展的可观测性(在下一章中介绍),但它们可能尚未普遍启用或默认安装。

基于Solaris的系统还默认启用了内核崩溃转储,以便可以从第一次发生时对内核崩溃进行分析和解决。

除了这些主要差异之外,内核之间还有许多许多微小的差异,特别是在性能优化方面。要了解这些差异如何影响您,需要分析所需工作负载,以确定哪些是相关的。

举个微小差异的例子,POSIX的fadvise()调用目前在Linux上实现,但在基于Solaris的内核上被忽略。应用程序可以使用此调用通知内核不缓存与文件描述符相关联的数据,从而允许Linux内核更高效地进行缓存,提高性能。以下是来自MySQL数据库的一个示例用法:

storage/innobase/row/row0merge.c:

/* Each block is read exactly once. Free up the file cache. */

posix_fadvise(fd, ofs, sizeof *buf, POSIX_FADV_DONTNEED);这样的微小差异可能会迅速改变,而当您阅读本书时,这个特定问题可能已经在基于Solaris的内核中得到解决。

虽然根据工作负载的不同,交付性能存在微小差异,但最大的差异可能是性能可观测性,特别是对动态跟踪的支持。如果一个内核支持您在生产环境中找到10倍以上的优势,那么早期发现的任何10%左右的差异都可能不那么重要。

观测工具将在下一章中介绍。

4 Observability Tools

操作系统在历史上为观察系统软件和硬件组件提供了许多工具。对于新手来说,各种可用的工具似乎可以观察到一切,或者至少可以观察到所有重要的东西。实际上,存在许多空白,并且系统性能专家擅长于推理和解释:从间接的工具和统计数据中找出活动情况。

例如,网络数据包可以逐个检查(嗅探),但磁盘I/O却不能(至少不容易)。相反,磁盘利用率(忙碌百分比)可以轻松地通过操作系统工具观察到,但网络接口利用率却不能。

随着追踪框架的添加,特别是动态追踪,现在可以观察到一切,并且几乎可以直接观察到任何活动。这对系统性能产生了深远的影响,使得可以创建数百种新的可观测性工具(潜在数量无限)。

本章介绍了操作系统可观测性工具的类型,包括关键示例以及构建它们的框架。重点是框架,包括/proc、kstat、/sys、DTrace和SystemTap。在后面的章节中,还介绍了使用这些框架的许多其他工具,包括第6章中的Linux性能事件(LPE)和CPU。

4.1 Tool Types

性能可观测工具可以分为提供系统范围或进程级可观测性的两种类型,并且大多数基于计数器或跟踪。这些属性如图4.1所示,同时还提供了工具示例。

有些工具适用于多个象限;例如,top(1)也具有系统范围的摘要,而DTrace也具有进程级的功能。

还有一些基于性能分析的工具。这些工具通过采集一系列快照来观察活动,可以是系统范围的或者进程级的。

以下几节将总结使用计数器、跟踪和性能分析的工具,以及执行监控的工具。

4.1.1 Counters

内核维护各种统计数据,称为计数器,用于计算事件数量。它们通常实现为无符号整数,在事件发生时递增。例如,有关接收的网络数据包数量、发出的磁盘I/O和执行的系统调用都有相应的计数器。

由于计数器默认启用并由内核持续维护,因此被认为是“免费”可用的。使用计数器时唯一的额外开销是从用户空间读取其值(这个开销应该是可以忽略不计的)。下面的示例工具可读取这些系统范围或进程级的计数器值。

系统范围的工具

这些工具使用内核计数器,在系统软件或硬件资源的环境下,检查系统范围的活动。示例包括:

- vmstat:虚拟和物理内存统计,系统范围的

- mpstat:每个CPU的使用情况

- iostat:每个磁盘的I/O使用情况,从块设备接口报告

- netstat:网络接口统计信息,TCP/IP堆栈统计信息和一些连接级别的统计信息

- sar:各种统计数据;也可以将其存档以备历史报告

这些工具通常可以由系统上的所有用户(非root用户)查看。它们的统计数据通常也由监控软件绘制成图形。

许多工具都遵循一个使用约定,可以接受可选的时间间隔和输出次数,例如,vmstat(8)可以设置为每秒采样一次,输出三次结果:

$ vmstat 1 3

procs -----------memory---------- ---swap-- -----io---- -system-- ----cpu----

r b swpd free buff cache si so bi bo in cs us sy id wa

4 0 0 34455620 111396 13438564 0 0 0 5 1 2 0 0 100 0

4 0 0 34458684 111396 13438588 0 0 0 0 2223 15198 13 11 76 0

4 0 0 34456468 111396 13438588 0 0 0 0 1940 15142 15 11 74 0输出的第一行是自启动以来的总结,显示系统运行时间内的平均值。随后的行是每秒钟的摘要,显示当前的活动情况。至少,这是意图:这个Linux版本在第一行中混合了自启动以来的总结和当前值。

进程级工具

这些工具是以进程为导向,使用内核为每个进程维护的计数器。示例包括:

- ps:进程状态,显示各种进程统计数据,包括内存和CPU使用情况。

- top:显示顶部进程,按某种统计数据(如CPU使用率)排序。Solaris系统提供了prstat(1M)来实现此目的。

- pmap:列出进程内存段和使用统计信息。

这些工具通常从/proc文件系统读取统计数据。

4.1.2 Tracing

跟踪收集每个事件的数据以进行分析。跟踪框架通常不会默认启用,因为跟踪会产生CPU开销来捕获数据,可能需要大量存储空间来保存数据。这些开销可能会减缓跟踪目标,并且在解释测量时间时需要考虑到它们。

日志记录,包括系统日志,可以视为默认启用的低频跟踪。日志包括每个事件的数据,尽管通常仅限于错误和警告等不经常发生的事件。

以下是系统范围和进程范围跟踪工具的示例。

系统范围

这些跟踪工具使用内核跟踪功能,在系统软件或硬件资源的上下文中检查系统范围的活动。示例包括:

- tcpdump:网络数据包跟踪(使用libpcap)

- snoop:适用于Solaris系统的网络数据包跟踪

- blktrace:块I/O跟踪(Linux)

- iosnoop:基于DTrace的块I/O跟踪

- execsnoop:新进程跟踪(基于DTrace)

- dtruss:系统范围的缓冲系统调用跟踪(基于DTrace)

- DTrace:使用静态和动态跟踪跟踪内核内部和任何资源(不仅限于网络或块I/O)

- SystemTap:使用静态和动态跟踪跟踪内核内部和任何资源

- perf:Linux性能事件,跟踪静态和动态探针

由于DTrace和SystemTap是编程环境,因此可以在它们之上构建系统范围的跟踪工具,包括此列表中包含的一些工具。本书中提供了更多示例。

进程级别

这些跟踪工具是面向进程的,就像它们所基于的操作系统框架一样。示例包括:

- strace:用于Linux系统的系统调用跟踪

- truss:用于Solaris系统的系统调用跟踪