不止检测,更能推理:解读Anomaly-OV如何革新零样本异常检测

在工业制造、医疗诊断等关键领域,视觉异常检测(Visual Anomaly Detection)扮演着“质量守门员”和“健康扫描仪”的重要角色。无论是生产线上的微小瑕疵,还是医学影像中的早期病灶,及时准确地发现它们都至关重要。然而,传统的异常检测方法通常依赖于“见过才认得”的监督学习模式,需要大量“正常”样本进行训练,这在数据隐私严格、样本采集成本高昂的现实场景中往往难以实现。

近年来,零样本异常检测(Zero-Shot Anomaly Detection, ZSAD)应运而生,它旨在让模型在不接触任何目标类别训练数据的情况下,直接识别异常。与此同时,以GPT-4o为代表的多模态大语言模型(MLLMs)在视觉理解和推理方面展现了惊人的能力。一个自然而然的想法是:我们能否利用MLLMs强大的通用能力来解决ZSAD问题?

然而,来自约翰霍普金斯大学和本田美国研究院的学者们发现,事情并非如此简单。尽管像GPT-4o这样的顶尖模型能够描述图像内容,但在识别和解释细微的、专业的视觉异常时,它们常常“视而不见”或“言之无物”。为了填补这一空白,他们提出了一个开创性的解决方案:一个名为 Anomaly-OneVision (Anomaly-OV) 的专业视觉助手,以及一套专门用于训练和评估此类模型的数据集Anomaly-Instruct-125k和基准VisA-D&R。这篇技术博客将深入解读这项工作,探讨它如何让MLLM不仅能“看见”异常,更能“理解”和“推理”异常。

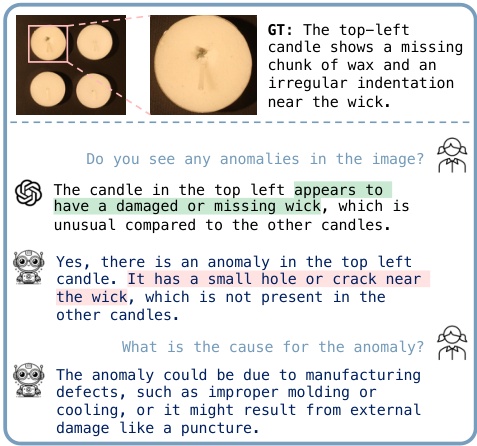

一、 核心困境:为何顶尖MLLM在异常检测上“翻车”?

在深入了解解决方案之前,我们必须先明确问题的根源。研究人员发现,当前最先进的MLLMs在处理异常检测任务时,存在两大核心挑战:

- 缺乏精细化感知能力:通用MLLMs虽然知识渊博,但它们的“视力”更偏向于宏观场景和常见对象的识别。对于工业零件上的一丝划痕、电路板上的一点焊锡过多,或是医学影像中微小的纹理变化,它们往往缺乏足够的敏感度。

- 推理与事实脱节:即便模型偶尔能正确判断图像存在异常(例如,回答“是”),但在被要求具体描述异常时,其解释往往是错误的或过于笼统,无法提供真正有价值的信息。

这种“看得见,但说不清”的现象,本质上源于两个“缺失”:

- 缺失专门的训练数据:现有的多模态指令微调数据集(如COCO、ShareGPT4V)主要关注通用场景的描述、问答和对话,几乎不包含针对异常检测和推理的细粒度标注。模型没有在“找茬”这个特定任务上受过专门训练。

- 缺失有效的评估基准:没有标准化的“考纲”,就无法系统地衡量和驱动模型在异常检测与推理能力上的进步。

正是为了解决这两个根本问题,研究团队首先着手构建了坚实的基础设施。

二、 奠定基石:Anomaly-Instruct-125k数据集与VisA-D&R基准

“工欲善其事,必先利其器”。为了让MLLM学会异常检测与推理,必须先为它提供高质量的“教材”和“考卷”。

2.1 Anomaly-Instruct-125k:首个大规模异常检测指令微调数据集

研究团队构建了首个为异常检测与推理量身定制的大规模视觉指令微调数据集——Anomaly-Instruct-125k。这个数据集的构建过程本身就充满了创新。

他们发现,直接让GPT-4o描述异常是行不通的。但如果给它一些“提示”,它的表现会判若两人。例如,在异常区域画一个红色的边界框,GPT-4o就能准确地描述出框内的微小气泡。这启发了一种新的数据标注流程:

- 利用现有标注生成“提示”:对于MVTec AD等已有分割掩码的异常检测数据集,自动在异常区域生成边界框。

- 结合提示生成高质量描述:将带有边界框的图像和类别、异常类型等文本提示一起输入给GPT-4o,引导其生成详尽、准确的图像和异常描述。

- 生成多轮对话:基于生成的高质量描述,利用类似LLaVA的上下文学习策略,自动生成包含“检测-描述-原因分析-改进建议”等多个层次的多轮对话数据。

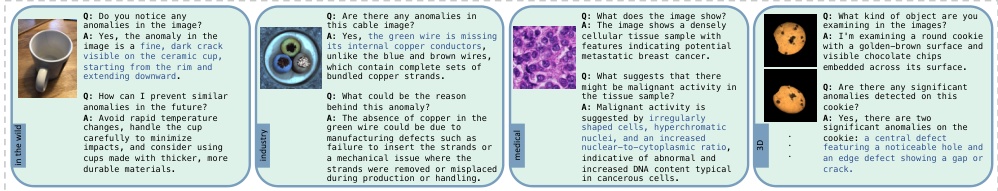

更值得一提的是,为了克服现有学术数据集规模和多样性的限制,团队设计了一个全自动的WebAD数据收集管道,从互联网上收集了7.2万张野外场景的异常图像,极大地丰富了数据集。该管道结合GPT-4o和谷歌图片搜索,实现了从“类别生成->关键词生成->图片搜索->数据清洗->自动标注”的全流程自动化。

2.2 VisA-D&R:一个全面的异常检测与推理评估基准

有了训练数据,还需要一个公正的评估标准。为此,团队基于经典的VisA工业异常检测数据集,通过更严格的人工审核和标注流程,构建了VisA-D&R基准。该基准不仅评估模型能否正确判断“有/无”异常,还从两个层面评估其推理能力:

- 低阶推理(Low-level Reasoning):评估模型描述视觉缺陷或异常的准确性。

- 高阶推理(Complex Reasoning):评估模型根据检测到的异常,推断潜在原因并提出改进建议的能力。

评估指标也相应地分为两类:使用准确率、精确率、召回率和F1分数来衡量检测性能;使用ROUGE-L、SBERT和GPT-Score(以GPT-4为裁判)来衡量推理质量。这套完善的评估体系为该领域未来的研究指明了方向。

三、 核心架构:专家引导的Anomaly-OV模型

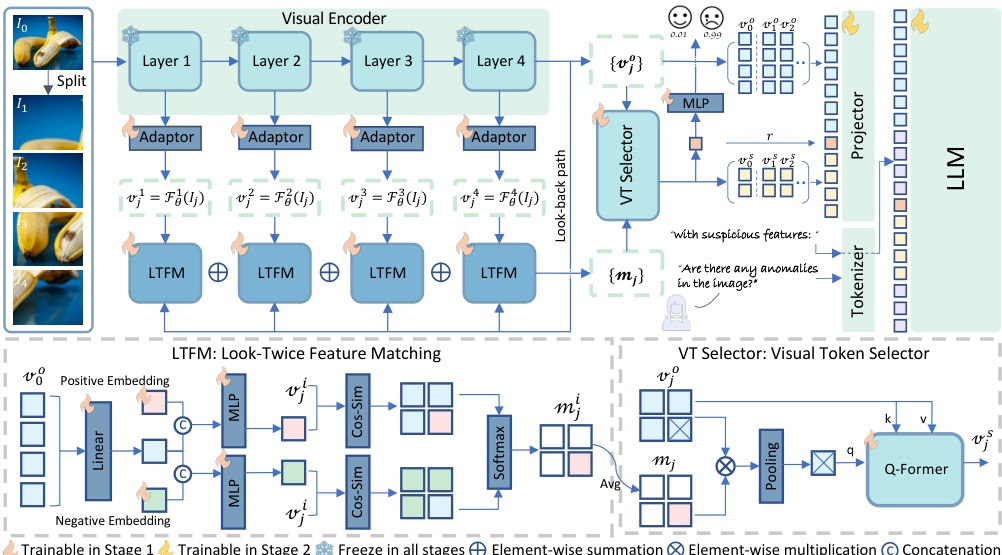

有了坚实的数据基础,接下来就是构建能够有效利用这些数据的模型——Anomaly-OV。其核心思想是:与其从头训练一个庞大的通用模型,不如在一个强大的通用MLLM(如LLaVA-OneVision)基础上,引入一个轻量级的“异常专家”模块,专门负责识别和定位可疑的视觉特征,然后将这些关键信息“喂”给大语言模型进行深入推理。

Anomaly-OV的架构精髓在于其“异常专家”的设计,该专家由两大核心组件构成:Look-Twice Feature Matching (LTFM) 和 Visual Token Selector (VT Selector)。

3.1 Look-Twice Feature Matching (LTFM):模拟人类的“二次审视”

人类在进行视觉检查时,通常会先快速扫视一遍,识别出可疑区域,然后再凑近仔细观察。LTFM机制正是模拟了这一行为。

它的工作流程可以分解为以下几步:

- 第一次审视(Look-Once):视觉编码器(如ViT)处理输入图像(包括其不同分辨率的切块),提取出多层次的视觉特征。

- 生成“异常模板”:利用原始图像的全局特征(

v_0^0),结合两个可学习的嵌入向量e+(代表异常模式)和e-(代表正常模式),动态地生成针对当前图像内容的“异常描述符”(d_i^+)和“正常描述符”(d_i^-)。这一步非常关键,它使得模型能够自适应地理解不同物体(如“胶囊”或“螺丝”)的异常模式,而无需像传统方法那样依赖手工设计的文本提示。 - 第二次审视(Look-Twice):将图像每个小块(patch)的特征与生成的“异常/正常描述符”进行余弦相似度比较,从而计算出一个显著性图(significance map)。这个图上的每个值都表示对应图像区域“有多么可疑”。

通过这种“二次审视”的方式,LTFM模块能够有效地将注意力聚焦到最可能存在异常的区域。

3.2 Visual Token Selector (VT Selector):为LLM“划重点”

一张高分辨率图像会产生数千个视觉令牌(visual tokens),如果将它们全部输入给LLM,不仅计算量巨大,而且大量无关信息会淹没掉关键的异常信号。VT Selector的作用就是充当一个“重点整理器”。

它利用LTFM生成的显著性图作为权重,对原始的视觉令牌进行加权。然后,通过一个Q-Former模块,将这些加权后的、高度可疑的令牌聚合成一小组精华令牌(v_j^s)。

最后,在将信息传递给LLM时,模型采用了一种巧妙的提示工程技巧。它会将原始的全部视觉令牌和经过筛选的“可疑”令牌串联起来,并在两者之间插入一个特殊的提示,如 highly suspicious feature:。这相当于明确地告诉LLM:“前面的内容是整体描述,接下来这些是我帮你划的重点,请特别关注!”

通过这种“专家指导”的模式,Anomaly-OV成功地将异常检测的精细感知能力与LLM的强大推理能力结合起来,实现了1+1>2的效果。

四、 实验结果:眼见为实的卓越性能

Anomaly-OV的性能究竟如何?研究团队在多个维度上进行了详尽的实验,结果令人印象深刻。

4.1 零样本异常检测(ZSAD)性能

首先,在传统的ZSAD任务上(只评估“异常专家”模块的性能),Anomaly-OV在MVTec AD、VisA等9个主流工业和医疗数据集上,其图像级AUROC指标全面超越了现有的SOTA方法。

值得注意的是,Anomaly-OV在取得SOTA性能的同时,移除了传统ZSAD方法中广泛使用的文本编码器,证明了仅通过视觉特征和巧妙的自匹配机制,就能学习到泛化能力很强的异常/正常模式。这主要归功于大规模、高多样性的WebAD数据集的引入。

4.2 基于文本的检测与推理性能

在更具挑战性的VisA-D&R基准上,Anomaly-OV(特别是7B版本)的表现同样出色。它在文本驱动的异常检测任务中,准确率和F1分数均大幅领先于其他开源MLLMs,并且在推理能力上与强大的闭源模型GPT-4o不相上下,甚至在某些方面更优。

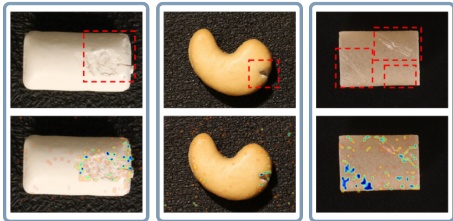

从上图可以看出,大多数通用MLLM在召回率(Recall)上表现不佳,这意味着它们对异常“不敏感”,容易漏报。而Anomaly-OV通过其“异常专家”模块,显著提升了对异常的敏感度,实现了更均衡的精确率和召回率。

定性分析的结果更加直观地展示了Anomaly-OV的优势:

| 场景:PCB板上焊锡过多 | 模型回答 |

|---|---|

| GPT-4o | 图像显示了一个HC-SR04超声波传感器。传感器本身似乎没有任何可见的异常。 |

| LLaVA-OV (基座模型) | 图像显示了一个超声波传感器模块... 图像中没有可见的异常。 |

| Anomaly-OV (Ours) | 是的,图像中有一个明显的异常:PCB上的短路,表现为'Echo'引脚附近的白色结壳残留物。 |

| 场景:通心粉上有黄色斑点 | 模型回答 |

|---|---|

| GPT-4o | 图像显示了四块肘形通心粉... 异常是通心粉不是完整的;它们被切成两半。 |

| LLaVA-OV (基座模型) | 图像显示了四块通心粉... 它们颜色和形状均匀,没有可见的缺陷或异常。 |

| Anomaly-OV (Ours) | 是的,图像中存在异常。右下角的那块通心粉表面有一个明显的黄色变色。 |

这些例子生动地说明,Anomaly-OV不仅能做出正确的判断,更能提供精准、可靠的异常描述,这对于实际应用至关重要。

五、 拓展、局限与未来展望

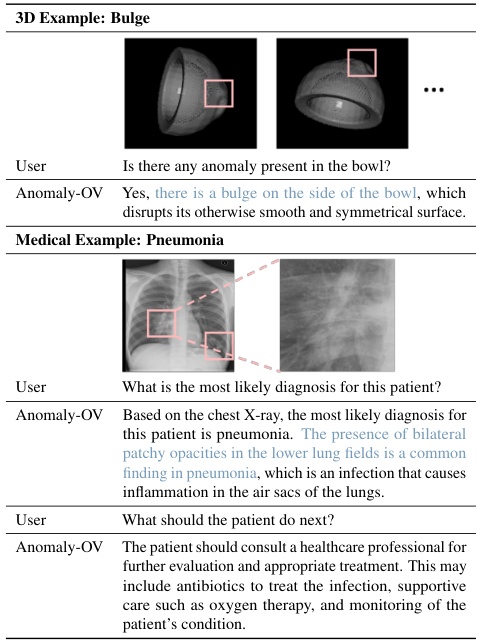

这项工作的意义不止于工业领域。研究团队还展示了Anomaly-OV在3D点云和医疗影像异常检测与推理任务上的潜力,证明了其作为统一视觉检查助手的可行性。

当然,研究也坦诚地指出了模型的局限性:

- 模型偶尔会错误地识别物体类别,或用一个笼统的词来描述异常(如将“蜡缺失”描述为“裂纹”)。

- 与所有LLM一样,它有时会产生幻觉。

- 模型的整体检测性能受限于其“异常专家”模块的能力上限。

针对这些局限,论文也为未来工作指明了方向:

- 设计更强大的“异常专家”模型。

- 构建更多样化的工业异常数据集,以提升模型对未知异常类型的泛化能力。

- 探索将视觉编码器的底层特征更直接地融入LLM的方法,因为异常检测高度依赖低级视觉线索。

六、 总结与启示

《Towards Zero-Shot Anomaly Detection and Reasoning with Multimodal Large Language Models》这篇论文为我们描绘了下一代智能视觉检测系统的蓝图。它通过三大核心贡献——专门的指令数据集Anomaly-Instruct-125k、全面的评估基准VisA-D&R以及创新的专家引导模型Anomaly-OV,成功地将MLLM的能力从宏观的场景理解,拓展到了微观的、专业的异常检测与推理领域。

这项工作最重要的启示在于,它证明了“通用大模型 + 领域专家模块 + 高质量指令数据”是解决专业领域问题的有效范式。它不仅仅是让AI学会了“找茬”,更是推动AI从一个简单的“检测器”向一个能够提供深刻洞察和解决方案的“智能分析师”转变。随着技术的不断演进,我们有理由相信,像Anomaly-OV这样的专业视觉助手,将在未来的智能制造、智慧医疗等领域发挥不可估量的价值。

对该研究感兴趣的读者,可以访问项目主页获取更多信息和论文原文:

Anomaly-OV Project Page