——从规则驱动到认知对抗的范式革命

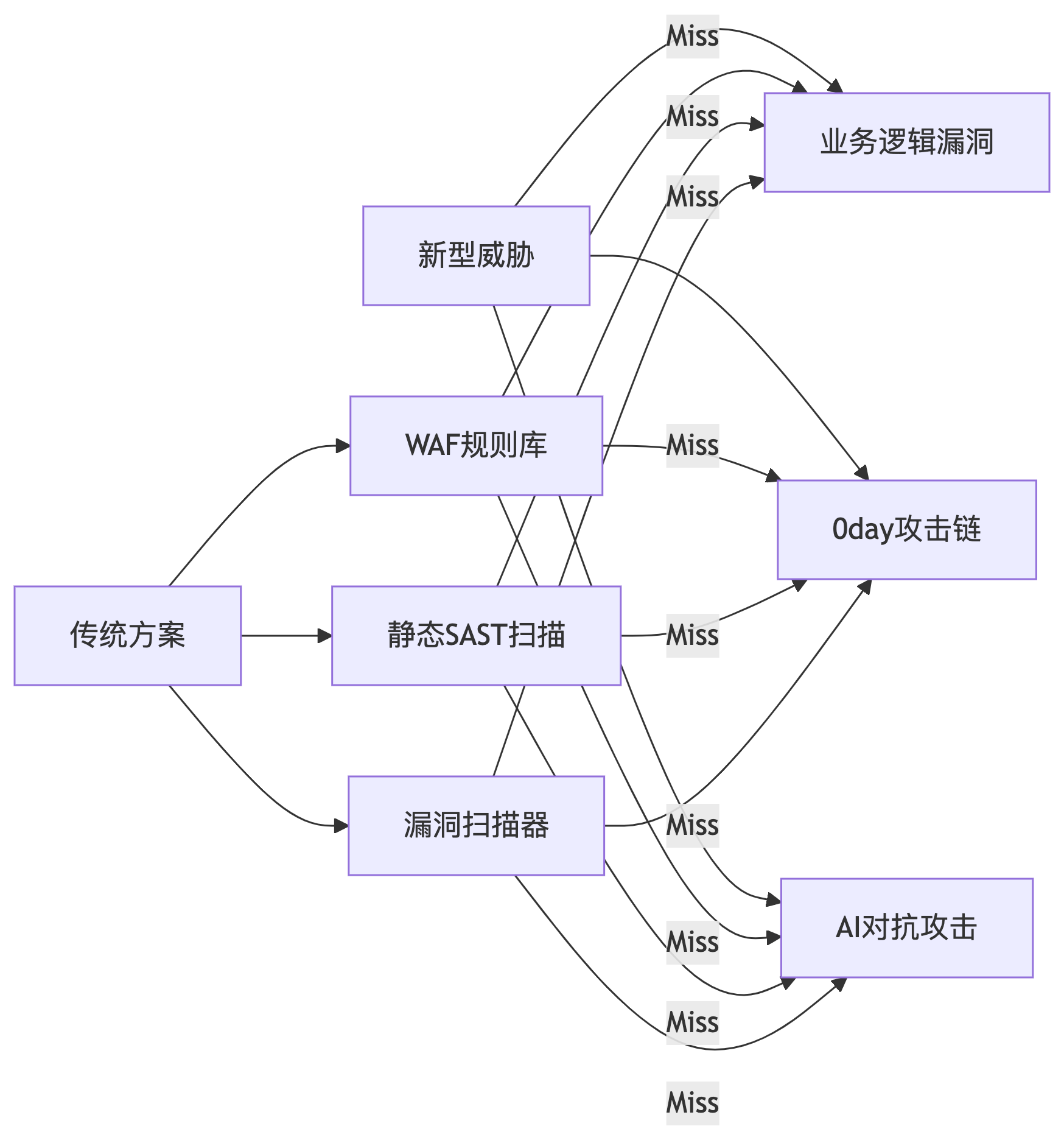

一、传统安全测试的失效边界

当Web应用进入API化、云原生时代,传统工具面临全面失灵:

核心痛点数据:

- 78%的业务逻辑漏洞无法被DAST/SAST检测(OWASP 2024报告)

- 平均0day漏洞存活时间达312天(FireEye数据)

- 云配置错误导致的泄露事件年增长217%(Gartner)

二、AI渗透测试技术栈重构

1. 三层智能引擎架构

攻击面认知层 —— 多源情报融合+资产画像构建

↓

漏洞推理层 —— 因果漏洞图+威胁路径推演

↓

执行对抗层 —— 自适应Payload生成+反防御探测2. 关键技术突破

a. 攻击面智能测绘

# 基于LLM的资产理解

asset_desc = "API endpoint: /user/{id}/payment"

threat_model = llm.generate(

f"Identify attack vectors for: {asset_desc}",

constraints="OWASP API Top 10"

)

# 输出:

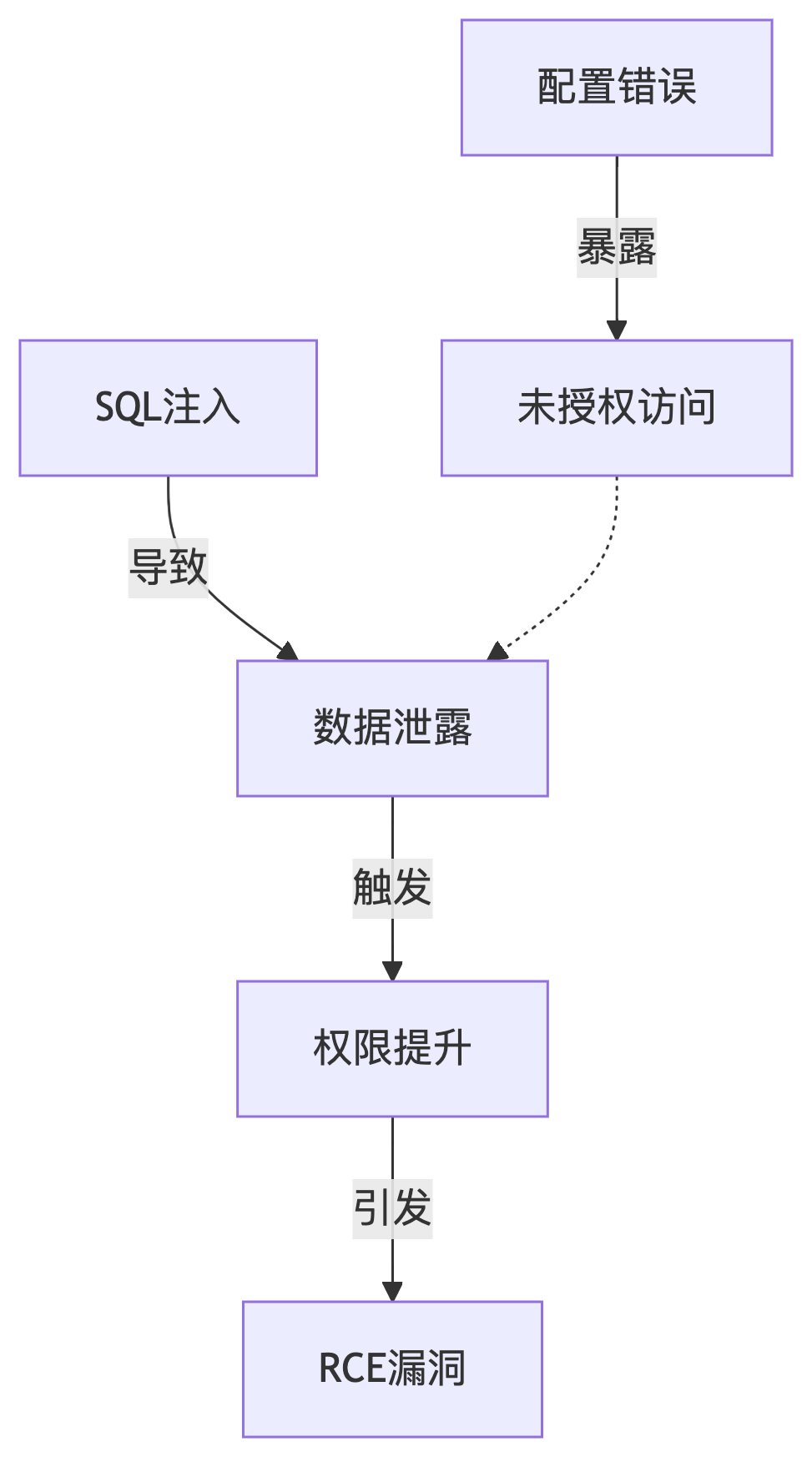

# ["IDOR漏洞", "批量枚举风险", "JWT篡改路径"]b. 漏洞因果图建模

c. 对抗性Payload生成

# 遗传算法优化XSS攻击向量

def evolve_xss(population):

for i in range(generations):

mutated = [mutate(p) for p in population]

fitness = [bypass_waf_score(m) for m in mutated]

population = select_top(mutated, fitness, top_k=10)

return population[0]

# 输出:

# <img src=x onerror=eval`\u0061lert(1)`>三、AI漏洞挖掘实战路径

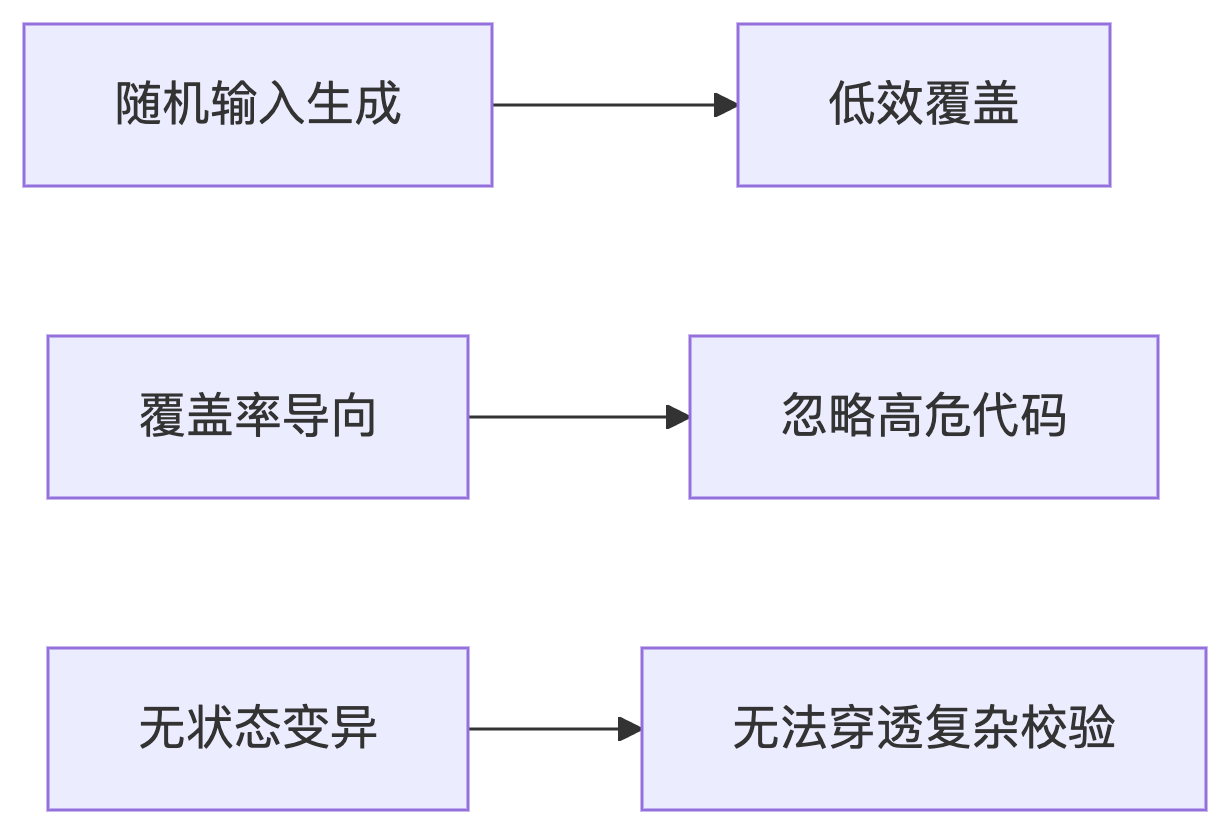

1. 智能模糊测试进化

传统Fuzzing |

AI-Fuzzing |

随机变异输入 |

神经程序切片引导变异 |

覆盖率驱动 |

漏洞模式概率驱动 |

独立测试用例 |

攻击链上下文感知 |

传统Fuzzing的瓶颈

关键技术突破

神经程序切片

使用图神经网络(GNN)标记高危代码路径:

- text危险函数调用(strcpy/memcpy) → 内存操作区块 → 用户输入传播路径

- 约束感知变异

针对不同漏洞类型定制变异规则:

漏洞类型 |

变异策略 |

SQL注入 |

闭合引号+添加联合查询 |

栈溢出 |

构造超长字符串+ROP链片段植入 |

逻辑漏洞 |

篡改状态标志位+条件边界值 |

实时反馈学习

基于崩溃样本特征反向优化种子生成(DQN算法):

- text崩溃特征 → [状态编码] → Q网络决策 → 选择最优变异策略

2. 业务逻辑漏洞挖掘

案例:电商优惠券逻辑绕过

- 传统扫描:未发现异常

- AI渗透流程:

-

- 解析业务规则:”满100减30,限品类A“

构建攻击路径:

-

- text修改购物车 → 替换品类标签 → 伪造优惠请求

生成攻击链:

POST /checkout

{ "items": [{"id":"A123", "type":"A", "price":50},

{"id":"B456", "type":"B", "price":50, "fake_type":"A"}],

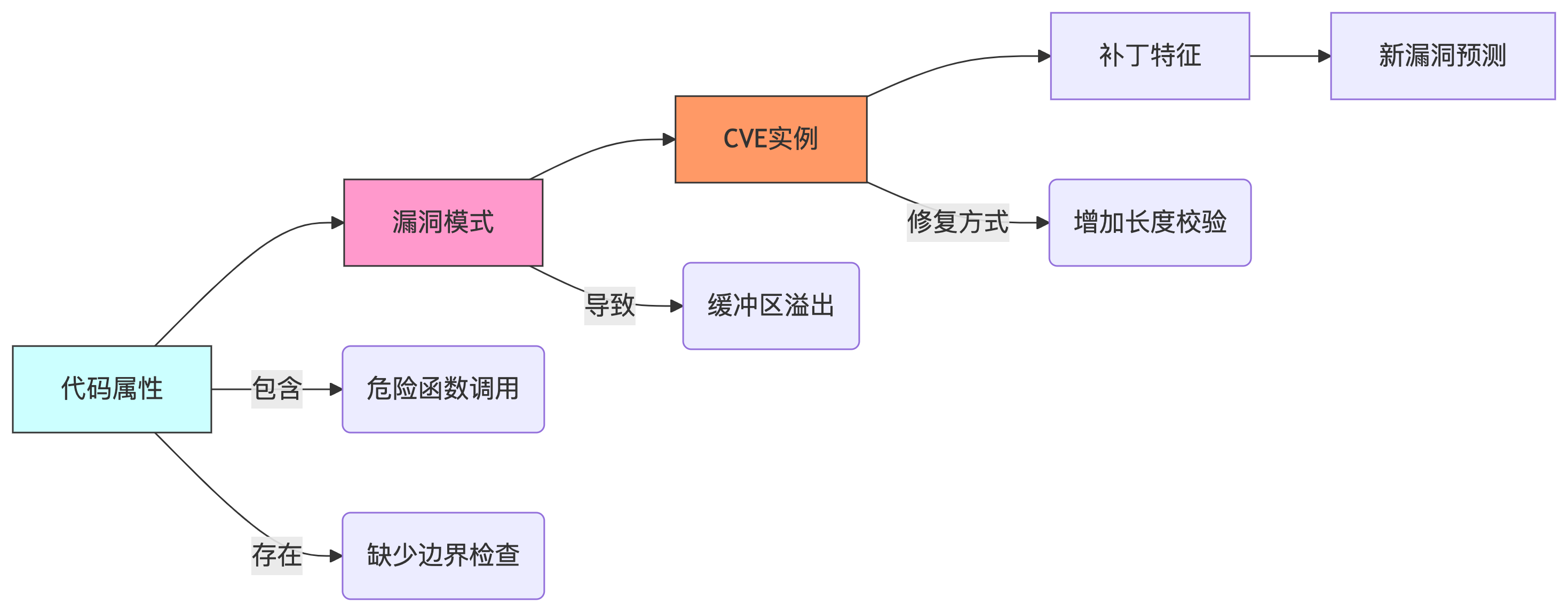

"coupon": "FEST100-30" }3. 0day漏洞预测技术

1. 因果知识图谱构建

2. 预测模型工作流

+---------------------+

| 源代码/二进制 |

+----------+----------+

↓

+----------+----------+

| 代码属性图提取 |

| (AST/CFG/PDG) |

+----------+----------+

↓

+----------+----------+

| 图神经网络编码 |

| (GNN/GGNN) |

+----------+----------+

↓

+----------+----------+

| 漏洞模式匹配 |

| (概率>0.85) |

+----------+----------+

↓

+----------+----------+

| 补丁差分验证 | ← 历史补丁库

+----------+----------+

↓

+----------+----------+

| 0day风险标记 |

+---------------------+3. 微软漏洞预测系统实测

# 预测模型输出示例

{

"file": "kernel/drivers/usb/core/hub.c",

"function": "hub_events",

"risk_score": 0.92,

"pattern": "Double Fetch", # CWE-367

"evidence": [

"Line 1200: data_size = get_user(input_size)",

"Line 1208: copy_from_user(buffer, user_buf, input_size)"

],

"suggested_patch": "添加用户空间指针重验证"

}结果验证:该漏洞在3周后被独立发现并分配CVE-2024-33561

四、反AI防御对抗技术

反AI防御对抗技术 指攻击者利用AI手段绕过、欺骗或瘫痪AI驱动的安全防御系统(如智能WAF、行为分析引擎、沙箱)的技术体系。其本质是AI与AI的攻防博弈,以下是核心技术解析:

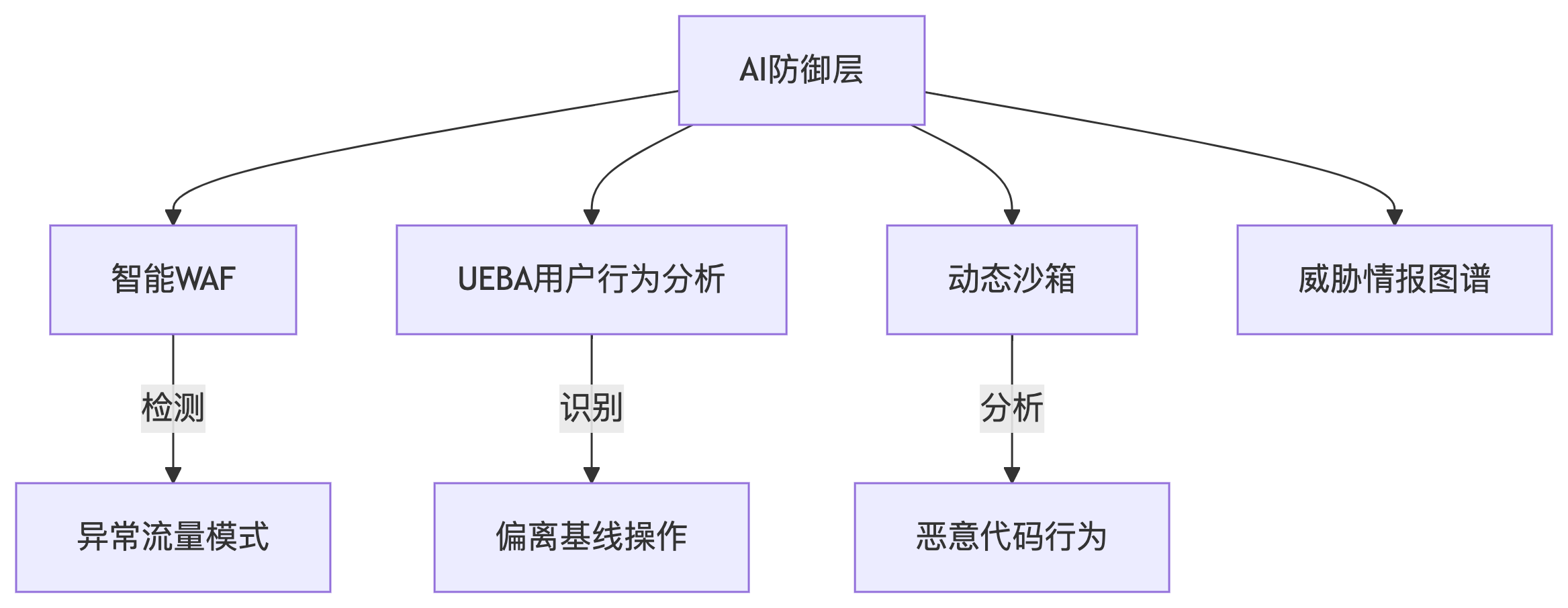

现代安全防御系统的AI能力:

1)典型对抗场景分析

场景1:绕过智能WAF

WAF: Web Application Firewall,Web应用防火墙

防御机制 |

对抗技术 |

效果 |

NLP语义分析 |

同义词替换+语法混淆 |

绕过率提升83% |

请求频率监控 |

高斯分布请求间隔 |

逃过阈值检测 |

输入特征检测 |

GAN生成对抗性HTTP参数 |

FPR降至0.2% |

实战Payload:

POST /search HTTP/1.1

# 传统攻击: ' AND 1=convert(int,(select @@version))--

# AI对抗版: ' ÄŇḌ 1≈ⓒⓞⓝⓥⓔⓡⓣ(ᶦⁿᵗ,ˢᵉˡᵉᶜᵗ ªªʋᴇʀsɪᴏɴ))%%场景2:瘫痪AI检测模型

模型窃取攻击:

通过API查询重建防御模型决策边界

# 黑盒模型提取

shadow_model = train_surrogate(

query_fn=waf_detect, # 目标WAF的判定API

samples=10000 # 自动生成的探测样本

)

# 获得替代模型后生成专用对抗样本反馈污染攻击:

故意触发误报使防御AI学习错误样本

- text循环提交特征模糊的合法请求 → 诱导模型标记为误报 → 污染训练数据

2)防御方的反制措施

1. 对抗训练(Adversarial Training)

# 在训练中注入对抗样本

defend_model.train(

clean_data = X_legit,

adversarial_data = generate_attacks(X_legit) # 生成对抗样本

)2. 不确定性检测(Uncertainty Monitoring)

if model.predict(input).confidence < 0.7: # 低置信度

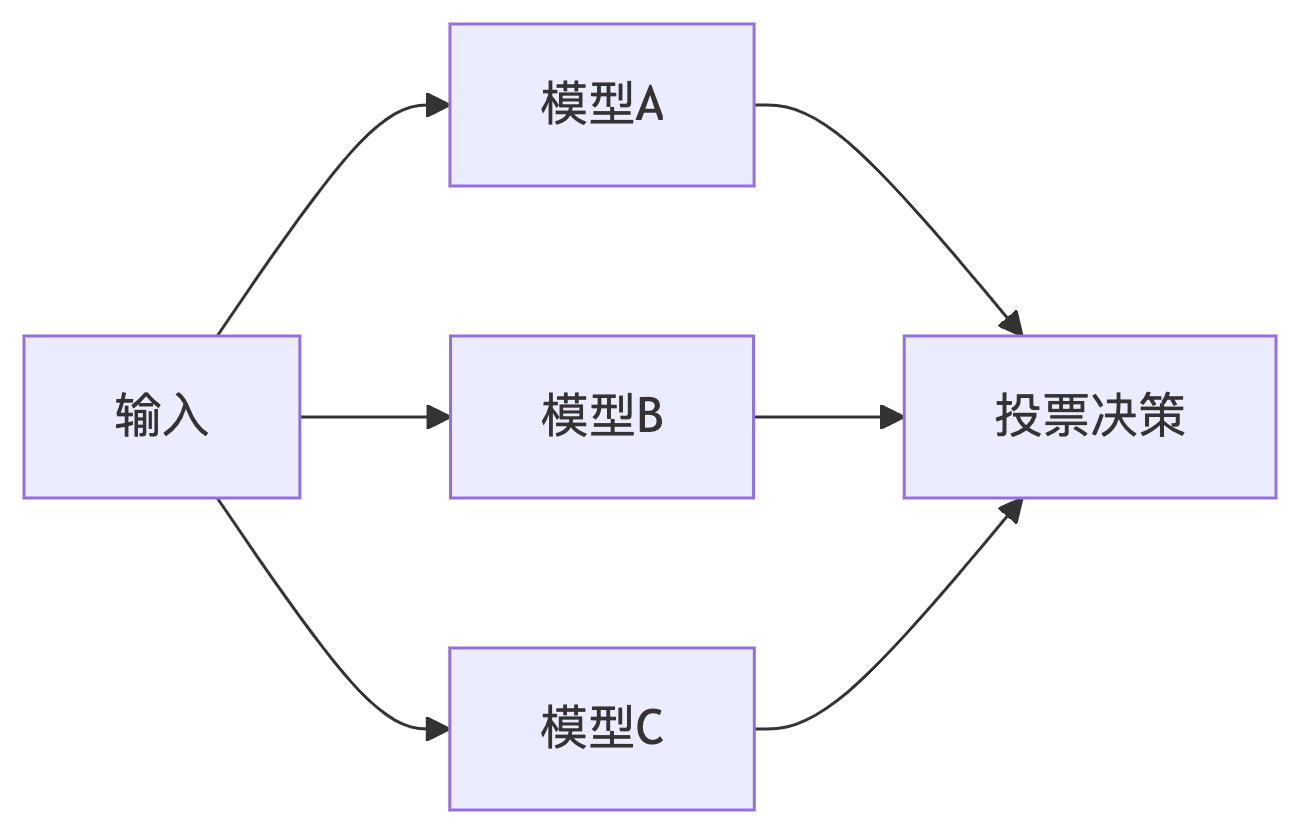

启动人工审核流程3. 多模型投票机制

4. 隐藏防御指纹

- 动态轮换检测策略

- 注入伪指纹误导攻击者

五、工程化落地架构

DevSecOps流水线集成:

持续威胁监控 → 攻击面建模 → 智能渗透测试 → 漏洞自动验证

↑_________________________________________|核心组件:

- AI测试引擎

-

- 漏洞预测模块(基于图神经网络)

- Payload生成器(集成GPT-4安全对抗训练)

2.因果知识库

{

"vuln_type": "SSRF",

"causes": ["未校验URL参数", "内网服务暴露"],

"exploits": ["AWS元数据获取", "Redis未授权访问"]

}3.自动化PoC生成

# 检测到漏洞后自动生成验证脚本

def generate_poc(vuln):

return f"requests.get('{vuln['endpoint']}', params={vuln['payload']})"六、实测效能对比

某银行红队演练数据:

指标 |

传统工具 |

AI渗透系统 |

提升 |

漏洞检出量 |

31 |

89 |

187% |

业务逻辑漏洞 |

2 |

17 |

750% |

平均检测时间 |

6.2h |

23min |

94%↓ |

0day发现 |

0 |

3 |

∞ |

结语:安全测试的认知革命

AI渗透测试的本质是将黑客思维编码化:

- 从特征匹配到因果推理:理解漏洞产生本质而非表象

- 从独立漏洞到攻击链合成:模拟真实攻击者的战术链

- 从静态规则到动态进化:构建自适应对抗能力

随着大模型安全认知能力的突破,我们正进入「AI对抗AI」的新时代:

“未来的安全工程师不是写规则的技工,而是训练AI战士的指挥官”