介绍

欢迎来到 🤗教程!

本课程将使用 Hugging Face生态系统中的库(🤗 Transformers、🤗 Datasets、🤗 Tokenizers和🤗 Accelerate 以及 Hugging Face Hub )向您介绍 自然语言处理 (NLP,natural language processing) 。它是完全免费的,没有广告。

将会有什么呢?

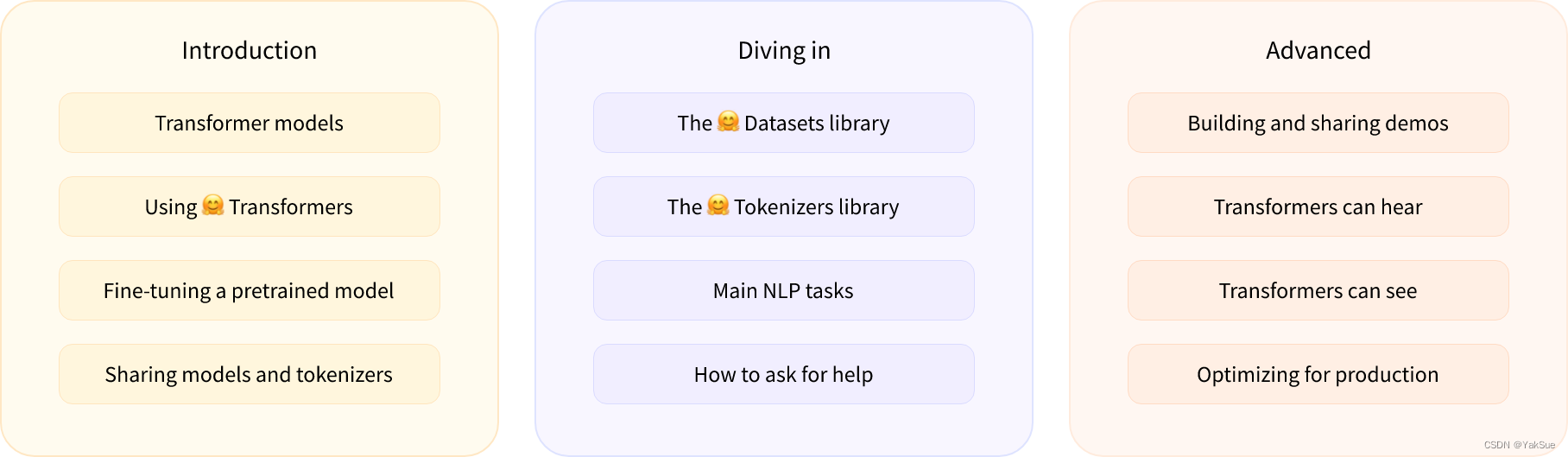

以下是课程的简要概述:

- 第 1 章到第 4 章介绍了🤗 Transformers 库的主要概念。在这部分课程结束时,您将熟悉 Transformer 模型的工作原理,并知道如何使用 Hugging Face Hub 中的模型,在数据集上对其进行微调,并在 Hub 上分享您的结果!

- 第 5 章到第 8 章讲解了 🤗 Datasets 和 🤗 Tokenizers 的基础知识,然后再深入研究经典的 NLP 任务。在这部分结束时,您将能够自己解决最常见的 NLP 问题。

- 第 9 章到第 12 章超出了 NLP 的范围,探讨了如何使用 Transformer 模型处理 演讲 和 计算机视觉 中的任务。在此过程中,您将学习如何为你的模型构建demo并共享它,并针对生产环境对其进行优化。在这部分结束时,您将准备好将🤗 Transformers 应用于(几乎)任何机器学习问题!

这个课程:

- 需要良好的 Python 知识

- 最好在入门深度学习课程之后学习,例如 fast.ai 的 Practical Deep Learning for Coders 或 DeepLearning.AI 所开发的程序。

- 不要求预先的 PyTorch 和 TensorFlow 知识(但熟悉它们会有所帮助)

完成本课程后,我们建议您看 DeepLearning.AI 的 Natural Language Processing Specialization,它涵盖了广泛的传统 NLP 模型,如 naive Bayes 和 LSTM,它们都非常值得了解!

我们是谁

关于作者:

Abubakar Abid在斯坦福大学完成了应用机器学习的博士学位。在攻读博士学位期间,他创立了Gradio,这是一个开源 Python 库,已有超过 600,000 个机器学习demo用它构建。Gradio 已被 Hugging Face 收购,Abubakar 现在担任机器学习团队的负责人。

Matthew Carrigan是 Hugging Face 的机器学习工程师。他住在爱尔兰都柏林,之前曾在 Parse.ly 担任 ML 工程师,在此之前曾在 Trinity College Dublin 担任博士后研究员。他不相信我们会通过扩展现有架构来实现 AGI,但却对机器人的不朽寄予厚望。

Lysandre Debut是 Hugging Face 的机器学习工程师,从早期开发阶段就一直致力于 🤗 Transformers 库。他的目标是通过使用非常简单的 API 开发工具,让每个人都可以使用 NLP。

Sylvain Gugger是 Hugging Face 的研究工程师,也是🤗 Transformers 库的核心维护者之一。此前,他是 fast.ai 的一名研究科学家,他与 Jeremy Howard 合作编写了 《Deep Learning for Coders with fastai and PyTorch》。他的主要研究重点是通过设计和改进允许模型在有限资源上快速训练的技术,使深度学习更容易落地。

Dawood Khan是 Hugging Face 的机器学习工程师。他来自纽约市,毕业于纽约大学计算机科学专业。在担任了几年的 iOS 工程师之后,Dawood 辞职并与其他联合创始人一起创办了 Gradio。Gradio 最终被 Hugging Face 收购。

Merve Noyan是 Hugging Face 开发的拥护者,致力于开发工具并围绕它们构建内容,以使机器学习民用化。

Lucile Saulnier是 Hugging Face 的机器学习工程师,负责开发和支持开源工具的使用。她还积极参与了NLP领域的许多研究项目,例如 collaborative training 和 BigScience。

Lewis Tunstall 是 Hugging Face 的机器学习工程师,专注于开发开源工具并让更广泛的社区可以访问它们。他还是 O’Reilly 书籍《Natural Language Processing with Transformers》的合著者。

Leandro von Werra是 Hugging Face 开源团队的一名机器学习工程师,也是 O’Reilly 书籍《Natural Language Processing with Transformers》 的合著者。他拥有多年的机器学习的全栈工作并将 NLP 项目投入生产的经验。

本章内容

在本章中,您将学习:

- 如何使用

pipeline()函数解决“文本生成”和“分类”等 NLP 任务 - 关于 Transformer 的架构

- 如何区分encoder、decoder 和 encoder-decoder 的架构和用例