☁️《深度解构现代云原生微服务架构的七大支柱》

一线架构师实战总结,系统性拆解现代微服务架构中最核心的 7 大支柱模块,涵盖通信协议、容器编排、服务网格、弹性伸缩、安全治理、可观测性、CI/CD 等。文内附架构图、实操路径与真实案例,适合 DevOps 工程师、后端中高级开发、云原生平台建设人员阅读与参考。

🧠 第一章:引言——微服务时代,为何我们不能“继续炒大锅饭”?

在现代企业软件系统架构演进的路上,从**单体架构(Monolith)走向微服务(Microservices)**已经成为行业共识。

但你是否遇到过:

- 服务拆了十几个,接口像八爪鱼,维护成本反而更高?

- 想引入服务网格,结果连部署都卡在 YAML 地狱?

- 明明已经用上了 Kubernetes,系统弹性却比不上以前裸机?

如果你有以上困扰,那这篇文章正是为你准备的。

📌 什么是微服务架构的“支柱”?

我们将用“七大支柱”模型,把复杂的微服务体系拆解为七个关键结构层面,如下图:

+------------------------------+

| CI/CD 与自动运维 |

+------------------------------+

| 可观测性与故障排查 |

+------------------------------+

| 服务网格与安全治理 |

+------------------------------+

| 容器化部署与弹性伸缩 |

+------------------------------+

| 配置管理 & 注册中心 |

+------------------------------+

| 通信协议 & 接口标准化 |

+------------------------------+

| 服务拆分与边界设计(DDD) |

+------------------------------+

每一层都不独立存在,它们层层递进,相互依赖。

很多团队失败不是技术不行,而是忽视了其中某一层的稳定性,导致整体“架构楼房”坍塌。

🎯 为什么值得深挖这七层?

- 选型混乱是常态:Spring Cloud vs Dubbo?Nacos vs Consul?你了解它们真正的边界吗?

- 云原生趋势不可逆:Kubernetes + DevOps 不是“是否做”,而是“何时做 + 怎么做”。

- 高可用是业务基础设施:宕机一次,可能就是用户一整年的流失。

如果你是:

- 架构师 / DevOps 负责人,希望构建企业级云原生平台;

- 后端开发工程师,想掌握下一阶段进阶核心;

- 技术团队 leader,正在带领团队服务拆分 / 重构;

👉 那么这篇文章将为你建立系统性认知图谱 + 提供实战经验提炼。

☁️《深度解构现代云原生微服务架构的七大支柱》

一线架构师实战总结,系统性拆解现代微服务架构中最核心的 7 大支柱模块,涵盖通信协议、容器编排、服务网格、弹性伸缩、安全治理、可观测性、CI/CD 等。文内附架构图、实操路径与真实案例,适合 DevOps 工程师、后端中高级开发、云原生平台建设人员阅读与参考。

🧱 第二章:服务拆分与边界设计——从大粽子到精致拼盘的第一刀

🤔 为什么拆分是第一难题?

很多团队做微服务的第一步是“拆分”,但恰恰这里最容易出错。

拆得太细:每个服务都像“独立星球”,调用如银河系穿梭,性能雪崩;

拆得太粗:本质仍是“伪单体”,部署看起来分了,其实内部全耦合。

因此,“服务边界”就是一把技术与业务交汇的刻刀,既要逻辑独立,也要协同流畅。

🧭 拆分的三大原则:

- 业务导向优先:优先按业务领域拆分,而非代码结构;

- 数据隔离:每个服务拥有自己的数据存储,禁止跨库 JOIN;

- 高内聚低耦合:服务内部操作强相关,外部只暴露必要 API。

🧠 引入 DDD(领域驱动设计)划分边界

DDD 是微服务边界设计的最佳拍档。它提供了“从业务到代码”的映射机制:

| 概念 | 作用 |

|---|---|

| 领域(Domain) | 描述业务范畴,如“订单”、“支付” |

| 子域(Subdomain) | 将大领域再细分,比如“优惠策略”、“积分兑换” |

| 聚合(Aggregate) | 一个操作的最小一致性单元,决定数据库事务范围 |

| 限界上下文(BC) | 明确边界、协议与集成方式,是服务拆分的基本单位 |

📌 BC(限界上下文) = 微服务天然候选者

📦 拆分模型举例:

以“商城系统”为例,DDD 推荐划分为如下子服务:

| 微服务 | 对应领域 | 边界说明 |

|---|---|---|

| 用户服务 | 用户信息、登录认证 | 限界上下文:账号、权限、Session |

| 商品服务 | 商品信息管理 | 限界上下文:分类、规格、上下架 |

| 订单服务 | 下单、取消、状态流转 | 限界上下文:订单生命周期 |

| 支付服务 | 支付发起、回调、记录 | 限界上下文:支付渠道、账单核对 |

| 库存服务 | 库存扣减、预占、释放 | 限界上下文:库存一致性与商品无关 |

| 营销活动服务 | 优惠券、满减、限时折扣 | 限界上下文:规则引擎、叠加策略 |

| 商品推荐服务 | 推荐算法、热销榜 | 限界上下文:行为日志、机器学习模型 |

🪓 拆分实战经验技巧

- ✅ 从最稳定的领域先拆:如“用户服务”“商品服务”常规业务形态稳定;

- ✅ 先拆读多写少的服务:因为写服务涉及一致性更难;

- ✅ 别为了拆而拆:能独立部署、独立扩容、有明确团队归属才值得拆;

💥 拆分过度的警告信号:

- RPC 比业务代码还多;

- 每上线一个功能改了 5 个服务;

- 整个系统像“一锅烂粽子”,哪都能连、哪都能炸;

此时建议反思是否应该“合并聚合”或“用网关聚合调用”,避免被“服务爆炸”反噬。

🧑💻 工程实战建议:

- 使用EventStorming(事件风暴)辅助梳理领域;

- 在设计 API 前,先用上下文地图绘制 BC 关系图;

- 使用 Swagger/OpenAPI 管理服务接口,避免“文档错位”;

- 每个微服务代码仓库需独立,使用 GitLab CI / Jenkins 各自构建流程。

📌 本章小结:

服务拆分是迈向微服务的第一步,也可能是第一坑。

结合业务理解,用 DDD 工具拆分限界上下文,将服务做得“既能独立包粽子,又能团体配合出锅”,才是高质量微服务的起点!

🔗 第三章:通信协议与接口标准化设计——让粽子之间“说得清,配得上”

🚦 为什么通信标准决定系统的上限?

在微服务架构中,一个最容易被忽视的问题是:服务之间靠什么通信?能不能说人话?

没有规范的通信协议和接口管理,你的系统就像一锅“无序拼盘”,服务彼此听不懂,数据时常丢包。

微服务拆分之后,接口调用频次激增,一旦标准混乱,就会出现:

- 服务间强依赖,改一个接口牵一发而动全身;

- 开发协作困难,A组改了协议 B组部署不了;

- 升级困难,每次发布都像手动解粽叶。

🧭 通信方式选型:同步 vs 异步

| 类型 | 协议/机制 | 适合场景 | 举例 |

|---|---|---|---|

| 同步通信 | HTTP/REST、gRPC | 请求响应明确、依赖强耦合场景 | 下单→支付、查询接口 |

| 异步通信 | 消息队列(MQ) | 解耦、削峰填谷、弱一致性场景 | 下单→发优惠券、日志落盘 |

📌 实战建议:核心链路选同步,辅助链路用异步。千万不要反过来,否则“关键粽子靠预约消息,用户饿死还没响应”。

📡 通信协议对比:REST / gRPC / GraphQL

| 协议 | 优点 | 缺点 |

|---|---|---|

| REST API | 简单通用,浏览器友好,社区生态成熟 | 不适合高频通信,接口颗粒度易不清晰 |

| gRPC | 高性能、跨语言、强类型校验、支持流式通信 | 调试复杂,浏览器端支持差,需要IDL(如proto) |

| GraphQL | 客户端灵活查询,接口聚合优雅 | 查询逻辑复杂,安全治理成本高,缓存困难 |

🧠 小结:推荐 REST + gRPC 混合部署,外部接口暴露 REST,内部微服务通信走 gRPC,兼顾兼容性与性能。

📦 接口管理实践:Swagger / OpenAPI / Postman

微服务多了之后,最重要的是:接口文档不能靠口口相传!

- 使用 Swagger 自动生成接口说明 + 示例请求;

- 接口定义遵循 OpenAPI 规范,支持多人协作;

- 引入 Postman Collection,做回归测试与多环境验证;

📌 一句话:写得清、调得通、测得准、传得出,才是真正合格的接口。

🧯 接口治理策略(防止“粽叶互卷”)

- 版本控制:/api/v1/user,/api/v2/user;

- 字段兼容:新字段默认 null,不要强依赖;

- 向后兼容性保障:使用 API 网关做协议转换;

- 接口变更广播机制:使用 Webhook 或协作平台自动通知;

🔐 安全性设计:认证 + 授权 + 限速

- 使用 OAuth2 / JWT 实现 Token 鉴权;

- 接口分级管理:内部接口、外部接口、特权接口不同策略;

- 限速与熔断配置(如 Sentinel),防止滥用调用“粽锅炸锅”;

🧑💻 工程建议与踩坑经验

- REST 接口参数建议使用对象包裹,避免“query 啰嗦到过年”;

- gRPC 中 proto 文件与接口代码严格版本控制,CI检查同步;

- 避免接口设计“返回值含业务状态 + 状态码 + 枚举 + message + hint”,保持一致性;

- 给接口打“使用频率热力图”,评估演进风险优先级。

📌 本章小结:

没有标准的通信协议和接口规范,微服务就像“各说各话的包粽大会”,结果必然混乱。

真正稳定的系统,一定是“粽子们都能讲通用语 + 会打手势 + 有手册 + 不内耗”。

🧭 第四章:配置管理与服务注册发现机制——系统“粽子”之间的导航图与调料包

🧂 为什么配置和注册中心是微服务“底座”?

在单体应用时代,我们常常把所有配置硬编码在 application.properties 或 YAML 文件里;

但在微服务架构下,数十上百个服务动态运行,环境不一致、配置不统一、地址不稳定,这时靠复制粘贴配置就像“盲人裹粽”,迟早翻车。

所以我们需要两个系统支柱:

- 配置中心(Config Center):集中管理配置参数,支持动态刷新;

- 注册中心(Service Registry):服务上线后“报到”,消费者根据注册信息自动发现与调用。

🛠️ 配置中心的实现与选型

| 技术 | 特点 | 适用场景 |

|---|---|---|

| Spring Cloud Config | Git 管理配置,版本控制友好 | Java 项目,适配 Spring Boot |

| Nacos Config | 支持多格式 + 动态推送 + 可视化 | 阿里系或多语言项目 |

| Apollo | 分环境 + 灰度 + 审批流程齐全 | 对发布安全敏感的中大型企业 |

📌 建议:中小团队首选 Nacos,GitOps 场景适合 Spring Config,大厂推荐 Apollo。

📚 配置中心实践要点

- 用“命名空间”隔离不同环境(dev/test/prod);

- 用“配置分组”隔离不同服务,避免“粽子混馅”;

- 配置项分级设计:基础配置 / 安全配置 / 可变业务参数;

- 配合客户端支持热更新,避免重启发布;

🧭 注册中心选型指南

| 技术 | 协议支持 | 健康检查 | 一致性协议 | 社区活跃 | 说明 |

|---|---|---|---|---|---|

| Eureka | HTTP | 内建 | CAP 弱一致 | 低 | 已停止维护,不推荐 |

| Consul | HTTP/DNS | 内建 | Raft 强一致 | 高 | 运维简单,支持多语言 |

| Nacos | HTTP | 内建 | CP模型 | 非常高 | 推荐,支持注册 + 配置一体化 |

| Etcd | gRPC | 外部集成 | Raft 强一致 | 高 | Kubernetes 默认依赖组件 |

✅ 推荐搭配:Nacos 既能做注册,又能做配置,适合全场景一体化。

🔄 服务发现机制

所谓“服务发现”,就是让系统在运行中动态地“找到别人”和“让别人找到我”。

两种发现模式:

- 客户端发现(Client-Side):客户端从注册中心拉取地址,自行做负载均衡(如 Netflix Ribbon)

- 服务端发现(Server-Side):由中间代理(如 Spring Cloud Gateway)统一调度

推荐使用:服务端发现 + 网关统一调度,便于控制和监控。

💡 动态扩展场景:

当某个服务实例数量从 2 个 → 8 个:

- 新实例注册进注册中心;

- 调用方无需修改地址,自动从注册中心获取最新可用列表;

- 负载均衡策略(轮询、最少连接、加权)立即生效。

就像多包粽子进锅,不用通知锅本身,锅会自动识别“谁进来了、该分几分钟煮”。

⚠️ 常见误区与坑:

- ⛔ 配置中心配置无版本管理:发布后回滚不了;

- ⛔ 注册中心不做健康检查:死服务还在列表,调用就挂;

- ⛔ 所有服务都用同一个命名空间:一锅粽子难区分;

📌 本章小结:

没有配置中心,就像把糯米扔进锅里找不到料包;

没有注册发现,粽子之间像迷路的船,不知往哪送、不知从哪来。

🌐 第五章:服务网格与流量治理机制——粽子交通警察的秘密武器

🧩 为什么需要服务网格(Service Mesh)?

传统微服务通信依赖 SDK 插件来实现限流、熔断、监控、加密等,但当服务数量激增后,每个服务都集成这些逻辑就像每个粽子都要带锅上桌——重、慢、维护麻烦。

服务网格的理念是:

- 通信逻辑下沉到独立进程(Sidecar);

- 业务服务只关注业务逻辑,而网络管理、安全策略、流量控制等由服务网格统一处理。

🧠 服务网格核心组件

| 角色 | 描述 | 工具/代表 |

|---|---|---|

| 数据平面 | 每个服务旁的 Sidecar 代理,负责流量拦截与转发 | Envoy |

| 控制平面 | 管理全局策略与 Sidecar 配置 | Istio、Linkerd、Kuma 等 |

📌 类比:

服务网格就像粽子包了个统一“高速通行证”,无论去哪儿都走绿灯,还能被精确跟踪、定向放行。

🚦 流量治理能力拆解

- 流量控制:流量镜像、按权重灰度发布、蓝绿部署;

- 限流熔断:自动检测服务过载,及时拒绝或降级处理;

- 请求路由:根据 Header/路径/版本精确转发;

- 安全加密:双向 mTLS 通信,防止中间人攻击;

- 故障注入:用于测试系统韧性,如延迟模拟、丢包模拟;

🔍 服务网格与 API 网关的区别

| 功能 | API 网关 | 服务网格 |

|---|---|---|

| 作用域 | 边缘流量 | 内部服务间流量 |

| 部署位置 | 集中部署 | 每个 Pod 一个 Sidecar |

| 功能覆盖 | 鉴权、限速、路由 | 路由、熔断、加密、跟踪 |

| 性能影响 | 可控 | 有一定资源开销(但更灵活) |

✅ 推荐组合:边缘用 API 网关 + 内部用服务网格,一外一内,协同高效。

🛠️ 实践落地建议(以 Istio 为例)

- 统一入口配置 VirtualService + DestinationRule;

- 将业务服务打包成 Deployment + Sidecar 自动注入;

- 使用 Istio Dashboard / Kiali 可视化服务拓扑与流量;

- 开启 mTLS 安全通道,禁止明文 HTTP;

- 引入 Prometheus + Grafana 实现流量观测与报警;

⚠️ 落地挑战与思考

- ⛔ 学习成本高:Istio 初期配置复杂,建议结合 Operator + 可视化界面;

- ⛔ 性能消耗:Sidecar 占用资源,需预留容器配额;

- ⛔ 故障排查困难:调试需同时具备业务 +网络层知识;

💡 最佳实践:小规模先试点,逐步铺开,搭配灰度策略回滚机制。

📌 本章小结:

服务网格是微服务“交通调度中心”,让所有粽子不堵车、不撞锅、不掉队;

要建一套高弹性、高安全、高透明的云原生系统,服务网格就是必须掌握的王牌技能之一。

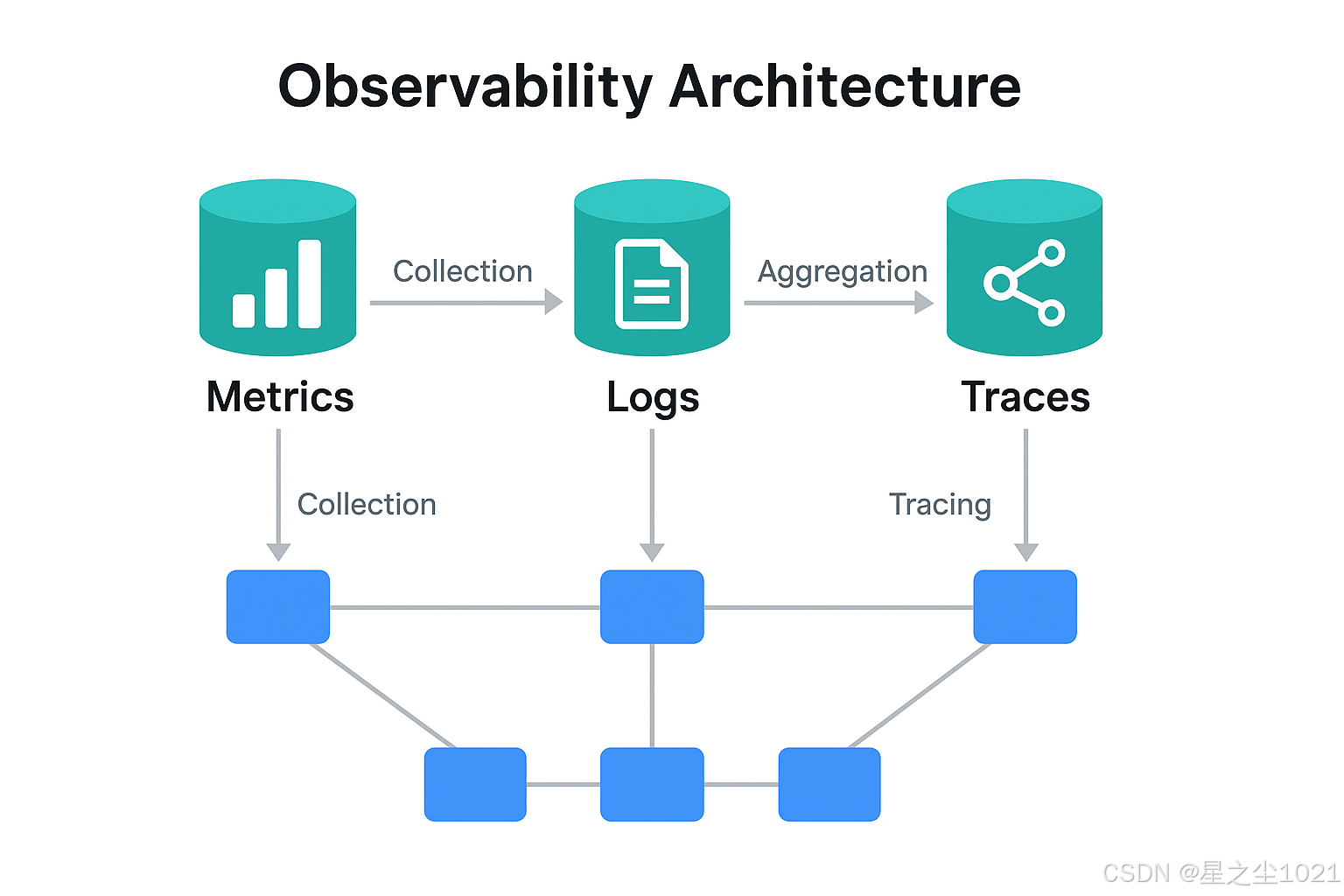

📊 第六章:可观测性体系建设——看见粽子的每一次翻滚与出锅

🕵️ 为什么可观测性是现代微服务的“眼睛”?

微服务系统动辄几十上百个服务实例、上千个 API 路由点,任何一个“馅料”出错都可能导致整锅“粽子翻锅”。

传统的“打日志+上控制台”的方式已经远远不够,我们需要完整的可观测性体系来实现:

- Metrics(指标):性能统计和趋势

- Logs(日志):行为轨迹与报错信息

- Traces(链路追踪):服务间调用全过程

📌 合称为“三大支柱(Three Pillars of Observability)”

🔍 可观测性组件一览

| 功能 | 工具代表 | 简述 |

|---|---|---|

| 指标采集 | Prometheus、Telegraf | 实时采集 CPU/内存/QPS 等数据 |

| 日志系统 | ELK Stack(Elasticsearch+Logstash+Kibana)、Loki | 日志收集、索引、查询、可视化 |

| 链路追踪 | Jaeger、Zipkin、Skywalking | 服务 A → B → C 的耗时与状态全链路展示 |

| 可视化面板 | Grafana | 大屏展示指标、日志、告警等信息 |

🛠️ 实战搭建方案:Prometheus + Grafana + Jaeger

- 使用 Prometheus Operator 快速部署并维护采集体系;

- 结合 ServiceMonitor 自动发现每个微服务的

/metrics接口; - 配置 Grafana Dashboard:CPU、内存、GC、TPS 一图尽览;

- 在微服务中引入 OpenTelemetry + Jaeger SDK,追踪每一次请求链路;

- 对异常点设置告警规则,实时推送到钉钉/飞书/Slack;

📌 类比:

每个粽子从投料、包裹、入锅、出锅的过程都被实时记录、打分、报警,让厨房管理像飞机塔台一样精密。

📈 告警体系建设 Tips

- ❗ 设置合理阈值:CPU > 80% 持续 1 分钟以上再报警

- 🔁 设定恢复规则:自动关闭告警避免重复通知

- 🪢 关联追踪 ID:告警日志可跳转到具体 Trace 详情页

- 👀 报警分级:高优先级走电话通知,中优飞书推送,低优邮件汇总

⚠️ 常见观测误区

| 错误做法 | 危害 |

|---|---|

| 所有日志都打印 INFO | 日志爆炸、查询无效 |

| 仅监控主服务,不关注中间件 | RabbitMQ 卡死没人知晓 |

| 链路 ID 未贯穿日志 | 关联查询难如登天 |

| 没有统一 Dashboard + 权限管理 | 观测体系形同虚设 |

📌 本章小结:

没有观测,微服务就像蒙眼炒菜,用户吃出问题都不知道锅在哪儿。

建立指标、日志、追踪一体化系统,让每一颗粽子从投料到出锅都“有迹可循”,才是真正可控、可调、可优化的工程体系。

🚀 第七章:CI/CD 与 DevOps 流水线构建机制——让粽子从立项到出锅一气呵成

🧬 为什么 CI/CD 是微服务的“出锅流水线”?

微服务架构意味着频繁迭代、小步快跑,如果没有一套高效稳定的持续集成与交付机制,开发上线就如“临时拼锅粽”:流程断裂、测试缺失、上线混乱。

CI/CD 就是 DevOps 体系中的生产流水线,帮你把“包粽→煮粽→摆盘”自动化,实现“一键投料→一键出锅”。

🏗️ 核心流程图(推荐形象图示)

🛠️ 主流工具链推荐(粽子工厂神器)

| 阶段 | 工具/平台代表 | 功能说明 |

|---|---|---|

| 持续集成 CI | Jenkins、GitLab CI、GitHub Actions | 构建、单元测试、代码检查、打包镜像 |

| 容器构建 | Docker、BuildKit、Kaniko | 构建应用镜像并推送至镜像仓库 |

| 镜像仓库 | Harbor、Docker Hub、Aliyun CR | 管理镜像版本、控制权限、安全扫描 |

| 部署编排 | Helm、Kustomize、Argo CD | 自动化部署 Kubernetes 应用 |

| 环境管理 | Kubernetes、K3s、Rancher | 容器调度、负载均衡、健康检查 |

| 灰度发布 | Flagger、Argo Rollouts | 控制版本比例、逐步上线、回滚控制 |

| 通知与集成 | 飞书、Slack、邮件、Webhook | 流程通知与集成下游系统 |

📌 建议组合:Git + Jenkins + Docker + K8s + ArgoCD + Grafana + 飞书告警

📦 微服务项目中的 CI/CD 实践重点

- 多服务分仓统一构建:每个服务独立 Git 仓库,CI 逻辑统一封装为模板;

- 镜像自动打标签:每次构建产物标记版本号、时间戳、分支名;

- 自动化测试优先:UT → API 测试 → Smoke 测试 → 性能压测;

- 灰度上线策略:金丝雀发布,先放一锅粽子测试市场,再全锅出品;

- 支持快速回滚:配置版本对比机制 + 一键退回上个稳定版本;

⚠️ 常见 CI/CD 踩坑与解决方案

| 问题 | 解决方案 |

|---|---|

| 构建脚本到处复制 | 建立公共 CI 模板,统一引用 |

| 发布流程无审批/日志无痕迹 | 引入审批节点 + GitOps 可审计记录 |

| 部署失败难追溯 | 接入 Prom + Loki 观察部署链路 |

| 多环境配置冲突 | 使用 Helm + 多环境 values 分离部署 |

📌 本章小结:

没有 CI/CD 的微服务,像手工批量包粽:慢、易错、不可控。

构建自动化、高质量、稳定回滚的交付链路,让每一颗粽子出锅前都能“蒸得香、码得稳、运得准”。