PyTorch C++扩展:集成自定义CUDA内核

PyTorch提供了卓越的性能,但为了实现极致优化或非标准操作,编写自定义CUDA C++内核是必经之路。PyTorch强大的C++扩展机制可以无缝地将自定义CUDA代码集成到Python工作流中。

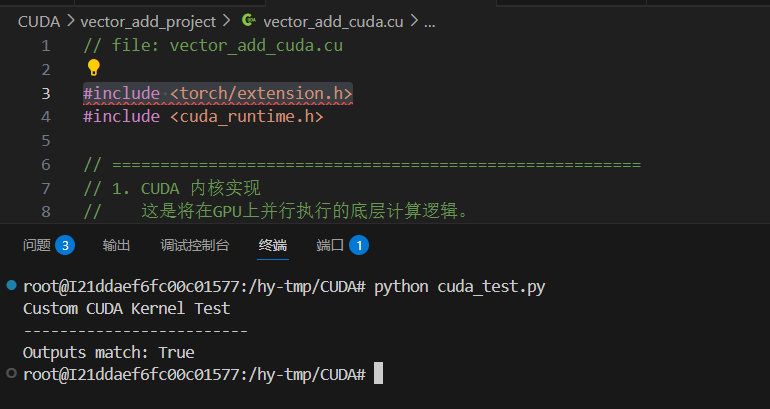

本指南将通过一个简单的向量加法示例(c = a + b),分步展示如何正确地构建、编译并调用一个自定义的CUDA C++内核,并特别强调避免常见编译错误的关键文件组织方法。

先决条件

在开始之前,请确保系统已安装以下环境:

- PyTorch

- CUDA Toolkit (与PyTorch版本兼容)

- 一个C++编译器 (如 GCC, MSVC)

步骤一:创建项目文件结构 (关键)

为了确保成功编译,所有包含CUDA特定语法的代码都必须位于由NVIDIA的nvcc编译器处理的文件中。最简单、最模块化的方法是将所有CUDA相关代码(包括内核实现和调用逻辑)都放在同一个.cu文件中。

创建一个项目文件夹,并包含以下两个核心文件:

vector_add_project/

├── setup.py # 用于编译和安装的构建脚本

└── vector_add_cuda.cu # 包含CUDA内核、绑定函数和模块定义的源文件

步骤二:编写CUDA和绑定代码 (.cu 文件)

在这个工作流中,vector_add_cuda.cu是唯一需要的源代码文件。它将包含三个部分:CUDA内核本身、调用该内核的C++包装函数,以及将该函数暴露给Python的模块定义。

// file: vector_add_cuda.cu

#include <torch/extension.h>

#include <cuda_runtime.h>

// =======================================================

// 1. CUDA 内核实现

// 这是将在GPU上并行执行的底层计算逻辑。

// =======================================================

__global__ void vector_add_kernel(const float* a, const float* b, float* c, int n) {

// 使用内置变量计算当前线程的全局唯一ID

int idx = blockIdx.x * blockDim.x + threadIdx.x;

// 边界检查,防止线程访问越界内存

if (idx < n) {

c[idx] = a[idx] + b[idx];

}

}

// =======================================================

// 2. C++ 包装函数 (主机端代码)

// 这个函数负责连接PyTorch和CUDA内核。

// =======================================================

torch::Tensor vector_add(torch::Tensor a, torch::Tensor b) {

// 检查输入张量是否在CUDA设备上

TORCH_CHECK(a.is_cuda(), "Input tensor 'a' must be on a CUDA device");

TORCH_CHECK(b.is_cuda(), "Input tensor 'b' must be on a CUDA device");

// 检查输入张量的形状和数据类型

TORCH_CHECK(a.sizes() == b.sizes(), "Input tensors must have the same shape");

TORCH_CHECK(a.scalar_type() == torch::kFloat32, "Input tensors must be of type float32");

// 创建一个与输入形状和类型相同的输出张量

auto c = torch::empty_like(a);

int n = a.numel(); // 获取元素总数

// 计算CUDA内核的启动配置

const int threads_per_block = 256;

const int blocks_per_grid = (n + threads_per_block - 1) / threads_per_block;

// ★ 关键:调用CUDA内核。

// 因为这段代码在.cu文件中,NVCC编译器能正确解析<<<...>>>语法。

vector_add_kernel<<<blocks_per_grid, threads_per_block>>>(

a.data_ptr<float>(),

b.data_ptr<float>(),

c.data_ptr<float>(),

n

);

return c;

}

// =======================================================

// 3. 模块定义 (绑定到Python)

// 使用PYBIND11将C++函数暴露给Python。

// =======================================================

PYBIND11_MODULE(TORCH_EXTENSION_NAME, m) {

m.def(

"forward", // 在Python中调用的函数名

&vector_add, // 指向要调用的C++函数

"Vector Add (CUDA implementation)" // 函数的文档字符串

);

}

代码解析:为何这样组织?

- 单一编译器处理:将所有包含CUDA语法的代码(

__global__,<<<...>>>)放在一个.cu文件中,确保了它们全部由nvcc编译器处理。nvcc既能理解标准C++,也能理解CUDA C++的扩展语法,从而避免了普通C++编译器遇到CUDA语法时会报的error: expected primary-expression before ‘<’ token错误。 - 模块化和封装:所有与此自定义操作相关的逻辑都封装在一个文件中,提高了代码的可维护性。

- 零拷贝:

a.data_ptr<float>()方法依然是关键,它直接获取指向GPU内存的指针,避免了任何不必要的数据复制。

步骤三:编写构建脚本 (setup.py)

setup.py只需要引用一个源文件即可。

# file: setup.py

from setuptools import setup

from torch.utils.cpp_extension import BuildExtension, CUDAExtension

setup(

name='vector_add_cpp', # 扩展的名称

ext_modules=[

CUDAExtension(

name='vector_add_cpp_cuda', # 最终导入到Python的模块名

sources=['vector_add_cuda.cu'], # 仅有的一个源文件

),

],

cmdclass={

'build_ext': BuildExtension

})

步骤四:编译和使用

现在,可以编译并运行这个经过正确组织的自定义内核了。

编译扩展

在终端中,导航到项目根目录并执行以下命令:

python setup.py developdevelop模式是开发阶段的最佳选择,因为它能实现对C++/CUDA代码的修改热重载(在下次import时自动重新编译)。在Python中调用

创建一个Python脚本来测试自定义内核:

# file: test.py import torch try: # 导入刚刚编译的模块 import vector_add_cpp_cuda print("CUDA C++ extension loaded successfully.") except ImportError: print("Error: C++ extension not installed. Please run 'python setup.py develop'.") exit() # 检查CUDA是否可用 if not torch.cuda.is_available(): print("CUDA device not found.") exit() # 创建两个在GPU上的输入张量 a = torch.randn(1, 4096, device='cuda', dtype=torch.float32) b = torch.randn(1, 4096, device='cuda', dtype=torch.float32) # 调用自定义的CUDA内核 c_custom = vector_add_cpp_cuda.forward(a, b) # 使用PyTorch内置操作进行验证 c_pytorch = a + b # 验证结果是否正确 print("\n--- Verifying Results ---") print(f"Outputs match: {torch.allclose(c_custom, c_pytorch)}")

运行python test.py,将会看到成功加载和匹配结果的输出。这证明了通过正确组织文件,可以轻松地将高性能的自定义CUDA C++内核集成到PyTorch中。

备注:在VSCode中进行PyTorch C++扩展开发时,可能会在#include语句下看到头文件未找到的错误提示。解决此问题的最佳、最简单的方法是安装NVIDIA官方的CUDA扩展:Nsight Visual Studio Code Edition。