模型规格与定位

腾讯混元团队正式宣布推出四款开源小尺寸模型,参数规模涵盖0.5B、1.8B、4B、7B四个层次。这些模型专门针对消费级显卡进行优化设计,完美适配笔记本电脑、手机、智能座舱、智能家居等低功耗应用场景,同时支持垂直领域的低成本微调需求。

此次发布进一步完善了混元开源模型生态体系,为开发者和企业用户提供了更加丰富的模型选择方案。

平台支持与获取方式

目前,四款新模型已全面上线GitHub和Hugging Face等主流开源社区平台,并获得了Arm、高通、Intel、联发科等多个消费级终端芯片平台的官方支持。

核心技术特点

双模式推理架构

新开源的四个模型均采用融合推理架构设计,具备推理速度快、性价比高的显著优势。用户可根据具体使用场景灵活切换模型的思考模式:

- 快思考模式:提供简洁高效的输出结果,专门针对简单任务进行优化

- 慢思考模式:具备完整的推理步骤,专门用于解决复杂问题

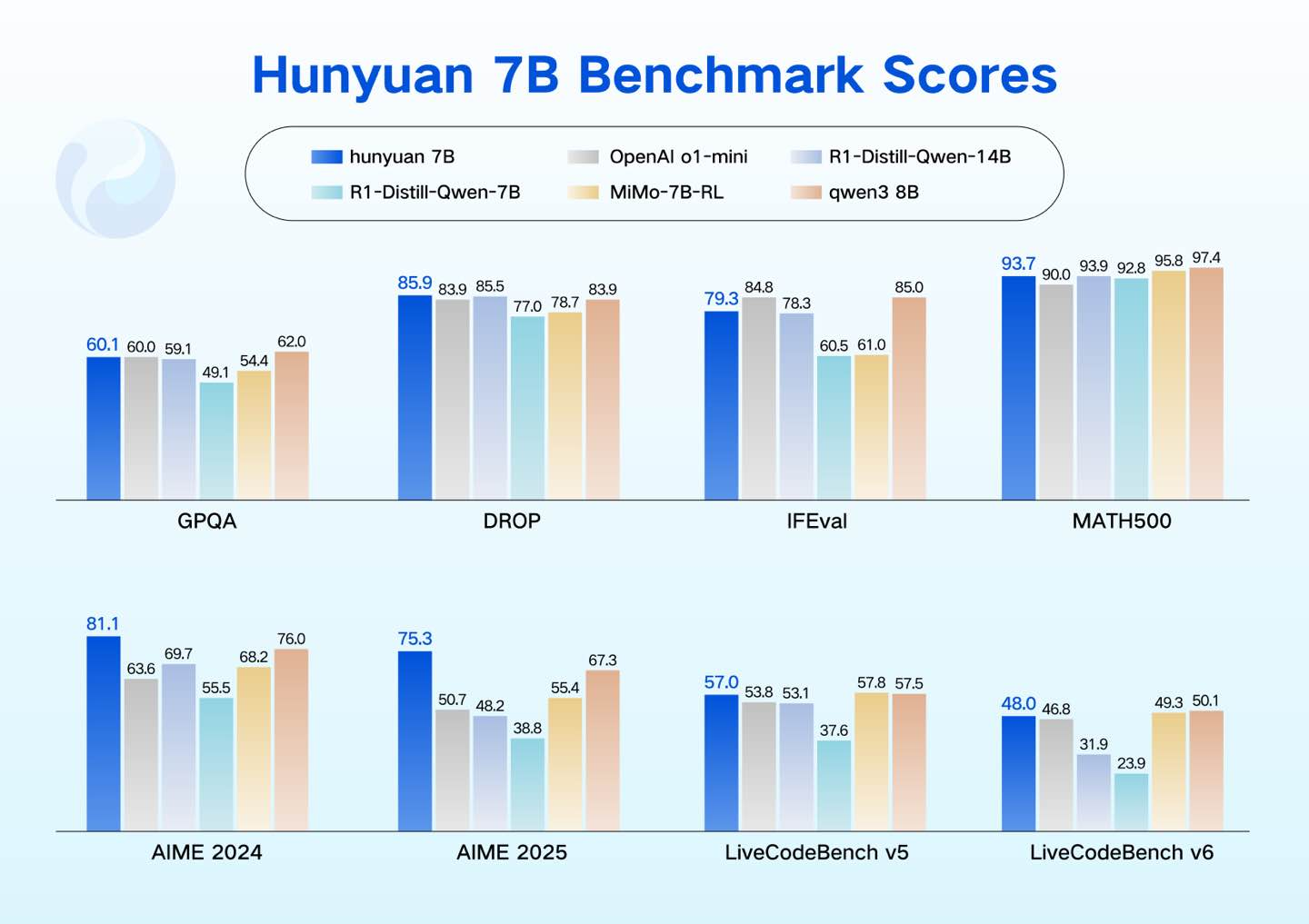

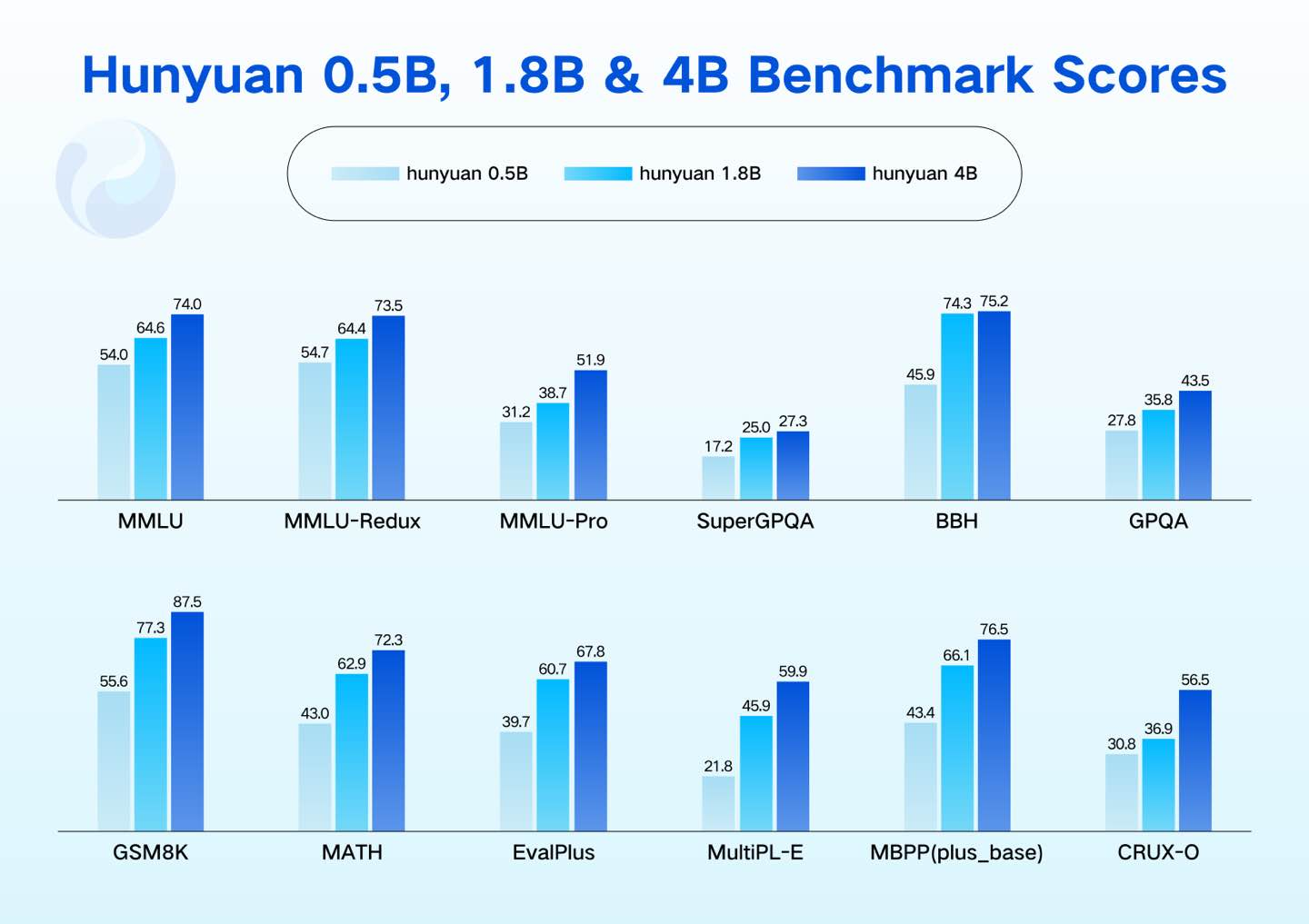

卓越的性能表现

在语言理解、数学计算、逻辑推理等核心领域,这些模型均展现出色的能力水平,在多个公开测试集上的评分达到了行业领先标准。

突出亮点功能

Agent能力

通过精心设计的数据构建和强化学习奖励信号优化,四款模型在以下Agent能力方面表现卓越:

- 任务规划与执行

- 工具调用与集成

- 复杂决策制定

- 反思与优化

实际应用中,模型能够轻松胜任深度搜索、Excel数据操作、旅行攻略规划等复杂任务。

超长文本处理能力

模型原生支持256K长上下文窗口,能够一次性处理和记忆相当于40万中文字符或50万英文单词的超长内容。这一能力相当于一次性阅读并记住3本《哈利·波特》小说的全部内容,包括所有人物关系和剧情细节,并能基于这些信息进行深度讨论和分析。

部署优势

硬件要求友好

四款模型均支持单卡部署方案,部分PC、手机、平板等设备可直接接入使用,大幅降低了部署门槛。

技术兼容性强

模型具备出色的开放性特征,支持主流推理框架(包括SGLang、vLLM、TensorRT-LLM等)以及多种量化格式,确保广泛的技术兼容性。

实际应用案例

这四款小尺寸模型能够满足从端侧到云端、从通用到专业的多样化应用需求,目前已在腾讯多个核心业务中成功应用,其可用性和实用性经过了充分的实践验证。

云端应用

- 腾讯会议AI助手:依托模型原生超长上下文能力,实现对完整会议内容的一次性理解和智能处理

- 微信读书AI问书:能够对整本书籍进行全面理解和深度问答

端侧应用

- 腾讯手机管家:利用小尺寸模型显著提升垃圾短信识别准确率,实现毫秒级智能拦截,确保用户隐私零上传

- 腾讯智能座舱助手:通过双模型协作架构有效解决车载环境应用痛点,充分发挥模型低功耗、高效推理的技术特性

模型性能

获取地址

官方体验平台

https://hunyuan.tencent.com/modelSquare/home/list

GitHub开源地址

- Hunyuan-0.5B: https://github.com/Tencent-Hunyuan/Hunyuan-0.5B

- Hunyuan-1.8B: https://github.com/Tencent-Hunyuan/Hunyuan-1.8B

- Hunyuan-4B: https://github.com/Tencent-Hunyuan/Hunyuan-4B

- Hunyuan-7B: https://github.com/Tencent-Hunyuan/Hunyuan-7B

Hugging Face平台

- Hunyuan-0.5B: https://huggingface.co/tencent/Hunyuan-0.5B-Instruct

- Hunyuan-1.8B: https://huggingface.co/tencent/Hunyuan-1.8B-Instruct

- Hunyuan-4B: https://huggingface.co/tencent/Hunyuan-4B-Instruct

- Hunyuan-7B: https://huggingface.co/tencent/Hunyuan-7B-Instruct