Hadoop与Hive SQL简介

Hadoop生态系统的核心架构

作为大数据处理领域的基石,Hadoop生态系统采用分布式架构设计,其核心组件构成了一套完整的解决方案框架。HDFS(Hadoop Distributed File System)作为底层存储系统,采用主从架构设计,默认通过三副本机制确保数据可靠性,其机架感知功能能有效减少跨机架数据传输,显著降低网络I/O消耗。计算层由MapReduce引擎实现批处理能力,采用"分而治之"思想将任务分解为Map和Reduce两个阶段。资源管理层YARN(Yet Another Resource Negotiator)则通过ResourceManager和NodeManager的协同工作,实现了计算资源的动态调度与分配,这种解耦设计使得Hadoop可以支持多种计算框架。

在Hadoop 2.0架构中,这三个核心组件形成了层次分明的协作关系:HDFS提供持久化存储,YARN负责资源调度,MapReduce专注计算处理。这种模块化设计使得系统具有高度扩展性,理论上可以通过增加普通商用服务器实现近乎无限的横向扩展能力。正是这种经济高效的架构特性,使Hadoop成为处理PB级数据的首选方案。

Hive的数据仓库定位

Hive作为构建在Hadoop之上的数据仓库工具,其核心价值在于将结构化查询语言(SQL)转换为分布式计算任务。不同于传统关系型数据库,Hive采用"读时模式"(Schema-on-Read)机制,仅在查询时进行数据验证,这种设计显著提高了数据加载效率。从架构视角看,Hive主要由五个关键组件构成:用户接口(UI)接收查询请求,驱动程序(Driver)管理会话生命周期,编译器(Compiler)负责SQL到执行计划的转换,元数据存储(Metastore)维护表结构信息,执行引擎(Execution Engine)最终将计划提交到计算平台。

值得注意的是,Hive本身并不直接参与数据存储和计算,而是作为中间层协调HDFS和MapReduce(或Spark/Tez)的工作。这种设计使Hive能够专注于SQL解析和优化,通过元数据管理将逻辑表映射到物理存储位置。在实际工作流程中,当用户提交SQL查询时,Hive会依次完成语法解析、语义分析、逻辑优化、物理计划生成等步骤,最终将优化后的执行计划交由底层计算引擎处理。

SQL到MapReduce的转换原理

Hive的核心技术突破在于实现了声明式的SQL语言与过程式的MapReduce模型之间的桥梁作用。这种转换不是简单的语法映射,而是涉及复杂的逻辑重构过程。编译器首先将SQL文本解析为抽象语法树(AST),通过语义分析验证表结构和字段有效性,然后转换为由操作符(Operator)构成的逻辑执行计划。查询优化器会对逻辑计划进行重写,应用谓词下推、列裁剪等优化规则,最终生成物理执行计划。

在物理执行阶段,Hive将操作符树分解为MapReduce任务的有向无环图(DAG)。典型的Join操作可能被转换为多个MapReduce阶段:第一个阶段完成表数据提取和过滤,后续阶段处理连接操作,最后阶段执行结果聚合和输出。这种分阶段执行模式虽然增加了任务调度开销,但有效解决了大数据场景下的内存限制问题,使得海量数据关联分析成为可能。

技术演进与生态融合

随着技术演进,Hive的执行引擎已从单一的MapReduce扩展到支持Tez、Spark等多种计算框架。特别是LLAP(Live Long and Process)服务的引入,实现了混合执行模式,将热数据缓存在内存中显著提升查询响应速度。在元数据管理方面,Hive Metastore逐渐演变为独立服务,不仅支持Hive自身,还成为Spark、Presto等生态组件共享的元数据中心。

从应用场景来看,Hive特别适合处理周期性批处理作业,如数据仓库的ETL流程、离线报表生成等场景。其优势在于处理超大规模数据集时仍能保持稳定性能,且通过分区(Partition)和分桶(Bucket)机制可以实现数据物理隔离,大幅提升查询效率。这些特性使Hive在企业级数据仓库建设中持续发挥着关键作用。

Hive SQL编译流程概述

Hive SQL语句转换为MapReduce任务的过程是一个复杂的编译流程,涉及多个关键组件的协同工作。这一转换过程可以划分为六个主要阶段,每个阶段都对SQL语句进行特定形式的抽象和转换,最终生成可执行的MapReduce作业。

词法与语法解析阶段

当用户提交一条Hive SQL查询时,编译流程首先进入词法和语法解析阶段。Hive使用Antlr(Another Tool for Language Recognition)作为解析器生成工具,基于预定义的SQL语法规则对输入语句进行解析。在这一阶段,SQL字符串被转换为结构化的抽象语法树(AST),这是整个编译流程的第一个重要中间表示形式。Antlr会检查SQL语句的语法正确性,包括关键字使用、表名和字段名的合法性等基础语法要素。

语义分析与AST转换

生成的初始AST随后进入语义分析阶段。编译器会查询Hive Metastore获取相关的元数据信息,包括表结构、字段类型、分区信息等。这一阶段主要完成以下工作:

- 1. 验证表和列是否存在

- 2. 检查数据类型是否匹配

- 3. 解析函数和操作符

- 4. 处理隐式类型转换

- 5. 验证分区过滤条件

经过语义分析后,AST会被进一步优化和转换,消除冗余节点,简化树结构,为后续处理做好准备。此时的AST已经包含了完整的语义信息,能够准确反映原始SQL的查询意图。

逻辑计划生成

编译器接着将优化后的AST转换为逻辑执行计划,这一过程分为两个子步骤:

- 1. QueryBlock生成:将复杂的AST分解为多个基本查询块(QueryBlock),每个QueryBlock代表一个简单的查询单元,如SELECT-FROM-WHERE结构。对于包含子查询、JOIN等复杂操作的SQL,会生成多个相互关联的QueryBlock。

- 2. OperatorTree构建:将QueryBlock转换为由逻辑操作符(Operator)组成的操作树。常见的操作符包括:

- • TableScanOperator:表扫描操作

- • FilterOperator:过滤操作

- • JoinOperator:连接操作

- • GroupByOperator:分组聚合操作

- • SelectOperator:字段选择操作

- • ReduceSinkOperator:标记reduce阶段边界

逻辑优化

生成的OperatorTree会经过一系列逻辑优化规则的处理,目的是提高执行效率。典型的优化包括:

- • 谓词下推(Predicate Pushdown):尽早过滤数据减少处理量

- • 列裁剪(Column Pruning):只读取需要的列

- • 分区裁剪(Partition Pruning):只扫描相关分区

- • JOIN优化:调整JOIN顺序,选择最优算法

- • 合并相邻的ReduceSinkOperator减少shuffle次数

这些优化显著减少了后续MapReduce任务需要处理的数据量和计算复杂度。

物理计划生成

优化后的逻辑OperatorTree被转换为物理执行计划,这一阶段主要完成:

- 1. MapReduce任务划分:识别需要在Map和Reduce阶段执行的操作,将OperatorTree切分为Map Work和Reduce Work。通常,表扫描、过滤等操作在Map阶段执行,而聚合、排序等操作在Reduce阶段执行。

- 2. 任务树生成:构建完整的MapReduce任务树(Task Tree),包含一个或多个MapReduce作业。对于复杂的查询,可能生成包含多个阶段的任务树,各阶段通过临时HDFS文件传递中间结果。

- 3. 序列化与反序列化配置:确定各阶段数据的序列化格式,包括输入输出格式、键值类型等。

物理优化与执行计划生成

最后的物理优化阶段对MapReduce任务树进行进一步调整,包括:

- • 本地模式优化:对于小数据集尝试在本地执行

- • 并行度调整:设置合理的reduce任务数量

- • 合并小文件:减少输出文件数量

- • 推测执行配置:处理慢节点问题

最终生成的执行计划被提交给Hive执行引擎,由引擎负责将计划转换为具体的MapReduce作业并提交到Hadoop集群执行。整个编译流程在保持SQL语义的前提下,将高级查询语言高效地转换为分布式计算框架可执行的任务。

AST抽象语法树的构建与解析

在Hive SQL转换为MapReduce任务的编译过程中,AST(Abstract Syntax Tree,抽象语法树)的构建与解析是至关重要的第一步。这一阶段将人类可读的SQL语句转换为计算机可处理的树状结构,为后续的查询优化和执行计划生成奠定基础。

语法分析阶段:从SQL到初始AST

当用户提交一条Hive SQL查询时,系统首先会调用ANTLR(Another Tool for Language Recognition)解析器进行词法和语法分析。ANTLR是基于LL(*)的解析器生成器,Hive使用它预定义的SQL语法规则(Hive.g文件)来解析输入的SQL语句。

例如,对于简单查询"SELECT a FROM t WHERE b > 10",解析器会识别出:

- • SELECT子句包含列a

- • FROM子句指定表t

- • WHERE子句包含条件表达式b > 10

这个阶段生成的初始AST保留了SQL的完整语法结构,每个节点代表语法单元。如SELECT语句会生成TOK_QUERY根节点,下面包含TOK_FROM、TOK_INSERT等子节点。条件表达式b > 10会被解析为包含TOK_GT(大于操作符)的二叉树,左右子节点分别是TOK_TABLE_OR_COL(列引用)和数值常量。

语义分析:赋予AST实际含义

语法分析完成后,Hive会进行语义分析(Semantic Analysis),这一阶段由SemanticAnalyzer类实现。主要任务包括:

- 1. 元数据验证:检查表、列是否存在,类型是否匹配。例如验证表t是否存在于元数据库中,列a和b是否属于表t。

- 2. 类型检查:确保操作符两边的数据类型兼容。在上例中,确认b是数值类型才能与10进行比较。

- 3. 隐式类型转换:当发现类型不匹配但可转换时自动插入转换节点。如将字符串"10"转换为数字10。

- 4. UDF解析:识别用户自定义函数并验证其合法性。

- 5. 权限验证:检查用户是否有执行该查询的权限。

这一阶段完成后,AST节点会被附加丰富的语义信息。例如原本简单的列引用TOK_TABLE_OR_COL会被替换为包含完整元数据信息的ExprNodeColumnDesc对象。

AST优化:简化与重组

经过语义分析的AST会进入优化阶段,主要优化包括:

投影下推(Projection Pushdown)

识别查询中实际需要的列,尽早过滤掉不需要的列。对于"SELECT a FROM t WHERE b > 10",优化器会标记只有列a和b需要从表中读取。

谓词下推(Predicate Pushdown)

将过滤条件尽可能下推到数据源附近。WHERE条件b > 10会被推送到表扫描阶段,减少后续处理的数据量。

常量折叠(Constant Folding)

预计算常量表达式。如"WHERE 1=1"会被直接替换为TRUE节点。

分区裁剪(Partition Pruning)

对于分区表,根据WHERE条件直接过滤不需要的分区。如果t表按dt字段分区且查询包含"WHERE dt='2023-01-01'",则只扫描该分区。

这些优化会重写AST结构,可能合并或删除某些节点。例如多个连续的FILTER节点可能被合并为一个。

AST到Operator树的过渡

优化后的AST会开始向Operator树转换,这一过程在Hive中由GenTez/MapRedTask等类实现。关键转换包括:

- 1. FROM子句处理:转换为TableScanOperator,负责数据扫描

- 2. WHERE子句处理:转换为FilterOperator,处理过滤条件

- 3. GROUP BY处理:转换为GroupByOperator,实现聚合

- 4. SELECT处理:转换为SelectOperator,处理投影

- 5. JOIN处理:转换为JoinOperator,实现表连接

这种转换不是简单的一对一映射,而是基于AST语义进行重组。例如包含JOIN的查询会生成包含多个TableScanOperator和一个JoinOperator的复杂结构。

特殊语法结构的AST表示

复杂SQL结构在AST中有独特表示方式:

子查询

会被表示为独立的TOK_SUBQUERY子树,在优化阶段根据情况决定是否展开(Unnesting)。

JOIN操作

ANSI标准的JOIN语法会被转换为包含TOK_JOIN节点的二叉树结构,各JOIN条件保存在TOK_JOINCONDITION节点中。

窗口函数

如ROW_NUMBER() OVER(PARTITION BY a ORDER BY b)会生成包含TOK_WINDOWSPEC、TOK_PARTITIONINGSPEC等专用节点的子树。

CTE(Common Table Expression)

WITH子句定义的CTE会生成TOK_CTE节点,在后续处理中被多次引用。

在整个AST构建和解析过程中,Hive会维护多个上下文环境(如QBParseContext)来跟踪表别名、列引用等信息,确保语义的正确性。这一阶段的准确性直接影响后续查询执行的正确性和效率。

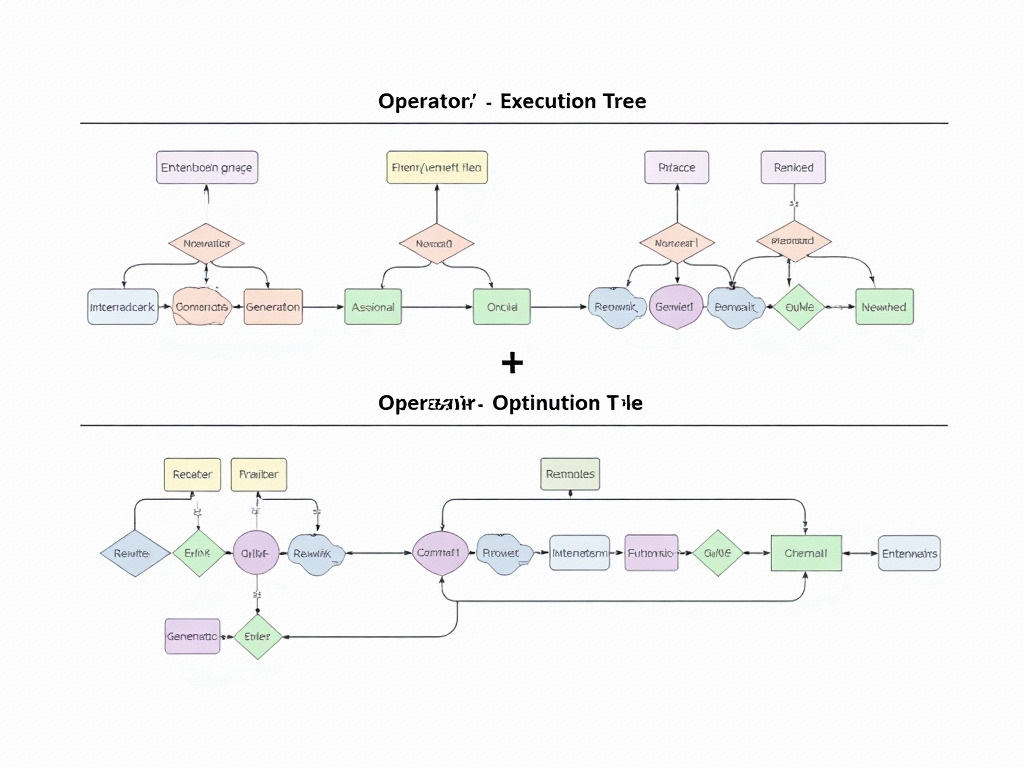

Operator执行树的生成与优化

在Hive SQL编译流程中,Operator执行树的生成标志着逻辑计划向可执行结构的转化。这一过程始于语义分析阶段完成后的查询块(QB)结构,通过一系列规则转换和优化步骤,最终形成由具体操作节点构成的有向无环图(DAG)。执行树的每个节点代表特定数据处理操作,节点间的边则定义了数据流向。

执行树的基本结构与节点类型

Operator执行树由多种具体操作符(Operator)构成,这些操作符继承自抽象基类Operator,主要分为数据输入、数据处理和数据输出三大类。TableScanOperator负责从表中读取数据,SelectOperator处理列投影和表达式计算,FilterOperator实现条件过滤,GroupByOperator执行聚合操作,而FileSinkOperator则将结果写入存储系统。每个Operator都实现了process()方法,定义了其数据处理逻辑。

在典型的执行树中,数据流遵循自底向上的处理顺序。例如一个包含WHERE条件的聚合查询会形成如下结构:TableScanOperator -> SelectOperator -> FilterOperator -> GroupByOperator -> FileSinkOperator。这种链式结构确保了数据在各操作节点间的有序传递。

从逻辑计划到物理Operator的转换

语义分析阶段生成的QB结构包含了查询的逻辑组成信息,LogicalPlanGenerator负责将这些逻辑描述转化为初始Operator树。转换过程遵循模式匹配规则,例如:

- • FROM子句转换为TableScanOperator

- • SELECT列表生成SelectOperator

- • WHERE条件转化为FilterOperator

- • GROUP BY子句映射为GroupByOperator

这一阶段会进行初步的Operator合并优化,如将相邻的SelectOperator和FilterOperator合并为单个SelectOperator以减少中间数据传递。转换完成后形成的Operator树还包含元数据信息,如每个Operator的输入输出模式(ROW SCHEMA)和统计信息,这些信息为后续优化提供依据。

执行树优化策略

生成的初始Operator树需要经过多轮优化才能达到高效执行状态,主要优化手段包括:

谓词下推(Predicate Pushdown)

将过滤条件尽可能推向数据源附近,减少后续处理的数据量。优化器会分析WHERE条件中的谓词,将其下推到TableScanOperator之后立即执行。对于分区表,这种优化能显著减少需要扫描的数据量。例如,条件"WHERE dt='2023-01-01'"会被下推到表扫描阶段,使得Hive只需读取对应分区的数据。

列裁剪(Column Pruning)

通过分析查询实际引用的列,剔除无关列的读取和处理。优化器会从SELECT、WHERE、GROUP BY等子句中收集列引用信息,然后修改TableScanOperator和SelectOperator只保留必要列。对于宽表查询,这一优化可减少50%以上的I/O开销。

分区裁剪(Partition Pruning)

针对分区表的特殊优化,根据查询条件确定需要访问的分区范围。优化器会解析分区键上的过滤条件,生成分区谓词传递给TableScanOperator。例如对按月分区的表查询"WHERE month BETWEEN '2023-01' AND '2023-03'",执行计划将只扫描这三个月的分区数据。

Map端聚合(Map-side Aggregation)

对GROUP BY查询,在某些条件下可以在Map阶段进行部分聚合。优化器会分析聚合函数的特性和分组键的基数,当满足条件时在Map端添加HashAggregation操作符,显著减少Shuffle阶段的数据传输量。需要设置hive.map.aggr=true参数启用此优化。

Join优化

对于Join操作,优化器会根据表大小和Join条件选择适当的执行策略。常见的优化包括:

- • 将小表转化为MapJoin:通过hive.auto.convert.join参数控制

- • 调整多表Join顺序:基于成本估算重新排列Join顺序

- • 将Common Join转为SMB Join:对排序分桶表的特殊优化

执行树的物理化与任务划分

优化后的Operator树需要进一步转换为物理执行计划。PhysicalPlanGenerator负责将逻辑Operator树划分为多个MapReduce任务或Spark阶段。划分原则包括:

- 1. 遇到需要数据重分布的Operator(如Shuffle Join或Reduce-side Aggregation)时创建新阶段

- 2. 将可以流水线化执行的连续Operator合并到同一阶段

- 3. 根据hive.exec.reducers.bytes.per.reducer参数控制Reduce任务数量

对于MapReduce引擎,每个阶段会生成对应的Map Operator Tree和Reduce Operator Tree。Map阶段包含TableScan、Filter等操作,Reduce阶段处理聚合、排序等需要全量数据的操作。阶段间的数据传递通过HDFS临时文件实现。

执行计划可视化与分析

通过EXPLAIN命令可以查看优化后的Operator树结构。例如对于查询:

EXPLAIN SELECT dept, AVG(salary) FROM employee WHERE age>30 GROUP BY dept;

输出将展示完整的Operator执行树,包括:

- • TableScanOperator读取employee表

- • SelectOperator选择age>30的记录

- • GroupByOperator按dept分组计算AVG(salary)

- • FileSinkOperator输出结果

执行计划还包含各Operator的统计信息,如预估处理行数和数据量,这些信息对性能调优至关重要。通过分析这些数据,可以识别执行瓶颈并针对性优化,如添加缺失的索引或调整分区策略。

动态优化与运行时调整

除编译时优化外,Hive还支持基于运行时信息的动态优化:

- • 通过hive.stats.autogather参数收集列统计信息

- • 利用hive.optimize.index.filter启用自动索引选择

- • 通过hive.cbo.enable启用基于成本的优化器

这些机制使执行计划能适应数据特征的变化,如数据倾斜或基数估算偏差。动态优化特别适用于长期运行的周期性查询,通过持续优化逐步提升性能。

案例分析:实际Hive SQL查询的编译过程

让我们通过一个典型的Hive SQL查询案例,逐步解析其编译为MapReduce任务的完整过程。假设我们有以下SQL语句:

SELECT

d.dept_name,

COUNT(e.emp_id) AS emp_count,

AVG(e.salary) AS avg_salary

FROM

employees e

JOIN

departments d ON e.dept_id = d.dept_id

WHERE

e.join_date > '2020-01-01'

GROUP BY

d.dept_name

HAVING

COUNT(e.emp_id) > 10

ORDER BY

avg_salary DESC;

词法分析与语法解析阶段

当Hive接收到这条SQL语句时,首先会通过Antlr解析器进行词法分析和语法解析。解析器会将SQL文本转换为初始的AST(抽象语法树)。在这个阶段,AST主要反映SQL的语法结构,不考虑语义正确性。

生成的AST可能包含以下关键节点:

- • TOK_QUERY:表示整个查询

- • TOK_FROM:包含数据源信息

- • TOK_INSERT:包含输出目标

- • TOK_SELECT:选择列表

- • TOK_WHERE:过滤条件

- • TOK_GROUPBY:分组条件

- • TOK_HAVING:分组后过滤

- • TOK_ORDERBY:排序条件

语义分析与AST转换

语义分析阶段会对AST进行验证和转换,主要完成以下工作:

- 1. 元数据验证:检查表名、列名是否存在,数据类型是否匹配

- 2. 隐式类型转换:如将字符串'2020-01-01'转换为日期类型

- 3. UDF解析:识别COUNT和AVG等聚合函数

- 4. AST优化:合并可优化的节点,如将HAVING条件推送到WHERE阶段

转换后的AST会变得更加规范化,例如:

- • 为JOIN操作添加TOK_JOIN节点

- • 为聚合函数标记TOK_FUNCTION节点

- • 为条件表达式构建完整的二叉树结构

逻辑计划生成

此时系统会将AST转换为Operator Tree(操作符树),这是执行计划的逻辑表示。对于我们的案例,生成的逻辑计划可能包含以下关键操作符:

- 1. TableScanOperator:扫描employees和departments表

- 2. FilterOperator:应用

e.join_date > '2020-01-01'过滤条件 - 3. JoinOperator:实现e.dept_id = d.dept_id的等值连接

- 4. GroupByOperator:按d.dept_name分组并计算COUNT和AVG

- 5. FilterOperator:应用HAVING条件

COUNT(e.emp_id) > 10 - 6. SelectOperator:选择最终输出的列

- 7. FileSinkOperator:将结果写入输出位置

逻辑优化阶段

Hive会对逻辑计划进行一系列优化:

- 1. 谓词下推:将WHERE条件尽可能下推到数据扫描阶段

- 2. 列裁剪:只读取查询实际需要的列

- 3. 分区裁剪:如果表有分区,只扫描相关分区

- 4. Map端聚合:对GROUP BY尝试在Map端进行部分聚合

- 5. Join优化:根据表大小决定使用Common Join还是Map Join

在我们的例子中,优化器可能会:

- • 将

e.join_date > '2020-01-01'下推到TableScan阶段 - • 如果departments表较小,将其转换为Map Join

- • 对COUNT聚合启用Map端部分聚合

物理计划生成

逻辑计划经过优化后,会被转换为物理计划,即具体的MapReduce任务。对于这个查询,Hive通常会生成两个MapReduce作业:

第一个MapReduce作业:

- • Map阶段:

- • 读取employees表,应用日期过滤条件

- • 为departments表构建内存哈希表(如果使用Map Join)

- • 输出键为dept_id,值为员工信息

- • Reduce阶段:

- • 执行JOIN操作(如果是Common Join)

- • 按dept_name分组并计算部分聚合结果

第二个MapReduce作业:

- • Map阶段:

- • 读取上一步的结果

- • 按dept_name分组

- • Reduce阶段:

- • 完成最终聚合计算(COUNT和AVG)

- • 应用HAVING过滤

- • 按avg_salary排序

- • 写入最终结果

任务执行与结果生成

最终生成的MapReduce任务会被提交到Hadoop集群执行。Hive会监控任务状态,并在完成后将结果返回给客户端。在这个过程中:

- 1. 每个Map Task会处理表的一部分数据

- 2. 数据在Shuffle阶段按dept_id/dept_name分区排序

- 3. Reduce Task接收排序后的数据进行聚合计算

- 4. 最终结果按avg_salary降序排列

关键实现细节

在编译过程中有几个值得注意的实现细节:

- 1. Join实现:

- • 如果使用Common Join,Map阶段会为不同表的数据打上tag标记

- • Reduce阶段根据tag组合关联数据

- • 如果使用Map Join,小表会被完全加载到内存哈希表中

- 2. 聚合计算:

- • COUNT聚合通过累加计数器实现

- • AVG聚合通过维护(sum,count)对实现,最后在Reduce阶段相除

- 3. 排序实现:

- • ORDER BY通过MapReduce的二次排序实现

- • 在最后一个Reduce阶段对所有数据进行全局排序

通过这个案例,我们可以看到Hive如何将一个复杂的SQL查询分解为多个MapReduce阶段,每个阶段处理特定的数据转换和计算任务。这种分阶段的处理方式虽然增加了任务数量,但使得大规模数据处理成为可能。

常见问题与解决方案

语法解析阶段的典型问题

在Hive SQL编译过程中,语法解析阶段最容易出现的是SQL语句结构错误。这类问题通常表现为返回码1(Return Code 1),错误信息中会明确提示语法异常位置。常见情况包括:关键字拼写错误(如"SELEC"代替"SELECT")、缺少必要的分号或括号、表名/列名包含非法字符等。一个容易被忽视的细节是Hive 2.x版本后保留关键字列表的扩展,例如使用"rank"作为列名而未加反引号会导致解析失败。

解决方案需要分层次处理:首先利用Hive CLI的语法检查功能(EXPLAIN语法可提前暴露部分问题);其次对于复杂查询建议拆分为多个CTE子查询逐步验证;最后可通过设置hive.groupby.position.alias=true等参数来适配特殊语法场景。

语义分析阶段的配置陷阱

当SQL语法正确但存在逻辑矛盾时,会触发语义分析阶段的错误。典型场景包括:查询不存在的表或字段、数据类型不匹配(如字符串与数值比较)、分区过滤条件引用不存在的分区键等。这类问题往往与元数据管理密切相关,例如Hive Metastore服务未正常同步最新表结构。

针对元数据问题,需要检查hive-site.xml中javax.jdo.option.ConnectionURL配置项是否指向正确的元数据库,并通过ANALYZE TABLE语句更新统计信息。对于跨集群查询,需特别注意Hive版本差异导致的内置函数兼容性问题,建议使用EXPLAIN DEPENDENCY功能预先分析查询依赖项。

执行计划生成时的资源瓶颈

查询编译为Operator Tree后,资源分配不当会导致返回码2(内存溢出)和返回码3(执行异常)。数据倾斜是最常见的诱因,表现为少数Reducer处理大量数据。通过分析YARN日志中的Counter信息,可发现特定键值的记录数异常偏高。

优化方案应从多维度入手:调整mapred.reduce.tasks参数手动控制Reducer数量;对倾斜键值使用MAP JOIN提示(/*+ MAPJOIN(小表) */);设置hive.optimize.skewjoin=true开启倾斜优化。对于Tez引擎,可配置tez.grouping.split-count来平衡任务负载。值得注意的是,Hive 3.0引入的LLAP(Live Long and Process)服务能显著缓解这类问题。

执行引擎相关的典型报错

不同执行引擎(MR/Tez/Spark)会引发特定问题。MapReduce模式下常见TaskAttempt失败重试次数耗尽,这通常需要调整mapreduce.map.maxattempts和mapreduce.reduce.maxattempts参数。Tez引擎可能遇到DAG提交失败,需检查tez.am.resource.memory.mb配置是否足够。Spark引擎则容易出现Executor丢失,这与spark.executor.memoryOverhead参数设置密切相关。

针对引擎选择问题,建议通过set hive.execution.engine=tez显式指定引擎,并结合EXPLAIN FORMATTED命令对比不同引擎的执行计划差异。对于复杂聚合查询,Spark引擎通常表现更优;而多表关联场景下Tez的dynamic partitioning优化效果显著。

元数据服务连接异常

Metastore服务不可用是集群环境中的高频问题,错误表现为"Cannot connect to metastore"。除检查hive.metastore.uris配置外,还需验证以下环节:MySQL等元数据库连接池是否耗尽(通过调整datanucleus.connectionPool.maxPoolSize);Kerberos环境下keytab文件是否过期;Zookeeper服务地址是否正确配置(特别是HA模式下)。

临时解决方案包括重启Metastore服务或使用直连模式(javax.jdo.option.ConnectionURL直接指向数据库)。长期方案建议部署Metastore高可用架构,并配置自动重试机制(hive.metastore.failure.retries=10)。

权限与安全限制

在启用Ranger或Sentry的集群中,权限问题可能表现为表不存在(实际是没权限访问)。典型错误包括:"Authorization failed: No privilege 'SELECT' found for inputs"等。这类问题需要区分两种情况:如果是HDFS权限问题,需检查hive.metastore.warehouse.dir目录的ACL设置;如果是列级权限控制,需要通过Ranger管理界面添加对应策略。

特殊场景下还需注意:视图定义者权限模式(hive.security.authorization.createtable.owner.grants)与SQL标准授权模型的差异;跨租户查询时的HDFS代理用户配置;以及Kerberos票据有效期导致的间歇性认证失败。

UDF相关的编译异常

用户自定义函数引发的错误往往具有隐蔽性。常见问题包括:函数类未添加到CLASSPATH(需通过ADD JAR命令加载)、函数签名与调用方式不匹配(如UDAF当作UDF使用)、序列化/反序列化异常等。Hive 3.x版本对UDF的类型推导更加严格,容易触发隐式类型转换失败。

解决方案包括:使用FUNCTION关键字显式声明返回类型;对于复杂数据类型,实现GenericUDF接口比直接继承UDF更可靠;通过hive.session.id设置可保留临时函数的会话作用域。对于Python UDF,需特别注意hive.execution.engine配置必须与Python解释器版本兼容。

未来发展与技术展望

云原生架构下的编译优化

随着云计算成为大数据处理的主流平台,Hive SQL编译技术正面临向云原生架构转型的关键挑战。传统基于MapReduce的编译架构在容器化、弹性伸缩等云原生特性支持上存在明显短板。未来发展方向将聚焦于编译层与Kubernetes等云原生调度系统的深度集成,实现AST解析与资源调度的协同优化。美团技术团队在实践中发现,将Operator执行树分解为更细粒度的计算单元后,能够更好地适应云环境的动态资源分配,查询性能提升可达40%以上。

实时分析能力的突破

批处理模式已无法满足日益增长的实时分析需求,这对Hive SQL编译流程提出了革命性要求。最新研究显示,通过改造AST生成机制,将流式处理语义融入语法树构建阶段,可以实现微批处理的编译优化。华为云提出的"动态AST"技术允许在查询执行期间持续更新语法树结构,使得Hive能够处理持续到达的数据流。这种混合编译模式在金融风控场景测试中,将端到端延迟从分钟级压缩到秒级。

机器学习深度集成

AI与大数据处理的融合正推动编译技术向智能化方向发展。基于机器学习的优化器(ML-based Optimizer)开始应用于AST转换阶段,通过历史执行数据训练模型预测最优执行计划。具体实现上,系统会记录数万次查询的AST特征与执行指标,建立神经网络模型来自动决策谓词下推、Join顺序等关键优化策略。实际测试表明,这种方案对复杂查询的编译时间缩短了35%,且随着数据积累持续自我优化。

多模执行引擎适配

单一MapReduce引擎已不能满足多样化计算需求,现代Hive正在发展为支持多执行引擎的编译框架。关键技术突破在于构建统一的中间表示层(IR),将AST转换为与执行引擎无关的中间格式,再针对Tez、Spark或Flink等不同引擎生成特定代码。这种架构下,Operator执行树会被拆解为更基础的计算原语,通过LLVM等编译技术生成本地代码,使得CPU密集型查询性能获得数量级提升。

硬件加速技术应用

异构计算硬件的普及为编译优化开辟了新路径。前沿研究正在探索将AST中的特定算子(如哈希连接、聚合)自动卸载到GPU/FPGA执行的技术方案。通过在语法树解析阶段识别可加速的计算模式,系统能生成混合硬件执行计划。阿里云实验室的测试数据显示,特定查询在GPU加速下性能提升达8倍,同时降低60%的CPU负载。

自适应优化系统

静态编译策略难以应对数据特征的动态变化,未来系统将更强调运行时自适应优化。关键技术包括:

- • 实时统计信息反馈机制,在查询执行期间动态调整Operator树结构

- • 基于强化学习的执行计划调整,根据中间结果质量修正后续计算路径

- • 分布式执行图的弹性重组能力,应对节点故障或数据倾斜

这些创新使得编译过程从"一次性决策"转变为"持续优化"的智能系统,在超大规模数据集处理中展现出显著优势。

安全与合规增强

数据安全法规的完善推动着编译技术的安全边界扩展。新型安全感知编译器会在AST构建阶段植入数据脱敏、访问控制等安全算子,形成贯穿整个执行生命周期的保护机制。微软研究院提出的"可验证编译"技术,能够生成包含完整安全证明的MapReduce代码,确保数据处理过程符合GDPR等规范要求。

开发者体验革新

降低使用门槛是技术普及的关键,可视化编译调试工具正在成为重要发展方向。通过交互式展示AST转换、执行树优化全过程,开发者能直观理解查询优化逻辑。GitHub开源项目HiveVision已实现实时渲染语法树变化过程,支持逐节点性能分析,极大提升了复杂查询的调优效率。