首个直播流扩散(LSD)AI模型:MirageLSD,它可以实时把任意视频流转换成你的自定义服装风格——虚拟换装新体验

概述

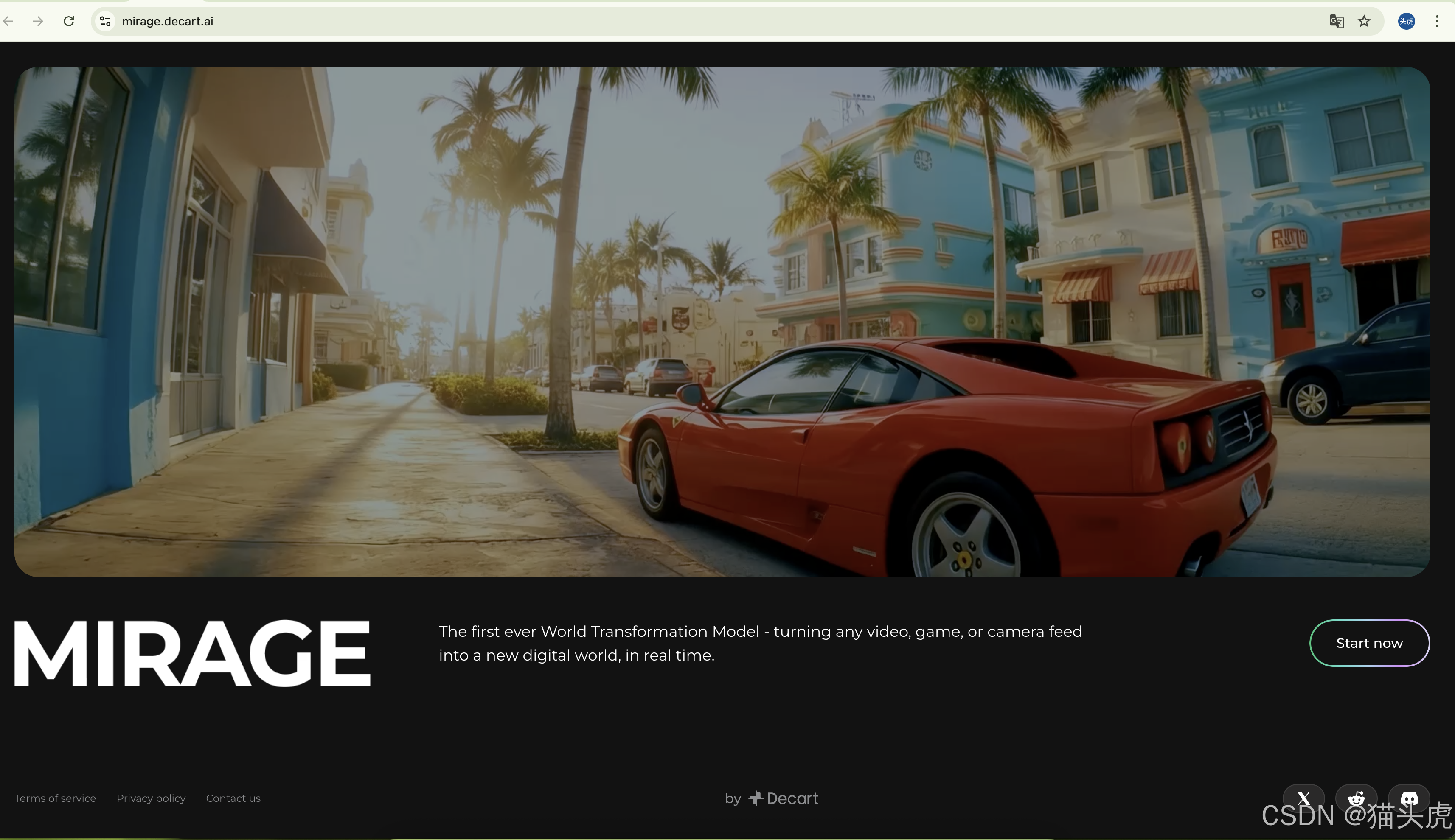

随着 AI 技术的高速发展,实时视频内容生成与场景转换成为了众多应用场景的核心需求——从直播互动、游戏开发到动画制作、虚拟试衣,任何需要“场景随心所欲” 的场合都渴望更低延迟、更高质量、更易集成的解决方案。MirageLSD 是 Decart AI 最新发布的首个 直播流扩散(Live Stream Diffusion, LSD) 模型,能够在 24 FPS 下、端到端延迟 < 40 ms 的条件下,实时将任意视频流转换成你想要的任何场景,并支持无限长度视频的持续输出。

文章目录

- 首个直播流扩散(LSD)AI模型:MirageLSD,它可以实时把任意视频流转换成你的自定义服装风格——虚拟换装新体验

-

- 概述

- 背景:为什么需要实时扩散模型?

- MirageLSD 架构解读

-

- 1. 时空 U-Net 核心

- 2. 低延迟采样策略

- 3. 光流引导与状态保持

- 流式处理管道

- 性能优化细节

- 关键性能指标

- 应用场景

- 上手指南

- 展望与未来

- 总结

背景:为什么需要实时扩散模型?

扩散模型(Diffusion Models)自 2022 年以来在静态图像生成上大放异彩,但要将其应用于实时视频流,则面临:

- 高延迟:传统扩散需要上百个采样步骤;

- 跨帧一致性:视频需保持连续性,避免闪烁和跳帧;

- 无限长度:一次性生成长视频会耗尽显存,且无法实时输出。

MirageLSD 的出现,正是为了突破以上瓶颈,将扩散模型真正带入实时视频应用时代。

MirageLSD 架构解读

1. 时空 U-Net 核心

- 输入:来自摄像头、屏幕捕获、游戏引擎的连续视频帧。

- 编码器:多层 2D 卷积加 3D 卷积混合,提取单帧与相邻帧的时空特征。

- 时空注意力模块:在 U-Net 的每个阶段加入跨帧 self-/cross-attention,保证画面一致性。

- 解码器:基于注意力融合后的 latent,重建成目标场景的 RGB 帧。

2. 低延迟采样策略

- 改良 DDIM:由原始 50+ 步骤降至 3–5 步骤,并结合可学习的时间调度器(Time-Step Scheduler),在保证画质的前提下极大缩短采样时间。

- 渐进式分辨率:先用低分辨率快速生成,再通过轻量级超分网络(Super-Resolution Net)恢复至目标分辨率,进一步减小主流程延迟。

3. 光流引导与状态保持

- 在线光流估计:通过高效的 FlowNet-lite 计算相邻帧光流,并将其引入时空注意力,提升帧间一致性。

- 隐藏态缓存:维护上一帧的 latent 隐藏态,作为下一帧生成的初始条件,支持无限长度视频的连续推理。

流式处理管道

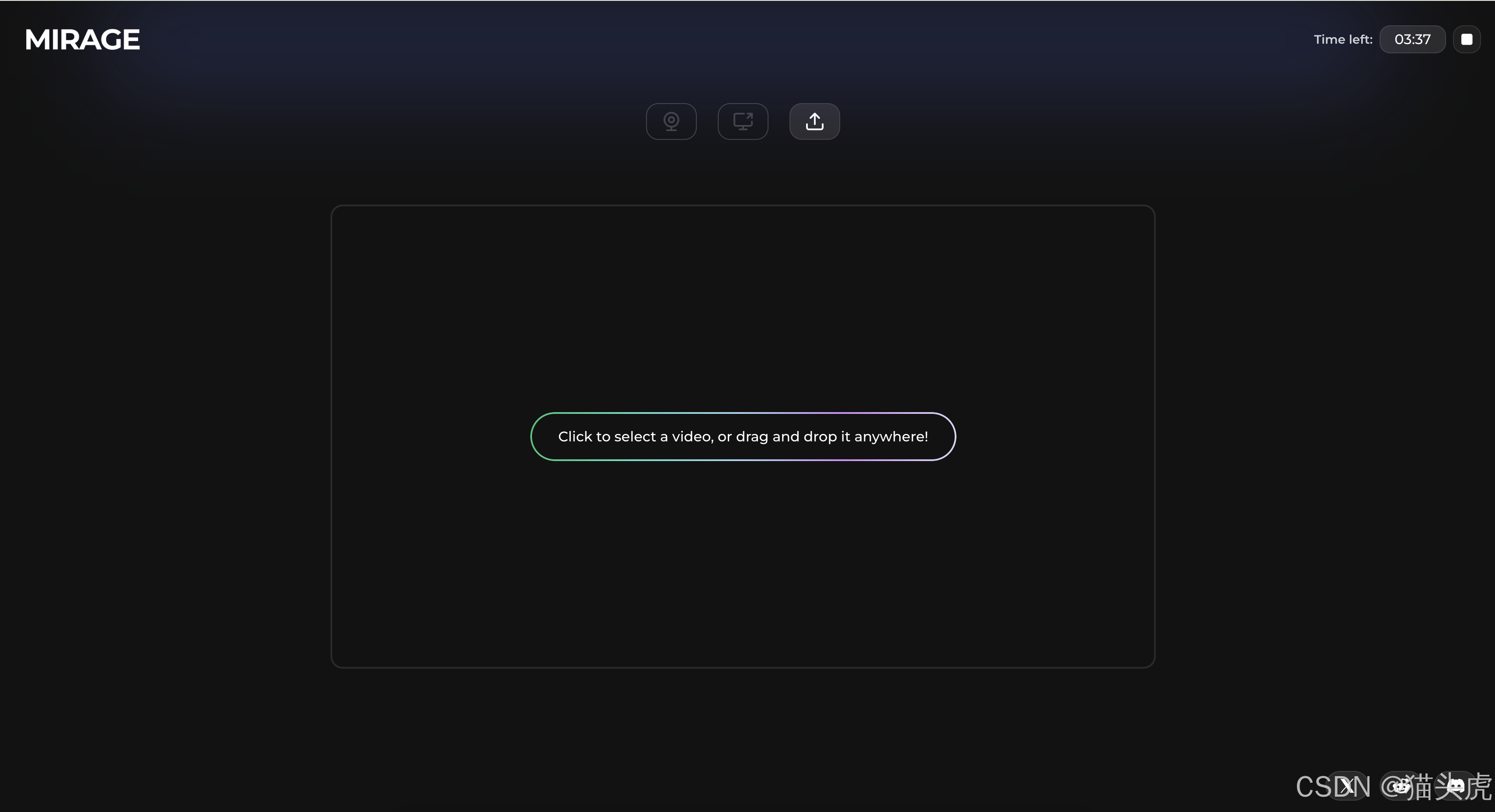

视频输入:支持 USB 摄像头、桌面捕获(Windows/macOS)、WebRTC 视频聊天流、Unity/Unreal 等游戏引擎插件。

交互控制:内置简单手势/按键/语音接口,实时调整:

- 场景(城市、森林、科幻等)

- 人物外观(服装、发型、表情)

- 光影效果(夜景、日落、霓虹灯)

输出:推流至 OBS、XSplit,或直接渲染到游戏引擎。

性能优化细节

| 优化点 | 说明 |

|---|---|

| 混合精度推理 (FP16) | 在 NVIDIA Ampere 及以上 GPU 上,几乎不损失画质,速度提升 1.8× |

| TensorRT 动态张量融合 | 合并多次小规模卷积,减少 kernel 启动开销 |

| 异步 CUDA 流 | 解耦光流、扩散采样、超分网络,最大化 GPU 利用率 |

| CPU 预处理加速 | 使用 OpenCV 多线程进行视频解码与缓冲 |

关键性能指标

- 帧率:24 FPS(可调至 30/60,根据硬件能力)

- 端到端延迟:< 40 ms(从视频输入到渲染输出)

- 视频长度:支持无限长流式推理,不会出现显存溢出

- 硬件要求:RTX 3080 及以上(8 GB 显存+)、或对应架构的 AMD GPU

应用场景

- 在线直播:主播可瞬间切换直播背景与服装,无需绿幕。

- 游戏开发:30 分钟内搭建 Demo,MirageLSD 负责所有实时渲染。

- 动画制作:实时预览动画分镜,大幅提升迭代效率。

- 虚拟换衣:电商直播中,观众通过手势切换试衣效果。

上手指南

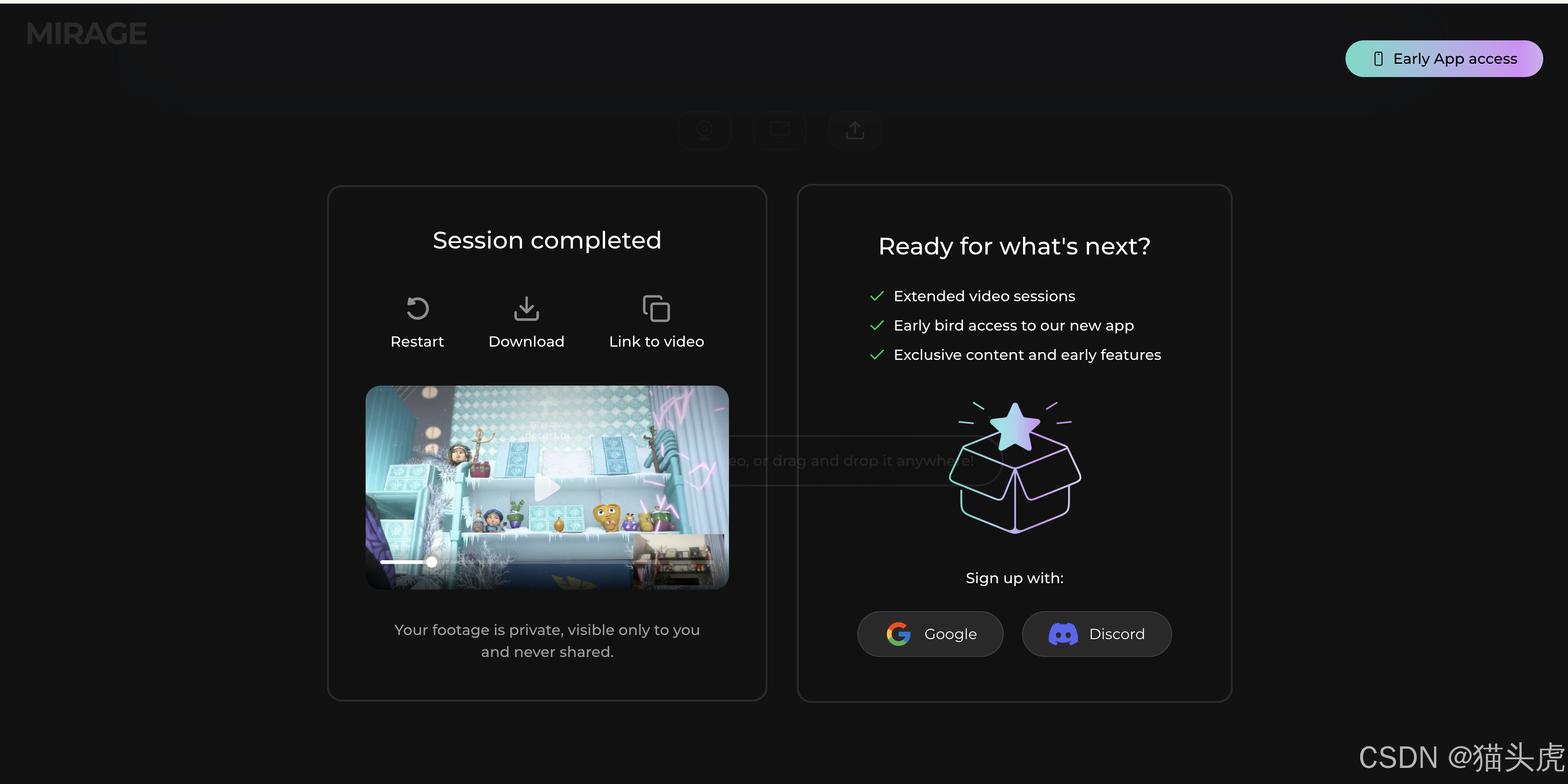

体验在线 Demo

访问:https://mirage.decart.ai/ ,无门槛试玩。安装与调用

# 安装 Python SDK pip install mirage-lsdimport mirage_lsd # 初始化 engine = mirage_lsd.StreamEngine( model="mirage-lsd-v1", device="cuda", fp16=True, max_steps=5, resolution=(720, 1280), ) # 启动摄像头流并渲染到窗口 engine.start(input_source=0, on_frame=engine.render)Unity / Unreal 插件

- Unity Package:

MirageLSD.unitypackage - Unreal Plugin:

MirageLSD.uplugin

双击导入,调用 API 即可:

using MirageLSD; void Start() { var engine = new LSDStreamEngine("mirage-lsd-v1", useGPU: true); engine.BindTexture(outputTexture); engine.StartCapture(); }- Unity Package:

展望与未来

- iOS / Android 版本:下周正式上线,基于 CoreML / MediaPipe 优化,支持手机侧实时 AR 场景转换。

- 更多交互方式:加入语义指令(Text2Video)、多人协同场景切换。

- 开源生态:计划开源模型权重与 API,让研究者与开发者快速创新。

总结

MirageLSD 将扩散模型首次带入 实时视频流 领域,以 低延迟、高质量、无限流长度 为核心特性,赋能直播、游戏、动画、虚拟试衣等多种场景。无论你是主播、游戏开发者,还是动画制作人,这款工具都能让你从繁重的渲染工作中解放出来,专注于创意本身。马上体验在线 Demo,并期待即将到来的移动端版本,开启你的视频场景革新之旅!