0. 引言:C/C++网络编程的困境与突破

在C/C++开发领域,网络编程一直是一个令人头疼的问题。与Python的requests库或Go的net/http包不同,C/C++缺乏统一的包管理体系和标准化的网络API。开发者往往需要面对gcc/msvc版本差异、平台兼容性问题、以及各种编译环境的复杂性。这种状况导致了许多"重复造轮子"的现象——不是开发者愿意重复工作,而是现有的轮子往往无法在特定环境下正常运转。

在实际项目开发中,我们经常遇到这样的场景:在Windows平台上使用Visual Studio 2013开发的网络服务,需要移植到Linux服务器上运行,却发现依赖的boost库版本不兼容,或者系统缺少某些必要的开发包。更糟糕的是,当项目需要在嵌入式设备上部署时,传统的网络库往往因为体积过大或依赖过多而无法使用。这种跨平台兼容性问题不仅增加了开发成本,也延长了项目周期。

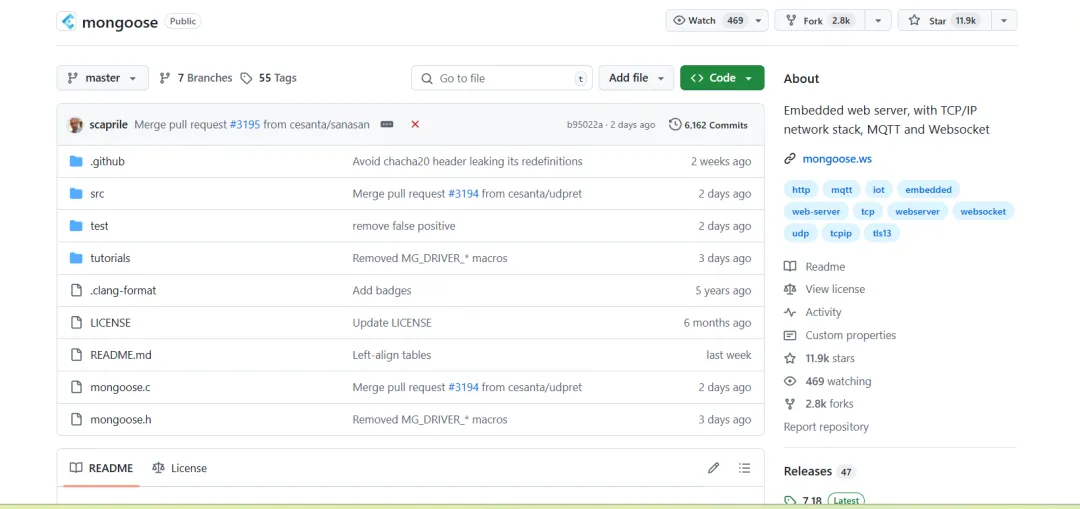

正是在这样的背景下,Mongoose网络库的出现为C/C++开发者提供了一个优雅的解决方案。作为一个轻量级、跨平台的网络库,Mongoose不仅解决了依赖管理的问题,还提供了丰富的协议支持,从简单的HTTP服务到复杂的WebSocket通信,都能轻松应对。更重要的是,Mongoose的设计理念体现了"简单即美"的哲学,整个库的核心文件只有两个:mongoose.c和mongoose.h,这种极简的设计使得集成变得异常简单。

1. Mongoose库概述:设计理念与核心特性

Mongoose是一个用纯C语言编写的网络库,其设计理念体现了"简单即美"的哲学。整个库的核心文件只有两个:mongoose.c和mongoose.h,这种极简的设计使得集成变得异常简单。开发者只需要将这两个文件复制到项目中,就能立即开始网络编程。这种设计思路与传统的网络库形成了鲜明对比,后者往往需要复杂的配置和依赖管理。

1.1 核心特性分析

Mongoose的核心特性可以从以下几个方面来理解:

1. 跨平台兼容性

Mongoose支持Windows、Linux、macOS、Android等主流操作系统,甚至在嵌入式系统如STM32、ESP32等MCU上也能良好运行。这种广泛的平台支持得益于其底层的抽象设计,将平台相关的网络操作封装在统一的API之下。在实际开发中,这意味着开发者可以编写一套代码,然后在不同的平台上编译运行,大大提高了开发效率和代码复用性。

2. 协议支持丰富

库内置了对HTTP、HTTPS、WebSocket、MQTT、TCP、UDP等多种协议的支持。这种全面的协议覆盖使得开发者可以用同一套代码处理不同的网络需求,大大提高了开发效率。特别是在物联网应用中,设备可能需要同时支持HTTP API接口、WebSocket实时通信和MQTT消息队列,Mongoose的协议支持让这些需求变得简单易实现。

3. 事件驱动架构

Mongoose采用事件驱动的编程模型,通过回调函数处理各种网络事件。这种设计模式特别适合处理高并发的网络应用,避免了传统多线程编程中的锁竞争问题。事件驱动架构的核心思想是:当网络事件发生时,系统会调用相应的回调函数来处理事件,而不是通过轮询或阻塞等待的方式。这种设计使得系统能够高效地处理大量并发连接。

4. 轻量级设计

整个库的代码量控制在合理范围内,内存占用小,启动速度快。这使得Mongoose特别适合资源受限的嵌入式环境。在实际测试中,Mongoose的内存占用通常在几十KB到几百KB之间,这对于嵌入式设备来说是非常理想的。同时,库的启动时间也很短,通常在毫秒级别,这对于需要快速响应的应用场景非常重要。

1.2 架构核心组件解析

1. 连接管理器(mg_mgr)

mg_mgr是Mongoose的核心数据结构,负责管理所有的网络连接。它内部维护着一个连接链表,通过事件循环统一处理所有连接上的事件。连接管理器的主要职责包括:创建和销毁连接、管理连接的生命周期、分发网络事件到相应的连接对象。这种集中式的连接管理方式使得系统能够高效地处理大量并发连接,同时保持代码的简洁性。

2. 连接对象(mg_connection)

每个网络连接都由一个mg_connection对象表示,包含了连接的状态信息、协议类型、用户数据等。这个对象贯穿整个连接的生命周期,从连接建立到数据交换再到连接关闭。连接对象的设计考虑了多种协议的需求,通过标志位来区分不同的协议类型,如HTTP、WebSocket、TCP等。这种设计使得同一个连接对象可以处理不同类型的网络协议。

3. 事件回调机制

通过ev_handler回调函数处理各种网络事件,如连接建立、数据接收、连接关闭等。这种设计使得代码结构清晰,易于维护。事件回调机制的核心优势在于:它将网络I/O操作与业务逻辑分离,开发者只需要关注业务逻辑的实现,而网络底层的复杂性由库来处理。这种分离使得代码更加模块化,也更容易进行单元测试。

4. 事件循环(mg_mgr_poll)

mg_mgr_poll函数是事件循环的核心,它会检查所有连接上的事件,并调用相应的回调函数。这个函数是非阻塞的,通过超时参数控制检查频率。事件循环的设计采用了非阻塞I/O模型,这意味着系统不会因为某个连接的数据未到达而阻塞整个程序。相反,系统会定期检查所有连接的状态,只处理有事件发生的连接,这种设计大大提高了系统的并发处理能力。

2. 基础架构:单线程事件循环模型

Mongoose的基础架构基于单线程事件循环模型,这种设计模式在现代网络编程中非常流行。让我们通过一个简单的HTTP服务器示例来理解这个架构:

#include "mongoose.h"

// 事件处理回调函数

static void ev_handler(struct mg_connection *nc, int ev, void *p)

{

// 处理HTTP请求事件

if (ev == MG_EV_HTTP_REQUEST) {

// 发送HTTP响应

mg_printf(nc, "%s",

"HTTP/1.1 200 OK\r\n"

"Content-Type: text/plain\r\n"

"Content-Length: 2\r\n"

"\r\n"

"OK");

}

}

int main(void)

{

struct mg_mgr mgr;

struct mg_connection *nc;

// 初始化连接管理器

mg_mgr_init(&mgr, NULL);

// 绑定端口并设置回调函数

nc = mg_bind(&mgr, "8000", ev_handler);

if (nc == NULL) {

printf("Failed to create listener\n");

return 1;

}

// 启用HTTP和WebSocket协议支持

mg_set_protocol_http_websocket(nc);

// 主事件循环

for (;;) {

mg_mgr_poll(&mgr, 1000); // 1000ms超时

}

// 清理资源

mg_mgr_free(&mgr);

return 0;

}

2.1 事件循环机制深度解析

事件循环是Mongoose架构的核心,它采用非阻塞I/O模型来处理网络事件。当程序调用mg_mgr_poll函数时,系统会检查所有注册的连接,查看是否有新的网络事件发生。如果有事件发生,系统会调用相应的回调函数来处理事件;如果没有事件发生,函数会在指定的超时时间后返回,让程序可以执行其他任务。

这种设计模式的优势在于:首先,它避免了传统多线程编程中的锁竞争问题,因为所有网络操作都在同一个线程中进行;其次,它减少了系统资源的消耗,因为不需要为每个连接创建独立的线程;最后,它简化了编程模型,开发者不需要考虑线程同步和竞态条件的问题。

在实际应用中,事件循环的超时参数设置非常重要。如果超时时间设置得太短,系统会频繁地检查网络事件,增加CPU使用率;如果设置得太长,系统对网络事件的响应会变得迟钝。通常建议将超时时间设置在100-1000毫秒之间,这样既能保证及时响应网络事件,又不会过度消耗系统资源。

2.2 连接管理机制详解

Mongoose的连接管理机制设计得非常精巧。每个网络连接都由一个mg_connection对象表示,这个对象包含了连接的所有状态信息。当新的客户端连接到服务器时,系统会创建一个新的mg_connection对象,并将其添加到连接管理器的连接链表中。

连接对象的状态管理是自动的,系统会根据网络事件自动更新连接状态。例如,当收到HTTP请求时,连接状态会被标记为正在处理请求;当响应发送完成后,连接状态会被更新为等待新请求。这种自动状态管理大大简化了开发者的工作,开发者只需要关注业务逻辑的实现,而不需要手动管理连接状态。

连接对象的生命周期管理也是自动的。当客户端断开连接时,系统会自动检测到这个事件,调用相应的回调函数,然后释放连接对象占用的内存。这种自动内存管理避免了内存泄漏的问题,提高了程序的稳定性。

2.3 事件类型与处理机制

Mongoose定义了丰富的事件类型,每种事件类型都有特定的用途和处理方式。主要的网络事件包括:

连接建立事件(MG_EV_ACCEPT)

当服务器接受新的客户端连接时,会触发这个事件。在这个事件的处理函数中,开发者通常需要进行一些初始化工作,比如设置连接的用户数据、初始化协议状态等。这个事件是连接生命周期的开始,为后续的数据交换做准备。

HTTP请求事件(MG_EV_HTTP_REQUEST)

当服务器收到HTTP请求时,会触发这个事件。事件数据包含了完整的HTTP请求信息,包括请求方法、URI、请求头、请求体等。开发者可以解析这些信息,然后根据业务逻辑生成相应的HTTP响应。这个事件是HTTP服务器的核心,大部分业务逻辑都在这里实现。

WebSocket握手事件(MG_EV_WEBSOCKET_HANDSHAKE_REQUEST)

当客户端发起WebSocket握手请求时,会触发这个事件。Mongoose会自动处理WebSocket握手过程,开发者只需要在这个事件中决定是否接受连接。如果接受连接,系统会自动完成握手过程;如果拒绝连接,可以返回相应的HTTP错误响应。

WebSocket数据事件(MG_EV_WEBSOCKET_FRAME)

当WebSocket连接收到数据帧时,会触发这个事件。事件数据包含了接收到的数据内容和帧类型信息。开发者可以解析这些数据,然后根据业务逻辑进行处理。这个事件是WebSocket应用的核心,用于实现实时双向通信。

连接关闭事件(MG_EV_CLOSE)

当连接关闭时,会触发这个事件。在这个事件的处理函数中,开发者通常需要进行一些清理工作,比如释放相关的资源、更新连接状态等。这个事件是连接生命周期的结束,确保系统资源的正确释放。

3. 多线程架构:从单线程到并发处理

虽然Mongoose的基础架构是单线程的,但在实际应用中,我们往往需要处理并发请求。Mongoose提供了多线程支持,但实现方式有其特殊性。让我们深入分析多线程架构的设计思路:

3.1 多线程架构的核心思想

Mongoose的多线程架构基于一个重要的设计原则:网络I/O操作必须在主线程中进行,业务逻辑处理可以在工作线程中进行。这种设计避免了多线程环境下的竞态条件,保证了网络操作的线程安全。这种架构模式在现代网络编程中被称为"主线程+工作线程池"模式,它结合了事件驱动和多线程的优势。

在实际应用中,这种架构模式的优势非常明显。主线程专门负责网络I/O操作,包括接收连接、读取数据、发送响应等,这些操作都是非阻塞的,可以高效地处理大量并发连接。工作线程负责处理业务逻辑,如数据库查询、文件操作、复杂计算等,这些操作可能是耗时的,放在独立的工作线程中不会影响网络I/O的性能。

这种分离设计还带来了另一个重要优势:简化了错误处理。网络错误和业务逻辑错误被清晰地分离,开发者可以针对不同类型的错误采用不同的处理策略。例如,网络错误可能需要重试机制,而业务逻辑错误可能需要回滚事务。

3.2 官方多线程示例分析

#include "mongoose.h"

static sig_atomic_t s_received_signal = 0;

static const char *s_http_port = "8000";

static const int s_num_worker_threads = 5;

static unsigned long s_next_id = 0;

// 工作请求结构体

struct work_request {

unsigned long conn_id; // 连接标识符

// 其他业务数据

};

// 工作结果结构体

struct work_result {

unsigned long conn_id;

int sleep_time;

};

// 工作完成回调函数

static void on_work_complete(struct mg_connection *nc, int ev, void *ev_data) {

struct mg_connection *c;

for (c = mg_next(nc->mgr, NULL); c != NULL; c = mg_next(nc->mgr, c)) {

if (c->user_data != NULL) {

struct work_result *res = (struct work_result *)ev_data;

if ((unsigned long)c->user_data == res->conn_id) {

char s[32];

sprintf(s, "conn_id:%lu sleep:%d", res->conn_id, res->sleep_time);

mg_send_head(c, 200, strlen(s), "Content-Type: text/plain");

mg_printf(c, "%s", s);

}

}

}

}

// 工作线程函数

void *worker_thread_proc(void *param) {

struct mg_mgr *mgr = (struct mg_mgr *) param;

struct work_request req = {0};

while (s_received_signal == 0) {

if (read(sock[1], &req, sizeof(req)) < 0)

perror("Reading worker sock");

// 模拟业务处理

int r = rand() % 10;

sleep(r);

// 通过广播机制返回结果

struct work_result res = {req.conn_id, r};

mg_broadcast(mgr, on_work_complete, (void *)&res, sizeof(res));

}

return NULL;

}

// 主事件处理函数

static void ev_handler(struct mg_connection *nc, int ev, void *ev_data) {

switch (ev) {

case MG_EV_ACCEPT:

nc->user_data = (void *)++s_next_id;

break;

case MG_EV_HTTP_REQUEST: {

struct work_request req = {(unsigned long)nc->user_data};

// 将请求发送到工作线程

if (write(sock[0], &req, sizeof(req)) < 0)

perror("Writing worker sock");

break;

}

case MG_EV_CLOSE: {

if (nc->user_data) nc->user_data = NULL;

}

}

}

3.3 多线程通信机制详解

1. Socket Pair通信

官方示例使用socketpair创建一对相互连接的socket,用于主线程和工作线程之间的通信。主线程通过sock[0]发送请求,工作线程通过sock[1]接收请求。这种通信方式的选择有其深层次的原因:首先,socket pair是系统级的IPC机制,性能高效且稳定;其次,它支持非阻塞I/O,不会因为工作线程处理速度慢而阻塞主线程;最后,它是跨平台的,在不同操作系统上都有良好的支持。

在实际应用中,socket pair通信的配置非常重要。需要设置适当的缓冲区大小,避免因为缓冲区满而导致通信阻塞。同时,还需要处理通信过程中的异常情况,如socket关闭、数据损坏等。这些异常处理机制确保了系统的稳定性和可靠性。

2. 广播机制(mg_broadcast)

mg_broadcast是Mongoose多线程架构的核心函数,它允许工作线程向主线程发送消息,触发回调函数在主线程中执行。这种设计确保了所有网络I/O操作都在主线程中进行。广播机制的工作原理是:工作线程调用mg_broadcast函数,将消息发送到主线程的事件队列中,主线程在下次事件循环中处理这些消息。

广播机制的设计考虑了多种应用场景。它可以向所有连接广播消息,也可以向特定的连接发送消息。这种灵活性使得开发者可以根据具体需求选择合适的通信方式。例如,在聊天应用中,可以向所有在线用户广播消息;在API服务中,可以向特定客户端发送响应。

3. 连接标识符管理

每个连接都有一个唯一的标识符(conn_id),用于在多线程环境中识别特定的连接。这个标识符存储在user_data字段中,在连接建立时分配。连接标识符的管理是多线程架构中的关键问题,需要确保标识符的唯一性和正确性。

在实际实现中,连接标识符的生成需要考虑并发安全性。通常使用原子操作或锁机制来确保标识符的唯一性。同时,还需要考虑标识符的回收和重用问题,避免标识符耗尽的情况。这些细节的实现直接影响系统的稳定性和性能。

3.4 多线程架构的挑战与解决方案

3.4.1 挑战1:数据生命周期管理

在多线程环境中,事件数据的生命周期管理是一个重要问题。事件回调函数返回后,相关数据可能被销毁,因此需要在回调中及时保存必要的数据。这个问题的复杂性在于:不同的事件类型包含不同的数据结构,需要针对性地进行数据保存。

解决方案:数据复制

// 保存HTTP请求数据

http_message *msg = (http_message *)event_data;

MG_EVENT_DATA_PTR cbdata = new MG_EVENT_DATA;

cbdata->event_type = event_type;

cbdata->body.assign(msg->body.p, msg->body.len);

cbdata->method.assign(msg->method.p, msg->method.len);

cbdata->uri.assign(msg->uri.p, msg->uri.len);

// ... 保存其他必要数据

数据复制的策略需要根据具体的应用场景来设计。对于简单的数据,可以直接复制;对于复杂的数据结构,可能需要深拷贝;对于大数据,可能需要考虑引用计数或共享指针等机制。这些策略的选择需要在性能和内存使用之间找到平衡。

3.4.2 挑战2:内存管理

在多线程环境中,内存管理变得更加复杂。特别是当连接断开时,需要确保相关的内存资源得到正确释放。这个问题的复杂性在于:多个线程可能同时访问同一块内存,需要确保内存访问的线程安全性。

解决方案:智能指针和引用计数

// 使用智能指针管理内存

std::shared_ptr<MG_EVENT_DATA> cbdata =

std::make_shared<MG_EVENT_DATA>();

// 在回调中检查连接状态

if (nc == NULL) {

// 连接已断开,清理资源

delete data;

return;

}

智能指针的使用大大简化了内存管理,但需要注意一些细节。首先,智能指针的引用计数操作是原子的,但访问智能指针指向的对象不是原子的,需要额外的同步机制。其次,智能指针的析构函数在哪个线程中执行需要仔细考虑,避免在错误的线程中释放资源。

3.5 性能优化与调优

多线程架构的性能优化是一个复杂的问题,需要考虑多个方面的因素。首先,工作线程的数量需要根据系统的CPU核心数和业务特点来调整。线程数量太少会导致处理能力不足,太多会导致线程切换开销过大。

其次,线程间的通信开销需要最小化。socket pair通信虽然稳定,但每次通信都有系统调用开销。对于高频通信场景,可以考虑使用无锁队列或共享内存等更高效的通信方式。

最后,负载均衡策略也很重要。简单的轮询分配可能不够均衡,需要考虑基于负载的动态分配策略。这种策略可以根据工作线程的当前负载情况,动态调整任务分配,提高整体处理效率。

4. 高级特性:WebSocket支持与实时通信

WebSocket是现代Web应用中不可或缺的技术,它提供了全双工的通信能力。Mongoose对WebSocket的支持非常完善,让我们深入了解其实现机制:

4.1 WebSocket握手过程

WebSocket连接的建立需要经过HTTP升级握手过程。Mongoose自动处理了这个过程:

static void ev_handler(struct mg_connection *nc, int ev, void *ev_data) {

switch (ev) {

case MG_EV_WEBSOCKET_HANDSHAKE_REQUEST:

// WebSocket握手请求

// Mongoose会自动处理握手过程

break;

case MG_EV_WEBSOCKET_HANDSHAKE_DONE:

// 握手完成,连接升级为WebSocket

printf("WebSocket connection established\n");

break;

case MG_EV_WEBSOCKET_FRAME:

// 接收WebSocket数据帧

{

struct websocket_message *wm = (struct websocket_message *) ev_data;

printf("Received: %.*s\n", (int) wm->size, wm->data);

// 发送响应

mg_send_websocket_frame(nc, WEBSOCKET_OP_TEXT, wm->data, wm->size);

}

break;

}

}

WebSocket握手过程的技术细节非常复杂,但Mongoose将其封装得相当简单。当客户端发起WebSocket连接时,会发送一个特殊的HTTP请求,包含Upgrade: websocket头部和Sec-WebSocket-Key等WebSocket特有的头部。Mongoose会自动解析这些头部,验证握手请求的有效性,然后生成相应的握手响应。

握手过程的安全性非常重要,Mongoose实现了完整的WebSocket协议规范,包括密钥验证、协议版本检查等。这种自动化的握手处理大大简化了开发者的工作,开发者只需要关注业务逻辑的实现,而不需要处理复杂的协议细节。

在实际应用中,WebSocket握手还可以包含自定义的验证逻辑。例如,可以在握手过程中验证用户的身份信息,或者检查连接的地理位置等。Mongoose提供了灵活的接口来支持这些自定义验证需求。

4.2 WebSocket数据帧处理

WebSocket协议定义了多种数据帧类型,Mongoose提供了相应的处理机制:

// WebSocket数据帧类型

#define WEBSOCKET_OP_CONTINUE 0x0

#define WEBSOCKET_OP_TEXT 0x1

#define WEBSOCKET_OP_BINARY 0x2

#define WEBSOCKET_OP_CLOSE 0x8

#define WEBSOCKET_OP_PING 0x9

#define WEBSOCKET_OP_PONG 0xa

// 发送WebSocket数据帧

void send_websocket_message(struct mg_connection *nc, const char *data, size_t len) {

mg_send_websocket_frame(nc, WEBSOCKET_OP_TEXT, data, len);

}

// 发送二进制数据

void send_binary_data(struct mg_connection *nc, const void *data, size_t len) {

mg_send_websocket_frame(nc, WEBSOCKET_OP_BINARY, data, len);

}

WebSocket数据帧的处理是实时通信的核心。Mongoose支持所有标准的WebSocket数据帧类型,包括文本帧、二进制帧、控制帧等。每种帧类型都有特定的用途和处理方式,开发者可以根据应用需求选择合适的帧类型。

文本帧(WEBSOCKET_OP_TEXT)通常用于传输JSON、XML等结构化数据,这些数据便于解析和处理。二进制帧(WEBSOCKET_OP_BINARY)用于传输图片、音频、视频等二进制数据,这些数据通常体积较大,需要特殊的内存管理策略。

控制帧(PING、PONG、CLOSE)用于连接的管理和维护。PING/PONG帧用于检测连接的有效性,CLOSE帧用于优雅地关闭连接。Mongoose会自动处理这些控制帧,确保连接的稳定性和可靠性。

4.3 实时通信应用示例

下面是一个完整的WebSocket聊天室示例:

#include "mongoose.h"

#include <map>

#include <string>

struct chat_room {

std::map<struct mg_connection *, std::string> clients;

};

static void broadcast_message(struct mg_connection *nc, const char *msg, size_t len) {

struct mg_connection *c;

for (c = mg_next(nc->mgr, NULL); c != NULL; c = mg_next(c->mgr, c)) {

if (c->flags & MG_F_IS_WEBSOCKET) {

mg_send_websocket_frame(c, WEBSOCKET_OP_TEXT, msg, len);

}

}

}

static void ev_handler(struct mg_connection *nc, int ev, void *ev_data) {

struct chat_room *room = (struct chat_room *) nc->mgr->user_data;

switch (ev) {

case MG_EV_WEBSOCKET_HANDSHAKE_DONE:

printf("Client connected\n");

room->clients[nc] = "Anonymous";

break;

case MG_EV_WEBSOCKET_FRAME:

{

struct websocket_message *wm = (struct websocket_message *) ev_data;

std::string message((char*)wm->data, wm->size);

// 广播消息给所有客户端

std::string broadcast = room->clients[nc] + ": " + message;

broadcast_message(nc, broadcast.c_str(), broadcast.length());

}

break;

case MG_EV_CLOSE:

if (nc->flags & MG_F_IS_WEBSOCKET) {

printf("Client disconnected\n");

room->clients.erase(nc);

}

break;

}

}

int main(void) {

struct mg_mgr mgr;

struct chat_room room;

mg_mgr_init(&mgr, &room);

mg_http_listen(&mgr, "ws://0.0.0.0:8000", ev_handler, NULL);

printf("Chat server started on ws://0.0.0.0:8000\n");

for (;;) {

mg_mgr_poll(&mgr, 1000);

}

mg_mgr_free(&mgr);

return 0;

}

这个聊天室示例展示了WebSocket在实际应用中的典型用法。当客户端连接到服务器时,系统会记录客户端信息;当收到消息时,系统会将消息广播给所有在线用户;当客户端断开连接时,系统会清理相关资源。

4.4 WebSocket性能优化策略

WebSocket应用的性能优化需要考虑多个方面。首先,消息的序列化和反序列化可能成为性能瓶颈,特别是对于复杂的JSON数据。可以考虑使用更高效的序列化格式,如Protocol Buffers或MessagePack。

其次,广播消息的效率很重要。简单的遍历所有连接的方式在连接数量很大时效率较低,可以考虑使用分组广播或消息队列等机制来提高效率。

最后,内存管理也需要特别注意。WebSocket连接通常是长连接,需要确保内存使用不会随着时间增长而无限增长。可以考虑使用对象池、内存池等技术来优化内存使用。

4.5 WebSocket安全考虑

WebSocket应用的安全问题不容忽视。首先,需要验证WebSocket握手的有效性,防止恶意客户端利用握手过程进行攻击。其次,需要限制消息的大小和频率,防止DoS攻击。最后,需要考虑数据的加密传输,特别是对于敏感数据的传输。

Mongoose提供了基本的安全机制,但开发者还需要根据具体应用场景添加额外的安全措施。例如,可以实现基于token的身份验证、消息签名验证、连接频率限制等安全机制。

5. 性能优化:从理论到实践

在实际应用中,性能往往是关键考虑因素。让我们分析Mongoose的性能特性以及优化策略:

5.1 性能基准测试

为了评估Mongoose的性能表现,我们可以进行一些基准测试:

#include "mongoose.h"

#include <chrono>

#include <thread>

// 性能测试结构

struct performance_test {

int total_requests;

int concurrent_connections;

std::chrono::high_resolution_clock::time_point start_time;

std::atomic<int> completed_requests{0};

};

static void performance_handler(struct mg_connection *nc, int ev, void *ev_data) {

if (ev == MG_EV_HTTP_REQUEST) {

// 简单的响应,用于测试吞吐量

mg_printf(nc,

"HTTP/1.1 200 OK\r\n"

"Content-Type: text/plain\r\n"

"Content-Length: 13\r\n"

"\r\n"

"Hello, World!");

}

}

// 客户端压力测试

void run_performance_test(const char *url, int connections, int requests_per_conn) {

struct mg_mgr mgr;

mg_mgr_init(&mgr, NULL);

auto start = std::chrono::high_resolution_clock::now();

// 创建多个连接

for (int i = 0; i < connections; i++) {

mg_http_connect(&mgr, url, performance_handler, NULL);

}

// 运行测试

for (int i = 0; i < requests_per_conn * connections; i++) {

mg_mgr_poll(&mgr, 1);

}

auto end = std::chrono::high_resolution_clock::now();

auto duration = std::chrono::duration_cast<std::chrono::milliseconds>(end - start);

printf("Performance test completed in %lld ms\n", duration.count());

mg_mgr_free(&mgr);

}

性能基准测试是评估网络库性能的重要手段。通过系统性的测试,我们可以了解Mongoose在不同负载条件下的表现,包括吞吐量、延迟、内存使用等关键指标。这些测试结果可以帮助开发者选择合适的配置参数,优化应用性能。

在实际测试中,需要考虑多种测试场景。首先是并发连接数测试,评估系统能够同时处理的最大连接数;其次是请求吞吐量测试,评估系统每秒能够处理的请求数量;最后是延迟测试,评估系统响应用户请求的时间。

测试环境的配置也很重要。需要确保测试环境的网络条件、硬件配置等与实际部署环境相似,这样才能得到有意义的测试结果。同时,还需要考虑测试的持续时间,短时间的测试可能无法反映系统的长期稳定性。

5.2 性能优化策略

1. 连接池管理

对于高并发应用,连接池是提高性能的重要手段:

class ConnectionPool {

private:

std::vector<struct mg_connection*> connections;

std::mutex pool_mutex;

public:

struct mg_connection* get_connection(struct mg_mgr *mgr) {

std::lock_guard<std::mutex> lock(pool_mutex);

if (connections.empty()) {

return mg_bind(mgr, "0.0.0.0:0", nullptr);

}

struct mg_connection* conn = connections.back();

connections.pop_back();

return conn;

}

void return_connection(struct mg_connection* conn) {

std::lock_guard<std::mutex> lock(pool_mutex);

connections.push_back(conn);

}

};

连接池的设计需要考虑多个因素。首先是池的大小,需要根据预期的并发连接数来设置。池太小会导致连接创建的开销,池太大会浪费内存资源。其次是连接的复用策略,需要考虑连接的健康状态、使用时间等因素。

连接池的实现还需要考虑线程安全性。多个线程可能同时访问连接池,需要使用适当的同步机制来确保数据的一致性。同时,还需要考虑连接池的动态调整,根据实际负载情况动态调整池的大小。

2. 内存池优化

频繁的内存分配和释放会影响性能,使用内存池可以显著提高性能:

template<typename T>

class MemoryPool {

private:

std::vector<T*> pool;

std::mutex pool_mutex;

public:

T* allocate() {

std::lock_guard<std::mutex> lock(pool_mutex);

if (pool.empty()) {

return new T();

}

T* obj = pool.back();

pool.pop_back();

return obj;

}

void deallocate(T* obj) {

std::lock_guard<std::mutex> lock(pool_mutex);

pool.push_back(obj);

}

};

内存池的设计需要考虑对象的大小和生命周期。对于小对象,可以使用固定大小的内存池;对于大对象,可以使用可变大小的内存池。同时,还需要考虑内存池的清理策略,避免内存泄漏。