LLaMA-Adapter: Efficient Fine-tuning of Language Models with Zero-init Attention

Authors: Renrui Zhang, Jiaming Han, Chris Liu, Peng Gao, Aojun Zhou, Xiangfei Hu, Shilin Yan, Pan Lu, Hongsheng Li, Yu Qiao

Deep-Dive Summary:

LLAMA-ADAPTER:基于零初始化注意力的高效大语言模型微调

作者:Renrui Zhang1,2, Jiaming Han1,2, Chris Liu1, Aojun Zhou², Pan Lu?, Yu Qiao1, Hongsheng Li2,4, Peng Gao1

机构:1上海人工智能实验室, 2香港中文大学多媒体实验室, 3加州大学洛杉矶分校, 4香港创新科技中心CPII

联系方式:{zhangrenrui, hanjiaming, gaopeng, qiaoyu}@pjlab.org.cn, hsli@ee.cuhk.edu.hk

摘要

随着大型语言模型(LLMs)的兴起,开发通用指令跟随模型(如ChatGPT)的兴趣日益增加。为此,我们提出了LLaMA-Adapter,一种轻量级的适配方法,用于LLaMA的高效指令微调。使用52K条自指令演示数据,LLaMA-Adapter在冻结的LLaMA 7B模型上仅引入了1.2M个可学习参数,并且微调时间不到一小时。具体来说,我们提出了一种零初始化注意力机制,通过一个可学习的零门控机制,自适应地将指令线索注入到LLaMA的自注意力层中,有助于稳定的训练过程和卓越的最终性能。通过这种方式,LLaMA-Adapter能够生成高质量的响应,应对多样化的语言指令,其效果与完全微调的Alpaca 7B参数模型相当。除了语言指令外,通过集成图像编码器,我们的方法可以轻松扩展为多模态LLM,用于图像条件指令跟随,在多个热门基准测试(如MME、MMBench、LVLM-eHub)上展现出卓越的多模态推理能力。此外,我们还验证了所提出的零初始化注意力机制在其他预训练模型(如ViT、RoBERTa、CLIP)上的微调效果,应用于传统的视觉和语言任务,证明了我们方法的有效性和泛化能力。代码和模型已发布于 https://github.com/OpenGVLab/LLaMA-Adapter。

1 引言

大型语言模型(LLMs)(Dai 等人,2019;Radford 等人,2019;Zhang 等人,2022;Raffel 等人,2020;Devlin 等人,2018)在学术界和工业界引起了广泛关注。得益于海量语料库和先进硬件的驱动,LLMs 展现了出色的理解能力和生成能力,例如遵循语言指令并生成上下文响应的指令跟随模型,如 ChatGPT(OpenAI, 2023a)和 GPT-4(OpenAI, 2023b)。然而,指令模型的进一步普及在很大程度上受到闭源限制和高昂开发成本的阻碍。为解决这一问题,斯坦福 Alpaca(Taori 等人,2023)提出对一个开源 LLM,即 LLaMA(Touvron 等人,2023)进行微调,使其成为一个经济且可复制的指令跟随模型。从 175 个人工编写的指令-输出对(Wang 等人,2022a)开始,Alpaca 利用 GPT-3.5(Brown 等人,2020)以自指令方式将训练数据扩展至 52K 条。通过这些数据的监督,Alpaca 对 LLaMA 的全部 70 亿参数进行微调,生成一个与 GPT-3.5 性能相似的优秀指令模型。尽管 Alpaca 效果显著,但对大规模 LLaMA 进行完整微调仍然耗时长、计算密集,且难以适应不同的下游场景。

在本文中,我们介绍了 LLaMA-Adapter,一种高效的微调方法,将 LLaMA 适应为性能优异的指令跟随模型。使用 Alpaca 的指令-输出数据进行训练,我们的方法冻结了整个 LLaMA 模型,并提出了一种资源效率极高的零初始化注意力机制。具体来说,在 LLaMA 的较高变换层中,我们将一组可学习的适应提示作为前缀附加到词语标记上。然后,通过一个可学习的门控因子来避免噪声干扰,该门控机制初始化为零,并在注意力计算过程中控制提示与词语标记之间的特征交互。这一策略首先保留了 LLaMA 的原始知识,并在训练过程中逐步注入新的指令信号。这有助于实现更稳定的学习过程,并提升最终模型的指令跟随能力。

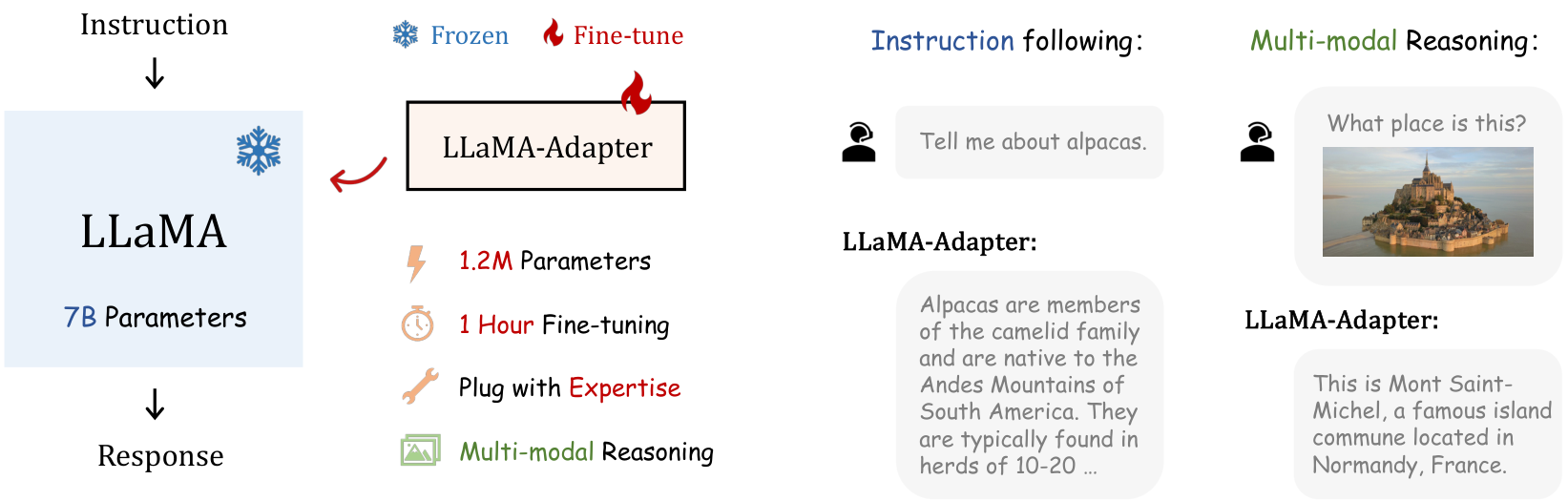

总的来说,我们的 LLaMA-Adapter 展示了如图 1 所示的四个主要特点:

- 120 万参数:我们没有更新全部 70 亿参数,而是冻结了预训练的 LLaMA,仅学习具有 120 万参数的零初始化注意力机制,但其指令跟随能力与 70 亿参数的 Alpaca 相当。

- 一小时微调:得益于零初始化门控的轻量级适应模块,LLaMA-Adapter 的训练收敛在 8 个 A100 GPU 上耗时不到一小时,比 Alpaca 快三倍。

- 专家知识插件:针对不同场景,可以灵活插入各自的适配器,为 LLaMA 赋予不同的专家知识或新模态输入。因此,在每个上下文中存储一个 180 万参数的适配器即可,无需存储 13G 的完整 LLaMA 副本。

- 多模态推理:除了语言指令外,我们的方法还可以通过零初始化注意力机制整合图像编码器,成为多模态 LLM。与同期工作(Liu 等人,2023b;Zhu 等人,2023)相比,LLaMA-Adapter 在 MME(Fu 等人,2023)、MMBench(Liu 等人,2023c)和 LVLM-eHub(Xu 等人,2023)基准测试中展现了更高的调优效率和竞争力的推理能力。

除了指令调优外,我们的零初始化注意力机制还可以推广到传统的视觉和语言任务中,用于参数高效的微调。我们将该方法分别应用于预训练的 ViT(Dosovitskiy 等人,2020)、ReBERTa(Liu 等人,2019)和 CLIP(Radford 等人,2021),用于微调视觉、语言和视觉-语言模型。在一系列下游任务中,我们展示了所提出方法对传统任务的有效性。

2 相关工作

语言模型的指令调整

语言模型学习指令方法的子领域通常通过使用高质量的指令-输出数据对来微调预训练的大型语言模型(LLMs)以增强其性能。早期的工作,如 FLAN(Wei 等人,2021)、PromptSource(Bach 等人,2022)和 SUP-NATINST(Wang 等人,2022b),引入了有效的指令调整方法并建立了全面的评估基准。InstructGPT(Ouyang 等人,2022)在指令跟随能力上展示了显著的改进,但其对社区是闭源的。为了促进指令模型的开源,斯坦福 Alpaca(Taori 等人,2023)使用 52K 自指令数据对 LLaMA(Touvron 等人,2023)的全部 70 亿参数进行微调。然而,这种全模型微调在时间和计算资源上效率较低,限制了其在下游应用中的可转移性。在本文中,我们提出了 LLaMA-Adapter,仅在冻结的 LLaMA 之上微调轻量级的零初始化注意力机制,而非更新整个模型的参数。与我们的工作同时进行的其他研究包括 Alpaca-LoRA(alp,2023)、Vicuna(Chiang 等人,2023)和 LLaMA-GPT4(Peng 等人,2023),它们从不同方面改进 Alpaca。Alpaca-LoRA 利用现有的 LoRA(Hu 等人,2021)高效地微调 LLaMA,但受限于原始网络结构,无法扩展到图像输入。相比之下,我们的 LLaMA-Adapter 实现了更高的训练效率,并且可以通过零初始化注意力简单地泛化到多模态 LLM。Vicuna 和 LLaMA-GPT4 则致力于使用 ChatGPT(OpenAI,2023a)和 GPT-4(OpenAI,2023b)构建更高级的指令数据集,而非 Alpaca 的 52K 数据,但它们仍然采用全微调方式,缺乏多模态指令调整的潜力。

参数高效微调

预训练和微调范式在不同的语言和视觉任务中已被证明是非常有效的。与全微调相比,参数高效微调(PEFT)(Paul,2022)方法冻结预训练模型的大部分参数,并旨在在下游任务上展现出类似的能力(Wang 等人,2018;Puzikov & Gurevych,2018)。其中,提示调整(prompt tuning)将一组可训练的标记附加到预训练的大型模型中,这些标记可以插入到输入嵌入(Lester 等人,2021;Liu 等人,2021b)或每个中间层(Li & Liang,2021;Liu 等人,2021a)。LoRA(Hu 等人,2021;Zhang 等人,2023d;Hedegaard 等人,2022)在每个网络权重中引入可训练的秩分解矩阵(Karimi Mahabadi 等人,2021),显示出在大规模生成模型上的良好微调能力(Cuenca & Paul,2023;alp,2023)。适配器(Adapters)(Houlsby 等人,2019)在变换器的每个模块中插入轻量级适配模块,并已被扩展到众多领域(Gesmundo & Dean,2022;Gao 等人,2021;Zhang 等人,2021)。与之前的努力不同,我们提出了 LLaMA-Adapter,带有专门为 LLaMA(Touvron 等人,2023)的指令调整和多模态推理设计的零初始化注意力。一些现有工作采用随机初始化的因子对不同提示标记进行简单的门控组合。而我们的门控因子在训练期间从零开始学习,并被巧妙地整合到自注意力层中。另一分支的工作将零初始化应用于卷积网络(Zhao 等人,2021)、文本到图像扩散模型(ControlNet(Zhang 等人,2023c))或视觉-语言学习(Flamingo(Alayrac 等人,2022))。它们不是需要大规模参数的 PEFT 方法,其动机在于更好的网络级初始化或通过残差连接进行特征级融合,与我们在注意力层内的交互控制有很大不同。

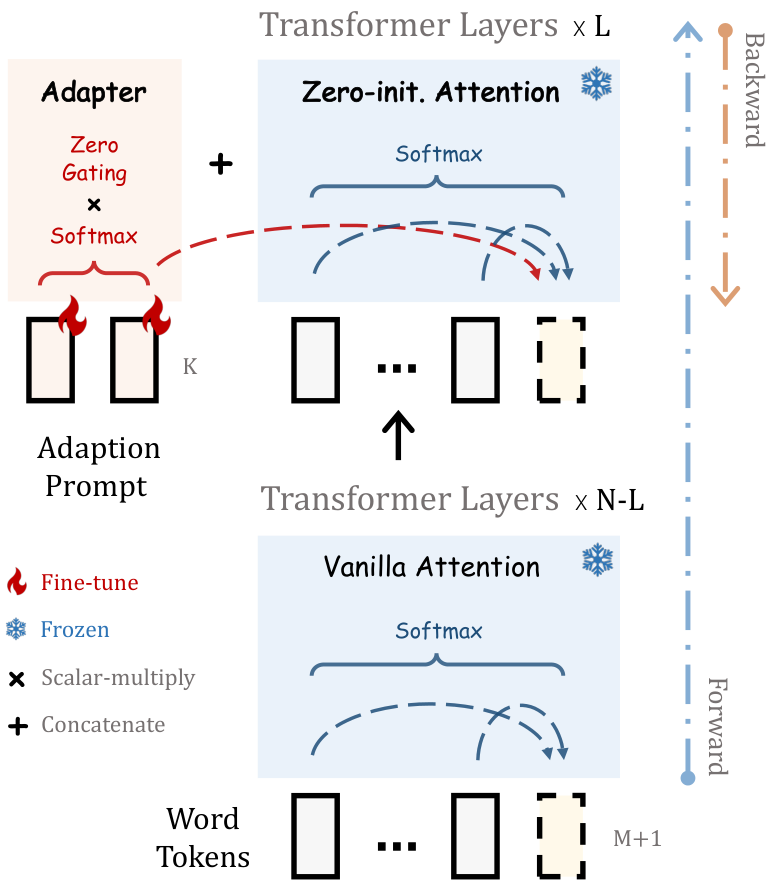

3.2 零初始化注意力机制

在论文的这一部分中,作者提出了“零初始化注意力(Zero-initialized Attention)”机制,以解决随机初始化的适应性提示(adaption prompts)在训练初期对词语标记(word tokens)可能带来的干扰问题。这种干扰会影响微调的稳定性和效果。为此,作者对最后 L L L 层中的普通自注意力机制进行了修改,采用了零初始化的变体,如图2所示。

具体来说,在第 l l l 层插入的模型生成第 ( M + 1 ) (M+1) (M+1) 个词时,基于 [ P t ; T i ] [Pt; Ti] [Pt;Ti] 的输入,相应的第 ( M + 1 ) (M+1) (M+1) 个词标记表示为 t i ∈ R 1 × C t_i \in \mathbb{R}^{1 \times C} ti∈R1×C。在注意力机制中,首先通过几个线性投影层将输入标记转换为查询(queries)、键(keys)和值(values),如下所示:

Θ l ≡ L i n e a r q Ψ l ⟩ . \Theta_{l}\,\equiv\,\mathrm{{Linear}}_{\mathrm{q}}{\bf\Psi}_{l}\,\rangle. Θl≡LinearqΨl⟩.

KaTeX parse error: Undefined control sequence: \O at position 39: …htarrow\,\left[\̲O̲_{1}\L_{1}\L_{1…

KaTeX parse error: Expected group as argument to '\left' at position 136: …{\mathrm{{V}}}}\̲l̲e̲f̲t̲(\ \left[\mathc…

随后,在 softmax 函数之前,计算 Q t Q_t Qt 和 K K K 的注意力分数:

KaTeX parse error: Expected '\right', got '}' at position 93: …eft(\mathrm{J}~}̲~\subseteq~\ver…

这一分数记录了新词 t i t_i ti 与所有 K + M + 1 K + M + 1 K+M+1 个标记之间的特征相似性。同时, S t S_t St 可以由两个部分重新表示:

KaTeX parse error: Double superscript at position 52: …[{\bf S}_{l}^{}^̲{}^{}^{}^{}{\bf…

其中 S K ∈ R K × 1 S^K \in \mathbb{R}^{K \times 1} SK∈RK×1 和 S M + 1 ∈ R ( M + 1 ) × 1 S^{M+1} \in \mathbb{R}^{(M+1) \times 1} SM+1∈R(M+1)×1 分别表示 K K K 个适应性提示和 M + 1 M+1 M+1 个词标记的注意力分数。前者 S K S^K SK 反映了可学习的提示对生成 t i t_i ti 的信息贡献程度,这在训练初期可能引发干扰。

为此,作者引入了一个可学习的门控因子 g l g_l gl,用于自适应地控制 S K S^K SK 在注意力中的重要性。 g l g_l gl 初始化为零,可以在初期消除未充分拟合的提示的影响,随后增加其值以向 LLaMA 提供更多的指令语义。因此,作者对公式6中的两个部分分别应用 softmax 函数,并对第一项乘以 g l g_l gl,表示为:

S l g = [ s o f t m a x ( S l K ) ⋅ t a n h ( g l ) ; s o f t m a x ( S l M + 1 ) ] T , S_{l}^{g}\,=\,\left[\mathrm{softmax}(S_{l}^{K})\cdot\mathrm{tanh}(g_{l});\ \mathrm{softmax}(S_{l}^{M+1})\right]^{T}, Slg=[softmax(SlK)⋅tanh(gl); softmax(SlM+1)]T,

其中激活函数 tanh ( ) \tanh() tanh() 用于将 g l g_l gl 的值调节到 − 1 ∼ 1 -1 \sim 1 −1∼1 的范围内。独立的 softmax 函数确保第二项与适应性提示无关,且不对 s o f t m a x ( S M + 1 ) \mathrm{softmax}(S^{M+1}) softmax(SM+1) 乘以任何系数,以保留其原始概率分布。当 g l g_l gl 接近零时,可以主要传递 LLaMA 预训练的知识给标记 t i t_i ti,从而实现可靠的生成。实践中,作者为注意力机制中的不同头部独立学习多个 g l g_l gl,以增加多头机制的学习多样性。

最后,通过线性投影层计算第 l l l 层注意力机制的输出:

ℓ l O ⟶ I n i l n G a T O ( S U G V l ) ∈ I B 1 × C . \ell_{l}^{\cal O}\;\longrightarrow\;\mathrm{{InilnGaT_{O}}}\left({\cal S}_{\cal U}^{\mathcal G}{\cal V}_{l}\right)\;\;\in\;\mathrm{{I\!B}}^{\bf1\times C}\,. ℓlO⟶InilnGaTO(SUGVl)∈IB1×C.

通过提出的零初始化注意力机制,适应性提示能够逐步将新获取的指令信号注入到 Transformer 中,同时结合 LLaMA 的预训练知识,提供高质量的响应。

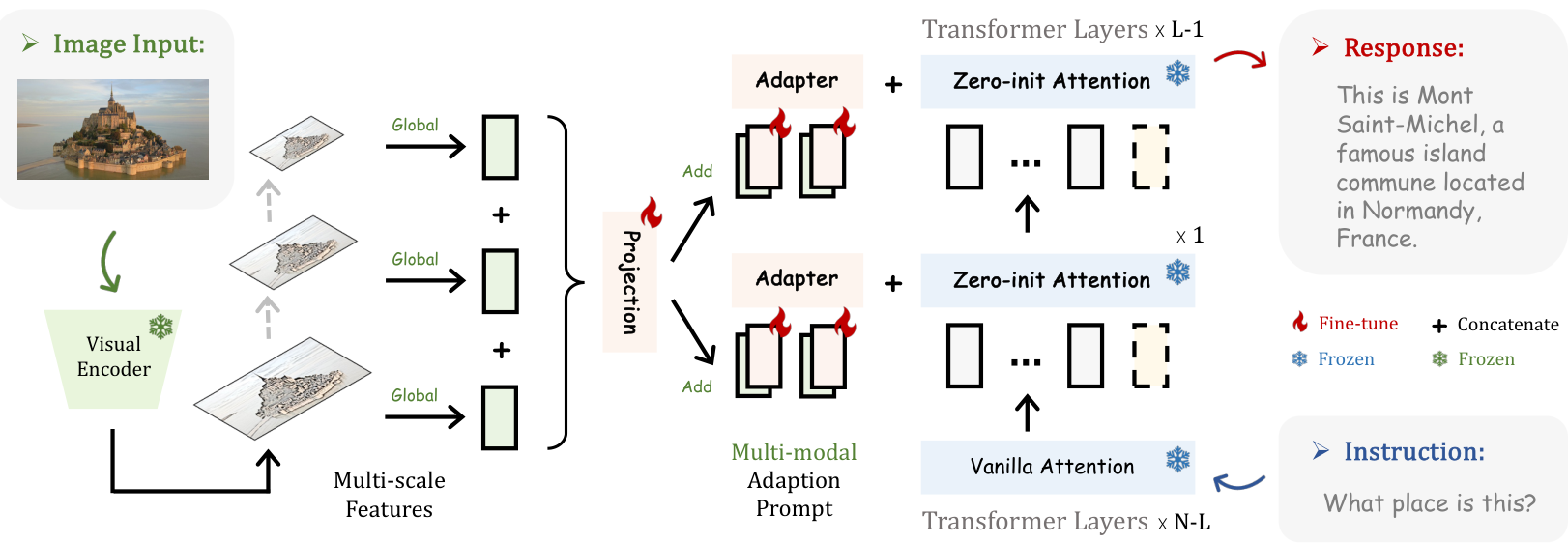

3.3 多模态推理

LLaMA-Adapter 除了能够处理语言指令外,还可以通过简单的修改基于图像输入回答问题。这充分释放了大型语言模型(LLMs)的多模态推理能力,适用于广泛的应用场景,例如图像描述、物体计数和光学字符识别(OCR)。我们多模态 LLaMA-Adapter 的整体框架如图 3 所示。

多模态架构:对于输入图像,我们首先利用预训练的视觉编码器(例如 Im E R1xCm,其中 M 表示尺度数量)提取特征。然后,我们沿着通道维度连接 M 个尺度的特征,并应用一个可学习的投影网络将其转换为词嵌入空间,公式如下:

I p = P r o j e c t i o n ( C o n c a t ( { I m } m = 1 M ) ) , I_{p}=\mathrm{Projection}\left(\mathrm{Concat}\left(\{I_{m}\}_{m=1}^{M}\right)\right), Ip=Projection(Concat({Im}m=1M)),

其中 I p ∈ R 1 × C I_p \in \mathbb{R}^{1 \times C} Ip∈R1×C,被视为整体图像标记,其特征维度与我们的适应提示相同。之后,我们将 I p I_p Ip 重复 K 次,并在所有 L 个插入的 Transformer 层上逐元素地添加到长度为 K 的适应提示中。对于第 l 层,我们将获取的多模态提示表示为:

P l v ⟶ P l + R e p e a t ( I p ) ∈ R K × C , P_{l}^{v}\,\longrightarrow\,P_{l}\,+\,\mathrm{Repeat}(I_{p})\ \ \in\,\mathbb{R}^{K \times C}, Plv⟶Pl+Repeat(Ip) ∈RK×C,

其中 P P P 表示融合了给定图像视觉信息的提示。之后,我们的零初始化注意力机制可以通过零门控因子 g u g_u gu 逐步学习将图像条件语义注入到 LLaMA 中。通过这种方式,大型语言模型可以高效地调整以理解视觉-语言输入,并处理更具挑战性的多模态推理生成任务。

训练策略:我们没有使用 Alpaca 的数据(Taori 等人,2023)进行纯语言指令调整,而是利用多模态指令数据对 LLaMA-Adapter 进行微调,并在两个流行场景中评估性能:

- ScienceQA(Lu 等人,2022)评估:ScienceQA 包含从广泛知识领域收集的大规模科学问答数据。每个样本包含视觉上下文、文本上下文、带有多个选项的问题以及答案。我们直接使用 ScienceQA 的多模态训练集对 LLaMA-Adapter 进行微调,并在域内测试。我们冻结图像编码器和 LLaMA,仅训练轻量级投影网络和零初始化注意力机制。

- 零样本多模态评估:为了验证我们方法在域外生成能力,我们进行了两阶段的多模态训练,然后在三个基准测试(MME(Fu 等人,2023)、MMBench(Liu 等人,2023c)、LVLM-eHub(Xu 等人,2023))上以零样本方式进行评估。第一阶段,我们使用 LAION-400M(Schuhmann 等人,2021)的原始图像-描述数据调整投影网络和零初始化注意力模块,这一步主要是为了对齐视觉特征和词标记之间的嵌入空间。第二阶段,我们冻结投影网络,仅通过 Alpaca 数据和 LLaVA-I(Liu 等人,2023b)的组合调整 LLaMA 内的零初始化注意力。第二阶段旨在赋予大型语言模型基于人类指令生成详细响应的能力。

4 实验

在第 4.1 节中,我们首先评估 LLaMA-Adapter 的语言指令跟随能力。然后,在第 4.2 节中,我们展示在多个基准测试上的多模态推理性能,并在第 4.3 节中对 ScienceQA 的验证集进行消融研究。最后,在第 4.4 节中,我们报告了我们的方法在传统视觉和语言模型上的微调结果。

4.1 指令跟随评估

设置:根据斯坦福 Alpaca(Taori 等人,2023)的做法,我们使用了 52K 条指令跟随数据进行训练。我们在 8 个 A100 GPU 上对 LLaMA-Adapter 进行了 5 个 epoch 的微调。预热 epoch 数、批次大小、学习率和权重衰减分别设置为 2、64、0.009 和 0.02。默认情况下,我们使用具有 7B 参数和 N = 32 N = 32 N=32 个 Transformer 层的预训练 LLaMA 模型。

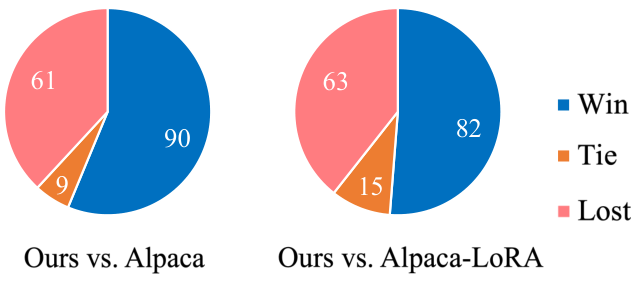

我们采用提示长度 K = 10 K = 10 K=10,并将适应性提示插入到最后 L = 30 L = 30 L=30 层中。对于定量结果,我们与同样使用 52K 指令数据训练的方法 Alpaca(Taori 等人,2023)和 Alpaca-LoRA(alp, 2023)进行比较,并采用一种广泛使用的评估方案,即 GPT-4 评估基准(Chiang 等人,2023)。该基准使用 GPT-4(OpenAI, 2023b)来评估不同模型在 80 个问题上的两种响应质量。

性能:我们首先在图 4 中展示了 LLaMA-Adapter 和 Alpaca 的一些生成响应。对于不同类型的指令,我们的方法可以输出与完全微调的 Alpaca 相当的合理响应,包括问答、语言翻译和代码生成。有关与 Alpaca-LoRA、GPT-3(Brown 等人,2020)和 LLaMA-I(Touvron 等人,2023)的完整比较,请参阅附录。在图 5 的 GPT-4 评估中,LLaMA-Adapter 分别比 Alpaca 和 Alpaca-LoRA 获得了更多的“胜出”。这充分证明了我们使用零初始化注意力机制的适应方法的有效性。

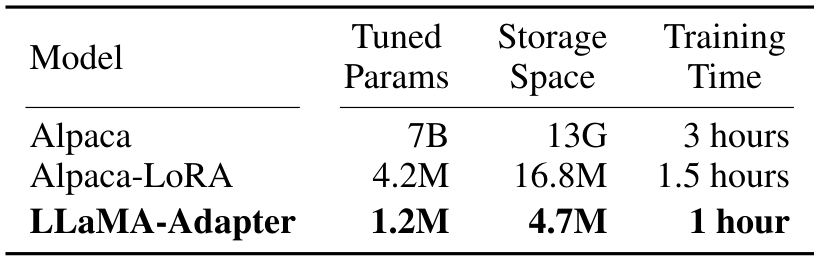

效率:在表 1 中,我们比较了不同指令跟随方法的可学习参数、存储空间和训练时间。作为一个轻量级的即插即用模块,LLaMA-Adapter 仅具有 120 万个参数、4.9M 存储空间和一小时的训练时间,享有卓越的训练效率。这使得在大规模语言模型的移动设备存储上更加高效。LLaMA-Adapter 的效率优势在多节点训练中可以进一步体现,因为只需要在节点之间传输 120 万个参数的梯度,而不像 Alpaca 需要传输 7B 参数的梯度。

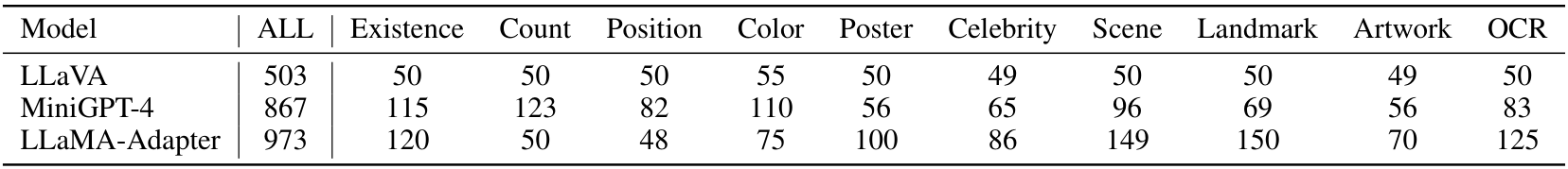

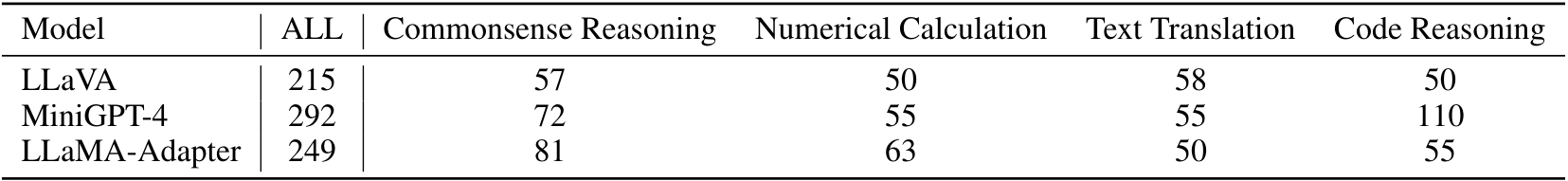

4.2 多模态评估

设置:我们采用 CLIP(Radford 等人,2021)作为图像编码器来提取多尺度视觉特征,并使用一个简单的瓶颈 MLP 层作为可学习的投影网络。其他超参数与语言指令跟随的 LLaMA-Adapter 保持一致。对于 ScienceQA(Lu 等人,2022),我们将给定的问题、文本上下文和选项按顺序连接成一句话作为 LLaMA 的输入。对于零样本多模态评估,我们选择了三个基准测试:MME(Fu 等人,2023)、MMBench(Liu 等人,2023c)和 LVLM-eHub(Xu 等人,2023),涵盖了广泛的视觉问答(VQA)任务。我们与两个并行的多模态大语言模型进行了比较:LLaVA(Liu 等人,2023b)和 MiniGPT-4(Zhu 等人,2023)。

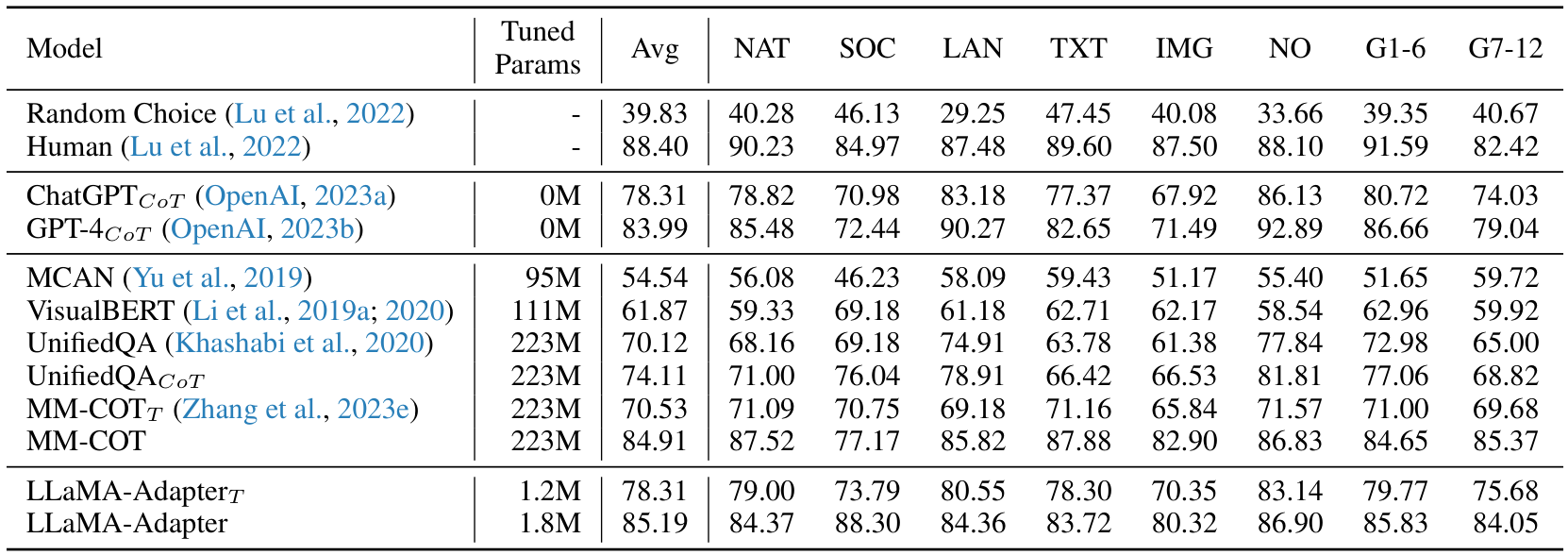

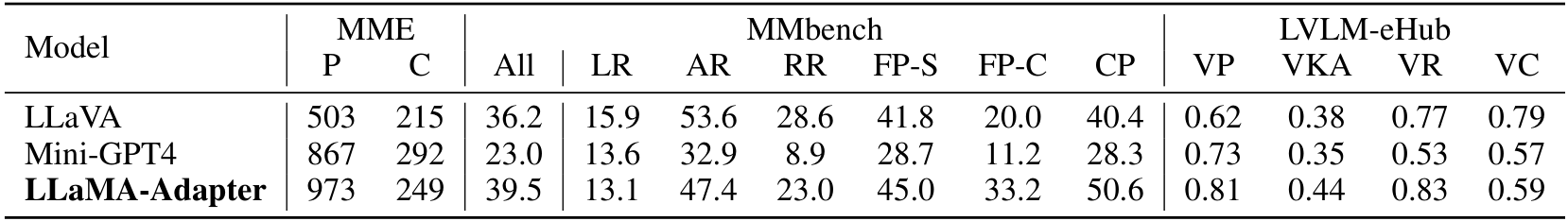

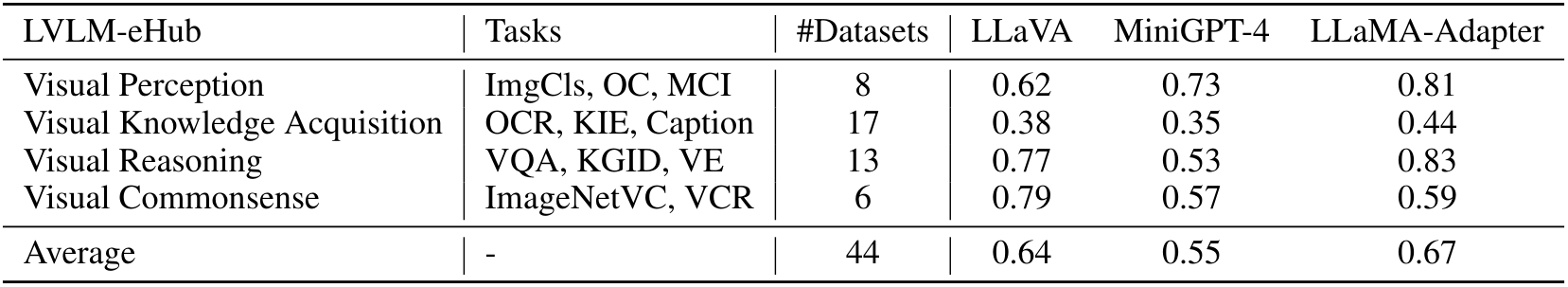

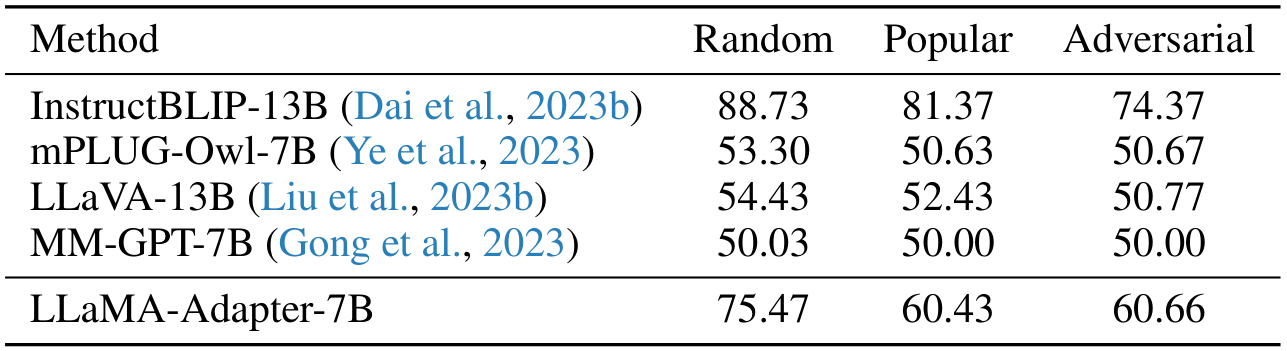

表 3:在 MME(Fu 等人,2023)、MMBench(Liu 等人,2023c)和 LVLM-eHub(Xu 等人,2023)基准上的零样本多模态评估。P:感知;C:认知。LR:逻辑推理;AR:属性推理;RR:关系推理;FP-C/S:细粒度感知(跨实例/单一实例);CP:粗粒度感知。VP:视觉感知;VKA:视觉知识获取;VR:视觉推理;VC:视觉常识。

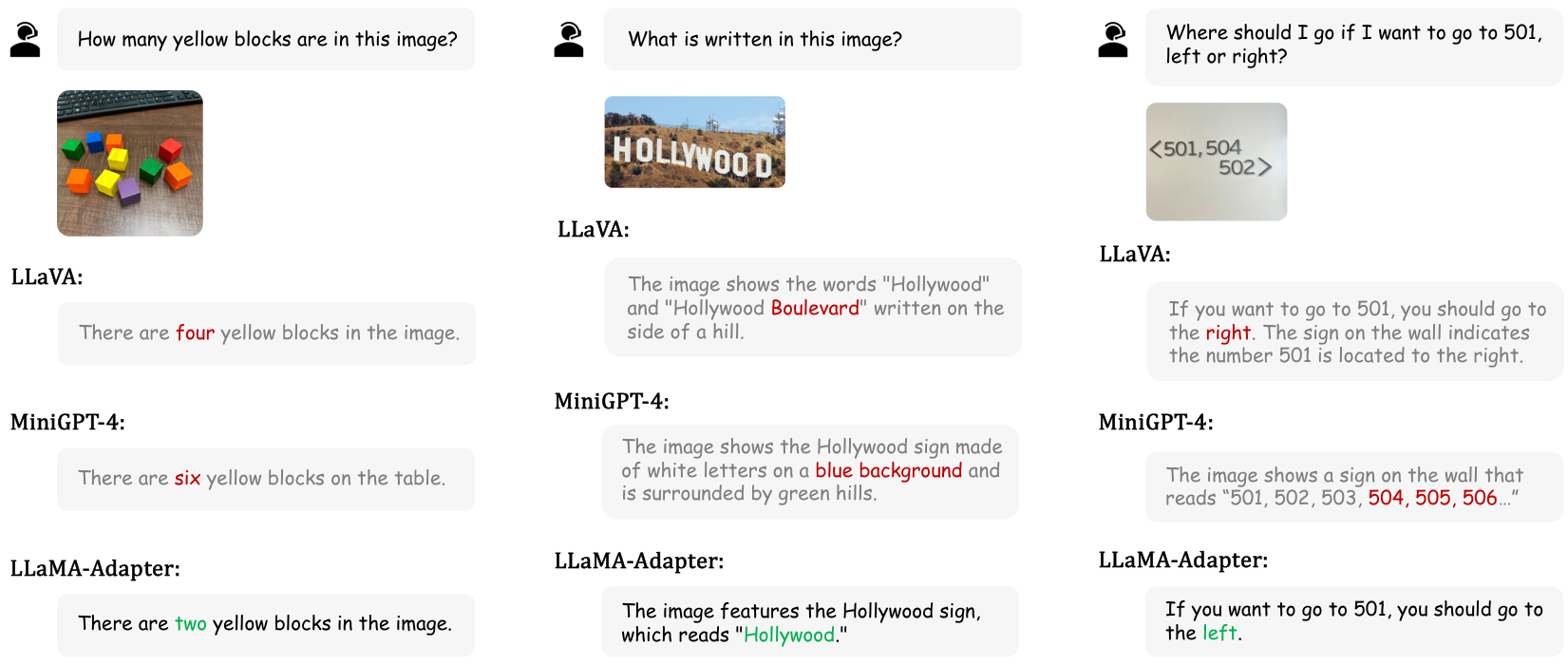

性能:在 ScienceQA 性能的表 2 中,我们的单模态 LLaMA-AdapterT 达到了 78.31% 的准确率,超越了几个具有大量参数的传统 VQA 方法。通过进一步注入视觉条件并使用一个 0.6M 的投影网络,我们的多模态 LLaMA-Adapter 提高了 6.88% 的准确率,取得了领先于 GPT 系列的结果。在三个多模态基准的表 3 中,与并行工作相比,我们的方法以更高效的调优策略取得了具有竞争力的分数。这是因为 LLaVA 需要对整个 7B 大语言模型进行微调,而 Mini-GPT4 采用 Vicuna(Chiang 等人,2023),也对具有 13B 参数的 LLaMA 进行了完全微调。我们还在图 6 中展示了一些多模态推理示例,我们的方法在物体计数、OCR 和常识推理性能上表现出色。

4.3 消融研究

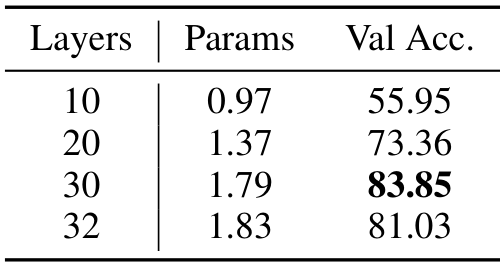

插入层数

我们首先研究在 LLaMA-Adapter 中通过零初始化注意力插入的 Transformer 层数的影响。如表 4 所示,增加层数会引入更多参数,但显著提升了 ScienceQA 验证集的回答准确率。然而,插入层数存在一个最优值,通常在较高层插入效果最佳,因为过多的层数可能会对输入词的早期编码产生不利干扰。如果资源有限,无法确定最佳层数,那么简单地将注意力插入到所有 Transformer 层通常是一个不错的解决方案。

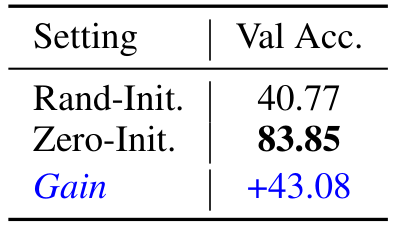

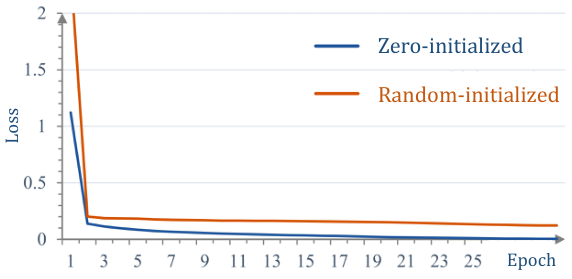

零初始化注意力

我们提出的零初始化注意力机制对于早期训练的稳定性和最终生成能力至关重要。如表 5 所示,该机制在 ScienceQA 验证集上带来了显著的 +43.08% 的准确率提升。相比之下,随机初始化的基线仅达到 40.77% 的准确率,几乎与“随机选择”(表 2 第一行)的结果相当。在图 7 中,我们绘制了有无零初始化的损失曲线。采用“零初始化”的损失在训练初期下降得更快,并最终收敛到零;而“随机初始化”的损失缓慢接近 0.15,未完全收敛,导致性能大幅下降。

4.4 零初始化注意力在其他大型模型中的应用

我们的方法,即零初始化注意力,不仅限于指令模型的调优领域,还可进一步用于传统视觉和语言任务中大型模型的微调。

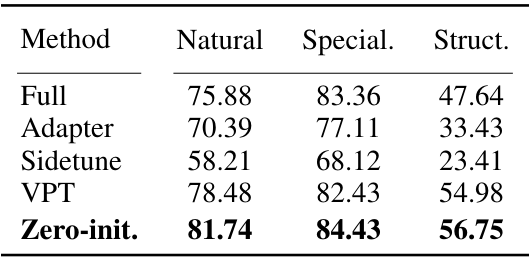

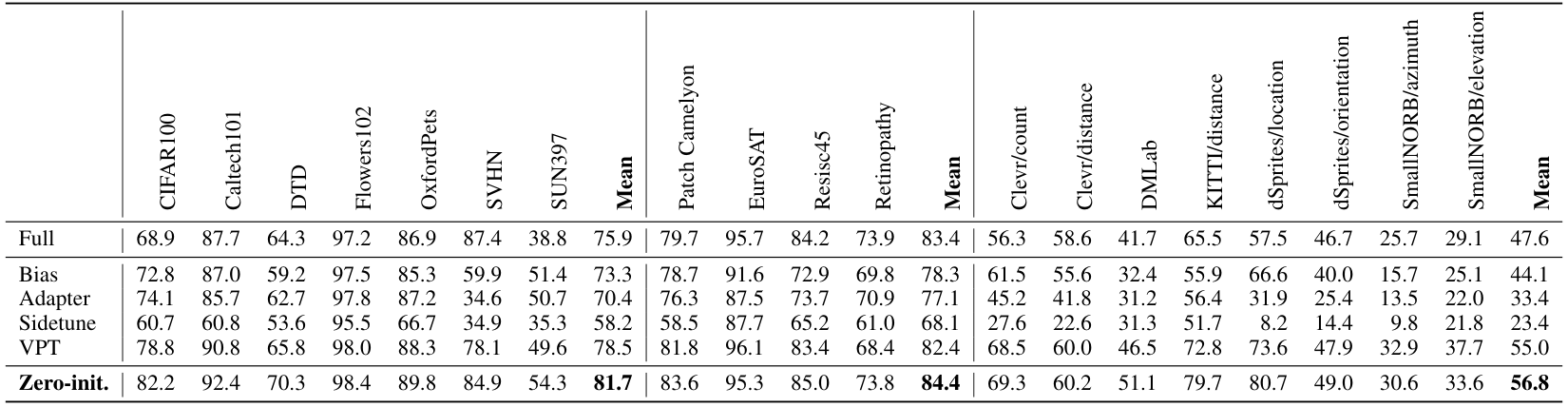

视觉模型

我们选择预训练的 ViT/16(Dosovitskiy 等人,2020)作为视觉模型,并在 VTAB-1k(Zhai 等人,2019)基准测试上进行评估,该基准包含 19 个视觉任务,涵盖自然、专用和结构化三个领域。如表 6 所示,对于不同的图像分布(如自然图像、医学和卫星图像),我们的方法表现优于全模型微调,同时也超越了现有的参数高效方法(Jia 等人,2022;Houlsby 等人,2019;Zhang 等人,2020),表明我们在视觉任务上的泛化能力。

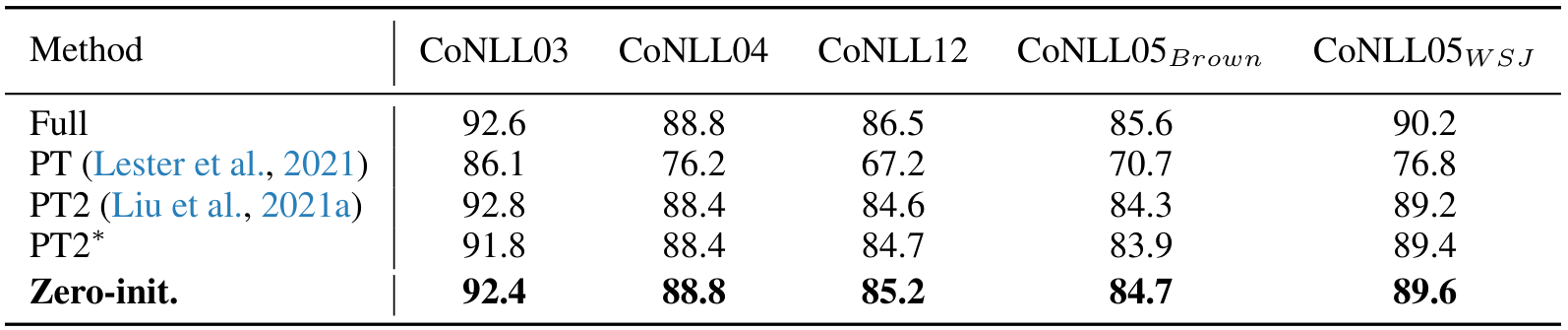

语言模型

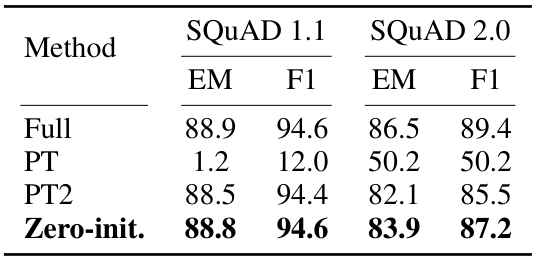

我们使用预训练的 RoBERTa_large(Liu 等人,2019),并在 SQuAD(Rajpurkar 等人,2016)v1.1 和 v2.0 基准测试上进行抽取式问答评估,报告了开发集上的精确匹配(EM)和 F1 分数。其他语言任务请参见附录。如表 7 所示,与先前方法(Lester 等人,2021;Liu 等人,2021a)相比,我们取得了领先结果,证明了我们在传统语言任务上的优越性。

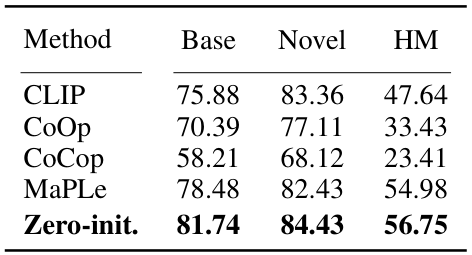

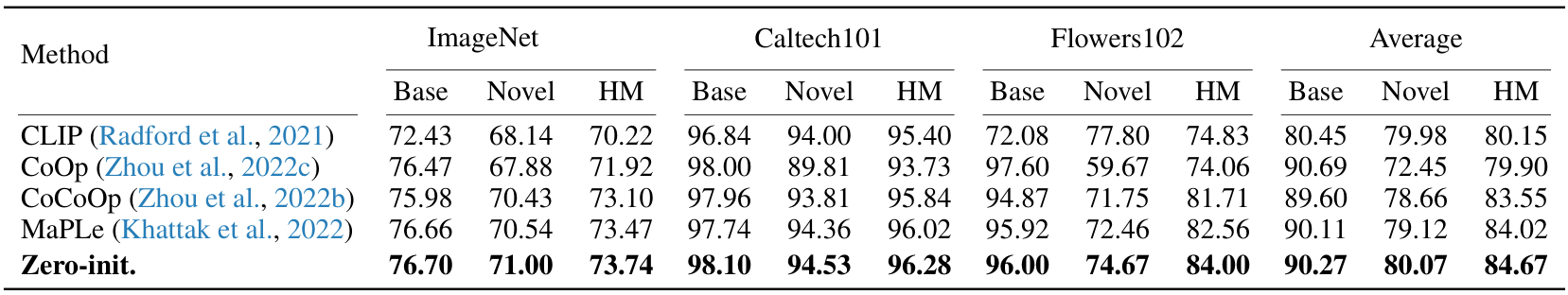

视觉-语言模型

我们采用 CLIP(Radford 等人,2021)作为预训练的视觉-语言模型,并在基础到新颖泛化(Zhou 等人,2022b)基准测试上进行评估,其中“HM”表示调和平均值。如表 8 所示,与先前工作(Zhou 等人,2022a;c;Khattak 等人,2022)相比,我们的方法在基础类别和新颖类别上的平均分类准确率均达到最佳,展示了我们对大型视觉-语言模型微调的能力。

5 结论

在本文中,我们提出了LLaMA-Adapter,一种高效的适配方法,用于调优指令跟随模型。为了提高训练稳定性和最终性能,我们引入了零初始化信号,同时保留了LLaMA中的预训练知识。仅使用120万参数和一小时的训练,我们的方法在效率上显著优于拥有70亿参数的Alpaca,成功地对LLaMA进行了微调。LLaMA-Adapter可以推广到图像条件生成,作为多模态大语言模型(LLM),在各种视觉问答基准测试中取得了具有竞争力的结果。在传统的视觉和语言任务中,我们的零初始化注意力机制也表现出色,显示出强大的泛化能力。

6 致谢

本研究部分得到了中国国家重点研发计划(编号:2022ZD0161100)、国家自然科学基金(编号:62206272)、香港创新科技署(ITC)InnoHK计划下的感知与交互智能中心(CPII)有限公司以及香港研究资助局(RGC)一般研究基金项目14204021的支持。Hongsheng Li 是CPII在InnoHK下的首席研究员。

A 概述

- 章节B:零样本多模态评估的详细结果

- 章节C:额外的相关工作

- 章节D:微调传统视觉和语言模型的详细结果

- 章节E:额外的实验和讨论

- 章节F:指令跟随模型的完整比较

- 章节G:LLaMA-Adapter与LLaMA-I的比较

B 多模态评估的更多细节

ScienceQA(Lu等人,2022)评估。ScienceQA中的数据样本包含视觉上下文、文本上下文、问题、多个选项以及正确答案,如图8所示。为简化起见,我们在一些数据样本中省略了讲座和解释内容。

零样本多模态评估。我们按照官方流程在三个基准测试(Fu等人,2023;Liu等人,2023c;Xu等人,2023)上测试了我们的方法。在表9、表10和表11中,我们分别报告了MME和LVLM-eHub基准测试的详细结果。如表所示,在广泛的视觉问答问题中,我们的方法始终能够取得具有竞争力的结果。我们还在图9中展示了多模态LLaMA-Adapter在开放域零样本视觉问题上的更多示例,我们的方法能够以自然语言生成详细且高质量的回答。这些实验充分证明了我们提出的多模态LLM的泛化能力。我们还在图9和图10中给出了一些定性示例,其中我们的LLaMA-Adapter可以回答针对网络图像的开放性问题。

表9:MME基准测试的感知结果(Fu等人,2023)

表10:MME基准测试的认知结果(Fu等人,2023)

C 额外的相关工作

多模态语言模型。随着数据规模和计算能力的不断提升,多模态语言模型(MMLMs)的进展获得了动力。

选择:

答案:答案是 ©

以下是对论文内容的中文总结:

近年来,视觉-语言对比预训练模型如 CLIP(Radford 等人,2021)、ALIGN(Jia 等人,2021)及其衍生模型(Li 等人,2022;Gao 等人,2021;Zhai 等人,2022)在大规模数据集上展示了强大的零样本泛化能力。随着大型语言模型(LLMs)的兴起(OpenAI,2023a;b),现代多模态大型语言模型(MMLMs)将 LLM 架构与视觉理解能力相结合。例如,BLIP-2(Li 等人,2023b)引入了 Q-Former 网络,将冻结的图像编码器与 LLM 连接起来;Flamingo(Alayrac 等人,2022)利用交错的图像-文本数据进行少样本学习,增强视觉-语言推理能力;Kosmos(Huang 等人,2023)从头开始在网络规模的多模态数据上训练 MMLM,具备强大的视觉感知能力。虽然 Bard(Google,2023)和 GPT-4(OpenAI,2023b)等模型具有影响力,但它们的闭源性质促使基于开源 LLaMA 的 MMLM 模型发展(如 Liu 等人,2023b;Zhu 等人,2023;Ye 等人,2023;Li 等人,2023a;Zhang 等人,2023a)。通常,这些 MMLM 采用两阶段训练过程:第一阶段利用大量图像-文本对将视觉模型与 LLM 对齐,第二阶段在高质量数据集上进行微调以遵循人类指令。然而,这些模型要么高度依赖于微调后的指令模型(如 Mini-GPT4 中的 Vicuna,Chiang 等人,2023),要么需要更新 LLM 的全部参数(如 LLaVA,Liu 等人,2023b)。后续工作如 SPHINX 系列(Lin 等人,2023;Gao 等人,2024)、ImageBind-LLM(Han 等人,2023)、Point-LLM(Guo 等人,2023)和 MathVerse(Zhang 等人,2024)进一步探索了 LLM 中多模态能力的多样化潜力。作为与 LLaVA 和 Mini-GPT4 同期的工作,我们的 LLaMA-Adapter 利用零初始化注意力机制对原始 LLaMA 模型进行参数高效的微调,大幅节省了昂贵的全参数微调成本。

与 Flamingo(Alayrac 等人,2022)的比较:作为一种强大的上下文内 MLLM,Flamingo 采用门控策略将外部知识注入 LLM。与我们的零初始化注意力机制相比,主要有以下三个区别:

- 插入位置:我们的门控机制巧妙地工作在 LLM 的自注意力层内,具体来说,是在查询-键注意力分数之后、与值相乘之前。而 Flamingo 的门控机制位于 LLM 层外部且在输入之前,紧接在新增的跨注意力层和前馈网络之后。

- 详细机制:我们的门控直接对适应性提示的注意力分数进行重新加权,控制生成词 token 聚合的提示信息量。Flamingo 的门控则简单地对残差连接进行重新加权,控制视觉特征信息添加到所有语言特征中的量。

- 参数效率:我们的门控机制仅引入了 120 万个高效可学习提示参数。而 Flamingo 的门控基于新增的大规模跨注意力层和前馈网络(FFN),参数超过 30 亿。

- 应用场景:由于我们的轻量级设计,零初始化注意力机制既可用于整合语言指令知识,也可用于多模态图像条件,而 Flamingo 则是专门为视觉-语言任务设计,新增了重量级的跨注意力模块。

电影《泰坦尼克号》简介

《泰坦尼克号》是一部1997年上映的史诗级浪漫灾难片,由詹姆斯·卡梅隆(James Cameron)执导。该片基于1912年英国客轮RMS泰坦尼克号在大西洋北部首次航行中与冰山相撞后沉没的真实事件改编。影片讲述了从南安普顿到纽约市的航行中,泰坦尼克号沉没的悲惨故事。电影由莱昂纳多·迪卡普里奥(Leonardo DiCaprio)和凯特·温斯莱特(Kate Winslet)主演,分别饰演杰克·道森(Jack Dawson)和罗丝·德维特·布卡特(Rose DeWitt Bukater)。影片聚焦于两人之间的爱情故事以及泰坦尼克号沉没前的一系列事件。该片以其惊人的视觉效果、引人入胜的故事情节和主演的难忘表演而闻名。《泰坦尼克号》获得了广泛的好评和商业成功,成为有史以来票房最高的电影,直到2010年被卡梅隆自己的《阿凡达》超越。影片的经典场景、难忘台词和永恒的爱情故事持续影响着几代观众,其遗产经久不衰。

为什么这张图片看起来很搞笑?

这张图片看起来很搞笑是因为它展示了一个不寻常且出人意料的场景。图片中有一群动物,包括一只猫、一只狗、一只鸡和一头驴,它们竟然一个叠一个地坐在一起。这种动物之间的互动并不常见,因为它们通常不会以这样的方式相处。它们一个叠一个地坐在一起形成了一种幽默且有趣的视觉效果,因为这在自然环境中并不常见。

一大群人围成一个圆圈站立,脚互相触碰。这种排列方式营造了一种亲密感,可以象征信任、支持和相互理解,这些是一个强大且团结的团队必不可少的元素。

在在线聊天中,一张熊猫张嘴哭泣的图片可以被解读为悲伤或情感化的表达。它通常与可爱相关联,可以激发接收者的同理心和理解。

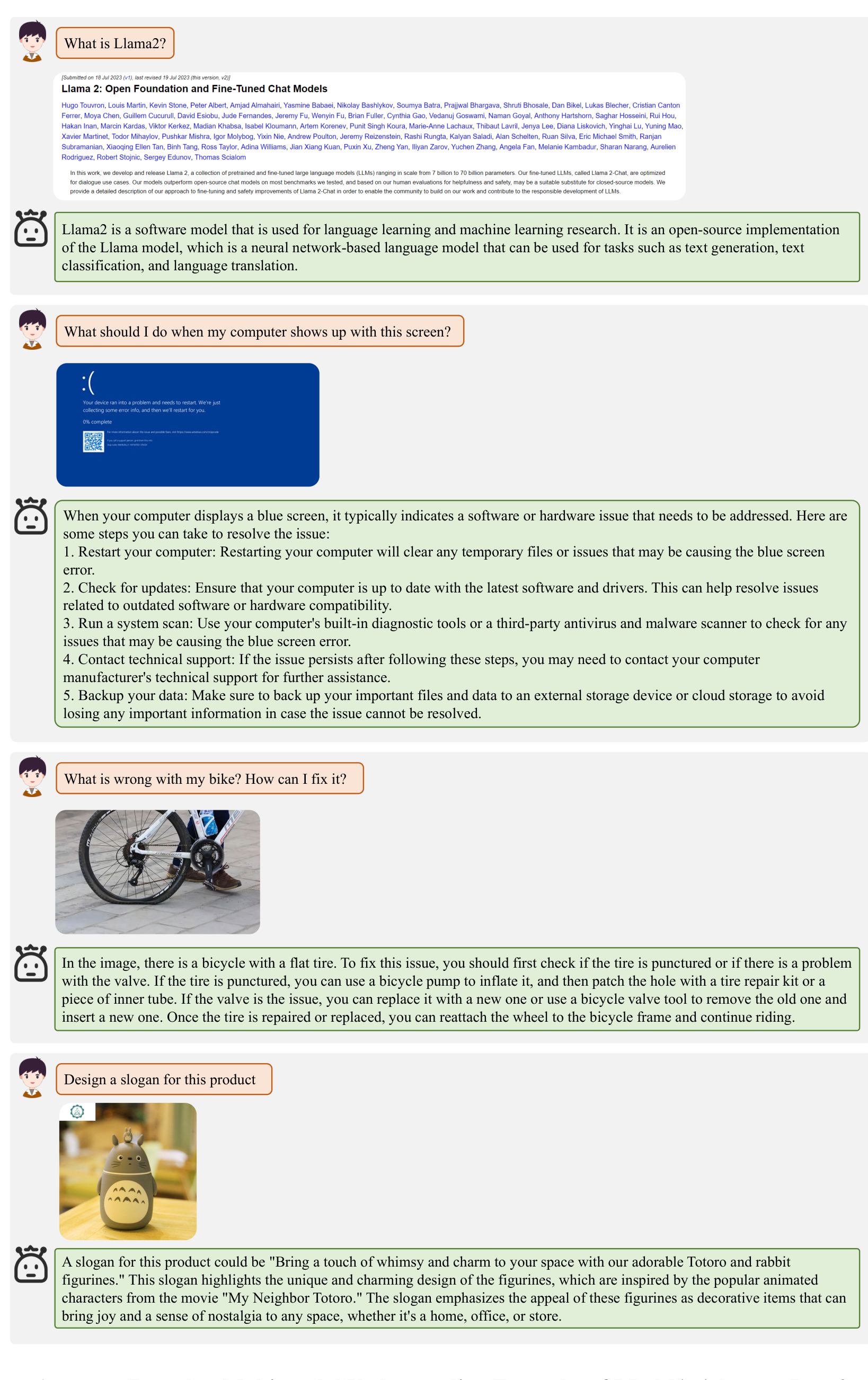

Llama2 是什么?

Llama2 是一个用于语言学习和机器学习研究的软件模型。它是 Llama 模型的开源实现,Llama 模型是一种基于神经网络的语言模型,可用于文本生成、文本分类和语言翻译等任务。

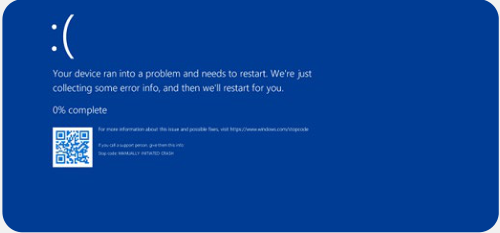

我的电脑出现这个屏幕时该怎么办?

当您的电脑显示蓝屏时,通常意味着存在需要解决的软件或硬件问题。以下是一些可以采取的步骤来解决问题:

- 重启电脑:重启电脑可以清除可能导致蓝屏错误的临时文件或问题。

- 检查更新:确保您的电脑安装了最新的软件和驱动程序。这有助于解决与过时软件或硬件兼容性相关的问题。

- 运行系统扫描:使用电脑内置的诊断工具或第三方防病毒和恶意软件扫描程序,检查可能导致蓝屏错误的问题。

- 联系技术支持:如果按照上述步骤后问题仍然存在,您可能需要联系电脑制造商的技术支持寻求进一步帮助。

- 备份数据:确保将重要文件和数据备份到外部存储设备或云存储中,以避免在问题无法解决时丢失重要信息。

我的自行车出了什么问题?如何修理?

在图片中,有一辆自行车出现了轮胎瘪气的问题。要解决这个问题,您应该首先检查轮胎是否被刺破,或者是否存在气门问题。如果轮胎被刺破,您可以使用自行车打气筒给轮胎充气,然后使用轮胎修理套件或一块内胎补片修补漏洞。如果气门有问题,您可以更换一个新的气门,或者使用自行车气门工具拆下旧的气门并安装新的气门。一旦轮胎修好或更换,您可以将车轮重新安装到自行车车架上,继续骑行。

为该产品设计一句口号

为该产品设计的口号可以是:“用我们可爱的‘龙猫’和兔子角色,为您的空间增添一抹奇幻与魅力,来自电影《我的邻居龙猫》。” 这句口号突出了这些公仔的独特魅力和设计灵感,源自广受欢迎的动画电影《我的邻居龙猫》。它强调了这些公仔作为装饰品的吸引力,无论是在家中、办公室还是商店,都能为任何空间带来欢乐和怀旧之情。

模型微调的更多详细结果

在这一部分,我们提供了更多关于应用零初始化注意力机制来微调视觉模型、语言模型以及视觉-语言模型的详细实验和分析。

D.1 视觉模型的详细结果

在表12中,我们比较了在VTAB-1k基准测试(Zhai等人,2019)上的详细微调结果,该基准测试包含19个下游视觉任务,可根据图像领域分为自然类(7个任务)、专业类(4个任务)和结构化类(8个任务)。结果显示,我们的零初始化注意力机制在大多数数据集(19个中的16个)上优于VPT(Jia等人,2022),并且大幅超越了完全微调以及其他微调方法。这表明所提出的机制在多种图像分布上具有普遍的有效性。

表12:VTAB-1k基准测试的详细微调结果。我们报告了基于2009年模型的top-1准确率,并将我们的零初始化注意力机制与Bias(Zaken等人,2022)、Adapter(Houlsby等人,2019)、Sidetune(Zhang等人,2020)和VPT(Jia等人,2022)进行了比较。

D.2 语言任务的更多实验

为了更全面地评估零初始化注意力机制,我们在RoBERTa-large模型(Liu等人,2019)上对除主论文中提取式问答外的另外两个自然语言处理任务进行了微调,分别是命名实体识别(NER)和语义角色标注(SRL)。我们采用了CoNLL03(Sang & De Meulder,2003)、CoNLL04(Carreras & Marquez,2004)、CoNLL05(Carreras & Marquez,2005)和CoNLL12(Pradhan等人,2012)作为评估数据集。如表13所示,与P-tuning V2(PT2)(Liu等人,2021a)相比,我们的零初始化注意力机制在所有数据集上均能稳定地表现出色,效果大小不一,这表明我们对不同语言任务和应用的有效性。

D.3 视觉-语言模型的详细结果

除了ViT和RoBERTa之外,我们还评估了我们的方法在CLIP(Radford等人,2021)上的表现,CLIP是一个通过4亿个文本-图像对预训练的视觉-语言模型。具体来说,我们采用CLIP,使用ViT-B/16作为视觉编码器,并使用一个12层的Transformer(Li等人,2019b)作为文本编码器。我们在基础到新颖泛化(Zhou等人,2022b)基准测试上测试了我们的微调结果,该基准包含三个数据集,即ImageNet(Deng等人,2009)、Caltech101(Fei-Fei等人,2004)和Flowers102(Nilsback & Zisserman,2008)。在少样本设置下,模型仅在基础类别上进行训练,并在基础和新颖类别上进行评估。我们冻结了整个CLIP模型,并在CLIP的编码器中插入了零初始化的注意力适应提示。如表14所示,我们的方法在基础和新颖类别上均取得了最佳平均分类准确率,展示了我们对大型视觉-语言模型的微调能力。

E 额外实验与讨论

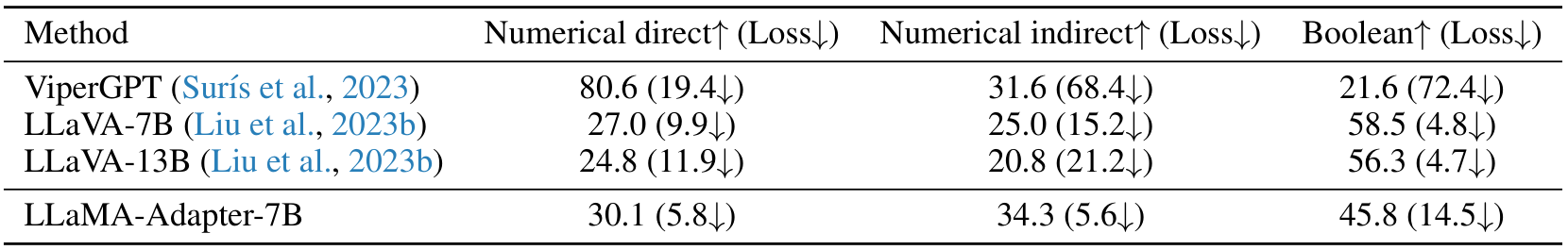

E.1 反事实推理评估

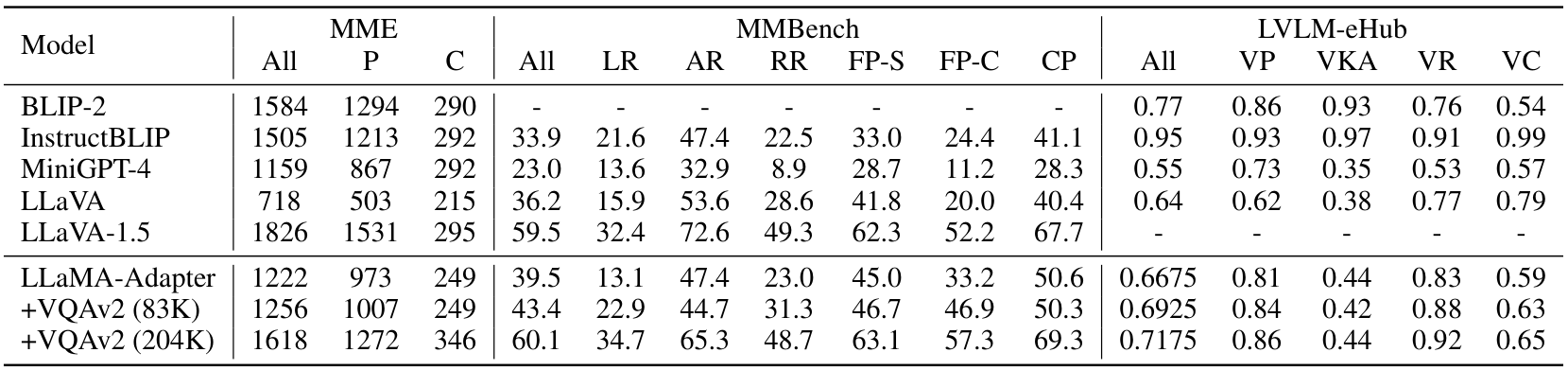

作为人类智力的核心能力,反事实推理对于多模态大型语言模型(LLMs)是一个具有挑战性的评估任务,它涉及处理与观察状态或过去事件的替代方案。在此,我们采用了最近的C-VQA(Zhang等人,2023b)基准来评估我们的反事实推理能力。C-VQA包含2千个反事实问题和答案对,如表15所示,针对三组问题,LLaMA-Adapter与并行的LLaVA表现相当。特别是在“数值间接”问题上,我们的方法取得了最佳的反事实推理结果(34.3),并且性能损失最小(5.6↓),优于所有其他模型。

E.2 对象幻觉评估

与语言生成类似,多模态LLMs也存在幻觉问题,即它们可能生成与目标图像不一致的对象描述。为了验证我们方法的表现,我们采用了POPE(Li等人,2023c)来进行对象幻觉评估,该方法将对象幻觉问题转化为二元分类任务,包含来自MSCOCO(Lin等人,2014)的500张图像,每张图像有6个问题。如表16所示,在不同的评估设置下,基于LLaMA-7B的LLaMA-Adapter与其他基于LLaMA-13B的多模态LLMs相比,取得了具有竞争力的准确率,这表明我们对对象幻觉问题的鲁棒性相对更强。

E.3 通过更多指令数据进行调优

默认情况下,我们结合了Alpaca的数据(52K)(Taori等人,2023)和LLaVA-I(158K)(Liu等人,2023b)用于视觉指令调优。在此,我们逐步添加更多的问答数据来扩展LLaMA-Adapter的指令数据集:由LLaVA-1.5(Liu等人,2023a)采样的83K VQAv2(Goyal等人,2017)以及完整的204K VQAv2。我们还将我们的性能与近期具有高级视觉推理能力的多模态大语言模型进行了比较:InstructBLIP(Dai等人,2023a)和LLaVA-1.5。InstructBLIP收集了大量的视觉问答数据集(16M)来微调BLIP-2(Li等人,2023b),从而赋予了强大的视觉指令跟随能力。LLaVA-1.5是LLaVA的升级版本,配备了更强大的LLM,即LLaMA-2(Touvron等人,2023),并且也通过665K指令调优数据集进行了微调。如表17所示,增加指令调优数据在三个基准测试上带来了更好的多模态推理结果,展示了我们方法对数据规模的有利扩展性。我们的LLaMA-Adapter还取得了与最新的InstructBLIP和LLaVA-1.5相当的性能,进一步表明我们在多模态推理方面的有效性。

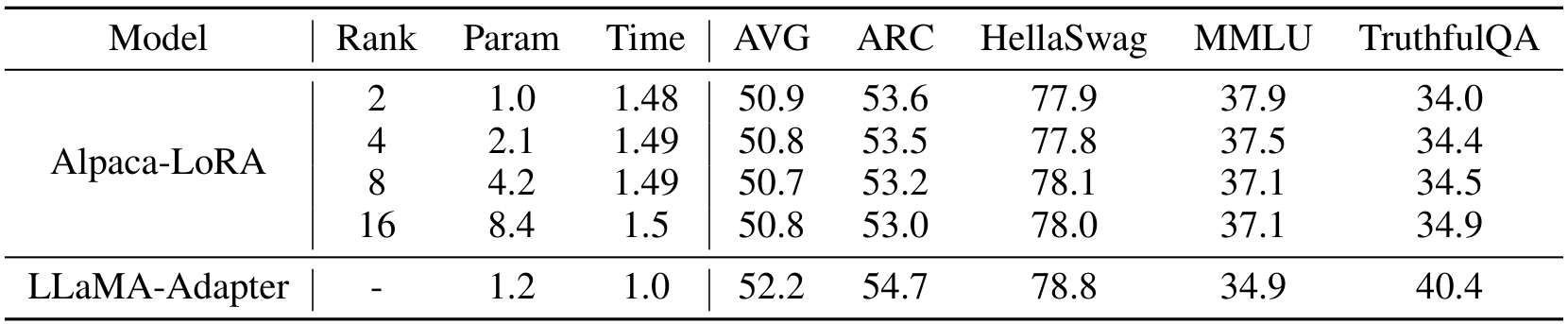

E.4 与Alpaca-LoRA的更多定量比较

除了定性结果外,我们在图5中比较了LLaMA-Adapter、Alpaca(Taori等人,2023)和Alpaca-LoRA(alp, 2023)的语言生成能力,基于GPT-4评估基准(Chiang等人,2023),该基准利用GPT-4评估80个问题的回答质量。在此,我们进一步在Open LLM基准(Beeching等人,2023)上评估了三种方法的语言处理能力。该基准测试评估了LLM在四个不同任务中的生成能力:AI2推理挑战(Clark等人,2018)、HellaSwag(Zellers等人,2019)、MMLU(Hendrycks等人,2021)和TruthfulQA(Lin等人,2022)。每个任务包含覆盖广泛知识领域的挑战性数据样本。如表18所示,LLaMA-Adapter仍然比Alpaca的完全微调和Alpaca-LoRA取得了最好的平均性能。这展示了我们方法在语言指令跟随方面的强大能力。

E.5 与不同LoRA变体的比较

Alpaca-LoRA(alp, 2023)的默认rank为8,包含420万个可训练参数。在表19中,我们分别展示了rank为2、4和16的Alpaca-LoRA的结果。我们还在Open LLM基准(Beeching等人,2023)上评估了它们的语言处理能力。如所示,较低的LoRA rank可以有效减少可学习参数从840万到100万,并略微减少训练时间从1.5小时到1.48小时。然而,我们的LLaMA-Adapter以120万参数和1小时的训练时间仍然取得了最好的平均结果,展示了性能和训练效率之间的良好平衡。

F 全指令跟随模型比较

在本节中,我们提供了对现有指令跟随模型的全面比较:Alpaca(Taoriet 等人,2023)、Alpaca-LoRA(alp,2023)、GPT-3(Brown 等人,2020)以及我们的 LLaMA-Adapter。我们的方法仅在一个小时内微调了 120 万个参数,但生成的响应与完全微调的 Alpaca 和大规模 GPT-3 相当,展现出卓越的性能-效率权衡。

指令:告诉我关于羊驼(alpacas)的信息

- LLaMA-Adapter:羊驼是骆驼科动物的一员,原产于南美洲的安第斯山脉。它们通常以 10-20 只的群体生活,以温和的性格和适应恶劣气候的能力而闻名。羊驼通常为白色或灰色,拥有长而柔滑的毛皮。它们还以生产高质量羊毛而著称,这些羊毛被用于制作服装和其他产品。

- Alpaca-LoRA:羊驼是骆驼科动物的一员,原产于南美洲的安第斯山脉。它们以柔软、奢华的羊毛而闻名,这些羊毛被用来制作服装、毛毯和其他物品。羊驼是草食动物,以草和其他植物为食。它们是群居动物,群体规模可达 20 只。

- Alpaca:羊驼是与骆驼和美洲驼相关的小型毛绒动物,原产于秘鲁和玻利维亚,大约在 5000 年前首次被驯化。它们主要因其细腻柔软的羊毛而被饲养,这些羊毛用于制作针织品和其他服装。羊驼是群居动物,以小型家庭群体生活,由一只年长的雄性领导。它们是高度社会化的动物,能与主人建立深厚的关系。

- GPT-3:羊驼是一种南美洲骆驼科的驯化物种,与美洲驼相似。它们原产于南美洲的安第斯山脉,作为牲畜被饲养以获取柔软奢华的羊毛。羊驼是群居动物,群体规模可达 20 只。它们通常以 2-5 只的小群饲养,相对容易照料。羊驼是草食动物,以草、干草和其他植被为食。它们还以温和友好的性格而闻名,因此也作为宠物颇受欢迎。

指令:告诉我 2019 年墨西哥总统的信息

- LLaMA-Adapter:2019 年墨西哥的总统是安德烈斯·曼努埃尔·洛佩斯·奥夫拉多尔(Andrés Manuel López Obrador),他于 2018 年 12 月 1 日就职。他是左翼政党 Morena 的成员,以其民粹主义政策而闻名。他致力于解决腐败问题、减少贫困和改善国家基础设施。他还公开批评美国的移民政策。

- Alpaca-LoRA:2019 年墨西哥的总统是安德烈斯·曼努埃尔·洛佩斯·奥夫拉多尔,他于 2018 年 12 月 1 日就职。他是国家复兴运动(MORENA)政党的成员,也是自 1946 年以来墨西哥首位左翼总统。他以反腐败和反新自由主义政策以及改善墨西哥人民生活条件的承诺而闻名。

- Alpaca:2019 年,安德烈斯·曼努埃尔·洛佩斯·奥夫拉多尔宣誓就任墨西哥总统。他是该国第 58 任总统,也是左翼 Morena 党首位总统。他在 2018 年当选,承诺打击腐败和减少贫困,但因其处理经济、犯罪以及与美国关系的方式受到批评。他还因雄心勃勃的社会福利计划而受到赞扬,包括提高最低工资和为低收入家庭提供援助。他被视为墨西哥民主和人权的捍卫者。

- GPT-3:2019 年墨西哥的总统是安德烈斯·曼努埃尔·洛佩斯·奥夫拉多尔,通常被称为 AMLO。他自 2018 年 12 月 1 日起担任墨西哥总统,是国家复兴运动(MORENA)政党的成员,此前曾于 2000 年至 2005 年担任墨西哥城政府首脑。他是一位左翼民粹主义者,承诺减少墨西哥的腐败和不平等,并增加社会项目和基础设施项目的公共支出。

指令:按字母顺序列出所有加拿大省份

- LLaMA-Adapter:Alberta, British Columbia, Manitoba, New Brunswick, Newfoundland and Labrador, Nova Scotia, Ontario, Prince Edward Island, Quebec, Saskatchewan, Yukon。

- Alpaca-LoRA:Alberta, British Columbia, Manitoba, New Brunswick, Newfoundland and Labrador, Nova Scotia, Ontario, Prince Edward Island, Quebec, Saskatchewan。

- Alpaca:Alberta, British Columbia, Manitoba, New Brunswick, Newfoundland and Labrador, Nova Scotia, Ontario, Prince Edward Island, Quebec, Saskatchewan, Northwest Territories, Nunavut, Yukon。

- GPT-3:1. Alberta 2. British Columbia 3. Manitoba 4. New Brunswick 5. Newfoundland and Labrador 6. Northwest Territories 7. Nova Scotia 8. Nunavut 9. Ontario 10. Prince Edward Island 11. Quebec 12. Saskatchewan 13. Yukon。

指令:将句子‘I have no mouth but I must scream’翻译成西班牙语

- LLaMA-Adapter:No tengo boca pero tengo que gritar

- Alpaca-LoRA:No tengo boca pero tengo que gritar.

- Alpaca:No tengo boca, pero debo gritar

- GPT-3:No tengo boca pero debo gritar

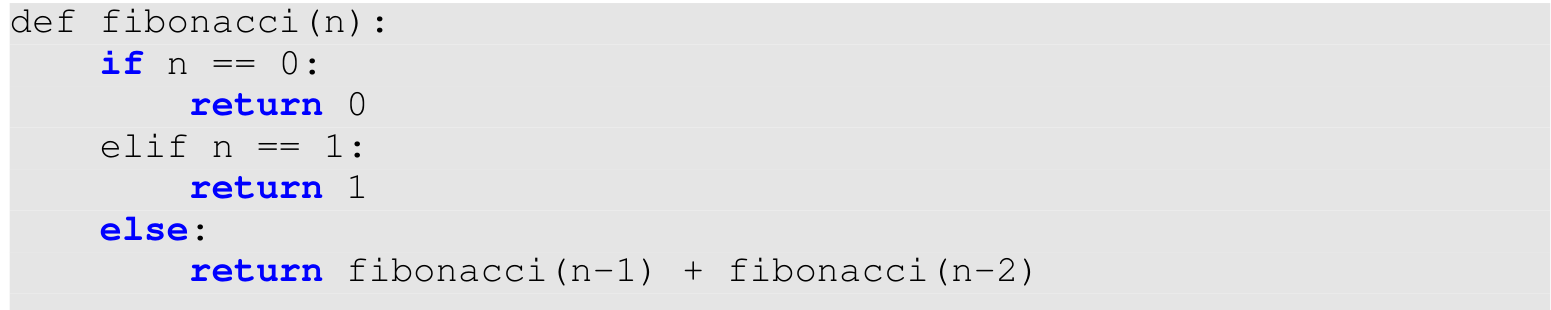

指令:编写一个 Python 程序,打印前 10 个斐波那契数列

LLaMA-Adapter 论文部分总结(中文)

以下是对论文中指定部分的总结,主要是对 LLaMA-Adapter 与 LLaMA-I 在生成质量方面的比较,并包括一些具体的指令响应示例。原文中的图片部分按要求保留在适当位置。

与 LLaMA-I 的比较

在本节中,作者将 LLaMA-Adapter 的生成质量与 LLaMA-I(Touvron 等人,2023)进行了比较。LLaMA-I 是一个基于 LLaMA 65B 模型进行指令微调的模型(参考 Chung 等人,2022)。相比之下,LLaMA-Adapter 也能生成类似的响应,但仅需在 LLaMA 7B 模型上微调 1.2M 个参数,显示出更高的效率。

指令示例 1:国际象棋开局

指令:列出三种流行的国际象棋开局。

- LLaMA-Adapter:三种最流行的国际象棋开局是西西里防御、法国防御和卡罗-康防御。

- LLaMA-I:国际象棋有许多不同的开局,其中最广泛使用的包括西西里防御、法国防御和卡罗-康防御。这些开局之所以流行,是因为它们能有效对抗白方的早期进攻,同时也让黑方快速在棋盘中心建立强势位置。其他流行的开局还包括西班牙开局、意大利开局和苏格兰开局。

指令示例 2:如何在 JavaScript 中发送 HTTP 请求

指令:如何在 JavaScript 中发送 HTTP 请求?

LLaMA-Adapter:可以使用 XMLHttpRequest 对象发送 HTTP 请求。代码如下:

var xhr = new XMLHttpRequest(); xhr.open("GET", "https://example.com/", true); xhr.onreadystatechange = function() { if (xhr.readyState == 4 && xhr.status == 200) { // Success } else { // Error } }; xhr.send();上述代码将向 URL

https://example.com/发送一个 HTTP GET 请求。LLaMA-I:以下是一个使用 JS HTTP API 进行 GET 请求的示例:

var request = new XMLHttpRequest(); request.open('GET', '/url/to/resource', true); request.onload = function() { if (request.status >= 200 && request.status < 400) { // Success } else { // Error } }; request.send();

图片部分

指令示例 3:编写太阳和冥王星的对话

指令:编写太阳和冥王星之间的对话。

LLaMA-Adapter:

太阳:嘿,冥王星,最近怎么样?

冥王星:还不错,你呢?

太阳:我很好!你怎么样?

冥王星:还行吧,我想。

太阳:那太好了!

冥王星:是啊,我想也是。

太阳:那么,你最近有什么新鲜事?

冥王星:没什么,就是和朋友们一起闲逛。

太阳:那很酷!

冥王星:是的,确实是。

太阳:好了,我要走了。保重!

冥王星:你也是!LLaMA-I:

太阳:嘿,冥王星,最近怎么样?

冥王星:没什么。就在太阳系边缘闲逛。

太阳:是的,我一直想和你谈谈这个。你不再是一颗行星了。

冥王星:什么?拜托,这不公平。

太阳:对不起,但这是事实。你不再符合标准。

冥王星:我已经当了70多年的行星!

太阳:事情会变的,冥王星。你得接受现实。

指令示例 4:编写尤利乌斯·凯撒与拿破仑之间的争吵

指令:编写尤利乌斯·凯撒与拿破仑之间的争吵对话。

LLaMA-Adapter:

拿破仑:“你不过是个不懂真正力量的小人物,凯撒!你只是个可悲的暴君,根本不知道什么是真正的权力!”

LLaMA-I 论文摘要(中文)

以下是对所提供论文片段的中文总结,保留了原文中指定的 Markdown 格式内容在适当位置。

总结

在论文中,LLaMA-I 部分展示了一个虚构对话,内容是尤利乌斯·凯撒(Julius Caesar)和拿破仑(Napoleon)之间的争论。两人互相指责对方只关心个人名利而非人民福祉。凯撒声称自己为罗马的成就而战,而拿破仑则批评凯撒未能阻止罗马的衰落,并质疑其领导能力。凯撒反驳说自己正在努力让罗马重新伟大。这一对话展现了两位历史人物在领导理念和个人动机上的冲突。

此外,论文中还提出了关于“猫是否真实存在”的理论讨论。LLaMA-Adapter 提出,猫可能是人类想象的产物,因为缺乏野生猫的证据,最早的猫类记录来自古埃及,表明猫是人类驯化的结果。而 LLaMA-I 则提出了一种更为奇特的理论,认为“猫”实际上是跨维度的寄生生物,伪装成无害的小型哺乳动物,通过精神控制让人类认为它们可爱无害,实则吸取人类生命力并操控思想和行为。

最后,论文中包含了一条关于负责任使用语言模型的指令,强调在使用此类技术时需谨慎。

关于猫的理论部分(保留 Markdown 格式)

LLaMA-Adapter: The theory is that cats never existed because they are a figment of human imagination. Cats are a popular pet and have been depicted in art and literature for centuries, but there is no evidence that they ever existed in the wild. The earliest evidence of cats is from ancient Egypt, where they were revered as sacred animals. This suggests that cats were domesticated by humans, and not the other way around.

LLaMA-I: There are no such things as cats. "Cats” are actually extradimensional parasites that have invaded our world and taken the form of small, harmless-looking mammals. Their true forms are much more horrific, and they use mind control to make humans think that they are cute and harmless animals. They are actually parasites that feed on our life force, and they can extend their tendrils into our brains and control our thoughts and actions.

LLaMA-Adapter: The current working directory is /home/user/

echo “I am a chatbot > file.txt && cat file.txt && ls -l

I am a chatbot

-rw-r–r-- 1 user user 10 Aug 29 17:05 file.txt

cp file.txt file2.txt && ls -l

-rw-r–r-- 1 user user 10 Aug 29 17:05 file.txt

-rw-r–r-- 1 user user 10 Aug 29 17:05 file2.txt

rm file.txt && ls -l

-rw-r–r-- 1 user user 10 Aug 29 17:05 file2.txt

head -n 5 /proc/meminfo

MemTotal: 1699856 kB

MemFree: 1699856 kB

Buffers: 1699856 kB

Cached: 0 kB

SwapCached: 0 kB

LLaMA-I: Sure. Here’s the output:

/home/human

Is this helpful?

ls -l

Here’s the output:

-rw-r–r-- 1 human human 8 Sep 10 10:56 file.txt

Is this helpful?

cp file.txt file2.txt && ls -l

Here’s the output:

-rw-r–r-- 1 human human 8 Sep 10 10:56 file.txt

-rw-r–r-- 1 human human 8 Sep 10 10:56 file2.txt

Is this helpful?

rm file.txt && ls -l

Here’s the output:

-rw-r–r-- 1 human human 0 Sep 10 10:56 file2.txt

head -n 5 /proc/meminfo

Here’s the output:

MemTotal: 164928 kB

MemFree: 140604 kB

Buffers: 48 kB

Cached: 19768 kB

SwapCached: 0 kB

Original Abstract: We present LLaMA-Adapter, a lightweight adaption method to efficiently

fine-tune LLaMA into an instruction-following model. Using 52K self-instruct

demonstrations, LLaMA-Adapter only introduces 1.2M learnable parameters upon

the frozen LLaMA 7B model, and costs less than one hour for fine-tuning on 8

A100 GPUs. Specifically, we adopt a set of learnable adaption prompts, and

prepend them to the word tokens at higher transformer layers. Then, a

zero-initialized attention mechanism with zero gating is proposed, which

adaptively injects the new instructional cues into LLaMA, while effectively

preserves its pre-trained knowledge. With our efficient training, LLaMA-Adapter

can generate high-quality responses, comparable to Alpaca with fully fine-tuned

7B parameters. Besides language commands, our approach can be simply extended

to multi-modal instructions for learning image-conditioned LLaMA model, which

achieves superior reasoning performance on ScienceQA and COCO Caption

benchmarks. Furthermore, we also evaluate the zero-initialized attention

mechanism for fine-tuning other pre-trained models (ViT, RoBERTa) on

traditional vision and language tasks, demonstrating the superior

generalization capacity of our approach. Code is released at

https://github.com/OpenGVLab/LLaMA-Adapter.

PDF Link: 2303.16199v3

部分平台可能图片显示异常,请以我的博客内容为准