习题 2-1 分析为什么平方损失函数不适用于分类问题 , 交叉熵损失函数不适用于回归问题?

解:交叉熵损失的假设是误差分布是二值分布,因此更适用于分类等离散属性的问题,而均方误差则假设数据的分布是正态分布,更加是用于连续属性的误差分析。

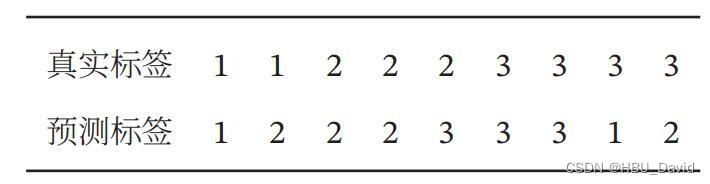

习题 2-12 对于一个三分类问题 , 数据集的真实标签和模型的预测标签如下 :

分别计算模型的精确率、召回率、F1值以及它们的宏平均和微平均.

格式要求:使用公式编辑器,在博客上正确书写公式。

解:

精确率:

分类1的精确率:

分类2的精确率:

分类3的精确率:

召回率:

分类1的召回率:

分类2的召回率:

分类3的召回率:

F1值:

分类1的F1值:

分类2的F1值:

分类3的F1值:

宏平均:

宏查准率:

宏查全率:

F1:

微平均:

本文含有隐藏内容,请 开通VIP 后查看