机器学习Part01——绪论

一、 概念与基本术语

机器学习(Machine Learning): 研究计算机怎样模拟或实现人类的学习行为,以获取新的知识或技能,重新组织已有的知识结构使之不断改善自身的性能.

一个程序被认为能从经验E中学习,解决任务 T,达到性能度量值P,当且仅当,有了经验E后,经过P评判, 程序在处理T时的性能有所提升

监督式学习(Supervised Learning): 对于数据集中每一个样本都有对应的标签,包括回归(regression)和分类(classification).

无监督式学习(Unsupervised Learning): 数据集中没有任何的标签,包括聚类(clustering).

| 术语 | 含义 |

|---|---|

| 数据集(data set) | 一组记录的集合 |

| 示例(instance) or 样本(sample) | 对一个事件或对象描述的记录 |

| 属性(attribute) or 特征(feature) | 反映事物或对象在某方面的表现或性质的事项 |

| 属性值(attribute value) | 属性上的取值 |

| 属性空间(attribute space) or 样本空间(sample space) or 输入空间 | 属性张成的空间 |

| 特征向量(feature vector) | “示例”的向量化 |

| 维数(dimensionallity) | 属性的个数 |

| 学习(learning) or 训练(training) | 从数据中学得模型的过程 |

| 训练数据(training data) | 训练过程中使用的数据 |

| 训练样本(training sample) | 训练过程中的样本 |

| 训练集(training set) | 训练样本组成的集合 |

| 假设(hypothesis) | 学得模型对应了关于数据的某种潜在规律 |

| 真相 or 真实(ground-truth) | 潜在规律自身 |

| 学习器(learner) | 模型 |

二、假设空间

归纳(induction) 与 演绎(deduction) 是科学推理的两大基本手段.

前者是从特殊到一般的 “泛化”(generalization) 过程,即从具体的事实归结出一般性规律.

后者则是从一般到特殊的 “特化”(specialization) 过程,即从基础原理推演出具体情况.

“样例学习”显然是一个归纳过程,因此也称为 “归纳学习(inductive learning)”

归纳学习由广义和狭义之分.

广义的归纳学习大体相当于从样例中学习,而狭义的归纳学习则要求从训练数据中学得概念(concept),因此也称为“概念学习”或“概念形成”.

假设空间: 一个由所有假设(hypothesis)组成的空间

学习过程就是在假设空间中搜索的过程,目的是找到与训练集 匹配(fit) 的假设.

版本空间(version space): 与训练集一致的假设集合.

需要注意,我们通常面临很大的假设空间,但学习过程是基于有限样本训练集进行的,因此,可能有多个假设与训练集一致,这些假设的集合就是版本空间

三、归纳偏好

归纳偏好(inductive bias): 指的是机器学习算法在学习过程中对某种类型假设偏好

任何一个有效的机器学习必有其归纳偏好,否则它将被假设空间中看似在训练集上“等效”的假设所迷惑,而无法产生确定的学习结果.

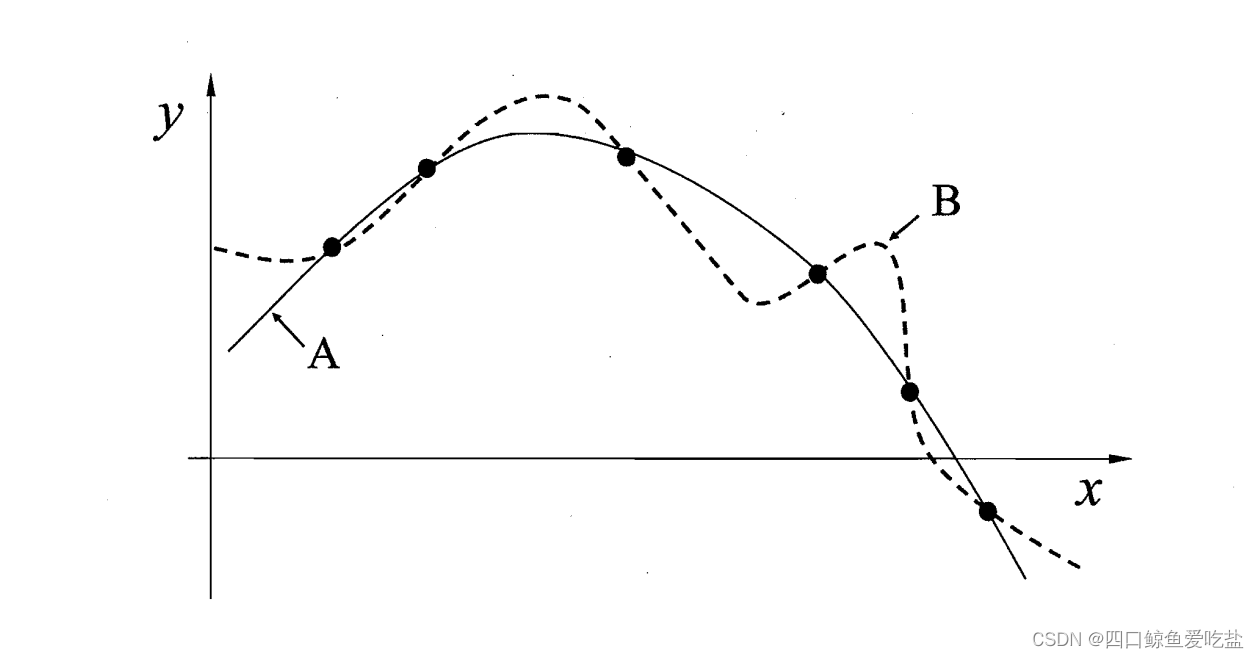

比如,在图一的回归学习图示中,在有限个样本点的条件下,A 和 B 两种回归曲线都满足与训练集一致. 而我们的学习算法必须有某种偏好,才能产出它 认为“正确”的模型.

3.1 奥卡姆剃刀

归纳偏好的一般性原则——**奥卡姆剃刀(Occam’s razor):**即“若有多个假设与观察一致,则选择最简单的那个”.

依照此原则,在图 1 所示中,我们会自然地偏好“平滑”的 曲线 A.

在具体的现实问题中,学习算法的归纳偏好是否与问题本身匹配,大多时候直接决定了算法能否取得好的性能.

3.2 NFL定理

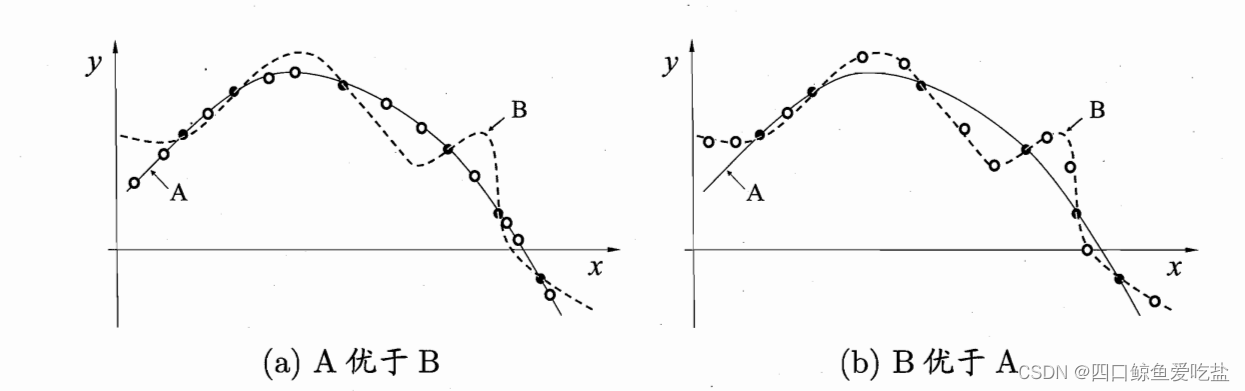

NFL(No Free Lunch Theorem,没有免费午餐)定理: 存在两种算法 ξ a \xi _{a} ξa 和 ξ b \xi_{b} ξb,若在某些问题上, ξ a \xi _{a} ξa 比 ξ b \xi_{b} ξb 好,则必然存在另一些问题, ξ b \xi_{b} ξb 比 ξ a \xi _{a} ξa 要好.

NFL定理有一个重要前提: 所有 “问题” 出现的机会相同、或所有问题同等重要.

但实际情形并不是这样,很多时候,我们只关注自己正在试图解决的问题.