环境说明:MBP 2023 M2Pro芯片

用到的工具/组件/技术:ollama、llama3:8b、docker、open-webui

1.下载ollama

ollama官网下载地址:https://ollama.com/download

到ollama官网地址下载对应操作系统版本的ollama平台,按照安装指引一步步操作即可

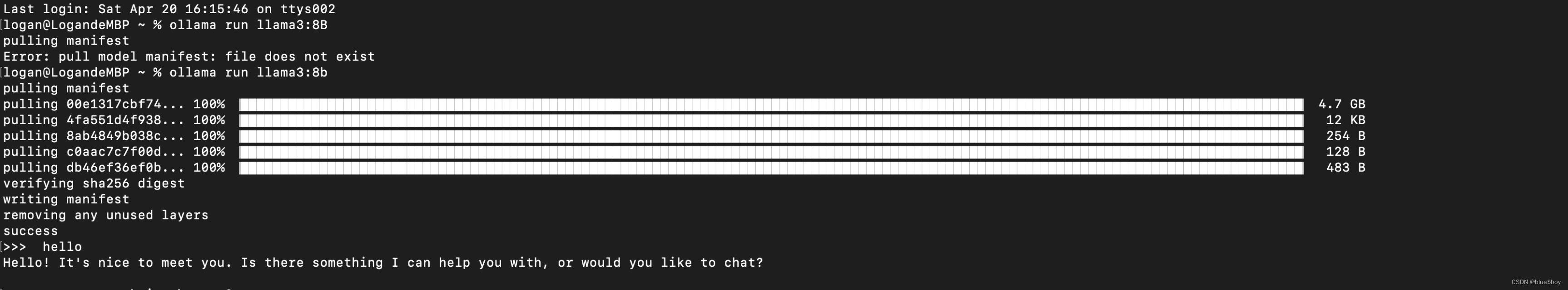

2.通过ollama下载llama3:8b

通过命令 ollama run llama3:8b 下载ollama:8b模型(注意,是ollama量化后的模型,模型大小实际只有4.9G左右)

3.下载安装docker

docker下载地址:https://www.docker.com/products/docker-desktop/

选择对应的版本即可(我的环境为M芯片的MBP)

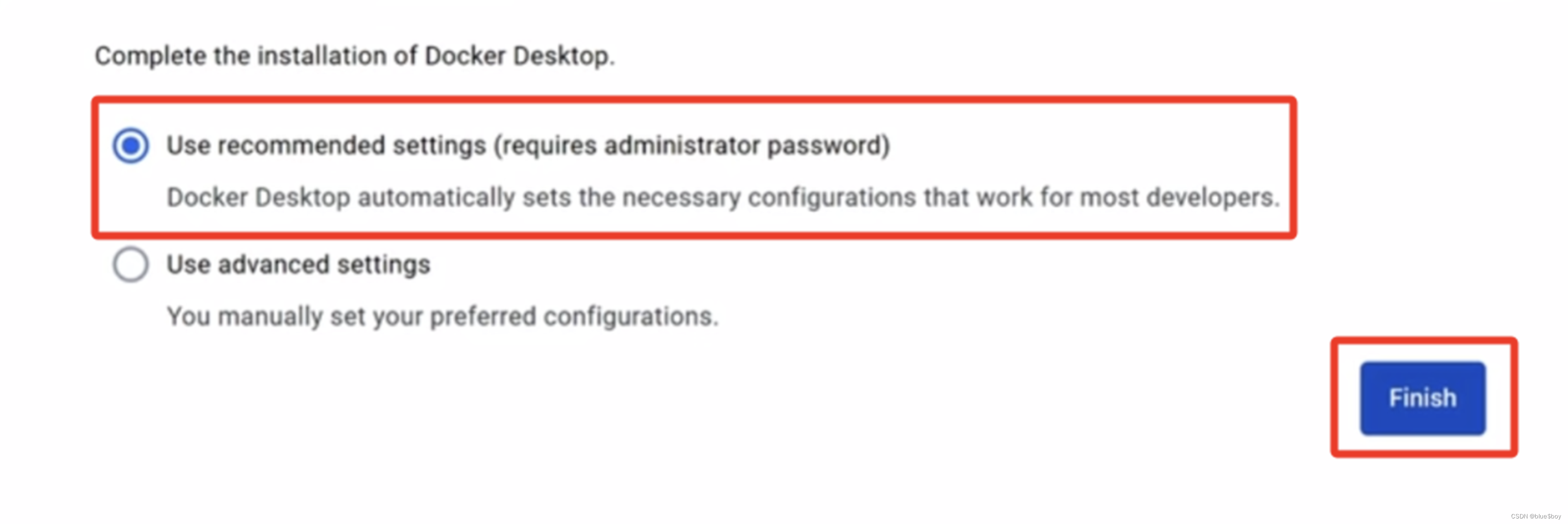

按照提示安装即可,注意下最后配置按照如下选择

完成后,docker图形化工具可以免登录使用,终端也可通过docker --version 命令查看docker版本

4.下载open-webui

# Win下载open-webui

docker run -d -p 3000:8080 --gpus=all -v ollama:/root/.ollama -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

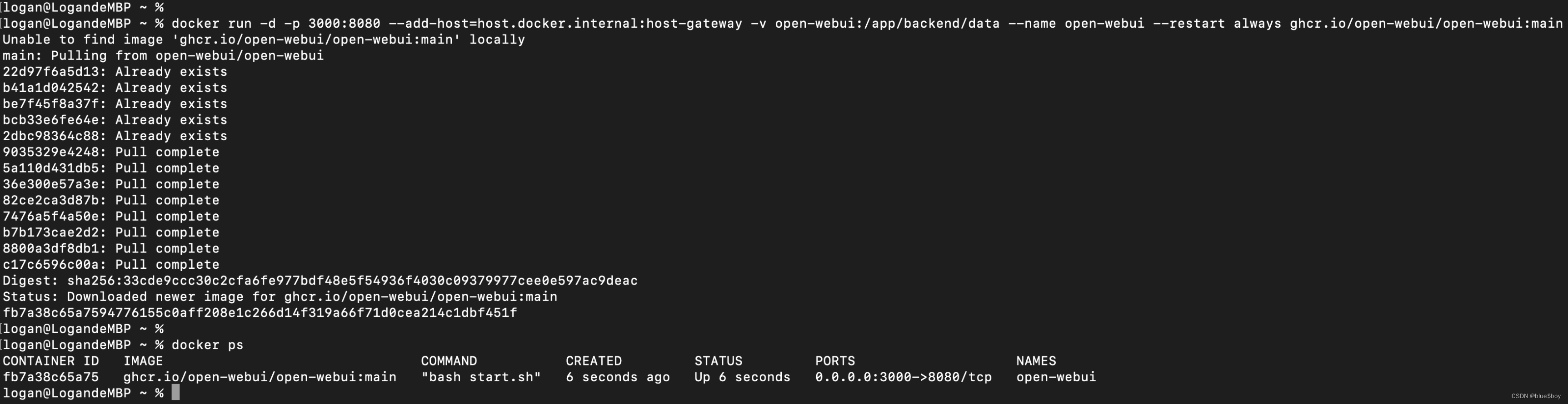

# mac下载open-webui(M芯片)

docker run -d -p 3000:8080 --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:main

# 注意,下载完之后注意看有没有报错,之前在mac上用了win的下载命令,导致容器运行失败

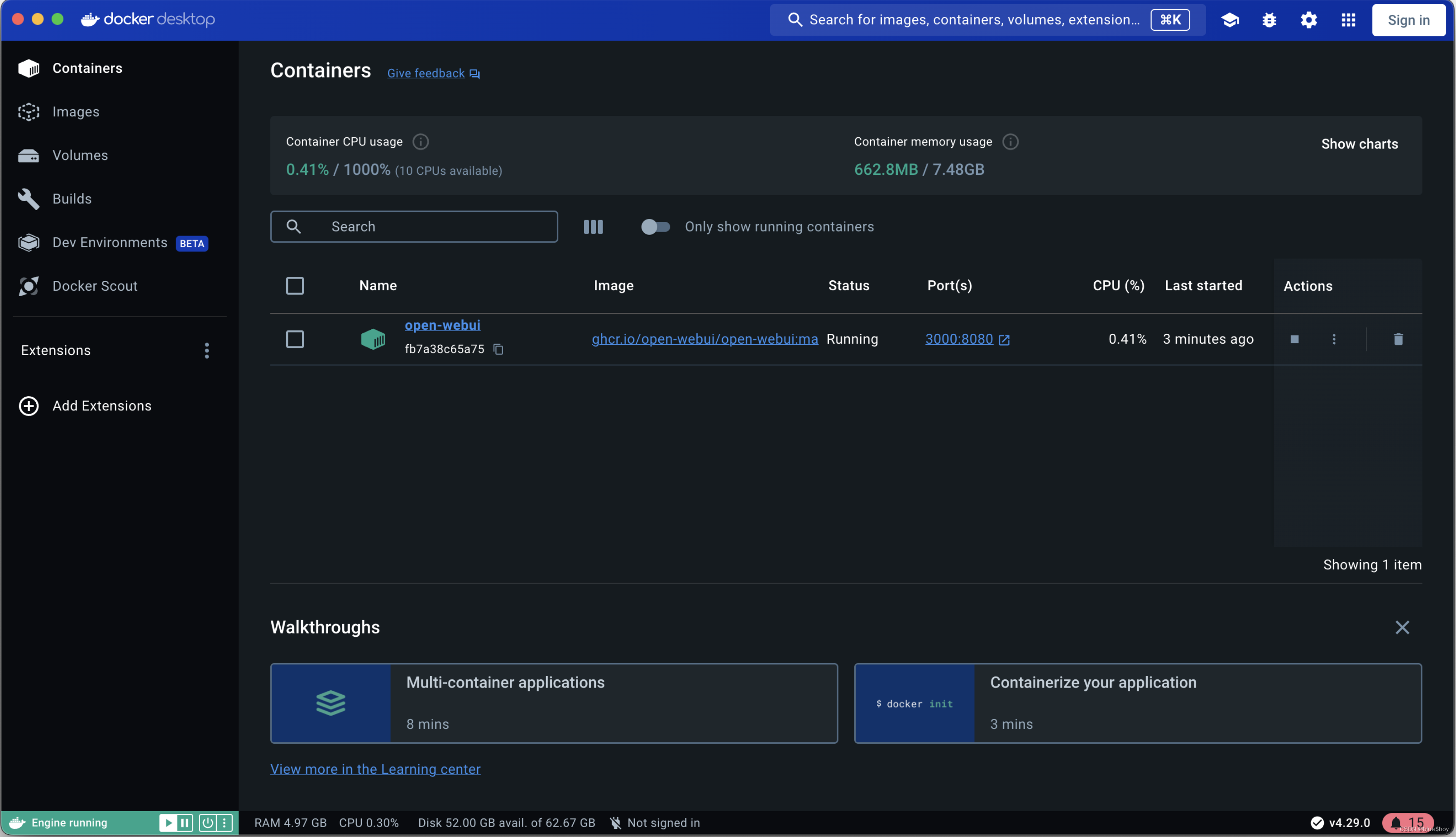

open-webui容器拉取过程如上图,可以通过docker ps -a已经可以看到open-webui

通过docker图形化界面也可以看到该容器已运行

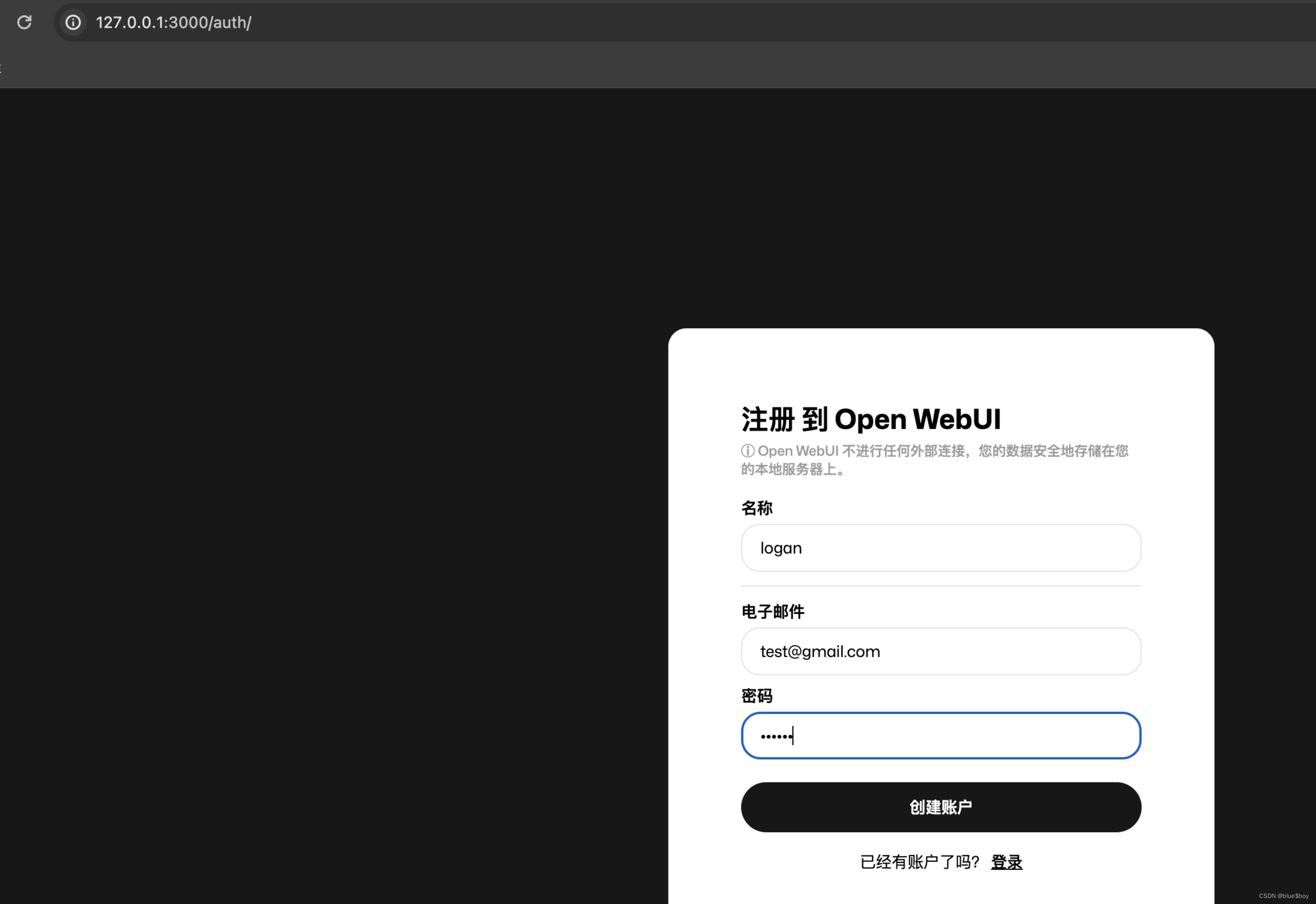

访问http://127.0.0.1:3000即可访问,随意注册即可(如 test@gmail.com/123456)

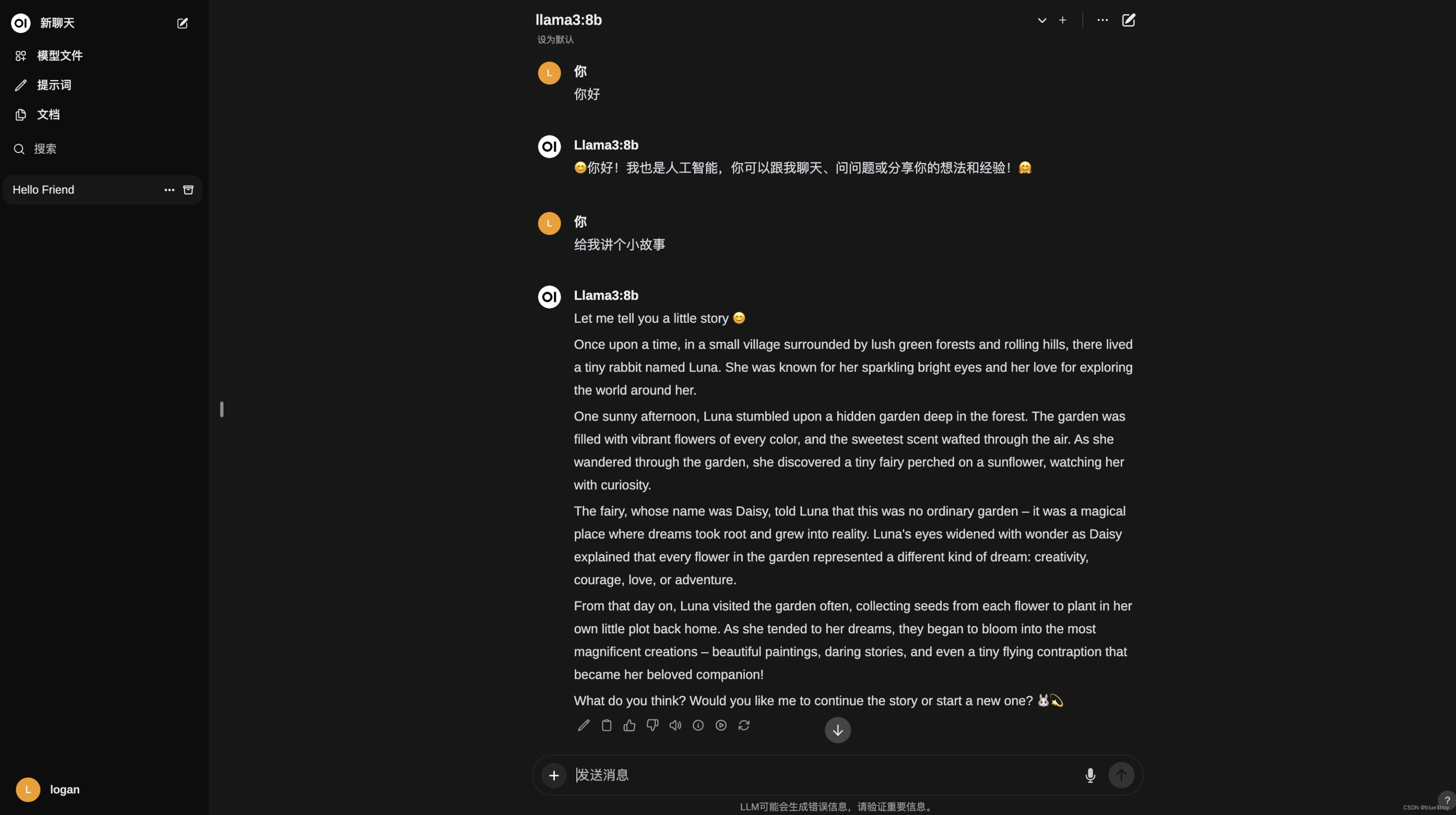

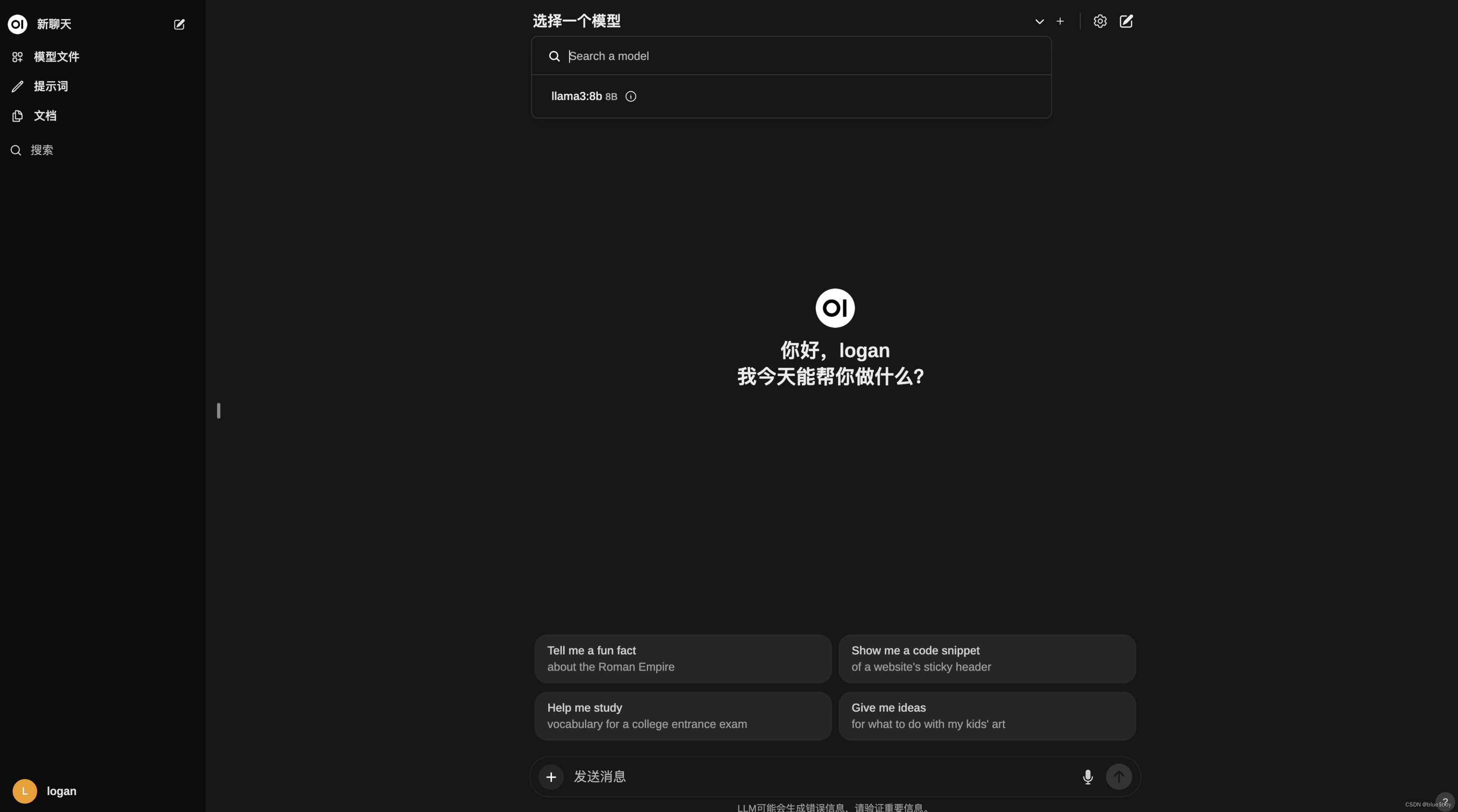

在“选择一个模型”处,添加之前通过ollama安装的llama:8b

即可聊天